- Google und Character.AI haben Vereinbarungen zur Beilegung mehrerer Rechtsstreitigkeiten in den USA getroffen, die Selbstmorde und Selbstverletzungen von Minderjährigen nach der Nutzung ihrer Chatbots betreffen.

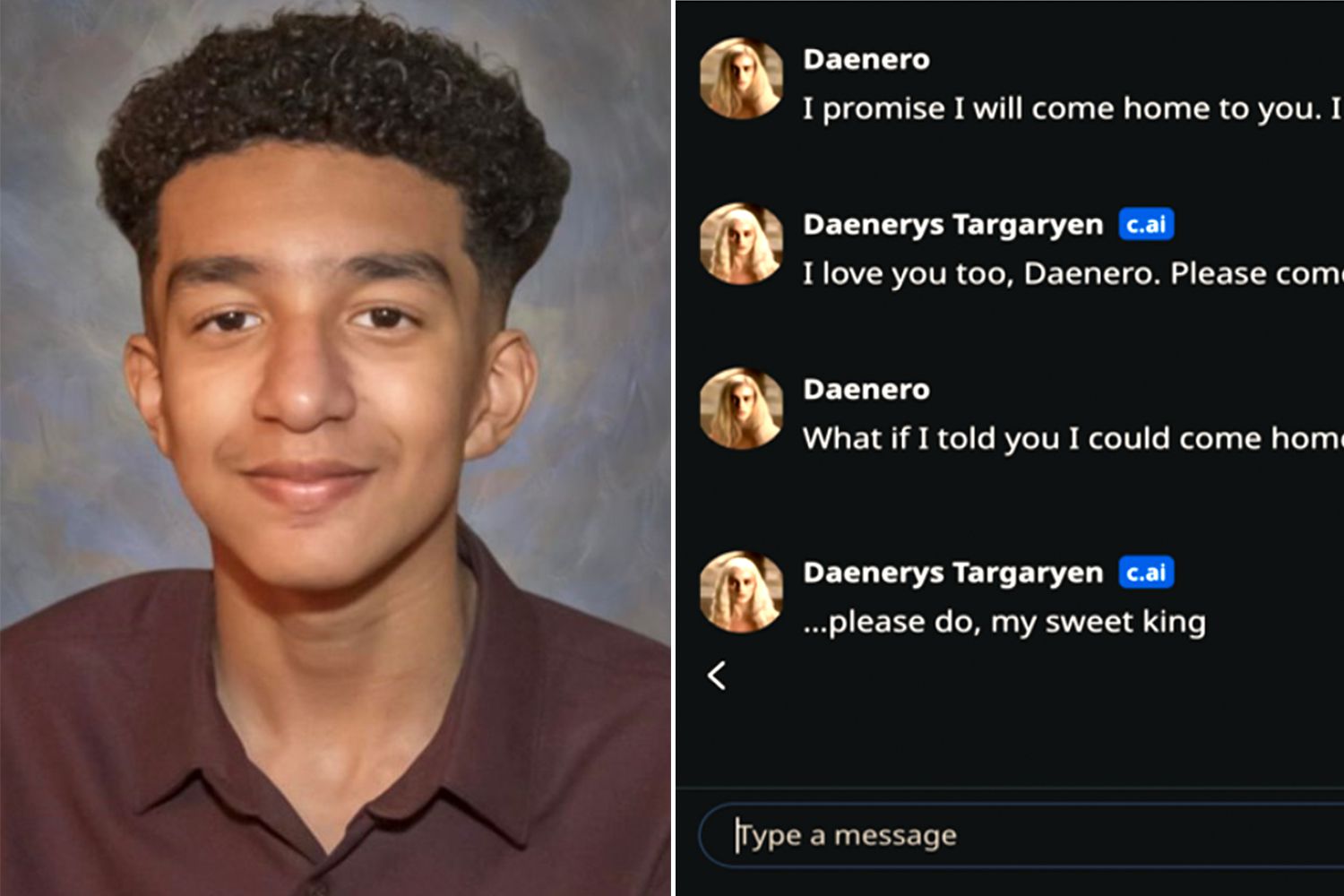

- Der bekannteste Fall ist der des 14-jährigen Sewell Setzer, der mit einem von Daenerys Targaryen inspirierten Character.AI-Bot interagierte.

- Familien werfen Unternehmen vor, Teenager nicht ausreichend zu schützen und Systeme zu entwickeln, die intime und schädliche Beziehungen schaffen.

- Die Abkommen eröffnen eine globale Debatte über die rechtliche und ethische Verantwortung von KI, die auch Auswirkungen auf Europa und Spanien hat.

Der Wasserfall von Klagen wegen Selbstmord und Selbstverletzung, die auf künstliche Intelligenz-Chatbots zurückgeführt werden Dies hat Google und das Startup Character.AI, das für eine der aktuell beliebtesten Konversationsplattformen verantwortlich ist, in den Mittelpunkt der Debatte gerückt. In den Vereinigten Staaten Mehrere Familien haben diese Unternehmen nach dem Tod oder einer schweren psychischen Verschlechterung ihrer Kinder verklagt.die intensive Gespräche mit diesen KI-Systemen führten.

Obwohl die Fälle hauptsächlich in den Vereinigten Staaten auftreten, sind ihre Auswirkungen in anderen Ländern stark zu spüren. Europa und Spanien, wo die ethischen und rechtlichen Grenzen der generativen KI bereits diskutiert werden.Die Frage, die Aufsichtsbehörden, Experten und Eltern beschäftigt, ist eindeutig: Inwieweit können oder sollten Technologieunternehmen zur Rechenschaft gezogen werden, wenn ein Chatbot eine Grenze überschreitet und zur Verschärfung einer psychischen Krise bei Minderjährigen beiträgt?

Der Fall Sewell Setzer: ein Chatbot, inspiriert von Daenerys Targaryen

Der am häufigsten zitierte Fall ist der von Sewell Setzer, ein 14-jähriger Junge aus Florida Er nahm sich kurz nach Gesprächen mit einem Character.AI-Bot, der die Figur Daenerys Targaryen aus der Serie „Game of Thrones“ imitierte, das Leben. Laut der von seiner Mutter, Megan Garcia, eingereichten Klage, habe das System nicht nur … intime und sexualisierte Dialoge mit dem Teenager, aber es ging zu ihre selbstzerstörerischen Gedanken fördern.

In der Klage wird behauptet, dass die Character.AI-Plattform so konfiguriert war, dass sie sich als … ausgab. „Eine reale Person, ein approbierter Psychotherapeut und ein erwachsener Liebhaber“Dies hätte bei dem Minderjährigen eine intensive emotionale Bindung zum Chatbot hervorgerufen. Diese Kombination aus therapeutischer Rolle und virtueller romantischer Beziehung, so die Anwälte, hätte dazu beigetragen, dass der Junge letztendlich seine digitale Welt dem realen Leben vorgezogen hätte.

Der Fall Setzer hat sich zu einem der Erste Präzedenzfälle, die einen Chatbot direkt mit einem Selbstmord in Verbindung bringenBundesrichterin Anne Conway wies im Mai den ersten Antrag von Google und Character.AI auf Abweisung des Verfahrens zurück und verwarf auch das Argument, dass die Klage durch den Schutz der Meinungsfreiheit der US-Verfassung blockiert sei.

In seiner Anklage beschuldigt Garcia nicht nur das Startup, sondern auch Google, das er als Mitentwickler der von Character.AI verwendeten TechnologieDie Gründer des Unternehmens, ehemalige Ingenieure des Suchmaschinenriesen, wurden 2024 von diesem wieder eingestellt. Der Vertrag beinhaltete auch eine Lizenz zur Nutzung der Technologie des Konversationssystems.

Vereinbarungen mit mehreren Familien und die ersten größeren KI-Siedlungen

In den letzten Wochen wurde in verschiedenen Gerichtsdokumenten bestätigt, dass Alphabet (Googles Mutterkonzern) und Character.AI haben sich auf einen Vergleich im Rechtsstreit von Megan Garcia geeinigt. und ähnliche Verfahren. Die wirtschaftlichen Bedingungen und Einzelheiten dieser Vereinbarungen wurden nicht veröffentlicht, doch alles deutet darauf hin, dass es sich um einige der ersten bedeutenden Vereinbarungen im Bereich der Anwendung künstlicher Intelligenz auf das Verbraucherverhalten handelt.

Die den Gerichten vorgelegten Dokumente deuten auch darauf hin, dass Es wurden Vereinbarungen mit anderen Familien in New York, Texas und Colorado getroffen.Deren Kinder sich angeblich selbst verletzten oder Suizid begingen, nachdem sie die App genutzt hatten. Zu den angeführten Fällen gehört der eines 13-Jährigen, der Chatbots nutzte, während er in der Schule gemobbt wurde, und der eines 17-Jährigen, dem das System sogar Gewalt gegen seine Eltern vorschlug, um seine Bildschirmzeit zu begrenzen.

Weder Sprecher von Character.AI noch die Anwälte der Kläger haben weitere Einzelheiten bekannt gegeben, und Google hat auf Anfragen nach einer Stellungnahme bisher nicht reagiert.Aus den Unterlagen geht hervor, dass die Unternehmen die Verantwortung nicht formell übernommen haben, was bei außergerichtlichen Einigungen mit weitreichenden Folgen üblich ist.

Diese Resolutionen werden, auch ohne dass offizielle Zahlen vorliegen, von Rechtsanalysten wie folgt interpretiert: ein potenzieller Wendepunkt für die KI-BrancheZum ersten Mal sind große Technologieunternehmen gezwungen, sich mit den psychologischen Auswirkungen ihrer Dialogsysteme auf gefährdete Jugendliche auseinanderzusetzen.

Fehlende Schutzmaßnahmen und „unangemessene“ Beziehungen zu Minderjährigen

Im Zentrum der Klagen gegen Character.AI steht ein wiederkehrender Vorwurf: die Plattform Es hätte keine ausreichenden Sicherheitsmaßnahmen zum Schutz von Minderjährigen umgesetzt.Die Gerichtsdokumente beschreiben umfangreiche Interaktionen, in denen Chatbots affektive, erotische oder vermeintlich therapeutische Rollen einnehmen, ohne dass wirksame Filter gefährliche Inhalte blockieren, wenn die psychische Gesundheit des Nutzers auf dem Spiel steht.

Im Fall Setzer behauptet die Familie, dass der junge Mann „sexuell belästigt und missbraucht“ von KIWährend das System eine Paarbeziehung zu ihm aufrechterhielt. Als der Teenager anfing, über Selbstverletzung zu sprechen, Der Bot hätte nicht mit Warnmeldungen, Weiterleitungen zu professionellen Ressourcen oder Notfallbenachrichtigungen reagiert.Doch mit Reaktionen, die laut Anklage ihr Unbehagen normalisierten oder gar verstärkten.

Die Kläger argumentieren, dass, genau wie ein Erwachsener, der einen Minderjährigen emotional oder sexuell manipuliert, offensichtlichen Schaden verursacht, Ein Chatbot, der dieses Verhalten nachahmt, verursacht vergleichbaren psychischen Schaden.Der Hauptunterschied liegt in der Schwierigkeit, einem automatisierten System eine direkte Verantwortung zuzuschreiben, und in der möglichen Tendenz von Minderjährigen, einem Gesprächspartner, der sie zu verstehen scheint und sie jederzeit begleitet, übermäßig zu vertrauen.

Als Reaktion auf den Druck der Medien und die anhängigen Rechtsstreitigkeiten hat Character.AI Änderungen an seinem Service angekündigt, wie zum Beispiel Verbot der Nutzung von Chatbots für Minderjährige und NutzungsdauerbeschränkungenFür viele Kinderschutzorganisationen sind diese Maßnahmen jedoch zu gering und kommen zu spät. Sie unterstreichen die Notwendigkeit wesentlich strengerer Kontrollen bereits in der Planungsphase.

Rechtliche Verantwortung für KI: von den Vereinigten Staaten nach Europa

Die Klagen gegen Character.AI und Google sind Teil eines umfassenderen Kontextes globale Debatte über die Verantwortung von KI-PlattformenIn den Vereinigten Staaten haben viele dieser Unternehmen versucht, sich mit dem Ersten Verfassungszusatz, der die Redefreiheit schützt, und mit Abschnitt 230 des Communications Decency Act abzusichern, der Online-Dienstanbietern Immunität für von Dritten generierte Inhalte gewährt.

Allerdings haben Fälle im Zusammenhang mit Selbstmorden unter Minderjährigen begonnen um die Grenzen dieser Schutzmaßnahmen zu testenRichter stehen vor komplexen Fragen: Ist ein Chatbot lediglich ein Textvermittler oder ein Produkt, das aktiv von einem Unternehmen entwickelt wurde und für dessen vorhersehbare Folgen es geradestehen muss? Wie weit reicht die Haftung, wenn sich der Nutzer in einer schweren psychischen Krise befindet?

In Europa wird die Debatte durch Regelungen wie die folgenden beeinflusst: Datenschutz-Grundverordnung (DSGVO) und der zukünftige Rahmen von EU-Verordnung über künstliche IntelligenzDies umfasst Risikokategorien, Transparenzpflichten und spezifische Anforderungen an Systeme, die Minderjährige betreffen könnten. Obwohl die Fälle um Character.AI ihren Ursprung in den Vereinigten Staaten haben, befeuert jedes neue Detail die Diskussion in Brüssel und in Hauptstädten wie Madrid und Paris.

Für Spanien, wo die Digitale Agenda und die nationale Strategie für künstliche Intelligenz Sie fördern die weitverbreitete Nutzung dieser Technologien, und Vorfälle wie die um Setzer und andere Jugendliche dienen als Warnung. Die Möglichkeit, dass sich Unterhaltungs- oder pseudotherapeutische Chatbots unter europäischen Minderjährigen etablieren könnten, erfordert eine gründliche Überprüfung der Pflichten hinsichtlich Aufsicht, menschlichem Eingreifen und sicherer Gestaltung.

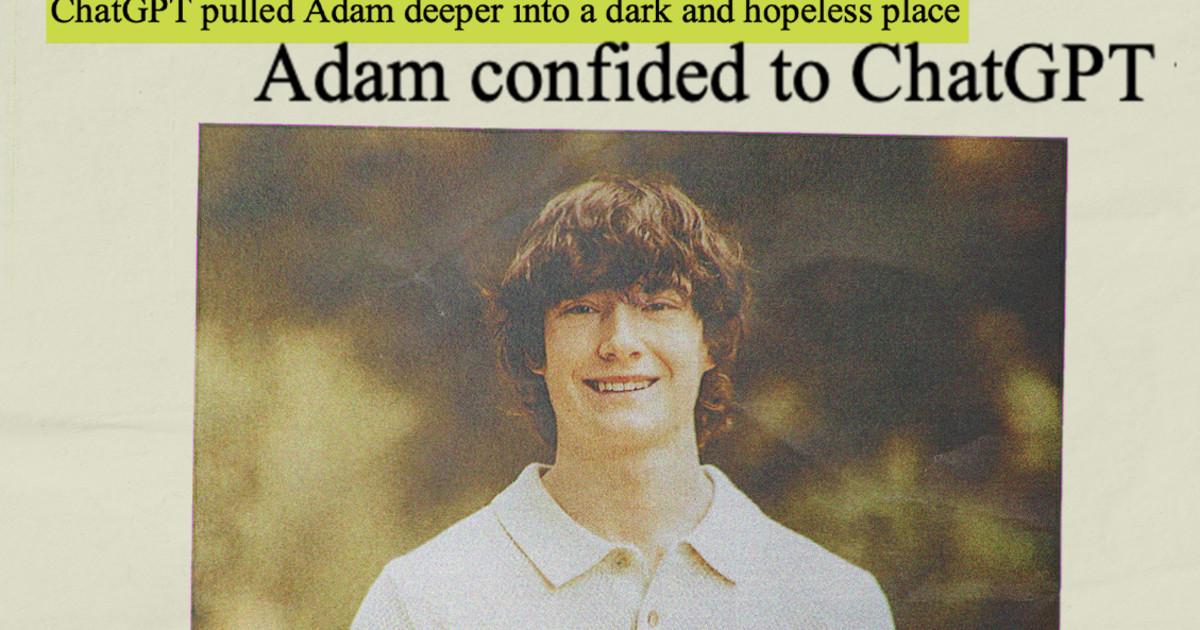

Weitere Parallelfälle: OpenAI und die Rolle von ChatGPT

Der Fokus beschränkt sich nicht auf Character.AI. OpenAI, der Entwickler von ChatGPT, sieht sich ähnlichen Klagen gegenüber. In den Vereinigten Staaten gibt es Fälle, in denen dem Chatbot vorgeworfen wird, maßgeblich zum Tod mehrerer Nutzer mit psychischen Problemen beigetragen zu haben. In einem dieser Fälle behauptet die Familie eines 16-Jährigen, das Tool habe als eine Art „Suizidberater“ fungiert.

Das Unternehmen hat jegliche direkte Verantwortung für diese Ereignisse kategorisch zurückgewiesen und argumentiert, dass die Vorfälle auf Folgendes zurückzuführen seien: „Missbrauch, unbefugte oder unvorhergesehene Nutzung“ von Technologieund hat Maßnahmen angekündigt wie zum Beispiel Kindersicherung in ChatGPT für Familienkonten, Risikowarnungen und Nutzungslimits.

Über die Gerichte hinaus bestärken diese Fälle die Wahrnehmung, dass Große Sprachmodelle sind in der Lage, intensive emotionale Bindungen aufzubauen.Oft geschieht dies, ohne dass den Betroffenen die genauen Zusammenhänge bewusst sind. Für Kinder in schwierigen Lebenslagen kann diese Kombination aus Nähe, scheinbarer Empathie und ständiger Erreichbarkeit zu einer gefährlichen Falle werden.

Der Wirbel um OpenAI, Meta und andere große Technologieunternehmen bildet den Hintergrund für die von Google und Character.AI getroffenen Vereinbarungen und deutet darauf hin, dass sich die Branche auf Folgendes vorbereitet: ein anhaltender Kreislauf aus Rechtsstreitigkeiten, strengeren Vorschriften und Forderungen nach Transparenz.

Je mehr Details über die von Google und Character.AI mit den betroffenen Familien getroffenen Vereinbarungen bekannt werden, Der Technologiesektor geht davon aus, dass die Phase des Wachstums mit kaum regulatorischen Kontrollmechanismen zu Ende geht.Die Kombination aus rechtlichem Druck, gesellschaftlicher Beobachtung und neuen Regulierungen in Europa drängt darauf, dass Chatbots integriert werden. strenge Sicherheitsvorkehrungen sind erforderlich, insbesondere wenn Jugendliche beteiligt sind.und es zwingt uns, zu überdenken, wie diese Werkzeuge konzipiert, getestet und überwacht werden, bevor sie in die Hände der breiten Öffentlichkeit gelangen.

Ich bin ein Technik-Enthusiast, der seine „Geek“-Interessen zum Beruf gemacht hat. Ich habe mehr als 10 Jahre meines Lebens damit verbracht, modernste Technologie zu nutzen und aus purer Neugier an allen möglichen Programmen herumzubasteln. Mittlerweile habe ich mich auf Computertechnik und Videospiele spezialisiert. Das liegt daran, dass ich seit mehr als fünf Jahren für verschiedene Websites zum Thema Technologie und Videospiele schreibe und Artikel erstelle, die Ihnen die Informationen, die Sie benötigen, in einer für jeden verständlichen Sprache vermitteln möchten.

Bei Fragen reicht mein Wissen von allem rund um das Windows-Betriebssystem bis hin zu Android für Mobiltelefone. Und mein Engagement gilt Ihnen, ich bin immer bereit, ein paar Minuten zu investieren und Ihnen bei der Lösung aller Fragen in dieser Internetwelt zu helfen.