- Schnelles und kostengünstiges Modell für agentenbasiertes Coding mit sichtbaren Spuren und 256 Kontext.

- Zugriff über xAI gRPC SDK oder REST mit OpenRouter/CometAPI, mit ACLs und Caching.

- Funktionsaufrufe und JSON-Ausgaben für Test-Fix-, CI- und IDE-Flows.

- Best Practices: klare Eingabeaufforderungen, kurze Iterationen, Sicherheit und Metriken.

Entwickler, die ihren Workflow beschleunigen möchten, finden in Grok Code Fast 1 ein erstklassiger Verbündeter, denn kombiniert Geschwindigkeit, wettbewerbsfähige Kosten und Spuren sichtbarer Argumentation die es Ihnen ermöglichen, das Modell präzise zu steuern, während Sie über komplexen Code iterieren.

Über das Marketing hinaus ist das Leistungsstarke dieses xAI-Modells darauf ausgelegt, Echtes agentisches Coding: plant, ruft Tools auf und strukturiert Ausgaben zur Integration mit IDEs, Pipelines und REST-kompatiblen Diensten; und das alles unter Beibehaltung eines großen Kontextfensters, das das Abschneiden großer Codebasen verhindert.

Was ist Grok Code Fast 1 und warum ist es wichtig?

Grok Code Fast 1 (Modell Grok-Code-Fast-1) ist eine familienorientierte Variante Grok xAI-orientierte Entwicklungsaufgaben: Funktionen generieren, Algorithmen optimieren, Systeme integrieren und vor allem fungiert als „Paarprogrammierer“ mit Tools (Suche, Test, Dateibearbeitung) und übertragbare Begründung zur Überprüfung während der Ausführung.

Diese Spezialisierung priorisiert zwei Achsen: interaktive Latenz für die Verwendung innerhalb des Editors/CI und Kosteneffizienz pro Token für umfangreiche Arbeiten. Anders als bei allgemeinen LLMs besteht ihr Ziel nicht in vollständiger Multimodalität, sondern darin, den Entwicklungszyklus perfekt zu meistern: Lesen, Vorschlagen, Testen und Wiederholen mit minimaler Reibung.

Die Plattform zeichnet sich durch die Ausstellung Streaming-Argumentationsspuren und unterstützt Funktionsaufrufe und strukturierte Ausgabe (JSON). In der Praxis erleichtert dies die Automatisierung mehrstufiger Schleifen (Suchen → Bearbeiten → Testen → Validieren) mit Kontrolle und Rückverfolgbarkeit auf Token-Ebene.

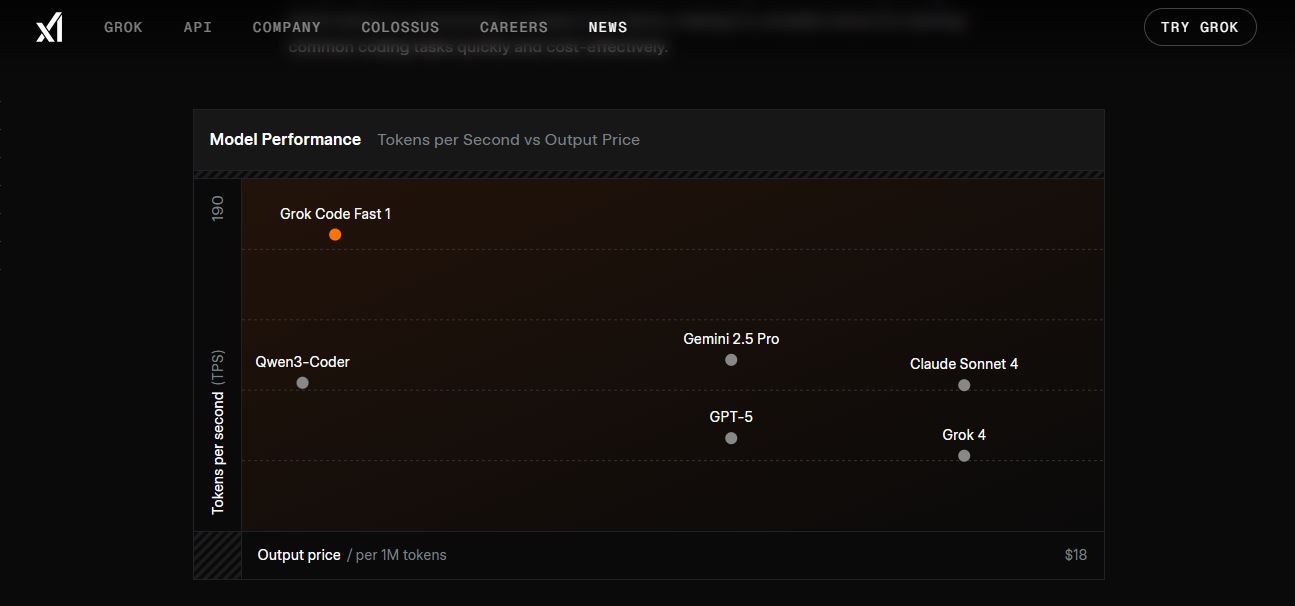

In Bezug auf die Leistung sind Zahlen wie ≈190 Token/Sekunde, sofortige Zeilenabschlusszeiten, weniger als 1 s für 5-10 Zeilenfunktionen, etwa 2-5 s für 50+ Zeilenkomponenten und 5-10 s für große Refactorings. Laut gemeinsamen Benchmarks übertrifft LLaMA-ähnliche Modelle in HumanEval und erreicht 70,8 % in Benchmarks wie SWE-Bench-Verified.

Technisches Design, das Geschwindigkeit ermöglicht

Das Modell unterstützt eine Kontextfenster mit bis zu 256.000 Token, nützlich zum Aufnehmen von Repositories, Dokumentationen und langen Konversationen ohne Kürzung, wodurch redundante Kontextweiterleitungen reduziert werden.

Die Plattform implementiert Präfix-Cache: Wenn Sie über dieselbe Basiseingabeaufforderung iterieren, reduzieren zwischengespeicherte Token die Kosten und die Latenz (niedrigerer Preis für zwischengespeicherte Token), was bei mehrstufigen Agentenflüssen entscheidend ist.

Darüber hinaus unterstützt die Grok API strukturierte Werkzeug-/Funktionsdefinitionen während des Parsens aufgerufen werden; dies verhindert fragile Hacks, vereinfacht das Parsen und ermöglicht eine zuverlässigere Koordination mehrerer Tools.

Operativ wird der Dienst gehostet in der Region US-Ost-1, etwas, das Sie im Hinterkopf behalten sollten, wenn Sie Latenzen in Nordamerika optimieren oder zwischen Anbietern und Regionen abwägen.

Preise, Limits und Verfügbarkeit

Das Modell wird pro Nutzung mit veröffentlichten Tarifen abgerechnet, wie z. B. 0,20 $/M Eintrittstoken, 1,50 $/M Ausgabetoken y 0,02 $/M zwischengespeicherte TokenDieses Schema bevorzugt lange Sitzungen mit konstanten Präfixen und mehreren Iterationen.

Die gemeldeten Standardgrenzen sind 480 Anfragen pro Minute y 2.000.000 Token pro MinuteSie verhindern Missbrauch und ermöglichen gleichzeitig eine intensive Nutzung auf Team- oder CI-Ebene.

Im Gegensatz zu anderen Modellen, Grok Code Fast 1 beinhaltet keine Live-Suche: Sie müssen das relevante Wissen und die Daten in der Eingabeaufforderung oder über in Ihrer Orchestrierung definierte Tools bereitstellen.

Kostenvergleiche mit größeren Modellen werden in Listen und Foren von Drittanbietern zitiert (z. B. GPT-5-Ausgabe ≈ 18 $/M Token im Vergleich zu 1,50 $/M von Grok CF1), was seine Positionierung in Entwicklungsaufgaben mit hohem Volumen.

Voraussetzungen für den Zugang

Bevor Sie die erste Petition starten, benötigen Sie eine mit X verknüpftes Konto (xAI authentifiziert mit X-Anmeldeinformationen) und eine Umgebung mit Python 3.8 +, Pip- und Umgebungsvariablenunterstützung zur sicheren Verwaltung Ihres Schlüssels.

Für den direkten Zugriff priorisiert xAI SDK und Kommunikation gRPC, was die Leistung verbessert; wenn Sie REST bevorzugen, können Sie verwenden OpenRouter oder Gateways wie CometAPI, die OpenAI-kompatible Endpunkte bereitstellen.

Bei der Schlüsselgenerierung ist es sinnvoll, Strikte ACLs (z. B. Sampler: Schreibberechtigung), um Aktionen einzuschränken. Dadurch wird die Risikofläche verringert, wenn Anmeldeinformationen verloren gehen oder eine Umgebung kompromittiert wird.

Führen Sie nach Abschluss der Einrichtung eine schnelle SDK-Prüfung durch, um Konnektivität und Berechtigungen bestätigenWenn dies fehlschlägt, überprüfen Sie Netzwerk, ACLs und Paketversion.

Erstellen Sie den API-Schlüssel in PromptIDE (xAI)

Zugang zu ide.x.ai Öffnen Sie mit Ihrem X-Konto das Profilmenü und gehen Sie zu „API-Schlüssel“. Klicken Sie dort auf „API-Schlüssel erstellen“ und ACLs anpassen abhängig davon, was Sie mit dem Modell vorhaben (von einfachen Vervollständigungen bis hin zu erweiterten Toolaufrufen).

Der Schlüssel wird angezeigt nur einmal, kopieren Sie es und bewahren Sie es sicher auf. Es wird empfohlen, es in einer Umgebungsvariablen zu speichern. XAI_API_KEY um die Festcodierung von Geheimnissen in Repositories zu vermeiden.

Später können Sie Berechtigungen widerrufen, rotieren oder anpassen vom selben Panel aus, wenn Sie es benötigen, beispielsweise wenn Sie eine anomale Nutzung oder Änderungen der Arbeitsabläufe feststellen.

Für die Expressprüfung stellen einige SDKs Methoden wie does_it_work() bereit. Verwenden Sie diese, um sicherzustellen, dass Authentifizierung und Umfang richtig sind, bevor Sie Zeit in die Integration investieren.

Installieren und Konfigurieren des xAI SDK

Installieren Sie das SDK mit pip install xai-sdk, exportieren Sie die Umgebungsvariable mit Ihrem Schlüssel (export XAI_API_KEY=…) und erstellen Sie eine Instanz von Klient() in Ihrer App, um loszulegen.

Das SDK ist verantwortlich für die Verwaltung gRPC transparent, unterstützt leistungsstarke asynchrone Operationen und ermöglicht Ihnen die Auswahl des Modells nach Namen, z. B. „grok-code-fast-1“.

Wenn etwas nicht wie erwartet reagiert, aktualisieren Sie Pakete (pip), überprüfen Sie die Unternehmenskonnektivität und Überprüfen Sie die Bereiche des Schlüssels; viele Vorfälle sind auf unzureichende Berechtigungen zurückzuführen.

Sobald die Funktion betriebsbereit ist, können Sie Parameter wie Temperatur oder top_p um in Ihren Abläufen ein Gleichgewicht zwischen Kreativität und Determinismus herzustellen.

REST-Zugriff mit OpenRouter und Gateways von Drittanbietern

Wenn HTTP besser zu Ihrer Infrastruktur passt, OpenRouter stellt eine OpenAI-ähnliche Schnittstelle basierend auf „https://openrouter.ai/api/v1“ und Vorlagen wie „x-ai/grok-code-fast-1“ bereit. Geben Sie einfach Ihren Schlüssel ein und definieren Sie Ihre Nachrichten.

Beispiel mit OpenAI SDK-Unterstützung, nützlich für Standardisieren Sie die Parameter zwischen den Lieferanten und verwenden Sie vorhandene Tools wieder (fügen Sie Header wie HTTP-Referer hinzu, wenn Sie eine Rückverfolgbarkeit des Ursprungs wünschen).

from openai import OpenAI

client = OpenAI(

base_url="https://openrouter.ai/api/v1",

api_key="<TU_CLAVE_OPENROUTER>"

)

resp = client.chat.completions.create(

model="x-ai/grok-code-fast-1",

messages=[

{"role": "user", "content": "Genera un algoritmo de ordenación con explicación rápida"}

]

)

print(resp.choices[0].message.content)

Es gibt auch Anbieter wie CometAPI die als REST-Bridge fungieren, die mit OpenAI kompatibel ist und dieselben Kontext 256kEin einfaches Beispiel mit Anfragen könnte folgendermaßen aussehen:

import os, requests

COMET_KEY = os.getenv("COMETAPI_API_KEY")

BASE = "https://api.cometapi.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {COMET_KEY}",

"Content-Type": "application/json",

}

payload = {

"model": "grok-code-fast-1",

"messages": [

{"role": "system", "content": "Eres Grok Code Fast 1, un asistente de código muy rápido."},

{"role": "user", "content": "Escribe una función en Python que fusione dos listas ordenadas."}

],

"max_tokens": 300,

"stream": False

}

resp = requests.post(BASE, json=payload, headers=headers)

resp.raise_for_status()

print(resp.json())

In diesen Szenarien sind die von den Aggregatoren angekündigten Preise in der Regel mit xAI ausrichten und ohne zusätzliche Gebühren; bestätigen Sie immer die Verfügbarkeit, Limits und mögliche Warteschlangen pro Anbieter.

Erweiterte Verwendung: Strukturierte Tools und Ausgaben

Das Modell glänzt in agentischen Strömen, wo es Beschwörungswerkzeuge (Tests, Linter, Grep, Git) und fügen Sie deren Ergebnisse in den Aktionsplan ein. Definieren Sie Ihre Tools mit einem Namen, einer Beschreibung und Parametern, damit die Engine entscheiden kann, wann sie aufgerufen werden sollen.

Wenn Sie umsetzbare Antworten benötigen, aktivieren Sie die JSON-Modus (response_format Typ json_object) und entwerfen Sie typisierte Schemata für Diffs, Zusammenfassungen oder Refactoring-Pläne. Dies vereinfacht die automatische Validierung.

Überprüfen Sie immer, was Ihre Tools zurückgeben (z. B. Testausgaben), fangen Sie Fehler ab und wenden Sie exponentieller Backoff Wenn Sie auf Ratenbegrenzungen stoßen, besteht das Ziel darin, die Schleife „Plan → Ausführen → Überprüfen“ stabil zu halten.

Dank des 256k-Fenster- und Präfix-Caches können Sie lange Konversationen pro Datei oder Repo ohne den Kontext zu verlieren oder wiederholte Token-Kosten auszulösen.

Integration mit IDEs und Diensten: Copilot, Cursor, Cline, Kilo Code

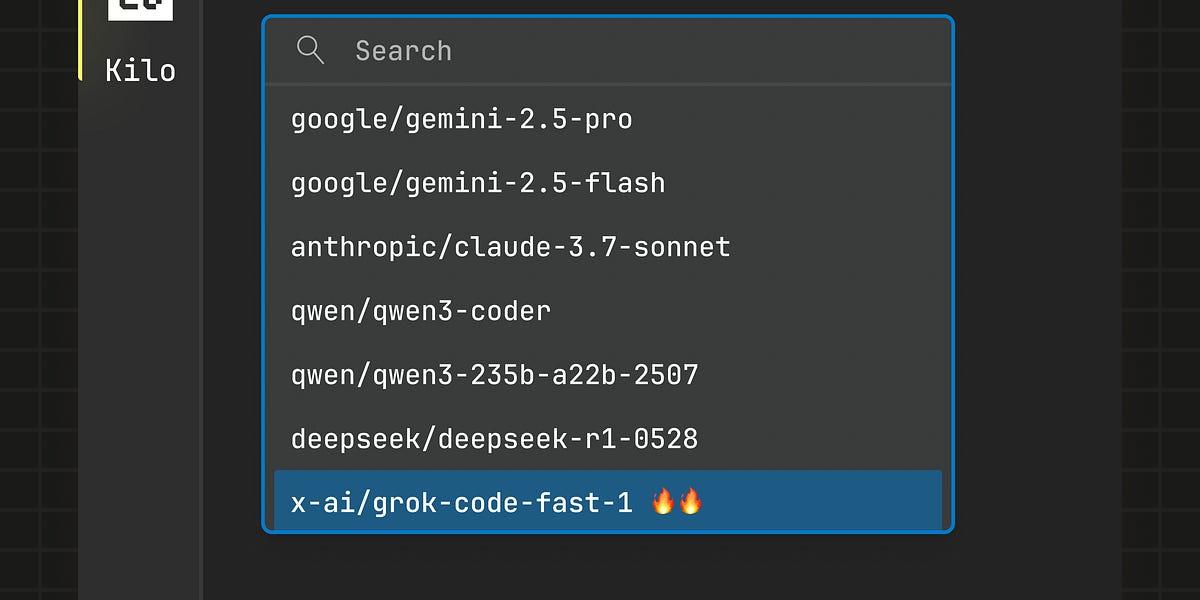

Grok Code Fast 1 ist jetzt verfügbar in IDE-Integrationen und Tools von Drittanbietern. Vorschauen auf GitHub Copilot und Präsenz in Lösungen wie Cursor und Cline werden zitiert, sogar mit kostenlosen Aktionszeiträumen.

Laut dem GitHub-Changelog (26.08.2025) hat Copilot einen kostenlosen Vorschauzugriff angekündigt. bis 10. September 2025 (PDT); einige Anleitungen erwähnen Schließtermine (sogar 2/09) und manchmal blieb das Modell in der Benutzeroberfläche als frei markiert. Das Kluge ist Überprüfen Sie innerhalb der Modellauswahl aus der IDE, um den aktuellen Status zu bestätigen.

Weitere Partner, wie z.B. Kilo-Code (Erweiterung für VS Code), haben kostenlosen Zugang für eine begrenzte Zeit (mindestens eine Woche nach der Veröffentlichung) angekündigt, mit Nutzung ohne erkennbare Grenzen im Austausch für die Entscheidung, Nutzungsdaten zur Verbesserung des Modells weiterzugeben.

Wenn Ihr Team bereits Copilot/Cursor/Cline verwendet, lohnt es sich auf jeden Fall, die freiwilliges Abonnement oder BYOK (bringen Sie Ihren eigenen Schlüssel mit) und messen Sie Latenzen und Qualität in Ihren echten Repos.

Empfohlene Integrationsmuster

- IDE-first- Verwenden Sie kurze Aufforderungen, die nach kleinen, testbaren Änderungen fragen (Patch generieren, Tests durchführen, iterieren). Halten Sie den Kreislauf geschlossen, um die Feedbackzeit zu verkürzen.

- CI-Automatisierung: klassifiziert Fehler, schlägt Korrekturen vor oder generiert neue Unit-Tests; durch Preis/Latenz, Grok CF1 eignet sich gut für häufige Läufe.

- Agentenorchestrierung: ermöglicht Tools mit Leitplanken; führt Patches in Testumgebungen aus; erfordert menschliche Überprüfung bei sensiblen Änderungen; verwenden Sie verständliche Argumente, um den Plan zu prüfen.

- Quick Tips: : Übergeben Sie genaue Dateien oder begrenzte Fenster, die Sie bevorzugen typisierte Formate (JSON/diff), zeichnet Anrufe und Ergebnisse zur Reproduzierbarkeit auf.

Phasenweise Bereitstellung in Teams

Befolgen Sie einen Adoptionsplan: Wochen 1-2, einzelne Tests3–4, Pilotprojekte mit geringem Risiko; 5–6, Prozesse und Vorlagen definieren; 7–8, breite Bereitstellung mit Metriken.

Enthält eine Qualitätscheckliste:kompiliert ohne FehlerGibt es offensichtliche Sicherheitsrisiken? Erfüllt es die Stil- und Wartbarkeitsstandards?

Vermeiden Sie häufige Vorurteile: Delegieren Sie kein kritisches Denken, Tests überspringen, ignorieren Sie keine Sicherheitsaspekte und hinterlassen Sie keine vagen Eingabeaufforderungen ohne Kontext.

Messen Sie die Auswirkungen mit Geschwindigkeitsmetriken (Zeit pro Aufgabe, behobene Fehler pro Sitzung), Qualität (Fehlerrate, Wartbarkeit) und Lernen (Best Practices übernommen).

Hinweise zum freien Zugang und zur Verfügbarkeit

Verschiedene Quellen weisen auf Zeiträume hin, vorübergehender freier Zugang für Integrationen (Copilot, Cursor, Cline, Kilo Code). Als Zeitfenster werden der 26. August bis 10. September 2025 (PDT) für Copilot oder mindestens einwöchige Werbeaktionen für Launch-Partner genannt.

Da sich diese Fenster ändern, überprüfen Sie die Modellauswahl in Ihrer IDE oder in der Dokumentation des Herstellers. Wenn das Modell als kostenlos aufgeführt ist, nutzen Sie dies, um die Latenz zu bewerten, Qualität und Kosten vor umfangreicher Nutzung.

Wenn Ihnen nur noch eine Idee bleibt: Grok Code Fast 1 ist als agiler Code-Assistent konzipiert, mit Reasoning-Traces, Tools und strukturierter Ausgabe; wenn Sie klare Eingabeaufforderungen planen, den Cache nutzen und die Integration mit ACLs und Tests sichern, Sie können Lieferungen beschleunigen, ohne die Kosten zu erhöhen. und mit detaillierter Kontrolle über jeden Schritt.

Auf Technologie- und Internetthemen spezialisierter Redakteur mit mehr als zehn Jahren Erfahrung in verschiedenen digitalen Medien. Ich habe als Redakteur und Content-Ersteller für E-Commerce-, Kommunikations-, Online-Marketing- und Werbeunternehmen gearbeitet. Ich habe auch auf Websites aus den Bereichen Wirtschaft, Finanzen und anderen Sektoren geschrieben. Meine Arbeit ist auch meine Leidenschaft. Nun, durch meine Artikel in TecnobitsIch versuche, alle Neuigkeiten und neuen Möglichkeiten zu erkunden, die uns die Welt der Technologie jeden Tag bietet, um unser Leben zu verbessern.