- MusicGen wird zu 100 % lokal ausgeführt: Datenschutz, Kontrolle und Geschwindigkeit.

- Umgebung erstellt mit Python, PyTorch, FFmpeg und Audiocraft.

- Optimieren Sie die Leistung durch die Wahl der richtigen Modellgröße und GPU.

- Vollständiger kreativer Workflow ohne Abhängigkeit von Cloud-Speicher.

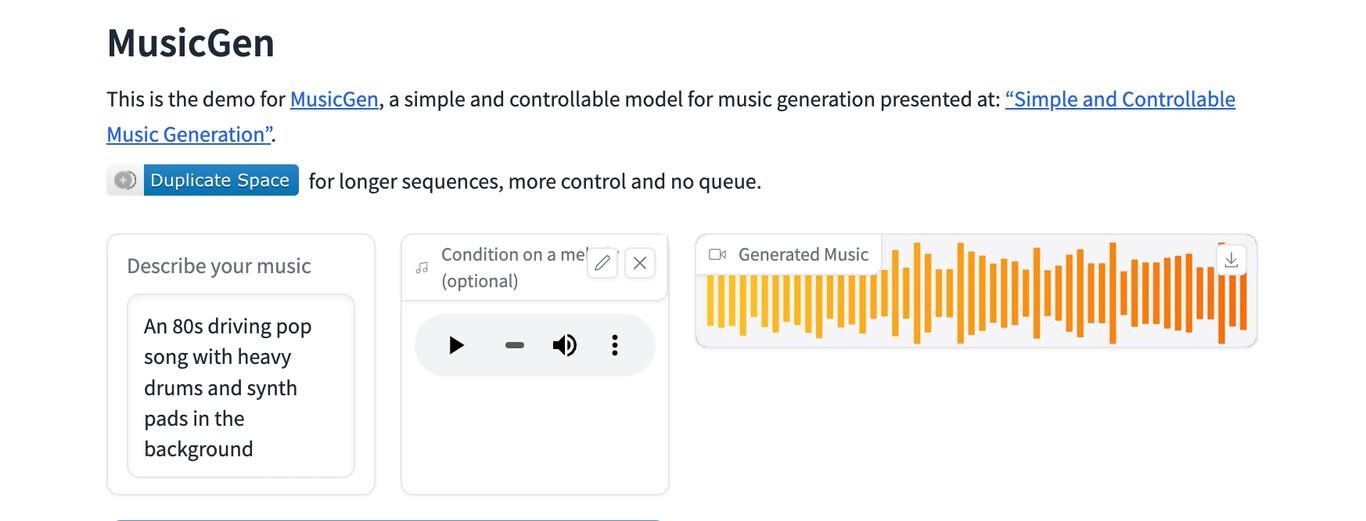

¿Wie kann ich Meta's MusicGen lokal verwenden? Musikgenerierung mit künstlicher Intelligenz ohne Abhängigkeit von externen Diensten ist heute durchaus möglich. Meta's MusicGen kann vollständig auf Ihrem Computer ausgeführt werden.Vermeiden Sie das Hochladen von Proben oder Ergebnissen in die Cloud und behalten Sie jederzeit die Kontrolle über Ihre Daten. Dieser Leitfaden führt Sie Schritt für Schritt durch den Prozess und bietet Ihnen praktische Empfehlungen, Hinweise zur Leistungsfähigkeit und Tipps, die den entscheidenden Unterschied machen.

Einer der Vorteile des lokalen Arbeitens ist die Freiheit, ohne Quotenbeschränkungen, ohne auf überlastete Server warten zu müssen und mit größerer Privatsphäre zu experimentieren. Im Gegensatz zu Cloud-Lösungen wie Speicher- und Authentifizierungs-SDKs, die für mobile Apps entwickelt wurden.Hier müssen Sie Ihre Audioinhalte nicht an Dritte auslagern: Die Modelle, Prompts und generierten Tracks bleiben bei Ihnen.

Was ist MusicGen und warum sollte man es lokal ausführen?

MusicGen ist ein von Meta entwickeltes Modell zur Musikgenerierung, das in der Lage ist, Stücke aus Textbeschreibungen zu erstellen und in einigen Varianten das Ergebnis mit einer Referenzmelodie zu verknüpfen. Ihr Vorschlag vereint Benutzerfreundlichkeit mit überraschender musikalischer Qualität.Wir bieten verschiedene Modellgrößen an, um ein Gleichgewicht zwischen Wiedergabetreue und Systemressourcenverbrauch zu gewährleisten.

Der lokale Betrieb des Computers hat mehrere wichtige Konsequenzen. Erstens, DatenschutzIhre Stimme, Ihre Samples und Ihre Kompositionen müssen nicht Ihr Gerät verlassen. Zweitens: die IterationsgeschwindigkeitSie sind weder auf Bandbreite zum Hochladen von Dateien noch auf ein entferntes Backend angewiesen. Und schließlich technische KontrolleSie können Bibliotheksversionen fixieren, Gewichtungen einfrieren und offline arbeiten, ohne von API-Änderungen überrascht zu werden.

Es ist wichtig, den Unterschied zu Cloud-Speicherlösungen zu verstehen. Zum Beispiel im mobilen Ökosystem Firebase erleichtert es Entwicklern von iOS- und anderen Plattformen, Audio-, Bild- und Videodateien zu speichern. Durch robuste SDKs, integrierte Authentifizierung und die natürliche Anbindung an Echtzeitdatenbanken für Textdaten ist dieser Ansatz ideal, wenn Synchronisierung, Zusammenarbeit oder schnelle Veröffentlichung erforderlich sind. Wenn es Ihre Priorität ist, nichts auf externe Server hochzuladenWenn Sie MusicGen auf Ihrem eigenen Computer ausführen, entfällt dieser Schritt komplett.

Die Community spielt Ihnen ebenfalls in die Karten. In offenen und inoffiziellen Foren wie r/StableDiffusion werden die neuesten Entwicklungen im Bereich kreativer Werkzeuge auf Basis generativer Modelle ausgetauscht und diskutiert. Es ist ein Ort, um Beiträge zu veröffentlichen, Fragen zu beantworten, Debatten anzustoßen, Technologie beizusteuern und Neues zu entdecken. Alles, was in der Musikszene passiert. Diese Open-Source- und Experimentierkultur passt perfekt zur lokalen Nutzung von MusicGen: Man testet, verbessert, dokumentiert und hilft anderen, die nach einem kommen. Man bestimmt das Tempo und die Vorgehensweise.

Sollten Sie bei Ihren Recherchen auf technische Fragmente stoßen, die nichts mit dem musikalischen Fluss zu tun haben – zum Beispiel, CSS-Stilblöcke mit definiertem Gültigkeitsbereich oder Frontend-Code-SnippetsBeachten Sie, dass diese Dateien für die Tonerzeugung irrelevant sind, aber manchmal auf Ressourcensammlungsseiten erscheinen. Konzentrieren Sie sich stattdessen auf die tatsächlichen Audio-Abhängigkeiten und die Binärdateien, die Sie auf Ihrem System benötigen.

Interessanterweise enthalten einige Ressourcenlisten Verweise auf wissenschaftliche Materialien oder Projektvorschläge im PDF-Format, die auf Universitätswebseiten gehostet werden. Auch wenn sie als Inspiration interessant sein mögenUm MusicGen lokal auszuführen, benötigen Sie im Wesentlichen Ihre Python-Umgebung, die Audiobibliotheken und die Modellgewichte.

Anforderungen und Vorbereitung der Umgebung

Bevor Sie die erste Notiz generieren, vergewissern Sie sich, dass Ihr Computer die Mindestanforderungen erfüllt. Es ist zwar auch mit einer CPU möglich, aber mit einer GPU ist das Ergebnis deutlich besser. Eine Grafikkarte mit CUDA- oder Metal-Unterstützung und mindestens 6-8 GB VRAM Es ermöglicht die Verwendung größerer Modelle und angemessener Inferenzzeiten.

Kompatible Betriebssysteme: Windows 10/11, macOS (Apple Silicon wird für eine gute Leistung bevorzugt) und gängige Linux-Distributionen. Sie benötigen Python 3.9–3.11.Sie benötigen eine virtuelle Umgebung (Conda oder venv) und FFmpeg zum Codieren/Decodieren von Audio. Installieren Sie auf NVIDIA-GPUs PyTorch mit der passenden CUDA-Version; auf macOS mit Apple Silicon die MPS-Version; und auf Linux die Version, die zu Ihren Treibern passt.

Die MusicGen-Modellgewichte werden beim ersten Aufruf aus den entsprechenden Bibliotheken (wie z. B. Meta's Audiocraft) heruntergeladen. Wenn Sie offline arbeiten möchtenLaden Sie die Dateien vorher herunter und konfigurieren Sie die lokalen Pfade so, dass das Programm nicht versucht, auf das Internet zuzugreifen. Dies ist besonders wichtig beim Arbeiten in geschlossenen Systemen.

Zum Thema Speicherung: Obwohl Tools wie Firebase Storage darauf ausgelegt sind, Dateien in der Cloud mit leistungsstarker Authentifizierung und SDKs zu speichern und abzurufen, Unser Ziel ist es, nicht auf diese Dienste angewiesen zu sein.Speichern Sie Ihre WAV/MP3-Dateien in lokalen Ordnern und verwenden Sie die Git LFS-Versionskontrolle, wenn Sie die Änderungsnachverfolgung von Binärdateien benötigen.

Zum Schluss bereiten Sie die Audio-Ein- und Ausgänge vor. FFmpeg ist unerlässlich Für die Konvertierung in Standardformate und zum Bereinigen oder Kürzen von Referenzbeispielen. Stellen Sie sicher, dass ffmpeg in Ihrem PATH enthalten ist und dass Sie es über die Konsole aufrufen können.

Schrittweise Installation in einer isolierten Umgebung

Ich schlage einen Workflow vor, der mit Windows, macOS und Linux unter Verwendung von Conda kompatibel ist. Falls Sie venv bevorzugen, passen Sie die Befehle entsprechend an. gemäß Ihrem Umgebungsmanager.

# 1) Crear y activar entorno

conda create -n musicgen python=3.10 -y

conda activate musicgen

# 2) Instalar PyTorch (elige tu variante)

# NVIDIA CUDA 12.x

pip install --upgrade pip

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

# CPU puro (si no tienes GPU)

# pip install torch torchvision torchaudio

# Apple Silicon (MPS)

# pip install torch torchvision torchaudio

# 3) FFmpeg

# Windows (choco) -> choco install ffmpeg

# macOS (brew) -> brew install ffmpeg

# Linux (apt) -> sudo apt-get install -y ffmpeg

# 4) Audiocraft (incluye MusicGen)

pip install git+https://github.com/facebookresearch/audiocraft

# 5) Opcional: manejo de audio y utilidades extra

pip install soundfile librosa numpy scipyFalls Ihre Umgebung die Installation über Git nicht zulässt, können Sie das Repository klonen und eine bearbeitbare Installation erstellen. Diese Methode erleichtert das Festlegen spezifischer Commits. zur Gewährleistung der Reproduzierbarkeit.

git clone https://github.com/facebookresearch/audiocraft.git

cd audiocraft

pip install -e .Testen Sie, ob alles in der Befehlszeile funktioniert.

Eine schnelle Möglichkeit, die Installation zu überprüfen, besteht darin, die in Audiocraft enthaltene Kommandozeilendemo zu starten. Dies bestätigt, dass die Gewichte heruntergeladen werden und der Inferenzprozess beginnt. korrekt in Ihrer CPU/GPU.

python -m audiocraft.demo.cli --help

# Generar 10 segundos de música con un prompt simple

python -m audiocraft.demo.cli \

--text 'guitarra acústica relajada con ritmo suave' \

--duration 10 \

--model musicgen-small \

--output ./salidas/clip_relajado.wavDer erste Durchlauf kann länger dauern, da das Modell heruntergeladen wird. Wenn Sie keine ausgehenden Verbindungen wünschenLaden Sie zunächst die Checkpoints herunter und platzieren Sie sie im Cache-Verzeichnis Ihrer Umgebung (z. B. in ~/.cache/torch oder dem von Audiocraft angegebenen Verzeichnis) und deaktivieren Sie das Netzwerk.

Verwendung von Python: Feinabstimmung

Für komplexere Arbeitsabläufe rufen Sie MusicGen von Python aus auf. Dies ermöglicht es Ihnen, den Startwert, die Anzahl der Kandidaten und die Temperatur festzulegen. und mit Spuren arbeiten, die durch Referenzmelodien geprägt sind.

from audiocraft.models import MusicGen

from audiocraft.data.audio import audio_write

import torch

# Elige el tamaño: 'small', 'medium', 'large' o 'melody'

model = MusicGen.get_pretrained('facebook/musicgen-small')

model.set_generation_params(duration=12, top_k=250, top_p=0.98, temperature=1.0)

prompts = [

'sintetizadores cálidos, tempo medio, ambiente cinematográfico',

'batería electrónica con bajo contundente, estilo synthwave'

]

with torch.no_grad():

wav = model.generate(prompts) # [batch, channels, samples]

for i, audio in enumerate(wav):

audio_write(f'./salidas/track_{i}', audio.cpu(), model.sample_rate, format='wav')Wenn Sie mit einer Melodie konditionieren möchten, verwenden Sie das Melodie-Typmodell und übergeben Sie Ihren Referenzclip. Dieser Modus respektiert melodische Konturen. und interpretiert den Stil entsprechend der Aufgabenstellung neu.

from audiocraft.models import MusicGen

from audiocraft.data.audio import load_audio, audio_write

model = MusicGen.get_pretrained('facebook/musicgen-melody')

model.set_generation_params(duration=8)

melody, sr = load_audio('./refs/melodia.wav', sr=model.sample_rate)

prompts = ['árpegios brillantes con pads espaciales']

wav = model.generate_with_chroma(prompts, melody[None, ...])

audio_write('./salidas/con_melodia', wav[0].cpu(), model.sample_rate, format='wav')Offline arbeiten und Modelle verwalten

Für einen vollständig lokalen Workflow laden Sie die Checkpoints herunter und konfigurieren Sie Umgebungsvariablen oder Routen, damit Audiocraft sie findet. Führen Sie eine Übersicht über Versionen und Gewichtungen. um die Reproduzierbarkeit zu gewährleisten und versehentliche Downloads zu verhindern, falls Sie das Netzwerk deaktivieren.

- Wählen Sie die Modellgröße entsprechend Ihrem VRAM: Kleinere Modelle verbrauchen weniger und reagieren schneller.

- Speichern Sie eine Sicherungskopie der Gewichte auf einer lokalen oder externen Festplatte.

- Dokumentieren Sie, welchen Audiocraft-Commit und welchen PyTorch-Build Sie verwenden.

Wenn Sie mehrere Maschinen verwenden, können Sie ein internes Spiegelbild Ihrer Bibliotheken und Gewichte erstellen. immer in einem lokalen Netzwerk und ohne irgendetwas dem Internet preiszugebenFür Produktionsteams mit strengen Richtlinien ist es praktisch.

Bewährte Vorgehensweisen für Eingabeaufforderungen und Parameter

Die Qualität der Spielanweisung hat einen erheblichen Einfluss. Sie beschreibt Instrumente, Tempo, Atmosphäre und stilistische Bezüge. Vermeiden Sie widersprüchliche Anfragen. und die Sätze sollten prägnant, aber musikalisch reichhaltig sein.

- Instrumentierung: Akustikgitarre, intimes Klavier, sanfte Streicher, Lo-Fi-Schlagzeug.

- Rhythmus und Tempo: 90 BPM, halbes Tempo, markierter Groove.

- Atmosphäre: filmisch, intim, düster, atmosphärisch, heiter.

- Produktion: dezenter Hall, moderate Kompression, analoge Sättigung.

Zu den Parametern: top_k und top_p steuern die Diversität; die Temperatur reguliert die Kreativität. Beginnen Sie mit moderaten Werten. und bewegen Sie sich schrittweise dahin, bis Sie den optimalen Punkt für Ihren Stil gefunden haben.

Leistung, Latenz und Qualität

Bei der Verwendung einer CPU kann die Inferenz langsam sein, insbesondere bei größeren Modellen und längeren Laufzeiten. Bei modernen GPUs verkürzen sich die Zeiten drastisch.Beachten Sie folgende Richtlinien:

- Beginnen Sie mit 8- bis 12-sekündigen Clips, um Ideen zu entwickeln und zu wiederholen.

- Generieren Sie mehrere kurze Varianten und verketten Sie die besten.

- Führe Upsampling oder Nachbearbeitung in deiner DAW durch, um das Ergebnis zu optimieren.

Auf macOS mit Apple Silicon bietet MPS einen Mittelweg zwischen dedizierter CPU und GPU. Aktualisieren Sie auf die neuesten Versionen von PyTorch. um Leistungs- und Speicherverbesserungen herauszuholen.

Postproduktion und Workflow mit Ihrer DAW

Sobald Sie Ihre WAV-Dateien erstellt haben, importieren Sie diese in Ihre bevorzugte DAW. Equalizer, Kompression, Hall und Bearbeitung Sie ermöglichen es Ihnen, vielversprechende Clips in vollständige Musikstücke umzuwandeln. Falls Sie einzelne Spuren oder Instrumententrennungen benötigen, nutzen Sie Quellentrennungswerkzeuge, um die Spuren neu zu kombinieren und zu mischen.

Eine hundertprozentige lokale Arbeitsweise schließt die Zusammenarbeit nicht aus: Teilen Sie die fertigen Dateien einfach über Ihre bevorzugten privaten Kanäle. Es ist nicht erforderlich, Daten zu veröffentlichen oder mit Cloud-Diensten zu synchronisieren. wenn Ihre Datenschutzrichtlinie davon abrät.

Häufige Probleme und deren Lösung

Installationsfehler: Inkompatible Versionen von PyTorch oder CUDA sind in der Regel die Ursache. Vergewissern Sie sich, dass die Brennerkonstruktion zu Ihrem Treiber passt. und System. Wenn Sie Apple Silicon verwenden, stellen Sie sicher, dass Sie keine Wheels installieren, die nur für x86 geeignet sind.

Downloads blockiert: Wenn Sie nicht möchten, dass sich Ihr Gerät mit dem Internet verbindet, Platzieren Sie die Gewichte wie von Audiocraft vorgesehen im Cache. Deaktivieren Sie alle externen Anrufe. Überprüfen Sie die Leseberechtigungen der Ordner.

Beschädigtes oder stummes Audio: Überprüfen Sie die Abtastrate und das Format. Konvertiere deine Schriftarten mit ffmpeg und eine gemeinsame Frequenz (z. B. 32 oder 44.1 kHz) beibehalten, um Artefakte zu vermeiden.

Schlechte Leistung: Verringert die Modellgröße oder die Clip-Dauer, Schließen Sie Prozesse, die VRAM verbrauchen. und erhöhen Sie die Komplexität schrittweise, wenn Sie freie Spielräume sehen.

Lizenzierungs- und verantwortungsvolle Nutzungsfragen

Bitte konsultieren Sie die MusicGen-Lizenz und die jeweiligen Datensätze, die Sie verwenden. Das lokale Generieren von Inhalten befreit Sie nicht von der Einhaltung der Urheberrechtsgesetze.Vermeiden Sie Vorgaben, die geschützte Werke oder Künstler direkt imitieren, und wählen Sie stattdessen allgemeine Stile und Genres.

Konzeptueller Vergleich: Cloud vs. lokal

Für Teams, die Apps entwickeln, bieten Dienste wie Firebase Storage SDKs mit Authentifizierung und Verwaltung von Audio-, Bild- und Videodateien sowie eine Echtzeitdatenbank für Text. Dieses Ökosystem ist ideal, wenn Sie Benutzer und Inhalte synchronisieren müssen.Im Gegensatz dazu vermeidet der lokale Modus bei einem privaten kreativen Workflow mit MusicGen Latenz, Kontingente und Datenlecks.

Man kann es sich als zwei getrennte Prozesse vorstellen. Wenn Sie Ergebnisse veröffentlichen, teilen oder in mobile Apps integrieren möchten, ist ein Cloud-basiertes Backend hilfreich. Wenn Ihr Ziel darin besteht, Prototypen zu erstellen und etwas zu entwickeln, ohne etwas hochzuladenKonzentriere dich auf deine Umgebung, dein Gewicht und deine lokale Festplatte.

So nutzen Sie Meta's MusicGen lokal: Ressourcen und Community

Foren und Subreddits, die sich mit generativen Werkzeugen befassen, sind ein guter Indikator für neue Entwicklungen und Techniken. Insbesondere gibt es inoffizielle Gemeinschaften, die Open-Source-Projekte unterstützen. wo man Kunstwerke veröffentlichen, Fragen stellen, Debatten starten, Technologie beisteuern oder einfach nur stöbern kann.Gemeinschaft öffnet Türen, die formale Dokumente nicht immer abdecken.

Sie finden außerdem Vorschläge und technische Dokumente in akademischen Repositorien und auf Universitätswebseiten, manchmal auch als herunterladbare PDFs. Nutzen Sie sie als methodische InspirationKonzentrieren Sie sich aber vor allem auf die tatsächlichen Audio-Abhängigkeiten und -Abläufe, damit MusicGen reibungslos auf Ihrem Rechner läuft.

Nach all dem haben Sie nun ein klares Verständnis davon, wie Sie die Umgebung einrichten, Ihre ersten Werke erstellen und die Ergebnisse verbessern können, ohne Ihr Material Dritten preiszugeben. Die Kombination aus einem guten lokalen Setup, sorgfältigen Anweisungen und einer Portion Nachbearbeitung Es wird Ihnen einen kraftvollen kreativen Fluss ermöglichen, den Sie vollständig kontrollieren können. Jetzt wissen Sie es. So verwenden Sie Meta's MusicGen lokal.

Seit seiner Kindheit begeistert er sich für Technik. Ich liebe es, in der Branche auf dem neuesten Stand zu sein und es vor allem zu kommunizieren. Deshalb widme ich mich seit vielen Jahren der Kommunikation auf Technologie- und Videospiel-Websites. Ich schreibe über Android, Windows, MacOS, iOS, Nintendo oder jedes andere verwandte Thema, das mir in den Sinn kommt.