- Le SAM comporte 3 segments avec des invites textuelles détaillées et intègre la vision et le langage pour une plus grande précision.

- SAM 3D reconstruit des objets et des corps en 3D à partir d'une seule image en utilisant des ressources ouvertes.

- Playground vous permet de tester la segmentation et la 3D sans connaissances techniques ni installation.

- Candidatures dans les domaines de l'édition, du marché et dans des secteurs tels que l'éducation, les sciences et le sport.

¿Comment convertir des personnes et des objets en modèles 3D avec SAM 3D ? L'intelligence artificielle appliquée au traitement de l'image a un impact considérable, et désormais, en plus de détourer précisément des objets, il est possible convertir une seule image en un modèle 3D Prêt à explorer sous de multiples angles ? Meta a introduit une nouvelle génération d’outils qui font le lien entre l’édition, la compréhension du monde visuel et la reconstruction tridimensionnelle, sans nécessiter d’équipement ni de connaissances avancés.

Nous parlons de SAM 3 et SAM 3D, deux modèles qui arrivent pour améliorer la détection, le suivi et la segmentation, et pour apporter Reconstruction 3D d'objets et de personnes à un large public. Leur proposition consiste à comprendre simultanément les instructions textuelles et les signaux visuels, de sorte que découper, transformer et reconstruire des éléments soit aussi simple que de taper ce que l'on veut ou d'effectuer quelques clics.

Que sont SAM 3 et SAM 3D et en quoi diffèrent-ils ?

La gamme Segment Anything de Meta s'agrandit avec deux nouveaux modules : SAM 3 et SAM 3D. Le premier se concentre sur l'identification, le suivi et la segmentation d'objets dans les photos et les vidéos avec une précision de nouvelle génération, tandis que le second… Reconstruit la géométrie et l'apparence 3D à partir d'une seule imagey compris les personnes, les animaux ou les produits du quotidien.

La différence fonctionnelle est claire : SAM 3 gère la « compréhension et la séparation » du contenu visuel, tandis que SAM 3D utilise cette compréhension pour « créer » un volume tridimensionnel. Grâce à cette association, un flux de travail qui nécessitait auparavant des logiciels complexes ou des scanners spécialisés devient… beaucoup plus accessible et plus rapide.

De plus, SAM 3 ne se limite pas à des indications visuelles de base. Il offre une segmentation guidée par le langage naturel capable d'interpréter descriptions très précisesOn ne parle plus seulement de « voiture » ou de « ballon », mais d'expressions comme « casquette de baseball rouge » pour situer précisément ces éléments dans une scène, voire tout au long d'une vidéo.

Parallèlement, SAM 3D se décline en deux versions complémentaires : SAM 3D Objects, axé sur objets et scèneset SAM 3D Body, entraîné à estimer la forme et le corps humain. Cette spécialisation lui permet de couvrir un large éventail de domaines, des biens de consommation aux portraits et aux poses, ouvrant ainsi la voie à des applications créatives, commerciales et scientifiques.

Comment parviennent-ils à segmenter et à reconstruire à partir d'une seule image ?

La clé réside dans une architecture entraînée sur de grands volumes de données afin d'établir des liens directs entre les mots et les pixels. Le modèle comprend simultanément les instructions écrites et les signaux visuels (clics, points ou carrés), de sorte que traduire une demande en domaines spécifiques d'une photo ou d'une image vidéo.

Cette compréhension du langage va au-delà des noms de classes traditionnels. SAM 3 peut gérer des instructions complexes, des exclusions et des nuances, permettant des requêtes telles que « personnes assises qui ne portent pas de chapeau rouge ». Cette compatibilité avec invites textuelles détaillées Il résout une limitation historique des modèles précédents, qui avaient tendance à confondre les concepts granulaires.

C’est là qu’intervient SAM 3D : à partir d’une image, il génère un modèle tridimensionnel permettant de visualiser l’objet sous d’autres angles, de réorganiser la scène ou d’appliquer des effets 3D. En pratique, il s’intègre à la segmentation précédente pour isoler ce qui nous intéresse et, par conséquent, Reconstruire en 3D sans étapes intermédiaires compliquées.

Nouvelles fonctionnalités par rapport aux générations précédentes

SAM 1 et SAM 2 ont révolutionné la segmentation en s'appuyant fortement sur des indices visuels. Cependant, ils éprouvaient des difficultés lorsqu'il s'agissait de fournir des interprétations longues ou des instructions nuancées en langage naturel. SAM 3 surmonte cet obstacle en intégrant compréhension multimodale qui relie plus directement le texte et l'image.

Meta accompagne ces progrès avec une nouvelle référence de segmentation du vocabulaire ouvertConçu pour évaluer la segmentation guidée par texte dans des scénarios réels, et avec la publication des pondérations SAM 3, cet outil permet aux chercheurs et développeurs de mesurer et de comparer rigoureusement les résultats obtenus avec différentes méthodes.

Dans sa nouvelle version, SAM 3D Objects améliore considérablement les approches précédentes, selon les données partagées par Meta, qui publie également des points de contrôle, le code d'inférence et un ensemble d'évaluation. Parallèlement à SAM 3D Body, la société lance Objets d'artiste 3D SAM, un nouvel ensemble de données créé avec des artistes pour évaluer la qualité 3D d'une grande variété d'images.

Applications concrètes et cas d'utilisation immédiats

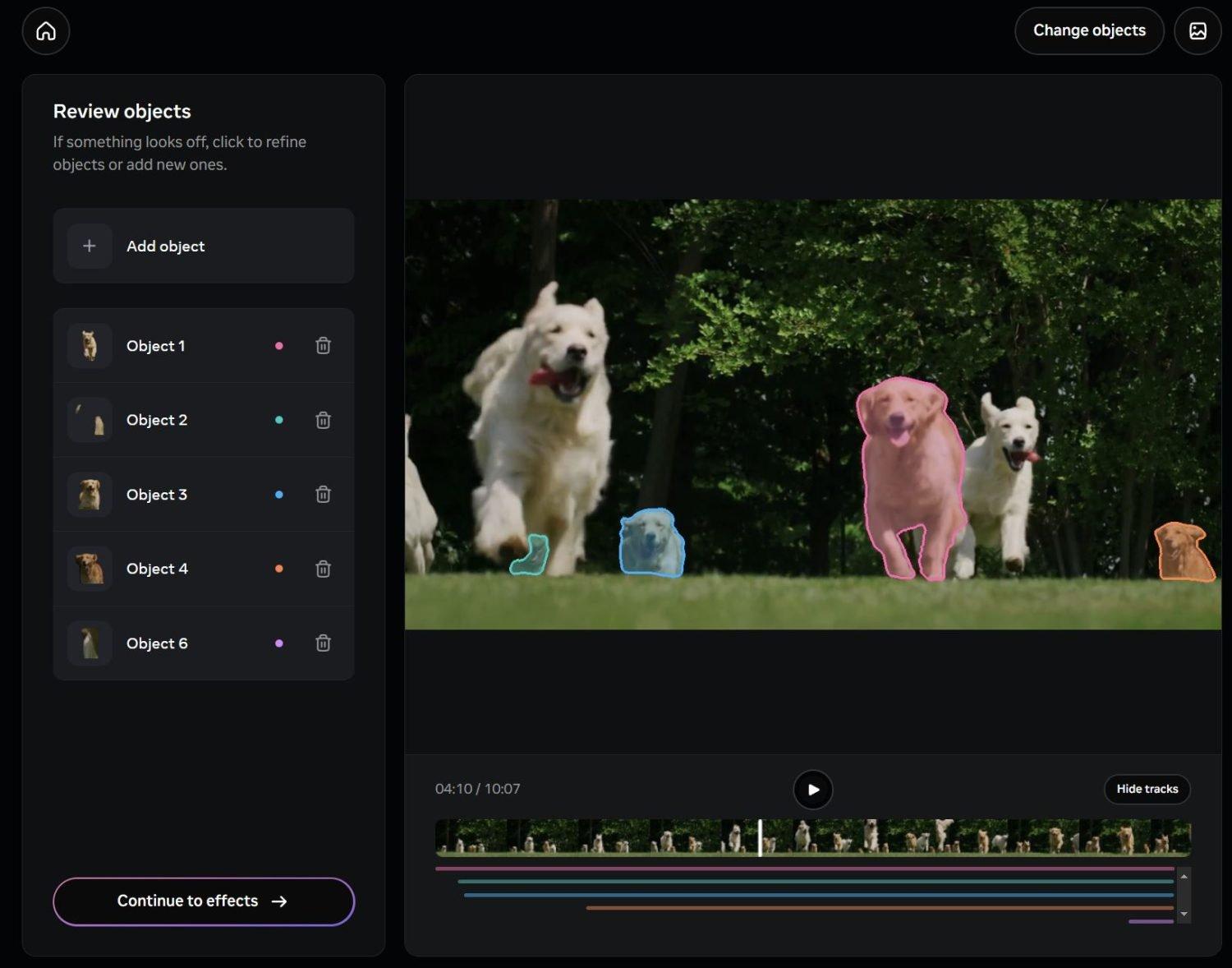

Meta intègre ces fonctionnalités à ses produits. Dans « Edits », son outil vidéo pour Instagram et Facebook, la segmentation avancée est déjà utilisée pour appliquer des effets aux vidéos. personnes ou objets spécifiques sans affecter le reste de l'image. Cela facilite les modifications d'arrière-plan, l'application de filtres sélectifs ou de transformations ciblées sans perte de qualité.

Ces fonctionnalités seront également disponibles dans Vibes, au sein de l'application Meta AI, et sur la plateforme meta.ai, offrant ainsi de nouvelles possibilités d'édition et de création. Grâce à la possibilité de fournir des instructions détaillées, l'utilisateur pourra décrire les modifications souhaitées, et le système s'adaptera en conséquence. automatise les tâches de post-production C'était autrefois laborieux.

Dans le domaine du commerce, la fonctionnalité « Voir dans la pièce » de Facebook Marketplace se distingue, permettant aux utilisateurs de visualiser l'apparence des meubles ou des lampes dans leur intérieur grâce à des modèles 3D générés automatiquement. Cette fonctionnalité réduit l'incertitude et améliore la décision d'achat, un point essentiel lorsque nous ne pouvons pas voir physiquement le produit.

L'impact s'étend à la robotique, aux sciences, à l'éducation et à la médecine sportive. La reconstruction 3D à partir de simples photographies peut alimenter des simulateurs, créer des modèles anatomiques de référence et soutenir des outils d'analyse qui nécessitaient auparavant un équipement spécialisé. Tout cela favorise nouveaux flux de travail en recherche et en formation.

Segment Anything Playground : testez et créez sans friction

Pour démocratiser l'accès, Meta a lancé Segmenter n'importe quel terrain de jeuUn site web où chacun peut télécharger des images ou des vidéos et expérimenter avec SAM 3 et SAM 3D. Son interface rappelle la « baguette magique » des éditeurs classiques, avec l'avantage de pouvoir Écrivez ce que nous voulons sélectionner ou affiner en quelques clics.

De plus, l'espace de jeu propose des modèles prêts à l'emploi. Ceux-ci incluent des options pratiques telles que : visages ou plaques d'immatriculation pixéliséset des effets plus créatifs comme les traînées lumineuses ou les projecteurs. Cela permet de réaliser des tâches de protection d'identité ou des effets visuels percutants en quelques secondes.

Au-delà de la segmentation, les utilisateurs peuvent explorer des scènes sous de nouveaux angles, les réorganiser ou appliquer des effets tridimensionnels avec SAM 3D. L'objectif est de rendre ces fonctionnalités accessibles à tous, même sans connaissances préalables en 3D ou en vision par ordinateur. obtenir des résultats acceptables en quelques minutes et sans rien installer.

Modèles, ressources ouvertes et évaluation

Meta a mis à disposition des ressources pour aider la communauté à faire progresser l'état de l'art. Pour SAM 3, les éléments suivants sont disponibles : poids du modèle Un référentiel de vocabulaire ouvert et un document technique détaillant l'architecture et la formation sont également fournis. Ceci facilite la reproductibilité et les comparaisons équitables.

Dans le domaine de la 3D, la société a publié des points de contrôle, du code d'inférence et une suite d'évaluation de nouvelle génération. La dualité de SAM 3D Objects et SAM 3D Body permet une couverture complète. objets généraux et le corps humain avec des métriques adaptées à chaque cas, un élément essentiel pour évaluer la fidélité géométrique et visuelle.

La collaboration avec des artistes pour la création d'objets 3D SAM introduit des critères esthétiques et de diversité dans l'évaluation, et non plus seulement des critères techniques. C'est essentiel pour que la reconstruction 3D soit utile dans environnements créatifs et commerciauxlà où la qualité perçue par les gens fait toute la différence.

Segmentation de texte : exemples et avantages

Avec SAM 3, il suffit de saisir « casquette de baseball rouge » pour que le système identifie toutes les occurrences dans une image ou une vidéo. Cette précision ouvre la voie à des flux de travail de montage où la simple saisie de « casquette de baseball rouge » suffit. phrases courtes et claires séparer les éléments et leur appliquer des effets ou des transformations.

La compatibilité avec les modèles de langage multimodaux permet de fournir des instructions plus riches, incluant des exclusions ou des conditions (« personnes assises ne portant pas de casquette rouge »). Cette flexibilité réduit le temps de travail manuel et diminue… erreurs de sélection qui étaient auparavant corrigées à la main.

Pour les équipes qui créent du contenu à grande échelle, la segmentation textuelle accélère les processus et facilite la standardisation des résultats. En marketing, par exemple, la cohérence peut être assurée en appliquant des filtres à une gamme de produits. améliore le temps et les coûts de production.

Édition pour les médias sociaux et créativité numérique

L'intégration dans Edits apporte des fonctionnalités de post-production avancées aux créateurs Instagram et Facebook. Un filtre qui nécessitait auparavant des masques complexes peut désormais être appliqué avec une simple commande texte et quelques clics, tout en conservant les bords et les détails fins stable image par image.

Pour les contenus courts, où le respect des délais de publication est crucial, cette automatisation est précieuse. Modifier l'arrière-plan d'un clip, mettre en valeur une seule personne ou transformer un objet spécifique ne nécessite plus de flux de travail manuels. effets démocratisent qui étaient auparavant réservées aux professionnels.

Parallèlement, Vibes et meta.ai élargissent la gamme d'expériences grâce à l'édition et à la créativité guidées par le langage. En pouvant décrire précisément nos besoins, le passage de l'idée au résultat est plus rapide, ce qui se traduit par… des itérations plus créatives en moins de temps.

Commerce, science et sport : au-delà du divertissement

La fonctionnalité « Voir dans la pièce » sur Facebook Marketplace illustre parfaitement son intérêt pratique : visualiser une lampe ou un meuble dans son salon avant de l’acheter réduit les retours et instaure un climat de confiance. Derrière ce système se cache un processus qui, à partir d’images, génère… Modèle 3D pour la visualisation contextuel.

En sciences et en éducation, la reconstruction à partir de simples photographies permet de réduire le coût de création de matériel pédagogique et de simulateurs réalistes. Un modèle anatomique généré par l'IA peut servir d'outil pédagogique en classe ou dans d'autres contextes. analyse biomécaniqueaccélérer la préparation du contenu.

En médecine du sport, l'association de l'analyse de la composition corporelle et de la reconstruction morphologique offre des outils pour étudier les postures et les mouvements sans équipement coûteux. Cela ouvre des perspectives pour des évaluations plus fréquentes et la surveillance à distance.

Confidentialité, éthique et bonnes pratiques

La puissance de ces outils exige de la responsabilité. Manipuler des images de personnes sans leur consentement peut entraîner des problèmes juridiques et éthiques. Il est conseillé d'éviter la reconstruction d'images. visages inconnusNe partagez pas les modèles sans autorisation et ne modifiez pas les scènes sensibles susceptibles de causer de la confusion ou du tort.

Meta annonce des mesures de contrôle pour limiter les abus, mais la responsabilité finale incombe à l'utilisateur de la technologie. Il est conseillé de vérifier l'origine des images, de protéger les données personnelles et… évaluer le contexte avant de publier des modèles 3D susceptibles de divulguer des informations privées.

Dans un contexte professionnel, la mise en place de politiques de révision et de consentement, ainsi que l'étiquetage clair des contenus générés par l'IA, contribuent à une utilisation responsable. Former l'équipe à ces sujets permet de prévenir les mauvaises pratiques déjà réagir rapidement aux incidents.

Comment convertir des personnes et des objets en modèles 3D avec SAM 3D : Premiers pas

Si vous souhaitez expérimenter immédiatement, l'espace de jeu Anything Playground est le point de départ idéal. Vous pouvez y importer une photo ou une vidéo, indiquer vos critères de sélection et tester les options de reconstruction 3D grâce à une interface simple. Pour les profils techniques, [d'autres options sont disponibles]. poids, points de contrôle et code qui facilitent les tests personnalisés.

Les chercheurs, les développeurs et les artistes disposent d'un écosystème comprenant des référentiels, des ensembles de données d'évaluation et de la documentation. L'objectif est d'établir un cadre commun pour mesurer les progrès et accélérer l'adoption. différents secteursDe la créativité numérique à la robotique.

Le plus intéressant, c'est que ce bond en avant n'est pas réservé aux spécialistes : la prise en main est plus rapide et les fonctionnalités s'intègrent aux applications du quotidien. Tout porte à croire que le montage et la 3D continueront de s'intégrer aux flux de travail. Le langage naturel est l'interface.

Avec SAM 3 et SAM 3D, Meta met la segmentation de texte et la reconstruction d'images uniques à la portée des créateurs et des équipes de toutes tailles. Entre l'espace de jeu, l'intégration dans Edits, les ressources ouvertes et les applications dans le commerce, l'éducation et le sport, une base solide se construit. nouvelle façon de travailler avec les images et le volume qui allie exactitude, accessibilité et responsabilité.

Passionné de technologie depuis qu'il est petit. J'aime être à jour dans le secteur et surtout le communiquer. C'est pourquoi je me consacre à la communication sur les sites de technologie et de jeux vidéo depuis de nombreuses années. Vous pouvez me trouver en train d'écrire sur Android, Windows, MacOS, iOS, Nintendo ou tout autre sujet connexe qui me vient à l'esprit.