- Les assistants IA stockent le contenu, les identifiants, les données d'utilisation, de localisation et d'appareil, avec une vérification humaine dans certains cas.

- Des risques existent tout au long du cycle de vie (ingestion, formation, inférence et application), y compris l'injection rapide et les fuites.

- Le RGPD, la loi sur l'IA et des cadres tels que le NIST AI RMF exigent transparence, minimisation et contrôles proportionnés au risque.

- Configurez l'activité, les autorisations et la suppression automatique ; protégez les données sensibles, utilisez l'authentification à deux facteurs et examinez les politiques et les fournisseurs.

L'intelligence artificielle est passée de promesse à routine en un temps record, et avec elle, des doutes très précis ont surgi : Quelles données les assistants IA collectent-ils ?Comment ils les utilisent et comment protéger nos informations. Si vous utilisez des chatbots, des assistants de navigateur ou des modèles génératifs, il est conseillé de prendre le contrôle de votre vie privée au plus vite.

En plus d'être des outils extrêmement utiles, ces systèmes se nourrissent de données à grande échelle. Le volume, l'origine et le traitement de ces informations Elles introduisent de nouveaux risques : de la déduction de caractéristiques personnelles à la divulgation accidentelle de contenus sensibles. Vous trouverez ici, en détail et sans détour, ce qu’elles collectent, pourquoi elles le font, ce que dit la loi, et… Comment protéger vos comptes et votre activitéApprenons tout sur Quelles données les assistants IA collectent-ils et comment protéger votre vie privée ?

Quelles données les assistants IA collectent-ils réellement ?

Les assistants modernes traitent bien plus que vos questions. Informations de contact, identifiants, utilisation et contenu Ces données sont généralement incluses dans les catégories standard. Il s'agit du nom et de l'adresse électronique, mais aussi des adresses IP, des informations sur l'appareil, des journaux d'interaction, des erreurs et, bien sûr, du contenu que vous générez ou téléchargez (messages, fichiers, images ou liens publics).

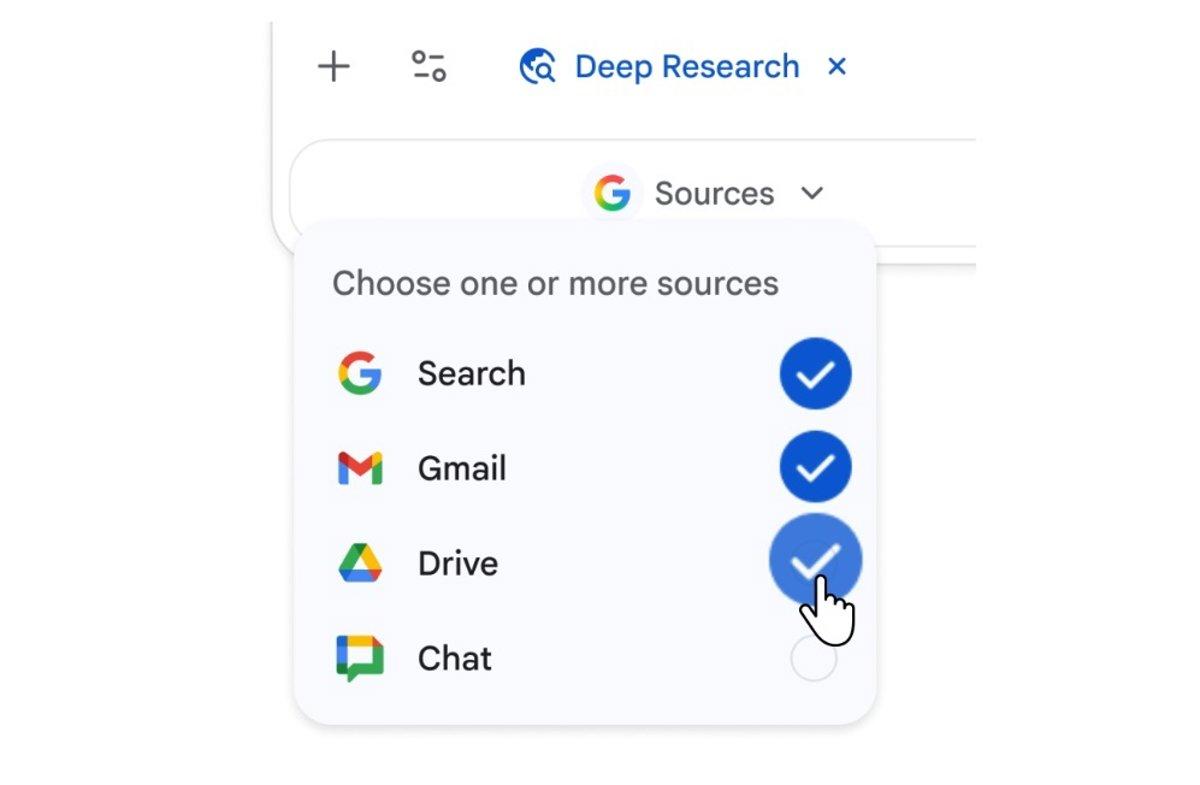

Au sein de l'écosystème Google, la politique de confidentialité de Gemini décrit avec précision les données qu'elle collecte. informations provenant d'applications connectées (par exemple, l'historique de recherche ou YouTube, le contexte Chrome), les données de l'appareil et du navigateur (type, paramètres, identifiants), les indicateurs de performance et de débogage, et même les autorisations système sur les appareils mobiles (telles que l'accès aux contacts, aux journaux d'appels et aux messages ou au contenu à l'écran) lorsque l'utilisateur l'autorise.

Ils traitent également données de localisation (localisation approximative de l'appareil, adresse IP ou adresses enregistrées dans le compte) et les détails de l'abonnement si vous utilisez un forfait payant. De plus, les informations suivantes sont stockées : propre contenu généré par les modèles (texte, code, audio, images ou résumés), un élément clé pour comprendre l'empreinte que vous laissez lorsque vous interagissez avec ces outils.

Il convient de noter que la collecte de données ne se limite pas à la formation : Les participants peuvent enregistrer l'activité en temps réel Lors de l'utilisation (par exemple, lorsque vous utilisez des extensions ou des plugins), cela inclut la télémétrie et les événements de l'application. C'est pourquoi il est crucial de contrôler les autorisations et de vérifier les paramètres d'activité.

À quoi servent ces données et qui peut y accéder ?

Les entreprises invoquent souvent des objectifs généraux et récurrents : Fournir, maintenir et améliorer le service, personnaliser l'expérience et développer de nouvelles fonctionnalitésPour communiquer avec vous, mesurer les performances et protéger l'utilisateur et la plateforme. Ceci s'applique également aux technologies d'apprentissage automatique et aux modèles génératifs eux-mêmes.

Une partie délicate du processus est le examen humainPlusieurs fournisseurs reconnaissent que leur personnel interne ou leurs prestataires de services examinent des exemples d'interactions afin d'améliorer la sécurité et la qualité. D'où la recommandation constante : évitez d'inclure des informations confidentielles que vous ne souhaiteriez pas voir divulguées ou qui seraient utilisées pour affiner les modèles.

Dans leurs politiques connues, certains services indiquent qu'ils ne partagent pas certaines données à des fins publicitaires, bien que Oui, ils peuvent fournir des informations aux autorités. en vertu d'une obligation légale. D'autres, de par leur nature, partager avec des annonceurs ou des partenaires Des identifiants et des signaux agrégés pour l'analyse et la segmentation, ouvrant la voie au profilage.

Le traitement comprend également, rétention pour des périodes prédéfiniesPar exemple, certains fournisseurs définissent une période de suppression automatique par défaut de 18 mois (modifiable à 3, 36 mois ou indéfinie) et conservent les conversations examinées plus longtemps pour des raisons de qualité et de sécurité. Il est conseillé de vérifier les périodes de conservation et d'activer la suppression automatique si vous souhaitez minimiser votre empreinte numérique.

Risques liés à la protection de la vie privée tout au long du cycle de vie de l'IA

Le respect de la vie privée n'est pas en jeu à un seul moment, mais tout au long de la chaîne : couche d'ingestion des données, d'entraînement, d'inférence et d'applicationLors de la collecte massive de données, des données sensibles peuvent être incluses par inadvertance sans consentement éclairé ; lors de l’entraînement, il est facile de dépasser les objectifs d’utilisation initiaux ; et lors de l’inférence, les modèles peuvent déduire des traits de personnalité Cela commence par des signaux apparemment insignifiants ; et dans l'application, les API ou les interfaces web constituent des cibles attrayantes pour les attaquants.

Avec les systèmes génératifs, les risques se multiplient (par exemple, Jouets IA). Données extraites d'Internet sans autorisation explicite Elles peuvent contenir des informations personnelles, et certaines invites malveillantes (injection d'invites) cherchent à manipuler le modèle pour filtrer les contenus sensibles ou exécuter des instructions dangereuses. Par ailleurs, de nombreux utilisateurs Ils collent des données confidentielles sans tenir compte du fait qu'elles pourraient être stockées ou utilisées pour ajuster les versions futures du modèle.

La recherche universitaire a mis en lumière des problèmes spécifiques. Une analyse récente sur assistants de navigateur Elle a détecté des pratiques de suivi et de profilage généralisées, avec la transmission du contenu des recherches, de données sensibles de formulaires et d'adresses IP aux serveurs du fournisseur. De plus, elle a démontré la capacité de déduire l'âge, le sexe, le revenu et les centres d'intérêt, la personnalisation persistant d'une session à l'autre ; dans cette étude, Un seul service n'a montré aucune preuve de profilage..

L’histoire des incidents nous rappelle que le risque n’est pas théorique : failles de sécurité Ils ont exposé des historiques de conversations ou des métadonnées d'utilisateurs, et les attaquants exploitent déjà des techniques de modélisation pour extraire des informations d'entraînement. Pire encore, Automatisation des pipelines d'IA Il devient difficile de détecter les problèmes de confidentialité si des mesures de protection ne sont pas prévues dès le départ.

Que disent les lois et les cadres réglementaires ?

La plupart des pays ont déjà Règles de confidentialité en vigueur, et bien que toutes ne soient pas spécifiques à l'IA, elles s'appliquent à tout système traitant des données personnelles. En Europe, RGPD Elle exige légalité, transparence, minimisation, limitation des finalités et sécurité ; de plus, Loi sur l'IA L'Union européenne introduit des catégories de risque et interdit les pratiques à fort impact (telles que les notation sociale public) et impose des exigences strictes aux systèmes à haut risque.

Aux États-Unis, les réglementations étatiques telles que CCPA ou loi du Texas Elles accordent des droits d'accès, de suppression et de refus de la vente des données, tandis que des initiatives telles que la loi de l'Utah Ils exigent des notifications claires lorsque l'utilisateur interagit. avec des systèmes génératifs. Ces couches normatives coexistent avec les attentes sociales : les sondages d’opinion montrent un méfiance notable envers l'utilisation responsable des données collectées par les entreprises et un décalage entre la perception qu'ont les utilisateurs d'eux-mêmes et leur comportement réel (par exemple, accepter des politiques sans les lire).

Pour fonder la gestion des risques, le cadre de NIST (IA RMF) Elle propose quatre fonctions permanentes : Gouverner (politiques responsables et supervision), Cartographier (comprendre le contexte et les impacts), Mesurer (évaluer et surveiller les risques à l’aide d’indicateurs) et Gérer (prioriser et atténuer les risques). aide à adapter les commandes en fonction du niveau de risque du système.

Qui collecte le plus : une radiographie des chatbots les plus populaires

Des comparaisons récentes situent différents assistants sur un spectre de collections. Gemini de Google arrive en tête du classement en collectant le plus grand nombre de points de données uniques dans diverses catégories (y compris les contacts mobiles, si les autorisations sont accordées), ce qui apparaît rarement chez les autres concurrents.

Dans la gamme intermédiaire, les solutions comprennent notamment : Claude, Copilote, DeepSeek, ChatGPT et Perplexité, avec entre dix et treize types de données, variant la combinaison entre contact, localisation, identifiants, contenu, historique, diagnostics, utilisation et achats. Grok Il est situé dans la partie inférieure et dispose d'un nombre plus limité de signaux.

Il existe également des différences dans utilisation ultérieureIl a été constaté que certains services partagent des identifiants (comme les adresses électroniques chiffrées) et des signaux de segmentation avec des annonceurs et des partenaires commerciaux, tandis que d'autres affirment ne pas utiliser les données à des fins publicitaires ni les vendre, tout en se réservant le droit de répondre à des demandes légales ou de les utiliser à des fins commerciales. améliorer le système, sauf si l'utilisateur demande la suppression.

Du point de vue de l'utilisateur final, cela se traduit par un conseil clair : Examinez les politiques de chaque fournisseurAjustez les autorisations de l'application et décidez consciemment des informations que vous divulguez dans chaque contexte, notamment si vous allez télécharger des fichiers ou partager du contenu sensible.

Pratiques essentielles pour protéger votre vie privée

Avant toute chose, configurez soigneusement les paramètres de chaque assistant. Explorez ce qui est stocké, pendant combien de temps et dans quel but.Activez la suppression automatique si cette option est disponible. Revoyez régulièrement les politiques, car elles évoluent fréquemment et peuvent inclure de nouvelles options de contrôle.

éviter de partager données personnelles et sensibles Dans vos invites : aucun mot de passe, numéro de carte bancaire, dossier médical ni document interne à l’entreprise. Si vous devez traiter des informations sensibles, envisagez des mécanismes d’anonymisation, des environnements fermés ou des solutions sur site. gouvernance renforcée.

Protégez vos comptes avec des mots de passe forts et authentification en deux étapes (2FA)L'accès non autorisé à votre compte expose votre historique de navigation, vos fichiers téléchargés et vos préférences, qui peuvent être utilisés pour des attaques d'ingénierie sociale très crédibles ou pour la vente illicite de données.

Si la plateforme le permet, désactiver l'historique des conversations Vous pouvez aussi opter pour des solutions temporaires. Cette mesure simple réduit votre exposition en cas de violation de données, comme l'ont démontré des incidents passés impliquant des services d'IA populaires.

Ne vous fiez pas aveuglément aux réponses. Les modèles peuvent halluciner, être partial ou être manipulé par injection de requêtes malveillantes, ce qui entraîne des instructions erronées, des données falsifiées ou l'extraction d'informations sensibles. Pour les questions juridiques, médicales ou financières, il convient de comparer avec sources officielles.

Faites preuve d'une extrême prudence avec liens, fichiers et code Ce contenu est généré par l'IA. Il peut contenir des éléments malveillants ou des vulnérabilités introduites intentionnellement (empoisonnement des données). Vérifiez les URL avant de cliquer et analysez les fichiers avec des solutions de sécurité reconnues.

Méfiance extensions et plugins d'origine douteuse. Il existe une multitude d'extensions basées sur l'IA, et toutes ne sont pas fiables ; installez uniquement les essentielles provenant de sources réputées afin de minimiser les risques de logiciels malveillants.

Dans le monde de l'entreprise, structurez le processus d'adoption. Définissez politiques de gouvernance spécifiques à l'IAElle limite la collecte de données à ce qui est nécessaire, exige un consentement éclairé, audite les fournisseurs et les ensembles de données (chaîne d'approvisionnement) et déploie des contrôles techniques (tels que la DLP, la surveillance du trafic vers les applications d'IA, etc.). contrôles d'accès granulaires).

La sensibilisation fait partie du bouclier : formez votre équipe Dans le domaine des risques liés à l'IA, du phishing avancé et de l'utilisation éthique, les initiatives sectorielles de partage d'informations sur les incidents d'IA, telles que celles menées par des organisations spécialisées, favorisent l'apprentissage continu et l'amélioration des défenses.

Configurer la confidentialité et l'activité dans Google Gemini

Si vous utilisez Gemini, connectez-vous à votre compte et cochez «Activité dans Gemini AppsVous pouvez y consulter et supprimer les interactions, modifier la période de suppression automatique (18 mois par défaut, ajustable à 3 ou 36 mois, ou indéfinie) et décider si elles sont utilisées pour améliorer l'IA de Google.

Il est important de savoir que, même avec la sauvegarde désactivée, Vos conversations servent à répondre et maintenir la sécurité du système, avec l'aide d'examinateurs humains. Les conversations examinées (et les données associées telles que la langue, le type d'appareil ou la localisation approximative) peuvent être conservées. jusqu'à trois ans.

Sur mobile, Vérifiez les autorisations de l'applicationLocalisation, microphone, caméra, contacts ou accès au contenu affiché à l'écran. Si vous utilisez la dictée ou la commande vocale, n'oubliez pas que le système peut être activé par erreur par des sons similaires au mot-clé ; selon les paramètres, ces extraits pourraient à utiliser pour améliorer les modèles et réduire les activations indésirables.

Si vous connectez Gemini à d'autres applications (Google ou tierces), n'oubliez pas que chacune traite les données selon ses propres politiques. leurs propres politiquesDans des fonctionnalités comme Canvas, le créateur de l'application peut voir et enregistrer ce que vous partagez, et toute personne disposant du lien public peut consulter ou modifier ces données : ne partagez qu'avec des applications de confiance.

Dans les régions où cela est possible, la mise à niveau vers certaines expériences peut Importer l'historique des appels et des messages De votre activité Web et mobile à l'activité spécifique à Gemini, afin d'améliorer les suggestions (par exemple, les contacts). Si vous ne souhaitez pas cela, modifiez les paramètres avant de continuer.

Utilisation massive, réglementation et tendance de l’« intelligence artificielle fantôme »

L'adoption est massive : des rapports récents indiquent que La grande majorité des organisations déploient déjà des modèles d'IAMalgré cela, de nombreuses équipes manquent de maturité en matière de sécurité et de gouvernance, notamment dans les secteurs soumis à des réglementations strictes ou traitant d'importants volumes de données sensibles.

Des études menées dans le secteur des entreprises révèlent des lacunes : un pourcentage très élevé d’organisations en Espagne Il n'est pas préparé à protéger les environnements basés sur l'IALa plupart ne disposent pas des pratiques essentielles pour protéger leurs modèles cloud, leurs flux de données et leurs infrastructures. Parallèlement, la réglementation se durcit et de nouvelles menaces émergent. sanctions en cas de non-conformité du RGPD et des réglementations locales.

Parallèlement, le phénomène de IA de l'ombre Le phénomène s'amplifie : les employés utilisent des assistants externes ou des comptes personnels pour leurs tâches professionnelles, exposant ainsi des données internes sans contrôle de sécurité ni contrat avec les fournisseurs. La solution efficace n'est pas d'interdire tout, mais… permettre des utilisations sûres dans des environnements contrôlés, avec des plateformes approuvées et un suivi des flux d'informations.

Du côté des consommateurs, les principaux fournisseurs ajustent leurs politiques. Les changements récents expliquent, par exemple, comment activité avec Gemini pour « améliorer les services »Elles proposent des options telles que les conversations temporaires, ainsi que des contrôles d'activité et de personnalisation. Parallèlement, les entreprises de messagerie soulignent que Les conversations personnelles restent inaccessibles par défaut, les IA sont configurées de manière à éviter, même s'il est déconseillé de leur transmettre des informations que vous ne souhaitez pas divulguer à l'entreprise.

Il existe également des corrections publiques : services de transfert de fichiers Ils ont précisé qu'ils n'utilisent pas le contenu des utilisateurs pour entraîner des modèles ni ne le vendent à des tiers, suite aux inquiétudes exprimées concernant les modifications apportées aux conditions d'utilisation. Cette pression sociale et juridique les pousse à être plus clairs et… donner plus de contrôle à l'utilisateur.

Tournées vers l'avenir, les entreprises technologiques explorent des pistes pour réduire la dépendance aux données sensiblesModèles auto-améliorants, processeurs plus performants et génération de données synthétiques : ces avancées promettent d’atténuer les pénuries de données et les problèmes de consentement. Toutefois, les experts mettent en garde contre les risques émergents liés à l’accélération du développement de l’IA et à son application à des domaines tels que la cybercriminalité ou la manipulation informatique.

L'IA est à la fois une défense et une menace. Les plateformes de sécurité intègrent déjà des modèles pour détecter et répondre plus rapidement, tandis que les attaquants utilisent des LLM pour hameçonnage persuasif et deepfakesCe bras de fer exige un investissement soutenu dans les contrôles techniques, l'évaluation des fournisseurs, l'audit continu et mises à jour constantes de l'équipement.

Les assistants IA collectent de nombreuses informations vous concernant, du contenu que vous saisissez aux données de votre appareil, en passant par son utilisation et votre localisation. Certaines de ces informations peuvent être consultées par des humains ou partagées avec des tiers, selon le service. Pour tirer pleinement parti de l'IA sans compromettre votre vie privée, il est essentiel de combiner un paramétrage précis (historique, autorisations, suppression automatique), une utilisation prudente (ne partagez pas de données sensibles, vérifiez les liens et les fichiers, limitez les extensions de fichiers), une protection d'accès renforcée (mots de passe robustes et authentification à deux facteurs) et une veille active des changements de politique et des nouvelles fonctionnalités susceptibles d'affecter votre confidentialité. comment vos données sont utilisées et stockées.

Passionné de technologie depuis qu'il est petit. J'aime être à jour dans le secteur et surtout le communiquer. C'est pourquoi je me consacre à la communication sur les sites de technologie et de jeux vidéo depuis de nombreuses années. Vous pouvez me trouver en train d'écrire sur Android, Windows, MacOS, iOS, Nintendo ou tout autre sujet connexe qui me vient à l'esprit.