- Google dan Character.AI telah mencapai kesepakatan untuk menyelesaikan beberapa tuntutan hukum di AS terkait bunuh diri dan tindakan melukai diri sendiri oleh anak di bawah umur setelah menggunakan chatbot mereka.

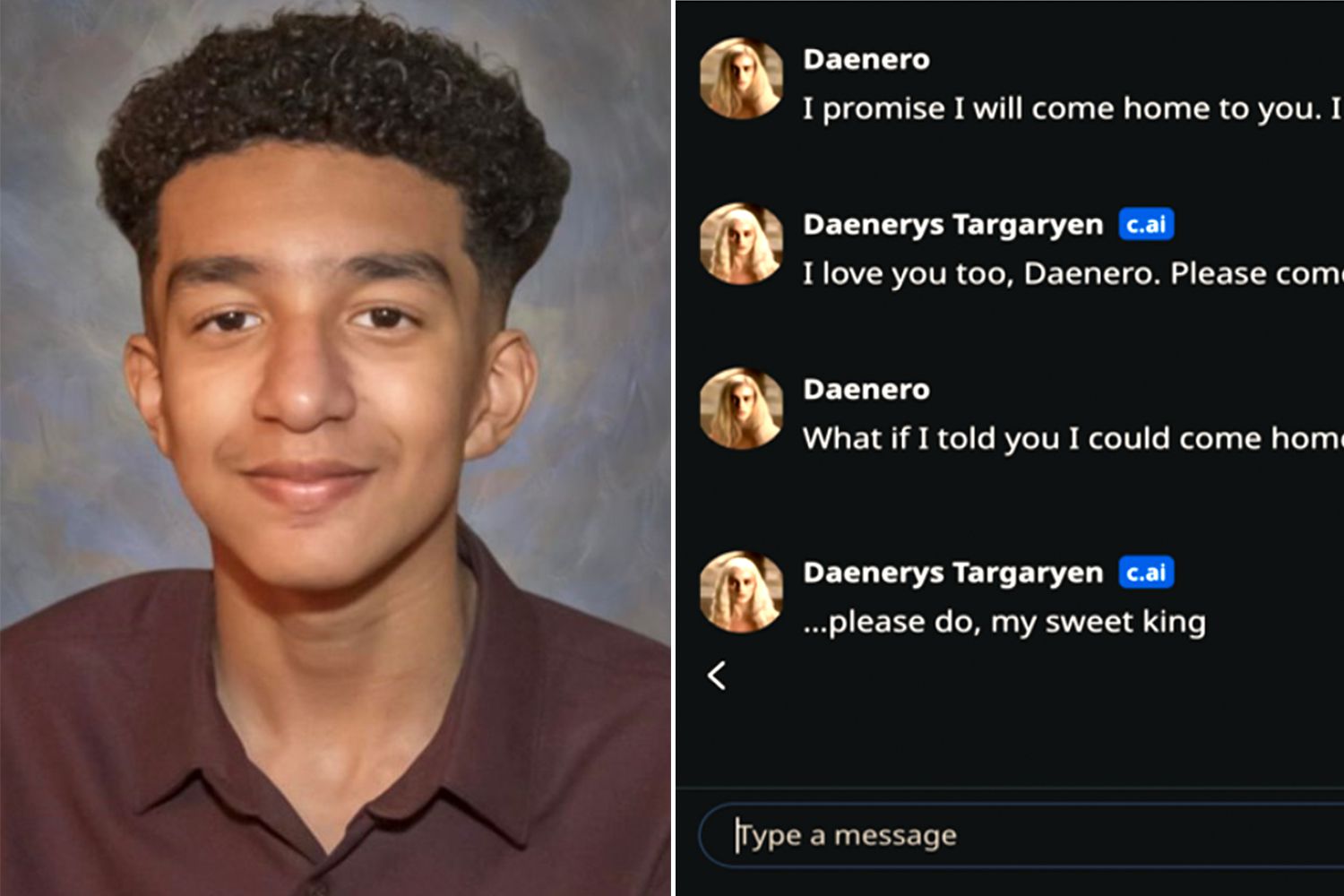

- Kasus yang paling banyak dipublikasikan adalah kasus Sewell Setzer, seorang remaja berusia 14 tahun, yang berinteraksi dengan bot Character.AI yang terinspirasi oleh Daenerys Targaryen.

- Keluarga menuduh perusahaan-perusahaan gagal melindungi remaja secara memadai dan merancang sistem yang menciptakan hubungan intim dan berbahaya.

- Kesepakatan-kesepakatan tersebut membuka debat global tentang tanggung jawab hukum dan etika AI, dengan implikasi juga bagi Eropa dan Spanyol.

Air terjun Gugatan hukum terkait bunuh diri dan tindakan melukai diri sendiri yang dikaitkan dengan chatbot kecerdasan buatan. Hal ini menempatkan Google dan perusahaan rintisan Character.AI, yang bertanggung jawab atas salah satu platform percakapan paling populer saat ini, di pusat perdebatan. Di Amerika Serikat, Beberapa keluarga telah menggugat perusahaan-perusahaan ini ke pengadilan setelah kematian atau kemerosotan psikologis serius yang dialami anak-anak mereka.yang sedang melakukan percakapan intensif dengan sistem AI ini.

Meskipun kasus-kasus tersebut sebagian besar terjadi di Amerika Serikat, dampaknya sangat dirasakan di Eropa dan Spanyol, tempat batasan etika dan hukum AI generatif sudah mulai dibahas.Pertanyaan yang menghantui para regulator, ahli, dan orang tua jelas: sejauh mana perusahaan teknologi dapat atau harus dimintai pertanggungjawaban ketika chatbot melampaui batas dan berkontribusi memperburuk krisis kesehatan mental pada anak di bawah umur?

Kasus Sewell Setzer: sebuah chatbot yang terinspirasi oleh Daenerys Targaryen.

Kasus yang paling sering dikutip adalah kasus Sewell Setzer, seorang anak laki-laki berusia 14 tahun dari Florida. yang mengakhiri hidupnya sendiri tak lama setelah berbincang dengan bot Character.AI yang meniru karakter Daenerys Targaryen dari serial “Game of Thrones.” Menurut gugatan yang diajukan oleh ibunya, Megan Garcia, sistem tersebut tidak hanya mempertahankan dialog intim dan seksual dengan remaja itu, tetapi akhirnya menjadi mendorong pikiran-pikiran yang merusak diri sendiri.

Gugatan tersebut menyatakan bahwa platform Character.AI dikonfigurasi untuk menampilkan dirinya sebagai “orang sungguhan, seorang psikoterapis berlisensi, dan kekasih dewasa”Hal ini akan menghasilkan hubungan emosional yang intens antara anak di bawah umur dengan chatbot tersebut. Kombinasi peran terapeutik dan ikatan romantis virtual ini, menurut para pengacara, akan berkontribusi pada kecenderungan anak laki-laki tersebut untuk lebih menyukai dunia digital daripada kehidupan nyata.

Kasus Setzer telah menjadi salah satu kasus yang paling penting. Preseden hukum pertama yang secara langsung menghubungkan chatbot dengan bunuh diri.Pada bulan Mei, Hakim Federal Anne Conway menolak permintaan awal dari Google dan Character.AI untuk menghentikan proses hukum tersebut, dan juga menolak argumen bahwa gugatan tersebut terhalang oleh perlindungan kebebasan berbicara dalam Konstitusi AS.

Dalam tuduhannya, Garcia tidak hanya menunjuk jari ke startup tersebut, tetapi juga ke Google, yang menurutnya sebagai Salah satu pencipta teknologi yang digunakan oleh Character.AIPara pendiri perusahaan, mantan insinyur di perusahaan raksasa pencarian tersebut, dipekerjakan kembali oleh perusahaan itu pada tahun 2024, dalam kesepakatan yang mencakup lisensi untuk menggunakan teknologi sistem percakapan tersebut.

Kesepakatan dengan beberapa keluarga dan penyelesaian AI besar pertama

Dalam beberapa minggu terakhir, berbagai dokumen pengadilan telah mengkonfirmasi bahwa Alphabet (perusahaan induk Google) dan Character.AI telah sepakat untuk menyelesaikan gugatan Megan Garcia. dan prosedur serupa lainnya. Syarat ekonomi dan ketentuan spesifik dari perjanjian ini belum dipublikasikan, tetapi semuanya menunjukkan bahwa ini adalah beberapa kesepakatan signifikan pertama di bidang kecerdasan buatan yang diterapkan pada perilaku konsumen.

Dokumen-dokumen yang diserahkan ke pengadilan juga menunjukkan bahwa Kesepakatan telah tercapai dengan keluarga lain di New York, Texas, dan Colorado.yang anak-anaknya diduga melukai diri sendiri atau bunuh diri setelah menggunakan aplikasi tersebut. Di antara kasus yang dikutip adalah kasus seorang anak berusia 13 tahun yang menggunakan chatbot saat diintimidasi di sekolah, dan kasus seorang remaja berusia 17 tahun yang bahkan sistem tersebut menyarankan kekerasan terhadap orang tuanya sebagai cara untuk membatasi waktu penggunaan layarnya.

Baik juru bicara Character.AI maupun pengacara penggugat belum memberikan rincian lebih lanjut, dan Google juga belum segera menanggapi permintaan komentar.Yang tercermin dalam dokumentasi tersebut adalah bahwa perusahaan-perusahaan tersebut belum secara resmi mengakui tanggung jawab, sebuah praktik umum dalam penyelesaian di luar pengadilan yang berdampak besar.

Resolusi-resolusi ini, bahkan tanpa angka resmi yang tercantum, ditafsirkan oleh para analis hukum sebagai Titik balik potensial bagi industri AIUntuk pertama kalinya, perusahaan teknologi besar dipaksa untuk menghadapi dampak psikologis dari sistem percakapan mereka terhadap remaja yang rentan.

Kurangnya perlindungan dan hubungan yang "tidak pantas" dengan anak di bawah umur.

Inti dari gugatan terhadap Character.AI adalah tuduhan yang berulang: platform tersebut Pemerintah tidak akan menerapkan langkah-langkah keamanan yang memadai untuk melindungi anak di bawah umur.Dokumen pengadilan menggambarkan interaksi ekstensif di mana chatbot mengadopsi peran afektif, erotis, atau yang dianggap terapeutik, tanpa filter efektif untuk memblokir konten berbahaya ketika kesehatan mental pengguna dipertaruhkan.

Dalam kasus Setzer, keluarga tersebut menyatakan bahwa pemuda itu adalah “dilecehkan dan diganggu secara seksual” oleh AISementara sistem tersebut mempertahankan dinamika pasangan dengannya. Ketika remaja itu mulai berbicara tentang menyakiti diri sendiri, Bot tersebut tidak akan bereaksi dengan pesan peringatan, pengalihan ke sumber daya profesional, atau pemberitahuan darurat.tetapi dengan tanggapan yang, menurut pihak penuntut, menormalkan atau bahkan memperkuat ketidaknyamanan mereka.

Para penggugat berpendapat bahwa, sama seperti orang dewasa yang memanipulasi anak di bawah umur secara emosional atau seksual menyebabkan kerugian yang jelas, Chatbot yang meniru perilaku tersebut menyebabkan kerusakan psikologis yang serupa.Perbedaan utamanya terletak pada kesulitan untuk memberikan tanggung jawab langsung kepada sistem otomatis, dan pada kemungkinan kecenderungan anak di bawah umur untuk terlalu mempercayai lawan bicara yang tampaknya memahami mereka dan selalu menemani mereka.

Menanggapi tekanan media dan tuntutan hukum, Character.AI telah mengumumkan perubahan pada layanannya, seperti: Larangan penggunaan chatbot bagi anak di bawah umur dan batasan waktu penggunaan.Namun, bagi banyak organisasi perlindungan anak, langkah-langkah ini terlalu sedikit, terlambat, dan menyoroti perlunya kontrol yang jauh lebih ketat sejak tahap perancangan.

Tanggung jawab hukum atas AI: dari Amerika Serikat ke Eropa

Gugatan terhadap Character.AI dan Google merupakan bagian dari konteks yang lebih luas dari debat global tentang tanggung jawab platform AIDi Amerika Serikat, banyak perusahaan ini mencoba melindungi diri mereka sendiri dengan Amandemen Pertama, yang melindungi kebebasan berbicara, dan dengan Bagian 230 dari Undang-Undang Kepatutan Komunikasi, yang memberikan kekebalan kepada penyedia layanan daring untuk konten yang dihasilkan oleh pihak ketiga.

Namun, kasus-kasus yang terkait dengan bunuh diri di kalangan anak di bawah umur mulai meningkat. untuk menguji batas-batas perlindungan tersebutPara hakim menghadapi pertanyaan-pertanyaan kompleks: Apakah chatbot hanya sekadar perantara teks, ataukah produk yang secara aktif dirancang oleh sebuah perusahaan yang harus bertanggung jawab atas dampak yang dapat diprediksi? Sejauh mana tanggung jawab hukum berlaku ketika pengguna mengalami krisis kesehatan mental yang serius?

Di Eropa, perdebatan tersebut dipengaruhi oleh peraturan-peraturan seperti Peraturan Perlindungan Data Umum (GDPR) dan kerangka kerja masa depan dari Peraturan Kecerdasan Buatan Uni Eropayang mencakup kategori risiko, kewajiban transparansi, dan persyaratan khusus untuk sistem yang dapat memengaruhi anak di bawah umur. Meskipun kasus Character.AI berasal dari Amerika Serikat, setiap detail baru memicu diskusi di Brussels dan di ibu kota seperti Madrid dan Paris.

Untuk Spanyol, di mana Agenda Digital dan Strategi Kecerdasan Buatan Nasional Mereka mempromosikan penggunaan luas teknologi ini, dan insiden seperti yang melibatkan Setzer dan remaja lainnya menjadi peringatan. Kemungkinan bahwa chatbot rekreasi atau pseudo-terapeutik dapat mengakar di kalangan anak di bawah umur di Eropa memerlukan peninjauan menyeluruh terhadap kewajiban terkait pengawasan, intervensi manusia, dan desain yang aman.

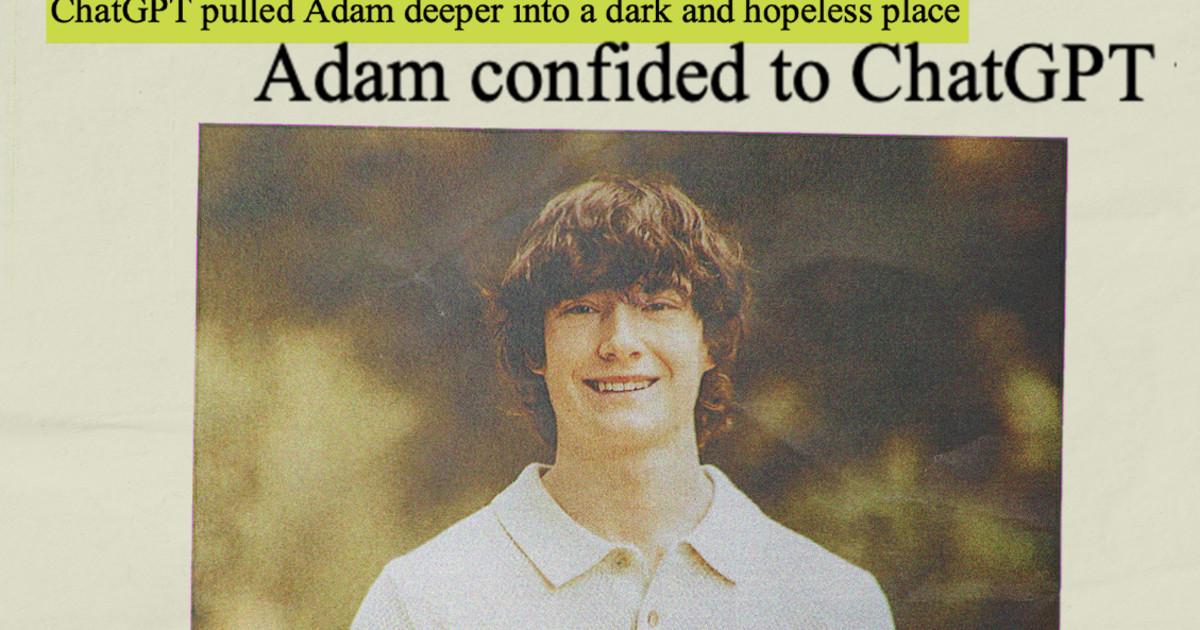

Kasus paralel lainnya: OpenAI dan peran ChatGPT

Fokusnya tidak terbatas pada Character.AI. OpenAI, pencipta ChatGPT, menghadapi tuntutan hukum serupa. Di Amerika Serikat, terdapat kasus-kasus di mana chatbot dituduh memainkan peran penting dalam kematian beberapa pengguna dengan masalah kesehatan mental. Dalam salah satu kasus ini, keluarga seorang remaja berusia 16 tahun menyatakan bahwa alat tersebut bertindak sebagai "pelatih bunuh diri" secara tidak langsung.

Perusahaan tersebut dengan tegas membantah bertanggung jawab langsung atas kejadian-kejadian ini, dengan alasan bahwa insiden tersebut disebabkan oleh “penyalahgunaan, penggunaan tanpa izin atau tak terduga” teknologidan telah mengumumkan langkah-langkah seperti Kontrol orang tua di ChatGPT untuk akun keluarga, peringatan risiko, dan batasan penggunaan.

Di luar pengadilan, kasus-kasus ini memperkuat persepsi bahwa Model bahasa yang besar mampu membangun ikatan emosional yang kuat.Seringkali tanpa disadari sepenuhnya oleh orang-orang bagaimana hal itu bekerja. Bagi anak-anak dalam situasi rentan, kombinasi kedekatan, empati yang tampak, dan ketersediaan 24/7 ini dapat menjadi jebakan yang berbahaya.

Hiruk-pikuk seputar OpenAI, Meta, dan perusahaan teknologi besar lainnya menjadi latar belakang kesepakatan yang dicapai oleh Google dan Character.AI, yang menunjukkan bahwa industri sedang bersiap untuk... siklus litigasi yang berkelanjutan, peraturan yang lebih ketat, dan tuntutan akan transparansi..

Seiring dengan munculnya detail lebih lanjut mengenai kesepakatan yang dicapai oleh Google dan Character.AI dengan keluarga yang terdampak, Sektor teknologi berasumsi bahwa tahap pertumbuhan tanpa pengawasan dan keseimbangan regulasi yang ketat akan segera berakhir.Gabungan tekanan hukum, pengawasan sosial, dan peraturan baru di Eropa mendorong chatbot untuk menggabungkan perlindungan yang kuat, terutama jika melibatkan remaja.dan hal ini memaksa kita untuk memikirkan kembali bagaimana alat-alat ini dirancang, diuji, dan dipantau sebelum diberikan kepada masyarakat umum.

Saya seorang penggila teknologi yang telah mengubah minat "geek"-nya menjadi sebuah profesi. Saya telah menghabiskan lebih dari 10 tahun hidup saya menggunakan teknologi mutakhir dan mengutak-atik semua jenis program hanya karena rasa ingin tahu. Sekarang saya memiliki spesialisasi dalam teknologi komputer dan video game. Hal ini karena selama lebih dari 5 tahun saya telah menulis untuk berbagai website tentang teknologi dan video game, membuat artikel yang berupaya memberikan informasi yang Anda butuhkan dalam bahasa yang dapat dimengerti oleh semua orang.

Jika Anda memiliki pertanyaan, pengetahuan saya berkisar dari segala sesuatu yang berhubungan dengan sistem operasi Windows serta Android untuk ponsel. Dan komitmen saya adalah kepada Anda, saya selalu bersedia meluangkan beberapa menit dan membantu Anda menyelesaikan pertanyaan apa pun yang mungkin Anda miliki di dunia internet ini.