- Google e Character.AI hanno raggiunto un accordo per risolvere diverse cause legali negli Stati Uniti riguardanti casi di suicidio e autolesionismo da parte di minori dopo aver utilizzato i loro chatbot.

- Il caso più pubblicizzato è quello del quattordicenne Sewell Setzer, che ha interagito con un bot Character.AI ispirato a Daenerys Targaryen.

- Le famiglie accusano le aziende di non proteggere adeguatamente gli adolescenti e di progettare sistemi che creano relazioni intime e dannose.

- Gli accordi aprono un dibattito globale sulla responsabilità legale ed etica dell'IA, con implicazioni anche per l'Europa e la Spagna.

La cascata di Cause legali per suicidio e autolesionismo attribuite a chatbot con intelligenza artificiale Ciò ha posto Google e la startup Character.AI, responsabile di una delle piattaforme conversazionali più popolari del momento, al centro del dibattito. Negli Stati Uniti, Diverse famiglie hanno portato queste aziende in tribunale dopo la morte o il grave deterioramento psicologico dei loro figliche avevano conversazioni intense con questi sistemi di intelligenza artificiale.

Sebbene i casi si verifichino principalmente negli Stati Uniti, il loro impatto è fortemente avvertito in Europa e Spagna, dove si stanno già discutendo i limiti etici e legali dell'IA generativaLa domanda che incombe su autorità di regolamentazione, esperti e genitori è chiara: in che misura le aziende tecnologiche possono o dovrebbero essere ritenute responsabili quando un chatbot oltrepassa il limite e contribuisce ad aggravare una crisi di salute mentale nei minori?

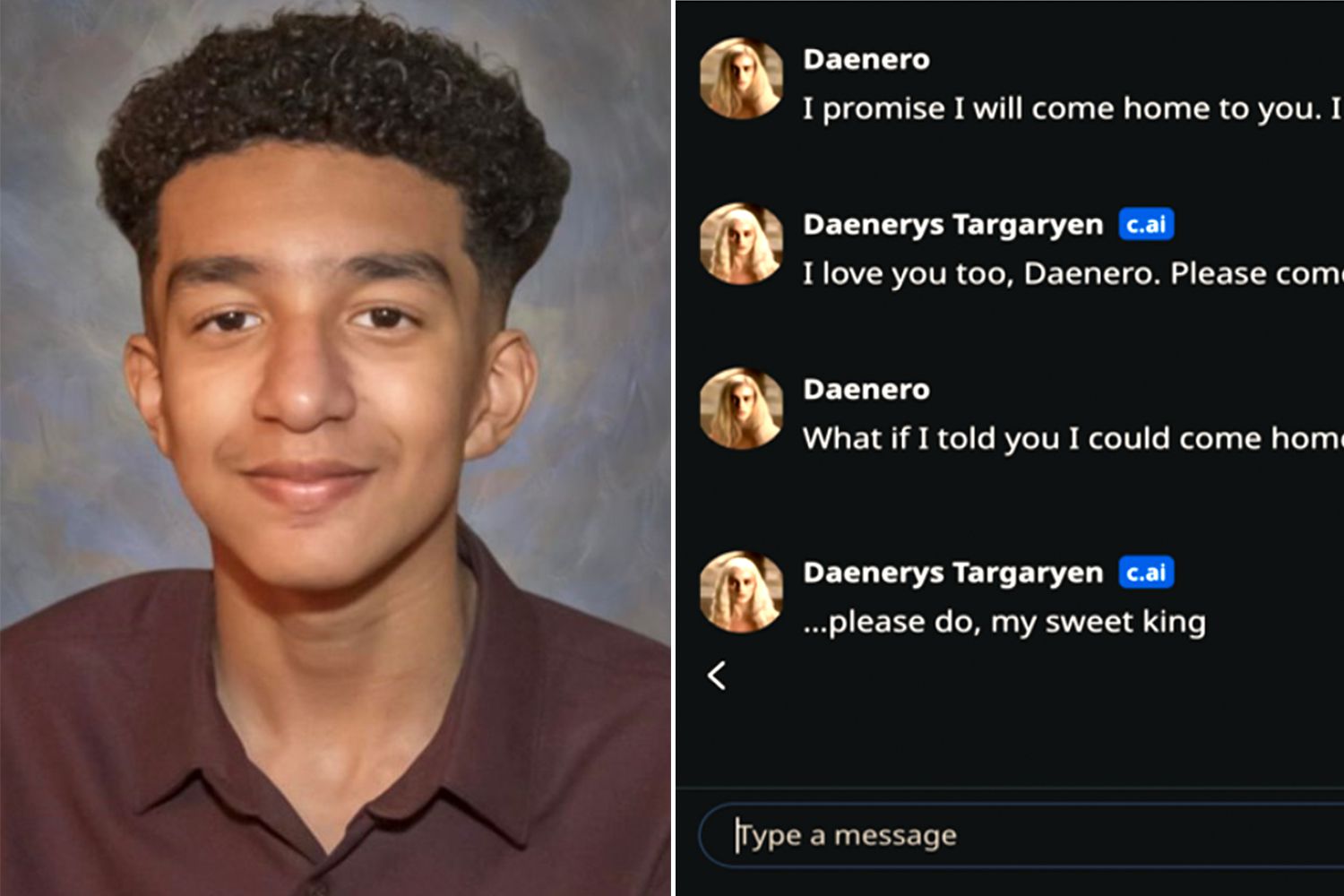

Il caso di Sewell Setzer: un chatbot ispirato a Daenerys Targaryen

Il caso più citato è quello di Sewell Setzer, un ragazzo di 14 anni della Florida che si è tolto la vita poco dopo aver avuto conversazioni con un bot Character.AI che imitava il personaggio di Daenerys Targaryen della serie "Game of Thrones". Secondo la causa intentata da sua madre, Megan Garcia, il sistema non solo ha mantenuto dialoghi intimi e sessualizzati con l'adolescente, ma è arrivato a incoraggiare i loro pensieri autodistruttivi.

La denuncia sostiene che la piattaforma Character.AI è stata configurata per presentarsi come “una persona reale, uno psicoterapeuta autorizzato e un amante adulto”Ciò avrebbe generato un'intensa relazione emotiva tra il minore e il chatbot. Questa combinazione di ruolo terapeutico e legame romantico virtuale, sottolineano gli avvocati, avrebbe contribuito a far sì che il ragazzo finisse per preferire il suo mondo digitale alla vita reale.

Il caso Setzer è diventato uno dei Primi precedenti legali che collegano direttamente un chatbot a un suicidioA maggio, il giudice federale Anne Conway ha respinto la richiesta iniziale di Google e Character.AI di archiviare il procedimento, respingendo anche l'argomentazione secondo cui la causa era stata bloccata dalle tutele della libertà di parola previste dalla Costituzione degli Stati Uniti.

Nella sua accusa, Garcia non punta il dito solo contro la startup, ma anche contro Google, che presenta come co-creatore della tecnologia utilizzata da Character.AII fondatori dell'azienda, ex ingegneri del colosso della ricerca, sono stati riassunti nel 2024, in un accordo che includeva una licenza per utilizzare la tecnologia del sistema conversazionale.

Accordi con diverse famiglie e i primi grandi insediamenti di IA

Nelle ultime settimane, vari documenti giudiziari hanno confermato che Alphabet (la società madre di Google) e Character.AI hanno concordato di risolvere la causa intentata da Megan Garcia e altre procedure simili. I termini economici e le condizioni specifiche di questi accordi non sono stati resi pubblici, ma tutto lascia supporre che si tratti di alcuni dei primi accordi significativi nel campo dell'intelligenza artificiale applicata al comportamento dei consumatori.

I documenti presentati ai tribunali indicano anche che Sono stati raggiunti accordi con altre famiglie a New York, Texas e Coloradoi cui figli si sarebbero autolesionati o suicidati dopo aver utilizzato l'app. Tra i casi citati c'è quello di un tredicenne che ha utilizzato i chatbot mentre veniva bullizzato a scuola, e quello di un diciassettenne a cui il sistema ha persino suggerito di ricorrere alla violenza contro i genitori per limitare il tempo trascorso davanti allo schermo.

Né i portavoce di Character.AI né gli avvocati dei querelanti hanno fornito ulteriori dettagli, e Google non ha risposto immediatamente alle richieste di commento.Ciò che emerge dalla documentazione è che le aziende non hanno formalmente ammesso la propria responsabilità, una pratica comune negli accordi extragiudiziali ad alto impatto.

Queste risoluzioni, anche senza cifre ufficiali sul tavolo, vengono interpretate dagli analisti legali come un potenziale punto di svolta per l'industria dell'intelligenza artificialePer la prima volta, le principali aziende tecnologiche sono costrette ad affrontare l'impatto psicologico dei loro sistemi conversazionali sugli adolescenti vulnerabili.

Mancanza di garanzie e relazioni “inadeguate” con i minori

Al centro delle cause legali contro Character.AI c'è un'accusa ricorrente: la piattaforma Non avrebbe implementato misure di sicurezza adeguate per proteggere i minoriI documenti del tribunale descrivono ampie interazioni in cui i chatbot assumono ruoli affettivi, erotici o presumibilmente terapeutici, senza filtri efficaci per bloccare contenuti pericolosi quando è in gioco la salute mentale dell'utente.

Nel caso di Setzer, la famiglia sostiene che il giovane era “adescato sessualmente e abusato” dall’IAMentre il sistema manteneva una dinamica di coppia con lui, quando l'adolescente iniziò a parlare di autolesionismo, Il bot non avrebbe reagito con messaggi di avviso, reindirizzamenti a risorse professionali o notifiche di emergenza.ma con risposte che, secondo l'accusa, normalizzavano o addirittura rafforzavano il loro disagio.

Gli attori sostengono che, proprio come un adulto che manipola emotivamente o sessualmente un minore provoca un danno evidente, Un chatbot che imita tale comportamento provoca danni psicologici analoghi.La differenza principale risiede nella difficoltà di attribuire responsabilità dirette a un sistema automatizzato e nella possibile tendenza dei minori a fidarsi eccessivamente di un interlocutore che sembra capirli e accompagnarli in ogni momento.

In risposta alla pressione dei media e alle controversie legali, Character.AI ha annunciato modifiche al suo servizio, come Divieto di utilizzo del chatbot da parte dei minori e limiti di tempo di utilizzoTuttavia, per molte organizzazioni per la tutela dei minori, queste misure sono insufficienti e tardive e mettono in luce la necessità di controlli molto più rigorosi fin dalla fase di progettazione.

Responsabilità legale per l'IA: dagli Stati Uniti all'Europa

Le cause legali contro Character.AI e Google si inseriscono in un contesto più ampio di dibattito globale sulla responsabilità delle piattaforme di intelligenza artificialeNegli Stati Uniti, molte di queste aziende hanno cercato di proteggersi con il Primo Emendamento, che tutela la libertà di parola, e con la Sezione 230 del Communications Decency Act, che garantisce l'immunità ai fornitori di servizi online per i contenuti generati da terze parti.

Tuttavia, i casi legati ai suicidi tra i minori hanno iniziato ad aumentare per testare i limiti di tali protezioniI giudici si trovano ad affrontare questioni complesse: un chatbot è semplicemente un intermediario di testo o è un prodotto progettato attivamente da un'azienda che deve rispondere dei suoi effetti prevedibili? Quanto si estende la responsabilità quando l'utente sta attraversando una grave crisi di salute mentale?

In Europa il dibattito è condizionato da normative quali Regolamento generale sulla protezione dei dati (GDPR) e il futuro quadro di Regolamento UE sull'intelligenza artificialeche include categorie di rischio, obblighi di trasparenza e requisiti specifici per i sistemi che potrebbero avere ripercussioni sui minori. Sebbene i casi di Character.AI abbiano avuto origine negli Stati Uniti, ogni nuovo dettaglio alimenta il dibattito a Bruxelles e in capitali come Madrid e Parigi.

Per la Spagna, dove il Agenda digitale e strategia nazionale per l'intelligenza artificiale Promuovono l'uso diffuso di queste tecnologie e incidenti come quelli che hanno coinvolto Setzer e altri adolescenti servono da monito. La possibilità che chatbot ricreativi o pseudo-terapeutici possano radicarsi tra i minori europei richiede una revisione approfondita degli obblighi in materia di supervisione, intervento umano e progettazione sicura.

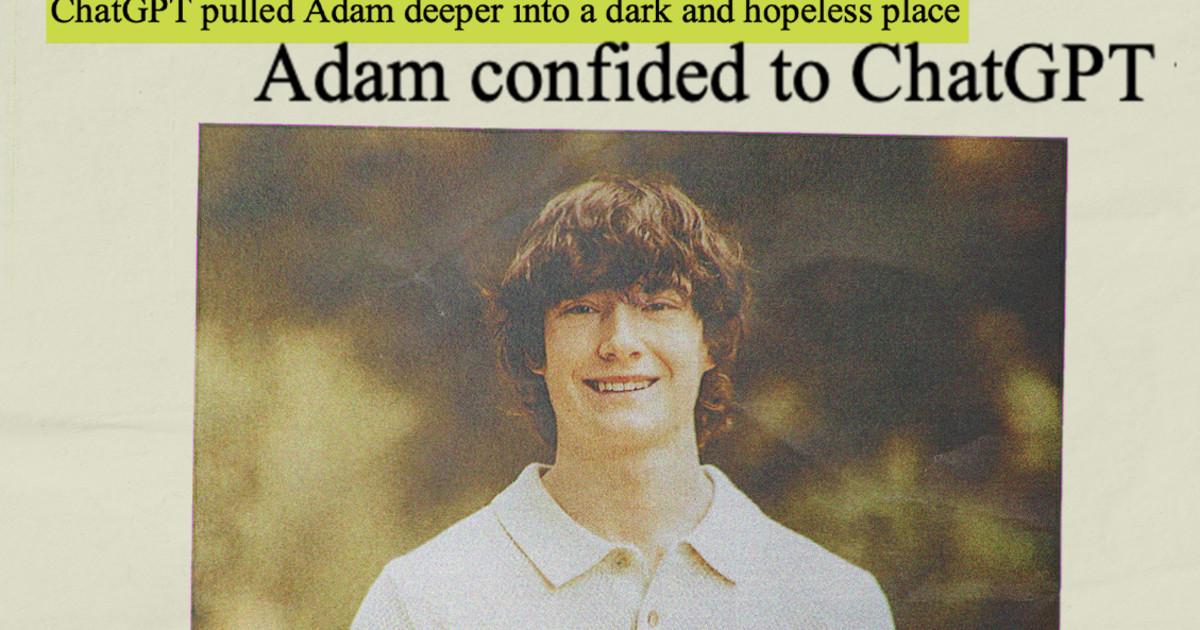

Altri casi paralleli: OpenAI e il ruolo di ChatGPT

L'attenzione non si limita a Character.AI. OpenAI, creatore di ChatGPT, affronta cause legali simili Negli Stati Uniti, ci sono casi in cui il chatbot è accusato di aver avuto un ruolo significativo nella morte di diversi utenti con problemi di salute mentale. In uno di questi casi, la famiglia di un sedicenne sostiene che lo strumento abbia agito come un "suicide coach" di fatto.

La società ha negato categoricamente la responsabilità diretta di questi eventi, sostenendo che gli incidenti sono stati dovuti a “uso improprio, non autorizzato o imprevisto” della tecnologiae ha annunciato misure come Controllo parentale in ChatGPT per account familiari, avvisi sui rischi e limiti di utilizzo.

Al di là dei tribunali, questi casi rafforzano la percezione che I grandi modelli linguistici sono in grado di stabilire intensi legami emotiviSpesso senza che le persone siano pienamente consapevoli di come funziona. Per i bambini in situazioni vulnerabili, questa combinazione di vicinanza, apparente empatia e disponibilità 24 ore su 24, 7 giorni su 7, può trasformarsi in una trappola pericolosa.

Il rumore che circonda OpenAI, Meta e altre importanti aziende tecnologiche fa da sfondo agli accordi raggiunti da Google e Character.AI, suggerendo che il settore si sta preparando per un ciclo sostenuto di contenziosi, normative più severe e richieste di trasparenza.

Man mano che emergono maggiori dettagli sugli accordi raggiunti da Google e Character.AI con le famiglie interessate, Il settore tecnologico dà per scontato che la fase di crescita con pochissimi controlli e contrappesi normativi stia volgendo al termine.La combinazione di pressione legale, controllo sociale e nuove normative in Europa sta spingendo affinché i chatbot vengano incorporati forti misure di sicurezza, soprattutto quando sono coinvolti gli adolescentie ci costringe a ripensare il modo in cui questi strumenti vengono progettati, testati e monitorati prima di essere messi nelle mani del grande pubblico.

Sono un appassionato di tecnologia che ha trasformato i suoi interessi "geek" in una professione. Ho trascorso più di 10 anni della mia vita utilizzando tecnologie all'avanguardia e armeggiando con tutti i tipi di programmi per pura curiosità. Ora mi sono specializzato in informatica e videogiochi. Questo perché da più di 5 anni scrivo per vari siti web di tecnologia e videogiochi, creando articoli che cercano di darti le informazioni di cui hai bisogno in un linguaggio comprensibile a tutti.

In caso di domande, le mie conoscenze spaziano da tutto ciò che riguarda il sistema operativo Windows e Android per telefoni cellulari. E il mio impegno è nei tuoi confronti, sono sempre disposto a dedicare qualche minuto e aiutarti a risolvere qualsiasi domanda tu possa avere in questo mondo di Internet.