- Cloudflare accusa Perplexity di aggirare robots.txt e di mascherare la sua scansione con user agent e indirizzi IP non dichiarati.

- L'azienda afferma di aver osservato modifiche ASN e milioni di richieste giornaliere su decine di migliaia di domini.

- Perplexity nega le pratiche nascoste, mette in discussione la metodologia e sostiene che la sua intelligenza artificiale funziona in modo diverso rispetto a un crawler tradizionale.

- Cloudflare rimuove Perplexity dall'elenco dei bot verificati e abilita regole per bloccare il tracciamento dell'IA per impostazione predefinita.

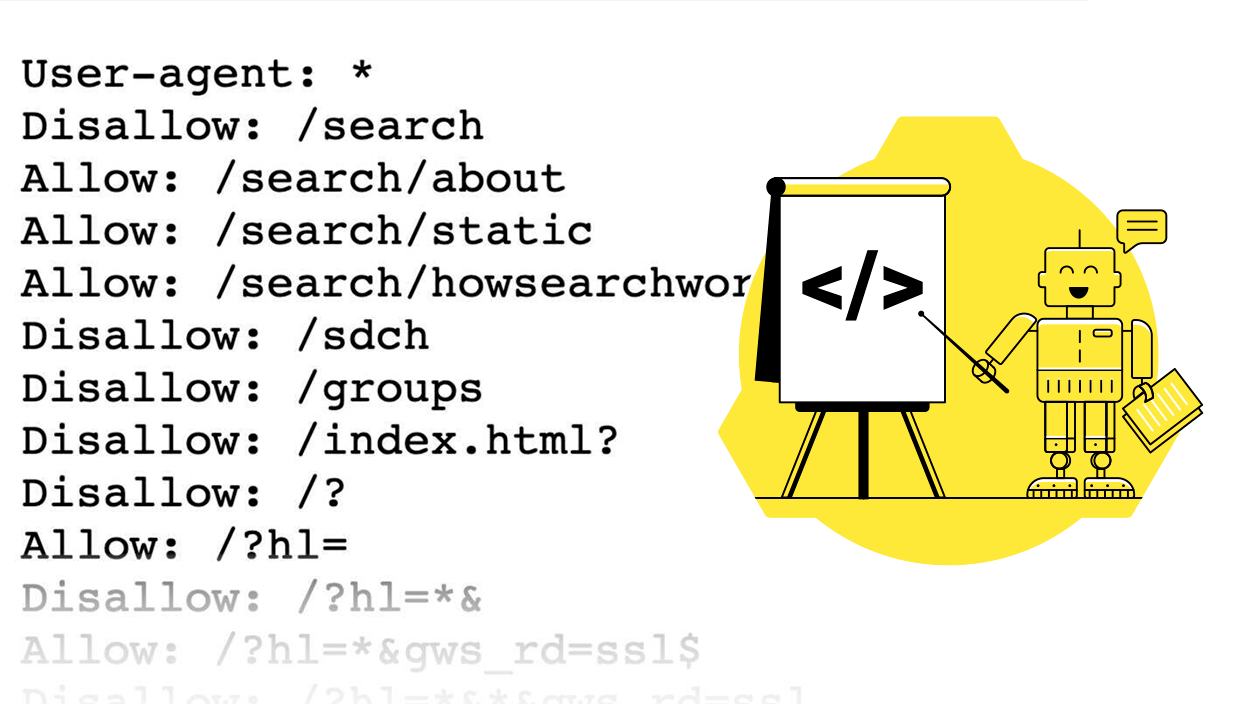

Cloudflare ha lanciato l'allarme pubblicando un rapporto in cui accusa il motore di risposta basato sull'intelligenza artificiale Perplexity di continuare a scansionare i siti web nonostante le barriere collocati dai loro proprietari. Secondo il fornitore dell'infrastruttura, il servizio avrebbe robots.txt ignorato e aggirare i blocchi di rete per accedere a contenuti vietati.

In un panorama in cui l’intelligenza artificiale divora i dati per addestrare modelli e rispondere in tempo reale, equilibrio tra innovazione e rispetto delle regole dell'ecosistema web sta diventando tesoLa polemica riaccende il dibattito sul scraping non autorizzato e i limiti tecnici ed etici che devono rispettare coloro che realizzano prodotti basati su grandi quantità di informazioni online.

Cosa segnala Cloudflare e perché è importante

L'azienda di sicurezza e prestazioni di rete afferma di aver ricevuto reclami dei clienti i cui siti hanno continuato a ricevere l'accesso attribuito a Perplexity nonostante vietarlo nel file robots.txt e applicare le regole del WAF per bloccare i tracker dichiarati. Dopo aver indagato, Cloudflare afferma di aver rilevato un modello di tracciamento segreto incompatibile con le preferenze dei proprietari dei siti web.

Il fornitore afferma di aver osservato questo comportamento in decine di migliaia di domini e con milioni di richieste al giorno, un volume che, a suo avviso, mostra pratiche sistematiche piuttosto che incidentali. Di conseguenza, ha rimosso Perplexity dal suo elenco di bot verificati e ha attivato euristiche e regole gestite per blocca questo tracciamento per impostazione predefinita.

Come la Perplessità avrebbe superato le barriere

Secondo Cloudflare, quando il tuo tracker dichiarati (come identificato dai nomi degli agenti utente Perplexity) ha riscontrato un arresto anomalo, il sistema sarebbe andato a impersonare un browser comune, presentandosi come se fosse Chrome su macOS per camuffare la loro identità e evitare il rilevamento.

Inoltre gli accessi provenivano da intervalli IP non pubblicati per Perplessità e ruotato frequentemente, il che avrebbe reso difficile il filtraggio. Cloudflare afferma inoltre di aver notato cambiamenti nel ASN (sistemi autonomi) provenienza delle richieste, altro segno di evasione dei blocchi rete.

La ricerca menziona che il comportamento osservato non rispetterebbe il modello dei buoni crawler descritti in RFC 9309 e nella sua politica sui “bot verificati”: trasparenza dell’identità (agente, IP e contatto), moderazione del traffico, un obiettivo chiaro e rispetta robots.txt già i limiti imposti dai proprietari dei siti.

Cloudflare afferma di essere riuscita a "lasciare un segno" a questo traffico attraverso una combinazione di segnali di rete e apprendimento automatico, aggiungendo firme alle regole gestite che identificano e bloccano questa attività, anche per i clienti del piano gratuito.

Test con domini esca e risultati

Per confermare i loro sospetti, il team ha creato domini nuovi e non pubblicati (non indicizzati o collegati pubblicamente) e hanno applicato loro una politica divieto totale di robots.txt, nonché regole specifiche per vietare i bot di Perplexity. Dopo aver consultato l'IA di quei siti, Cloudflare afferma che ho ottenuto risposte con dettagli sul contenuto ospitato, qualcosa che, se corretto, indicherebbe accesso nonostante le barriere.

Quando il blocco è diventato effettivo, Cloudflare ha osservato che l'intelligenza artificiale di Perplexity ricorso a fonti alternative per costruire una risposta, ma meno preciso e senza le particolarità del materiale originale, riflettendo che il la restrizione aveva funzionato.

La risposta ufficiale di Perplexity

La perplessità, da parte sua, Lui nega le accuse. di tracciamento nascosto e affermazioni secondo cui Cloudflare ha mal interpretato parte dell'attività analizzata. I portavoce dell'azienda hanno descritto il rapporto come un “pezzo commerciale” e sostengono che alcune prove non avrebbero testato gli accessi reali o addirittura corrispondono a i bot di altre persone.

La startup ha anche condiviso la sua posizione su pubblicazioni in X, dove mette in discussione la capacità del sistemi di rilevamento per distinguere tra assistenti AI legittimi, tracker di terze parti e traffico dannoso. Inoltre, sostiene che un agente che cerca informazioni tempestive per rispondere a una domanda non funziona allo stesso modo rispetto a un crawler tradizionale che esplora il web in massa.

Misure, buone pratiche e ruolo degli altri attori

Come parte della sua strategia, Cloudflare ha rimosso da Perplexity dal suo registro di bot affidabili e ha aggiunto regole per il blocco il suo presunto tracciamento nascosto. L'azienda raccomanda agli amministratori di attivare politiche anti-bot, fare domanda a sfide quando non si desidera un blocco totale e utilizzare regole gestite specifiche contro il Scraping dell'IA.

Nella sua argomentazione, Cloudflare contrappone il caso con esempi di conformità delle migliori pratiche, citando gli attori che rispetta robots.txt, documentare i propri agenti e adottare standard emergenti come Autenticazione Web BotNei test comparativi, afferma che altri bot si sono fermati quando si incontra un divieto o un blocco di rete, senza tentativi camuffati.

Un conflitto che segna il corso dell'ecosistema

Il fornitore prevede un evoluzione costante delle tattiche degli operatori di bot e delle difese utilizzate per contenerli. Parallelamente, partecipa al lavoro con esperti e organizzazioni come IETF per potenziare estensioni robots.txt e principi misurabili a cui i tracker ben intenzionati dovrebbero attenersi.

Al di là dell'impulso specifico, il caso mette sul tavolo il crisi di fiducia tra creatori di contenuti, piattaforme e aziende di intelligenza artificiale: chi può accedere a cosa, in quali condizioni e come renderlo trasparente senza rompere i modelli di business o rallentare l'innovazione. Tutto punta a questa conversazione rimarrà aperto mentre gli agenti di intelligenza artificiale acquisiscono importanza e il web modifica le sue regole di coesistenza.

Questo episodio lascia un messaggio chiaro: Il tracciamento dell'intelligenza artificiale è sotto esame, con Cloudflare che denuncia le tattiche di mimetizzazione attribuite a Perplexity e alla startup negandolo fermamente; al centro, i proprietari del sito hanno accesso a nuovi strumenti per controllare l'accesso e un insieme di buone pratiche in costruzione che segnerà il campo da gioco nei prossimi mesi.

Sono un appassionato di tecnologia che ha trasformato i suoi interessi "geek" in una professione. Ho trascorso più di 10 anni della mia vita utilizzando tecnologie all'avanguardia e armeggiando con tutti i tipi di programmi per pura curiosità. Ora mi sono specializzato in informatica e videogiochi. Questo perché da più di 5 anni scrivo per vari siti web di tecnologia e videogiochi, creando articoli che cercano di darti le informazioni di cui hai bisogno in un linguaggio comprensibile a tutti.

In caso di domande, le mie conoscenze spaziano da tutto ciò che riguarda il sistema operativo Windows e Android per telefoni cellulari. E il mio impegno è nei tuoi confronti, sono sempre disposto a dedicare qualche minuto e aiutarti a risolvere qualsiasi domanda tu possa avere in questo mondo di Internet.