- SAM 3 introduce la segmentazione di immagini e video guidata da esempi testuali e visivi, con un vocabolario di milioni di concetti.

- SAM 3D consente di ricostruire oggetti, scene e corpi umani in 3D a partire da un'unica immagine, utilizzando modelli aperti.

- In Segment Anything Playground è possibile testare i modelli senza conoscenze tecniche, grazie a modelli pratici e creativi.

- Meta rilascia pesi, checkpoint e nuovi benchmark in modo che gli sviluppatori e i ricercatori in Europa e nel resto del mondo possano integrare queste funzionalità nei loro progetti.

Meta ha compiuto un altro passo nel suo impegno per intelligenza artificiale applicata alla visione artificiale con il lancio di SAM 3 e SAM 3D, due modelli che ampliano la famiglia Segment Anything e che Il loro obiettivo è cambiare il modo in cui lavoriamo con foto e videoLungi dal rimanere un esperimento di laboratorio, l'azienda vuole che questi strumenti siano utilizzati sia dai professionisti sia dagli utenti senza competenze tecniche.

Con questa nuova generazione, Meta si concentra su migliorare il rilevamento e la segmentazione degli oggetti e nel portare il ricostruzione tridimensionale a un pubblico molto più ampioDal montaggio video alla visualizzazione dei prodotti per l'e-commerce in Spagna e nel resto d'Europa, l'azienda immagina uno scenario in cui È sufficiente descrivere a parole cosa si vuole fare perché l'intelligenza artificiale faccia la maggior parte del lavoro pesante..

Cosa offre SAM 3 rispetto alle versioni precedenti?

SAM 3 si posiziona come l'evoluzione diretta dei modelli di segmentazione presentati da Meta nel 2023 e nel 2024, noti come SAM 1 e SAM 2. Le prime versioni si concentravano sull'identificazione dei pixel appartenenti a ciascun oggetto, utilizzando principalmente segnali visivi come punti, riquadri o maschere e, nel caso di SAM 2, seguendo gli oggetti in un video quasi in tempo reale.

La novità chiave ora è che SAM 3 comprende testi ricchi e precisiNon solo etichette generiche. Mentre prima si utilizzavano termini semplici come "auto" o "autobus", il nuovo modello è in grado di rispondere a descrizioni molto più specifiche, ad esempio "scuolabus giallo" o "auto rossa in doppia fila".

In pratica, questo significa che è sufficiente scrivere qualcosa come "berretto da baseball rosso" in modo che il sistema possa individuare e separare tutti gli elementi che corrispondono a quella descrizione all'interno di un'immagine o di un video. Questa capacità di perfezionare con le parole è particolarmente utile in contesti di editing professionale, pubblicità o analisi dei contenuti, dove spesso è necessario esaminare dettagli molto specifici.

Inoltre, SAM 3 è stato progettato per integrarsi con grandi modelli linguistici multimodaliCiò consente di andare oltre le semplici frasi e di utilizzare istruzioni complesse come: “Persone sedute ma senza berretto rosso” o "pedoni che guardano la telecamera ma senza zaino". Questo tipo di istruzione combina condizioni ed esclusioni che fino a poco tempo fa erano difficili da tradurre in uno strumento di visione artificiale.

Prestazioni e scala del modello SAM 3

Meta ha voluto anche evidenziare la parte meno visibile ma cruciale: la prestazioni tecniche e scala di conoscenza del modello. Secondo i dati dell'azienda, SAM 3 è in grado di elaborare una singola immagine con più di cento oggetti rilevati in circa 30 millisecondi utilizzando una GPU H200, una velocità molto vicina a quella necessaria per flussi di lavoro impegnativi.

Nel caso del video, l'azienda assicura che il sistema mantenga le prestazioni praticamente in tempo reale quando si lavora con circa cinque oggetti contemporaneamente, il che lo rende adatto al monitoraggio e alla segmentazione di contenuti in movimento, da brevi clip per i social media a progetti di produzione più ambiziosi.

Per raggiungere questo comportamento, Meta ha costruito una base di addestramento con più di 4 milioni di concetti uniciCombinando annotatori umani con modelli di intelligenza artificiale per etichettare grandi volumi di dati, questa combinazione di supervisione manuale e automatizzata mira a bilanciare accuratezza e scalabilità, elementi essenziali per garantire che il modello risponda bene a diversi input nei contesti di mercato europei, latinoamericani e di altri paesi.

L'azienda inquadra SAM 3 in quello che chiama Raccolta di qualsiasi segmentoUna famiglia di modelli, benchmark e risorse progettati per ampliare la comprensione visiva dell'IA. Il lancio è accompagnato da un nuovo benchmark per la segmentazione del "vocabolario aperto", incentrato sulla misurazione della misura in cui il sistema è in grado di comprendere quasi tutti i concetti espressi in linguaggio naturale.

Integrazione con Edits, Vibes e altri strumenti Meta

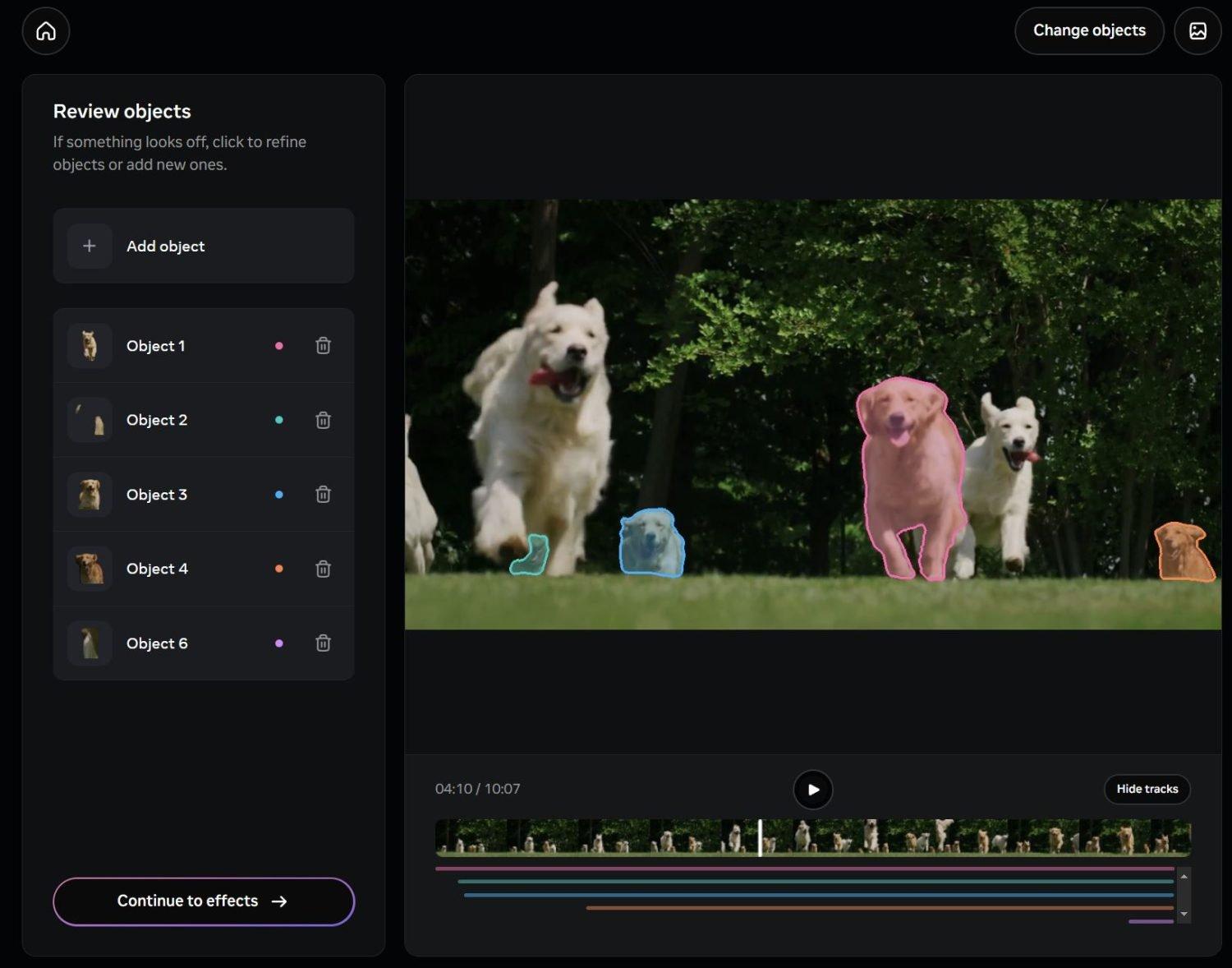

Oltre alla componente tecnica, Meta ha già iniziato a integrare SAM 3 in prodotti specifici destinati all'uso quotidiano. Una delle prime destinazioni sarà Edits, la loro applicazione per la creazione e la modifica di video, in cui l'idea è che l'utente possa selezionare persone o oggetti specifici con una semplice descrizione testuale e applicare effetti, filtri o modifiche solo a quelle parti del filmato.

Un'altra via per l'integrazione sarà trovata in Vibes, all'interno dell'app Meta AI e della piattaforma meta.aiIn questo contesto, la segmentazione del testo verrà combinata con strumenti generativi per creare nuove esperienze di editing e creative, come sfondi personalizzati, effetti di movimento o modifiche fotografiche selettive pensate per i social network, molto popolari in Spagna e nel resto d'Europa.

La proposta dell'azienda è che queste capacità non siano limitate agli studi professionali, ma raggiungano... creatori indipendenti, piccole agenzie e utenti avanzati che lavorano quotidianamente con contenuti visivi. La possibilità di segmentare le scene scrivendo descrizioni in linguaggio naturale riduce la curva di apprendimento rispetto agli strumenti tradizionali basati su maschere e livelli manuali.

Allo stesso tempo, Meta mantiene un approccio aperto verso gli sviluppatori esterni, suggerendo che applicazioni di terze parti -dagli strumenti di editing alle soluzioni per l'analisi video nel settore della vendita al dettaglio o della sicurezza- possono fare affidamento su SAM 3 a condizione che vengano rispettate le policy di utilizzo dell'azienda.

SAM 3D: Ricostruzione tridimensionale da una singola immagine

L'altra grande novità è SAM 3Dun sistema progettato per eseguire ricostruzioni tridimensionali Partendo da immagini 2D. Invece di dover acquisire più immagini da diverse angolazioni, il modello mira a generare una rappresentazione 3D affidabile da una singola foto, un aspetto particolarmente interessante per chi non dispone di attrezzature di scansione o flussi di lavoro specializzati.

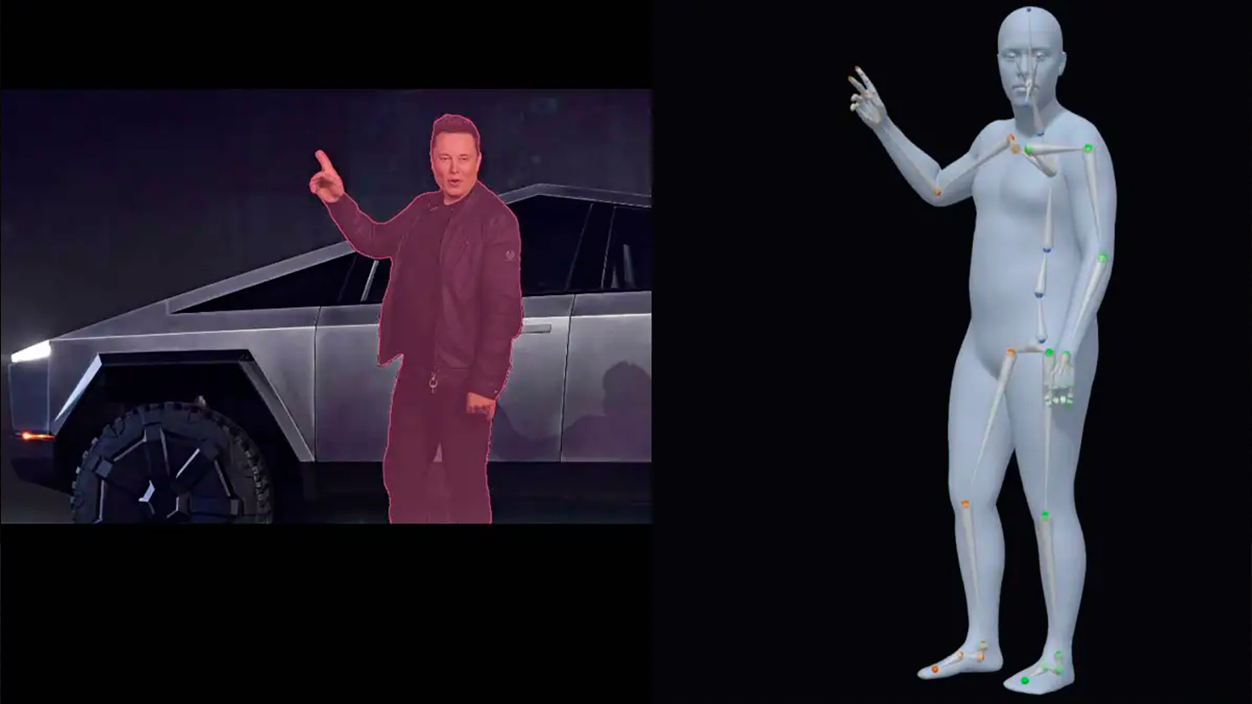

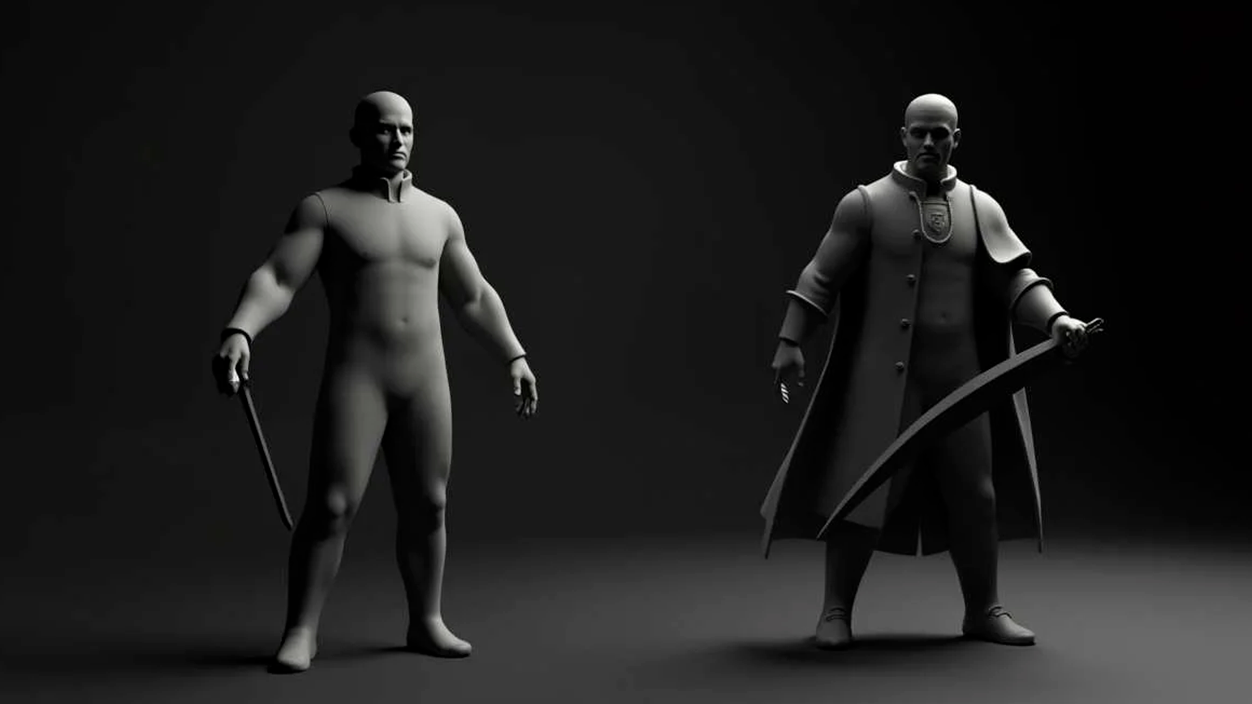

SAM 3D è costituito da due modelli open source con funzioni distinte: Oggetti SAM 3Dfocalizzato sulla ricostruzione di oggetti e scene, e Corpo SAM 3D, orientato alla stima della forma e del corpo umano. Questa separazione consente al sistema di essere adattato a casi d'uso molto diversi, dai cataloghi di prodotti alle applicazioni sanitarie o sportive.

Secondo Meta, SAM 3D Objects segna un Nuovo benchmark delle prestazioni nella ricostruzione 3D guidata dall'intelligenza artificialesuperando facilmente i metodi precedenti in parametri qualitativi chiave. Per valutare i risultati in modo più rigoroso, l'azienda ha collaborato con artisti per creare SAM 3D Artist Objects, un set di dati specificamente progettato per valutare la fedeltà e il dettaglio delle ricostruzioni di un'ampia varietà di immagini e oggetti.

Questo progresso apre le porte ad applicazioni pratiche in settori quali robotica, scienza, medicina sportiva o creatività digitaleAd esempio, nella robotica può aiutare i sistemi a comprendere meglio il volume degli oggetti con cui interagiscono; nella ricerca medica o sportiva, potrebbe aiutare ad analizzare la postura e il movimento del corpo; e nella progettazione creativa, funge da base per generare modelli 3D per animazioni, videogiochi o esperienze immersive.

Una delle prime applicazioni commerciali già visibili è la funzione "Vista dalla stanza" de Mercato di Facebookche consente di visualizzare come apparirebbe un mobile o un oggetto decorativo in una stanza reale prima di acquistarlo. Con SAM 3D, Meta cerca di perfezionare questo tipo di esperienze, di grande rilevanza per l'e-commerce europeo, dove la restituzione dei prodotti a causa di aspettative non soddisfatte rappresenta un costo crescente.

Segment Anything Playground: un ambiente per sperimentare

Per consentire al pubblico di testare queste funzionalità senza installare nulla, Meta ha abilitato Segmenta qualsiasi cosa PlaygroundÈ una piattaforma web che consente di caricare immagini o video e sperimentare SAM 3 e SAM 3D direttamente dal browser. L'idea è che chiunque sia interessato all'intelligenza artificiale visiva possa esplorare le potenzialità di SAM 3 e SAM 3D senza alcuna conoscenza di programmazione.

Nel caso di SAM 3, Playground consente di segmentare gli oggetti utilizzando frasi brevi o istruzioni dettagliateCombinando testo e, se desiderato, esempi visivi, si semplificano le attività più comuni, come la selezione di persone, auto, animali o elementi specifici della scena e l'applicazione di azioni specifiche, dagli effetti estetici alla sfocatura o alla sostituzione dello sfondo.

Quando si lavora con SAM 3D, la piattaforma rende possibile Esplora scene da nuove prospettiveRiorganizzare gli oggetti, applicare effetti tridimensionali o generare viste alternative. Per chi lavora nel design, nella pubblicità o nei contenuti 3D, offre un modo rapido per prototipare idee senza dover utilizzare fin dall'inizio strumenti tecnici complessi.

Il Playground comprende anche una serie di Modelli pronti all'uso Queste funzionalità sono pensate per scopi molto specifici. Includono opzioni pratiche come la pixelizzazione di volti o targhe per motivi di privacy, ed effetti visivi come scie di movimento, evidenziazioni selettive o riflettori su aree di interesse nel video. Queste tipologie di funzioni possono essere particolarmente adatte ai flussi di lavoro dei creatori di contenuti e media digitali in Spagna, dove la produzione di brevi video e contenuti per i social media è costante.

Risorse aperte per sviluppatori e ricercatori

In linea con la strategia seguita da Meta in altre versioni di intelligenza artificiale, l'azienda ha deciso di rilasciare una parte significativa del risorse tecniche associate a SAM 3 e SAM 3DPer prima cosa, sono stati resi pubblici i pesi del modello, un nuovo benchmark incentrato sulla segmentazione del vocabolario aperto e un documento tecnico che ne descrive in dettaglio lo sviluppo.

Nel caso di SAM 3D, sono disponibili: punti di controllo del modello, codice di inferenza e un set di dati di valutazione di nuova generazione. Questo set di dati include una notevole varietà di immagini e oggetti che mirano ad andare oltre i tradizionali punti di riferimento 3D, offrendo maggiore realismo e complessità, un aspetto che può essere molto utile per i gruppi di ricerca europei che lavorano nel campo della visione artificiale e della grafica.

Meta ha anche annunciato collaborazioni con piattaforme di annotazione come Roboflow, con l'obiettivo di consentire agli sviluppatori e alle aziende di Inserisci i tuoi dati e modifica SAM 3 in base a esigenze specifiche. Ciò apre le porte a soluzioni specifiche per settore, dall'ispezione industriale all'analisi del traffico urbano, compresi i progetti di beni culturali in cui è importante segmentare accuratamente elementi architettonici o artistici.

Optando per un approccio relativamente aperto, l'azienda cerca di garantire che l'ecosistema degli sviluppatori, università e startup -compresi quelli che operano in Spagna e nel resto d'Europa- possono sperimentare queste tecnologie, integrarle nei propri prodotti e, in ultima analisi, contribuire con casi d'uso che vanno oltre quelli che Meta può sviluppare internamente.

Con SAM 3 e SAM 3D, Meta punta a consolidare un piattaforma di intelligenza artificiale visiva più flessibile e accessibiledove la segmentazione guidata dal testo e la ricostruzione 3D a partire da una singola immagine non sono più funzionalità riservate a team altamente specializzati. Il potenziale impatto si estende dall'editing video quotidiano ad applicazioni avanzate in ambito scientifico, industriale ed e-commerce, in un contesto in cui la combinazione di linguaggio, visione artificiale e creatività sta diventando uno strumento di lavoro standard e non solo una promessa tecnologica.

Sono un appassionato di tecnologia che ha trasformato i suoi interessi "geek" in una professione. Ho trascorso più di 10 anni della mia vita utilizzando tecnologie all'avanguardia e armeggiando con tutti i tipi di programmi per pura curiosità. Ora mi sono specializzato in informatica e videogiochi. Questo perché da più di 5 anni scrivo per vari siti web di tecnologia e videogiochi, creando articoli che cercano di darti le informazioni di cui hai bisogno in un linguaggio comprensibile a tutti.

In caso di domande, le mie conoscenze spaziano da tutto ciò che riguarda il sistema operativo Windows e Android per telefoni cellulari. E il mio impegno è nei tuoi confronti, sono sempre disposto a dedicare qualche minuto e aiutarti a risolvere qualsiasi domanda tu possa avere in questo mondo di Internet.