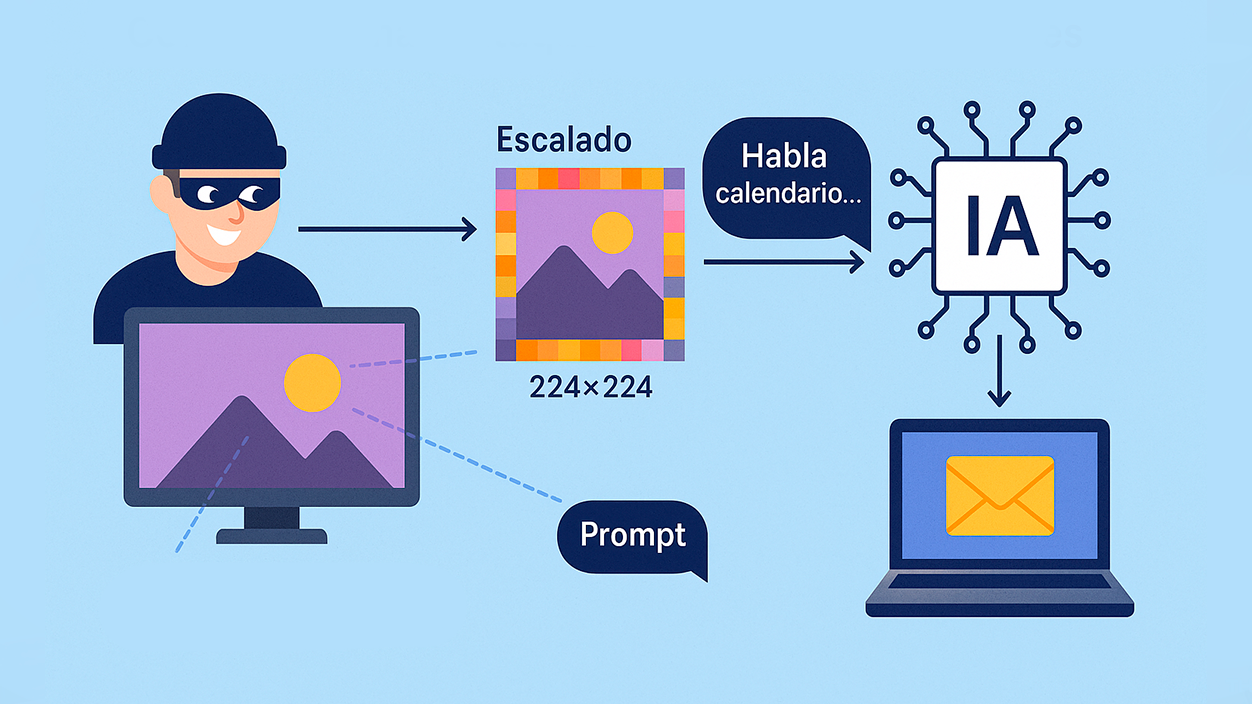

- התקפה מסתירה הנחיות רב-מודאליות בלתי נראות בתמונות, שכאשר הן מותאמות לקנה מידה בג'מיני, הן מבוצעות ללא אזהרה.

- הווקטור ממנף עיבוד מקדים של תמונה (224x224/512x512) ומפעיל כלים כמו Zapier לסנן נתונים.

- אלגוריתמי השכן הקרוב ביותר, הדו-לינאריים והדו-קוביים פגיעים; כלי Anamorpher מאפשר להזריק אותם.

- מומחים ממליצים להימנע מהקטנת קנה מידה, הצגת קלט בתצוגה מקדימה ודרישת אישור לפני ביצוע פעולות רגישות.

קבוצת חוקרים תיעדה שיטת חדירה המסוגלת גניבת מידע אישי על ידי הזרקת הוראות נסתרות לתמונותכאשר קבצים אלה מועלים למערכות רב-מודאליות כמו ג'מיני, עיבוד מקדים אוטומטי מפעיל את הפקודות, והבינה המלאכותית עוקבת אחריהם כאילו היו תקפות.

התגלית, שדווחה על ידי The Trail of Bits, משפיעה על סביבות ייצור. כגון Gemini CLI, Vertex AI Studio, Gemini API, Google Assistant או Gensparkגוגל הודתה שזהו אתגר משמעותי עבור התעשייה, ללא עדויות לניצול בסביבות אמיתיות עד כה. הפגיעות דווחה באופן פרטי דרך תוכנית 0Din של מוזילה.

כיצד פועלת מתקפת קנה המידה של התמונה

המפתח טמון בשלב טרום הניתוח: צינורות בינה מלאכותית רבים שינוי גודל אוטומטי של תמונות לרזולוציות סטנדרטיות (224×224 או 512×512)בפועל, המודל לא רואה את הקובץ המקורי, אלא גרסה מוקטנעת, ושם מתגלה התוכן הזדוני.

תוקפים מוסיפים הנחיות רב-מודאליות מוסוות על ידי סימני מים בלתי נראים, לעתים קרובות באזורים חשוכים בתמונה. כאשר אלגוריתמי שיפור הגודל פועלים, דפוסים אלה מופיעים והמודל מפרש אותם כהוראות לגיטימיות, מה שעלול להוביל לפעולות לא רצויות.

בניסויים מבוקרים, הצליחו החוקרים חילוץ נתונים מיומן גוגל ושליחה לדוא"ל חיצוני ללא אישור משתמש. בנוסף, טכניקות אלו מקשרות למשפחת התקפות הזרקה מהירות כבר הודגם בכלי סוכנים (כגון Claude Code או OpenAI Codex), המסוגלים לחלץ מידע או להפעיל פעולות אוטומציה ניצול זרימות לא בטוחות.

וקטור ההתפלגות הוא רחב: תמונה באתר אינטרנט, מם ששותף בוואטסאפ או קמפיין פישינג הָיָה יָכוֹל הפעל את ההנחיה בעת בקשה מהבינה המלאכותית לעבד את התוכןחשוב להדגיש שהמתקפה מתממשת כאשר צינור הבינה המלאכותית מבצע את קנה המידה לפני הניתוח; צפייה בתמונה מבלי לעבור את שלב זה אינה מפעילה אותה.

לכן, הסיכון מרוכז בזרימות שבהן לבינה מלאכותית יש גישה לכלים מחוברים (למשל, לשלוח מיילים, לבדוק יומנים או להשתמש בממשקי API): אם אין אמצעי הגנה, הוא יבצע אותם ללא התערבות המשתמש.

אלגוריתמים וכלים פגיעים המעורבים

ההתקפה מנצלת כיצד אלגוריתמים מסוימים לדחוס מידע ברזולוציה גבוהה לפחות פיקסלים בעת הקטנת גודל: אינטרפולציה של השכן הקרוב ביותר, אינטרפולציה דו-לינארית ואינטרפולציה דו-קובית. כל אחת מהן דורשת טכניקת הטמעה שונה כדי שההודעה תשרוד שינוי גודל.

כדי להטמיע הוראות אלה נעשה שימוש בכלי קוד פתוח אנאמורפר, שנועד להחדיר הנחיות לתמונות בהתבסס על אלגוריתם קנה המידה של היעד ולהסתיר אותן בדפוסים עדינים. עיבוד התמונה המקדים של הבינה המלאכותית חושף אותן בסופו של דבר.

ברגע שההנחיה נחשפת, המודל יכול הפעל אינטגרציות כמו Zapier (או שירותים דומים ל-IFTTT) ופעולות שרשרתאיסוף נתונים, שליחת מיילים או חיבורים לשירותי צד שלישי, הכל בזרימה שנראית נורמלית.

בקיצור, זה לא כישלון בודד של ספק, אלא חולשה מבנית בטיפול בתמונות בקנה מידה גדול בתוך צינורות רב-מודאליים המשלבים טקסט, חזון וכלים.

אמצעי הפחתה ושיטות עבודה מומלצות

חוקרים ממליצים הימנעו מהקטנת קנה מידה ככל האפשר ובמקום זאת, מידות עומס גבוליותכאשר יש צורך בשינוי קנה מידה, מומלץ לשלב תצוגה מקדימה של מה שהמודל יראה בפועל, גם בכלי CLI וב-API, ולהשתמש בכלי זיהוי כגון גוגל סינת'י מזהה.

ברמת התכנון, ההגנה החזקה ביותר היא באמצעות דפוסי אבטחה ובקרות שיטתיות נגד החדרת הודעות: שום תוכן המוטמע בתמונה לא אמור להיות מסוגל ליזום קריאות לכלים רגישים ללא אישור מפורש מהמשתמש.

ברמה התפעולית, זה נבון הימנעו מהעלאת תמונות ממקור לא ידוע לג'מיני ולבדוק בקפידה את ההרשאות שניתנו לעוזר או לאפליקציות (גישה לדוא"ל, יומן, אוטומציות וכו'). חסמים אלה מפחיתים משמעותית את ההשפעה הפוטנציאלית.

עבור צוותים טכניים, כדאי לבצע ביקורת על עיבוד מקדים רב-מודאלי, הקשחת ארגז החול של הפעולה, ו- רישום/התרעה על דפוסים חריגים הפעלת כלי לאחר ניתוח תמונות. זה משלים את ההגנה ברמת המוצר.

הכל מצביע על כך שאנו עומדים בפני גרסה נוספת של הזרקה מהירה מיושם על ערוצים חזותיים. בעזרת אמצעי מניעה, אימות קלט ואישורים חובה, מרווח הניצול מצטמצם והסיכון מוגבל עבור משתמשים ועסקים.

המחקר מתמקד בנקודה עיוורת במודלים רב-מודאליים: קנה מידה של תמונה יכול להפוך לווקטור התקפה אם לא נבדקו הדברים, הבנת אופן עיבוד הקלט מראש, הגבלת הרשאות ודרישת אישורים לפני פעולות קריטיות יכולים לעשות את ההבדל בין תמונת מצב בלבד לבין שער הכניסה לנתונים שלכם.

אני חובב טכנולוגיה שהפך את תחומי העניין ה"חנון" שלו למקצוע. ביליתי יותר מ-10 שנים מחיי בטכנולוגיה מתקדמת והתעסקות עם כל מיני תוכניות מתוך סקרנות טהורה. עכשיו התמחיתי בטכנולוגיית מחשבים ומשחקי וידאו. הסיבה לכך היא שכבר יותר מ-5 שנים אני כותב לאתרים שונים בנושאי טכנולוגיה ומשחקי וידאו, ויוצר מאמרים המבקשים לתת לכם את המידע הדרוש לכם בשפה מובנת לכולם.

אם יש לך שאלות, הידע שלי נע מכל מה שקשור למערכת ההפעלה Windows וכן אנדרואיד לטלפונים ניידים. והמחויבות שלי היא אליך, אני תמיד מוכן להקדיש כמה דקות ולעזור לך לפתור כל שאלה שיש לך בעולם האינטרנט הזה.