- MusicGen の 100% ローカル実行: プライバシー、制御、速度。

- Python、PyTorch、FFmpeg、Audiocraft で準備された環境。

- 適切なモデル サイズと GPU を選択してパフォーマンスを最適化します。

- クラウド ストレージに依存せずにクリエイティブ ワークフローを完了します。

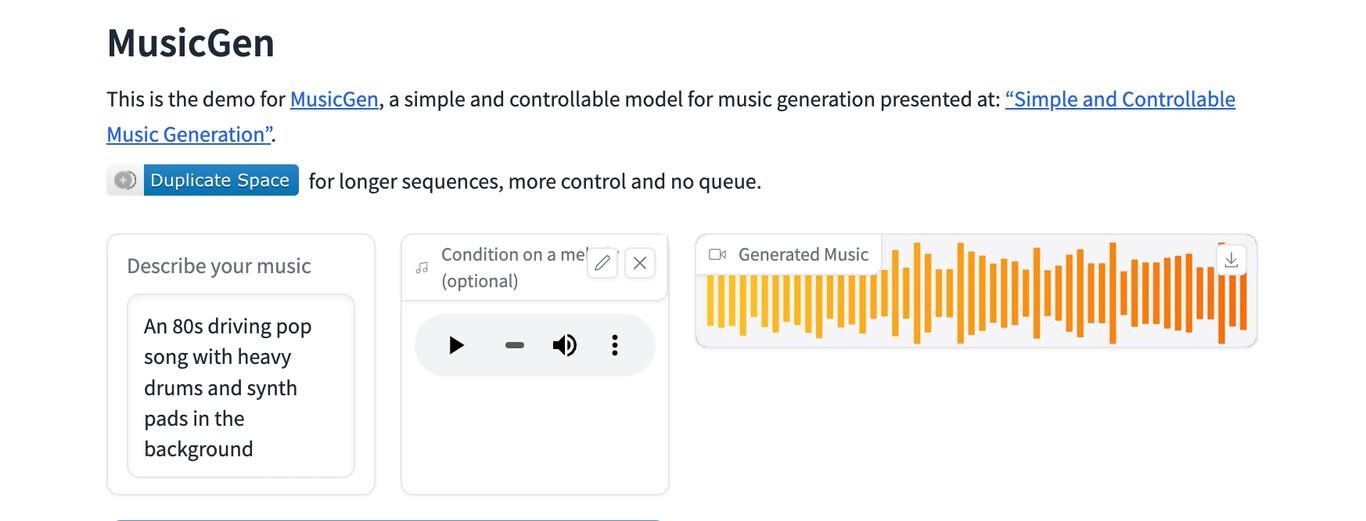

¿Meta の MusicGen をローカルで使用するにはどうすればいいですか? 今日では、外部サービスに頼らずに人工知能で音楽を生成することは完全に可能です。 MetaのMusicGenは完全にコンピュータ上で実行できますサンプルや結果をクラウドにアップロードせず、常にデータの管理を維持してください。このガイドでは、実用的な推奨事項、パフォーマンスに関する考慮事項、そして大きな違いをもたらすヒントを交えながら、プロセスを段階的に説明します。

ローカルで作業する利点の 1 つは、クォータ制限がなく、サーバーが過負荷になるのを待たずに、プライバシーを高めながら自由に実験できることです。 モバイルアプリ向けに設計されたストレージや認証SDKなどのクラウドソリューションとは異なりここでは、オーディオをサードパーティに委託する必要はありません。モデル、プロンプト、生成されたトラックはあなたの手元に残ります。

MusicGen とは何ですか? また、なぜローカルで実行するのですか?

MusicGen は、Meta によって開発された音楽生成モデルであり、テキストの説明から楽曲を作成することができ、いくつかのバリエーションでは、参照メロディーを使用して結果を調整することができます。 彼らの提案は、使いやすさと驚くべき音楽品質を兼ね備えています忠実度とシステム リソースの消費のバランスをとるために、さまざまなモデル サイズを提供します。

コンピュータをローカルで実行することには、いくつかの重要な意味合いがあります。まず、 プライバシーあなたの声、サンプル、そして作曲は、あなたのマシンから外に出る必要はありません。第二に、 反復速度ファイルのアップロードやリモートバックエンドに帯域幅を依存しません。そして最後に、 技術的制御ライブラリのバージョンを修正したり、重みを固定したり、API の変更による予期せぬ事態を避けながらオフラインで作業したりできます。

クラウドストレージソリューションとの違いを理解することが重要です。例えば、モバイルエコシステムでは、 Firebase を使用すると、iOS やその他のプラットフォーム開発者は、オーディオ、画像、ビデオを簡単に保存できます。 堅牢なSDK、組み込み認証、そしてテキストデータ用のRealtime Databaseとの自然な連携により、このアプローチは同期、共同作業、迅速な公開が必要な場合に最適です。しかし 外部サーバーに何もアップロードしないことを優先する場合自分のコンピュータで MusicGen を実行すると、その手順は完全に回避されます。

コミュニティもあなたの味方です。r/StableDiffusionのようなオープンで非公式なスペースでは、生成モデルに基づいた最先端のクリエイティブツールが共有され、議論されています。 記事を公開したり、質問に答えたり、議論を開始したり、テクノロジーを提供したり、探索したりする場所です。 音楽シーンで起こっていることすべて。オープンソースで探究的な文化は、MusicGenをローカルで使うことにぴったりです。テスト、反復、記録、そして後続のアーティストのサポート。ペースとアプローチは自分で決められます。

研究中に、音楽の流れとは関係のない技術的な断片に遭遇した場合、例えば、 スコープ付きCSSスタイルブロックまたはフロントエンドスニペット— これらはサウンド生成には関係ありませんが、リソースコレクションのページに表示されることがあります。実際のオーディオ依存関係と、システムで実際に必要なバイナリに注目すると役立ちます。

興味深いことに、一部のリソース リストには、大学の Web サイトでホストされている PDF 形式の学術資料やプロジェクト提案への参照が含まれています。 インスピレーションを得るには興味深いかもしれないがMusicGen をローカルで実行するには、Python 環境、オーディオ ライブラリ、モデルの重みが必要です。

環境の要件と準備

最初のノートを生成する前に、お使いのコンピュータが最小要件を満たしていることを確認してください。CPUでも動作可能ですが、GPUを使用すると、はるかに優れたエクスペリエンスが得られます。 CUDAまたはMetalをサポートし、少なくとも6~8 GBのVRAMを搭載したグラフィックカード より大きなモデルと合理的な推論時間の使用が可能になります。

互換性のあるオペレーティング システム: Windows 10/11、macOS (優れたパフォーマンスを得るには Apple Silicon が推奨)、一般的な Linux ディストリビューション。 Python 3.9~3.11が必要です環境マネージャ(Conda または venv)と、オーディオのエンコード/デコード用の FFmpeg が必要です。NVIDIA GPU の場合は適切な CUDA を搭載した PyTorch を、Apple Silicon を搭載した macOS の場合は MPS ビルドを、Linux の場合はお使いのドライバーに対応したものをインストールしてください。

MusicGen モデルの重みは、対応するライブラリ (Meta の Audiocraft など) から最初に呼び出したときにダウンロードされます。 オフラインで操作したい場合事前にダウンロードし、プログラムがインターネットにアクセスしないようにローカルパスを設定してください。これは、閉鎖された環境で作業する場合に非常に重要です。

ストレージに関して:Firebase Storageのようなツールは、強力な認証とSDKを使用してクラウドにファイルを保存および取得するように設計されていますが、 私たちの目標は、これらのサービスに依存しないことですWAV/MP3 ファイルをローカル フォルダーに保存し、バイナリの変更追跡が必要な場合は Git LFS バージョン コントロールを使用します。

最後に、オーディオ I/O を準備します。 FFmpegは必須 標準フォーマットへの変換、およびリファレンスサンプルのクリーニングやトリミングを行うには、ffmpeg が PATH に存在し、コンソールから呼び出せることを確認してください。

隔離された環境でのステップバイステップのインストール

Conda を使用して Windows、macOS、Linux と互換性のあるワークフローを提案します。 venv を使用する場合は、コマンドを調整してください。 環境マネージャーに応じて異なります。

# 1) Crear y activar entorno

conda create -n musicgen python=3.10 -y

conda activate musicgen

# 2) Instalar PyTorch (elige tu variante)

# NVIDIA CUDA 12.x

pip install --upgrade pip

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

# CPU puro (si no tienes GPU)

# pip install torch torchvision torchaudio

# Apple Silicon (MPS)

# pip install torch torchvision torchaudio

# 3) FFmpeg

# Windows (choco) -> choco install ffmpeg

# macOS (brew) -> brew install ffmpeg

# Linux (apt) -> sudo apt-get install -y ffmpeg

# 4) Audiocraft (incluye MusicGen)

pip install git+https://github.com/facebookresearch/audiocraft

# 5) Opcional: manejo de audio y utilidades extra

pip install soundfile librosa numpy scipy環境で Git からのインストールが許可されていない場合は、リポジトリを複製して編集可能なインストールを作成できます。 この方法により、特定のコミットを簡単に設定できます 再現性のため。

git clone https://github.com/facebookresearch/audiocraft.git

cd audiocraft

pip install -e .CLIですべてが機能することをテストする

インストールを検証する簡単な方法は、Audiocraft に含まれているコマンドライン デモを起動することです。 これにより、重みがダウンロードされ、推論プロセスが開始されていることが確認されます。 CPU/GPU で正しく動作していることを確認します。

python -m audiocraft.demo.cli --help

# Generar 10 segundos de música con un prompt simple

python -m audiocraft.demo.cli \

--text 'guitarra acústica relajada con ritmo suave' \

--duration 10 \

--model musicgen-small \

--output ./salidas/clip_relajado.wav最初の実行ではモデルをダウンロードするため、時間がかかる場合があります。 発信接続をしたくない場合はまず、チェックポイントをダウンロードし、環境で使用されているキャッシュ ディレクトリ (たとえば、~/.cache/torch または Audiocraft によって指定されたディレクトリ) に配置し、ネットワークを無効にします。

Pythonの使用:微調整

より高度なワークフローの場合は、Python から MusicGen を呼び出します。 これにより、シード、候補の数、温度を設定できます。 参照メロディーによって条件付けられたトラックを操作します。

from audiocraft.models import MusicGen

from audiocraft.data.audio import audio_write

import torch

# Elige el tamaño: 'small', 'medium', 'large' o 'melody'

model = MusicGen.get_pretrained('facebook/musicgen-small')

model.set_generation_params(duration=12, top_k=250, top_p=0.98, temperature=1.0)

prompts = [

'sintetizadores cálidos, tempo medio, ambiente cinematográfico',

'batería electrónica con bajo contundente, estilo synthwave'

]

with torch.no_grad():

wav = model.generate(prompts) # [batch, channels, samples]

for i, audio in enumerate(wav):

audio_write(f'./salidas/track_{i}', audio.cpu(), model.sample_rate, format='wav')メロディーで条件付けをしたい場合は、メロディータイプのモデルを使用し、参照クリップを渡します。 このモードは旋律の輪郭を尊重する プロンプトに応じてスタイルを再解釈します。

from audiocraft.models import MusicGen

from audiocraft.data.audio import load_audio, audio_write

model = MusicGen.get_pretrained('facebook/musicgen-melody')

model.set_generation_params(duration=8)

melody, sr = load_audio('./refs/melodia.wav', sr=model.sample_rate)

prompts = ['árpegios brillantes con pads espaciales']

wav = model.generate_with_chroma(prompts, melody[None, ...])

audio_write('./salidas/con_melodia', wav[0].cpu(), model.sample_rate, format='wav')オフラインでの作業とモデルの管理

100% ローカル ワークフローの場合は、チェックポイントをダウンロードし、Audiocraft がチェックポイントを見つけられるように環境変数またはルートを構成します。 バージョンと重量の目録を保持する 再現性を確保するため、またネットワークを無効にした場合に誤ってダウンロードされるのを防ぐためです。

- VRAM に応じてモデル サイズを選択します。小さいほど消費量が少なくなり、応答が速くなります。

- 重みのバックアップ コピーをローカル ディスクまたは外部ディスクに保存します。

- 使用した Audiocraft コミットと PyTorch ビルドを文書化します。

複数のマシンを使用する場合は、ライブラリとウェイトを使用して内部ミラーを作成できます。 常にローカルネットワーク上にあり、インターネットに何も公開されない厳格なポリシーを持つ制作チームにとって実用的です。

プロンプトとパラメータのベストプラクティス

プロンプトの質は非常に重要です。楽器、テンポ、雰囲気、そしてスタイルの参照について説明しなければなりません。 矛盾した要求を避ける フレーズは簡潔でありながら、音楽的な内容が豊かなものにします。

- 楽器構成: アコースティック ギター、親密なピアノ、柔らかな弦楽器、ローファイ ドラム。

- リズムとテンポ: 90 BPM、ハーフタイム、マークされたグルーヴ。

- 雰囲気: 映画的、親密、暗い、アンビエント、明るい。

- 制作: 微妙なリバーブ、適度なコンプレッション、アナログの飽和。

パラメータに関して: top_k と top_p は多様性を制御し、温度は創造性を調整します。 中程度の値から始める そして、自分のスタイルに最適なポイントが見つかるまで徐々に進めていきましょう。

パフォーマンス、レイテンシー、品質

CPU を使用すると、特にモデルが大きく期間が長い場合には推論が遅くなる可能性があります。 最新の GPU では、時間が大幅に短縮されます。以下のガイドラインを考慮してください。

- アイデアを繰り返し試すために、8~12 秒のクリップから始めます。

- いくつかの短いバリエーションを生成し、最適なものを連結します。

- DAW でアップサンプリングまたはポストプロダクションを行って、結果を磨き上げます。

Apple Silicon を搭載した macOS では、MPS は専用 CPU と GPU の中間的な役割を提供します。 PyTorchの最新バージョンにアップデートする パフォーマンスとメモリの向上を最大限に引き出します。

DAWを使ったポストプロダクションとワークフロー

WAV ファイルを生成したら、お気に入りの DAW にインポートします。 イコライゼーション、コンプレッション、リバーブ、編集 有望なクリップを完全な作品へと変換できます。ステムや楽器の分離が必要な場合は、ソース分離ツールを使って再結合とミックスを行ってください。

100% ローカルで作業してもコラボレーションが妨げられることはありません。最終的なファイルを好みのプライベート チャネルを通じて共有するだけです。 クラウドサービスに公開したり同期したりする必要がない プライバシー ポリシーで禁止されている場合は、使用しないでください。

よくある問題とその解決方法

インストールエラー: 互換性のないバージョン パイトーチ または CUDA が原因となることがほとんどです。 トーチのビルドがドライバーと一致していることを確認します およびシステム。Apple Silicon を使用している場合は、x86 専用のホイールをインストールしないでください。

ダウンロードがブロックされました: デバイスをインターネットに接続したくない場合は、 Audiocraftが期待する通りに重みをキャッシュに配置する 外部からの呼び出しを無効にしてください。フォルダの読み取り権限を確認してください。

オーディオが破損しているか無音の場合: サンプル レートと形式を確認してください。 ffmpegでフォントを変換する アーティファクトを回避するために共通の周波数 (例: 32 kHz または 44.1 kHz) を維持します。

パフォーマンスの低下: モデルのサイズやクリップの持続時間が減少する VRAMを消費するプロセスを閉じる 余裕が出てきたら、徐々に複雑さを増やしていきます。

ライセンスと責任ある使用の問題

MusicGen ライセンスと、参照用に使用するデータセットを参照してください。 ローカルで生成しても、著作権法の遵守が免除されるわけではありません。保護された作品やアーティストを直接模倣するプロンプトは避け、一般的なスタイルとジャンルを選択してください。

概念の比較: クラウド vs ローカル

アプリを開発するチーム向けに、Firebase Storage などのサービスでは、音声、画像、動画ファイルの認証と管理機能に加え、テキスト用のリアルタイム データベースを備えた SDK が提供されています。 このエコシステムは、ユーザーとコンテンツを同期する必要がある場合に最適です。対照的に、MusicGen を使用したプライベートなクリエイティブ ワークフローの場合、ローカル モードにより、遅延、クォータ、データの露出を回避できます。

2つの別々のトラックとして考えてください。結果を公開、共有、またはモバイルアプリに統合したい場合は、クラウドベースのバックエンドが便利です。 何もアップロードせずにプロトタイプを作成して作成することが目的の場合環境、重量、ローカル ディスクに注目してください。

MetaのMusicGenをローカルで使用する方法:リソースとコミュニティ

生成ツールに特化したフォーラムやサブレディットは、新しい開発や技術を知る良い指標となります。特に、オープンソースプロジェクトを積極的に支持する非公式コミュニティが存在します。 アートを公開したり、質問したり、議論を始めたり、技術を提供したり、単に閲覧したりできる場所ですコミュニティは、正式なドキュメントでは必ずしもカバーされない扉を開きます。

提案書や技術文書は、学術リポジトリや大学の Web サイトにも掲載されており、ダウンロード可能な PDF 形式で提供される場合もあります。 方法論的なインスピレーションとして活用するただし、MusicGen をマシン上でスムーズに実行できるようにするには、実際のオーディオの依存関係とフローに重点を置いてください。

上記のすべてにより、環境を設定し、最初の作品を生成し、素材を第三者に公開せずに結果を改善する方法を明確に理解できるようになりました。 適切な現地設定、慎重な指示、そしてポストプロダクションの組み合わせ 完全にコントロールできる、パワフルな創造の流れが手に入ります。さあ、あなたもその答えを見つけてください。 Meta の MusicGen をローカルで使用する方法。

幼い頃からテクノロジーに熱中。私はこの分野の最新情報を知ること、そして何よりもそれを伝えることが大好きです。だからこそ、私は長年テクノロジーとビデオゲームのウェブサイトでのコミュニケーションに専念してきました。 Android、Windows、MacOS、iOS、Nintendo、またはその他の思いついた関連トピックについて書いているのを見つけることができます。