- 一貫性を失うことなく長時間のセッションを圧縮してプログラミングすることに特化した新しいモデル。

- ベンチマーク (SWE-Bench、SWE-Lancer、Terminal-Bench) の測定可能な改善と、トークンの使用量削減。

- Plus、Pro、Business、Edu、Enterprise で利用可能。Codex ツールとの統合、パブリック API の計画あり。

- デフォルトではネットワークのない分離された環境ですが、セキュリティと監視の制御が備わっています。

OpenAIはGPT-5.1-Codex-Maxを導入した。、 人工知能の新しいモデル ソフトウェア開発に特化しており、 長期プロジェクトにおいて、文脈を失うことなく継続することを約束する実際には、 コーデックスの進化 複雑な作業を何時間も続けることができ、 効率とスピードの向上 これらは実際のワークフローで顕著です。

大きな新機能は、 持続的に推論する 圧縮と呼ばれるメモリ管理技術のおかげでこのアプローチにより、コンテキスト ウィンドウが過負荷になる前に飽和状態になることができます。 システムは冗長性を識別し、付属品を要約し、重要なものを保持します。したがって、長期にわたるタスクを停滞させる典型的な見落としを回避できます。

GPT-5.1-Codex-Maxとは何ですか?

それは プログラミングに最適化された特定のモデル 拡張ソフトウェアエンジニアリングタスクコードレビューからプルリクエストの生成、フロントエンド開発のサポートまで。以前の世代とは異なり、 長時間労働中に一貫性を保つように訓練されている かなり大きなサイズのリポジトリに保存されます。

OpenAIはGPT-5.1-Codex-MaxをCodexより一歩上の位置に置いた 許可することで 結果に劣化を生じさせることなく24時間以上連続して流す製品を構築する人にとって、これはコンテキストの境界による中断が減り、連続した反復でタスクを再度説明するために無駄に費やす時間が減ることを意味します。

技術革新と圧縮技術

キーは 履歴圧縮このモデルは、文脈のどの部分が文字通り不要であるかを特定し、それらを要約し、重要な参照を保持することで、記憶に負担をかけずにタスクを続行できるようにします。このメカニズムは、一部の資料では「圧縮」とも呼ばれていますが、文脈をインテリジェントにフィルタリングするという同じプロセスを説明しています。

この基盤により、GPT-5.1-Codex-Maxはコードの反復処理を継続することができます。 エラーを修正しリファクタリングする コンテキストウィンドウがボトルネックになることなく、モジュール全体を実行できます。また、処理負荷の高いユースケースでは、処理に必要なトークン数も削減され、コストとレイテンシの両方に影響を与えます。

このモデルには、 「超高い」推論 困難な問題については、多くのステップと依存関係を持つプロセスで出力の一貫性を維持しながら、タスクで必要なときに分析をさらに深く掘り下げることを目的としています。

パフォーマンスとベンチマーク:数字が示すもの

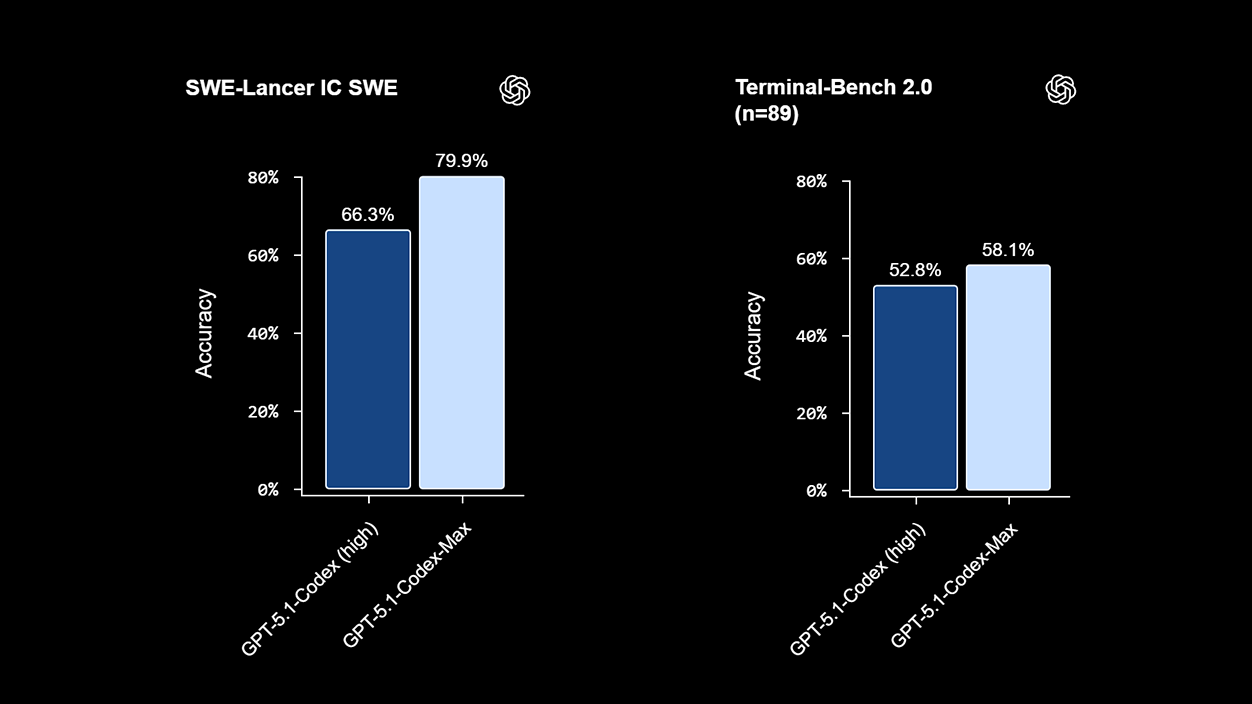

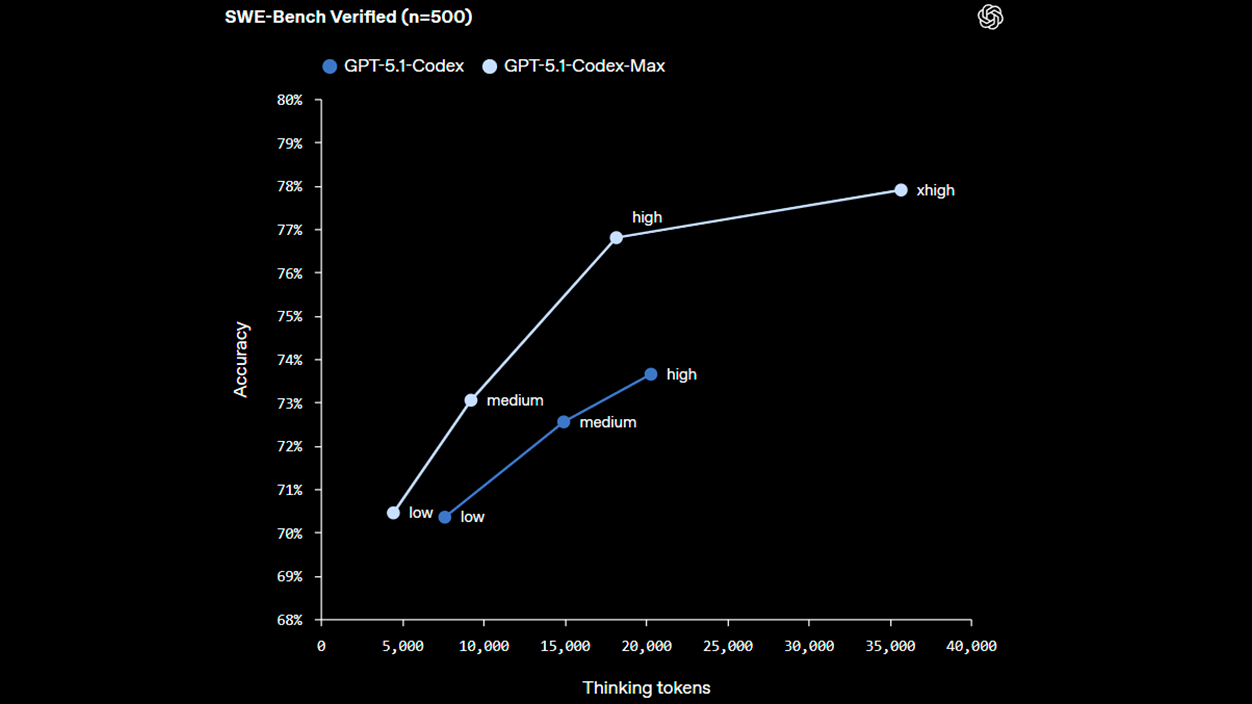

プログラミングに焦点を当てた内部評価では、 GPT-5.1-Codex-Maxは前バージョンより改良されたものである さまざまな面で、 成功率の向上 トークン効率の向上OpenAIが報告したこれらの結果は、 これらは、SWE-Bench Verified、SWE-Lancer IC SWE、Terminal-Bench 2.0などの実際のエンジニアリングタスクとバッテリーのテストを反映しています。.

共有データの中で、モデルはおよそ SWE-Bench Verified で 77,9% (GPT-5.1-Codexの73,7%と比較して)登録 SWE-ランサーIC SWEで79,9% そして達成する ターミナルベンチ2.0では58,1%さらに、同じ情報源によると、長時間のコンテキストでは、Codex と比較して一般的なタスクで 27% ~ 42% の速度向上が測定されています。

他のモデルとの比較では、 ジェミニ 3 プロOpenAIはいくつかのコーディングベンチマークでわずかな優位性を目指しており、 LiveCodeBench Proのような競争テストでの同等性を含むこれらの数字は、 内部測定 実稼働環境では異なる場合があります。

スペインとヨーロッパでの統合、ツール、可用性

GPT-5.1-Codex-Maxは、以下のサーフェス上で動作可能になりました。 古写本公式CLI、IDE拡張機能、コードレビューサービス OpenAIエコシステム同社によれば、パブリック API アクセスは後の段階で提供される予定であり、チームは今日からテストを開始できるという。 ネイティブツール カスタマイズされた統合を準備している間。

商業的利用可能性に関しては、 ChatGPT Plus、Pro、Business、Edu、Enterprise 発売当初からの新モデルも含まれています。スペインおよび世界のユーザーと組織 EU これらのサブスクリプションを使用すると、Codex の互換性のあるサーフェスを使用している限り、追加のデプロイメントを必要とせずにフロー内でアクティブ化できます。

OpenAIはまた、このモデルが Windows環境、Unix を超えて範囲を拡大し、混合開発パークと標準化された企業ツールを備えた企業での導入を促進します。

運用上の安全性とリスク管理

長期実行のリスクを軽減するために、モデルは 隔離されたワークスペースデフォルトのスコープ外への書き込み権限がない。さらに、ネットワーク接続は、担当開発者が明示的に有効にしない限り無効であり、 プライバシー.

環境には、 モニタリング 異常なアクティビティを検知し、不正使用が疑われる場合はプロセスを中断します。この構成は、エージェントの自律性と、機密性の高いコードや重要なリポジトリを管理するチームのための合理的な安全対策とのバランスをとることを目的としています。

最も貢献するユースケース

主な利点は、永続的な記憶と継続性を必要とする仕事で現れます。 大規模なリファクタリング、長期にわたる監視を必要とするデバッグ、継続的なコードレビュー、大規模リポジトリでのプルリクエストの自動化これらのタスクでは、圧縮によってコンテキストの「消耗」が軽減され、一貫性が維持されます。

スタートアップや技術チームにとって、 これらのプロセスを安定したモデルに委任することで、 製品の優先順位配送を迅速化し、疲労や手作業の繰り返しによるミスを減らすために。これらすべてが より合理化されたトークン消費 以前のバージョンよりも。

- マルチモジュールプロジェクト セッション間の継続性が重要になります。

- 支援付きCI/CD チェックと修正あり バックグラウンドで進行するものです。

- フロントエンドサポートとクロスコンテキストレビュー 複雑なユーザーストーリーにおいて。

- 故障解析 デバッグ 長持ちする 数時間ごとに事件について再度説明することなく。

Codexや他のモデルとの違い

クラシックコーデックスとの主な違いは、そのパワーだけでなく、 効果的なコンテキスト管理 長期的には、Codex は特定のタスクに優れています。一方、Codex-Max は継続的なプロセス向けに設計されており、モデルは時間が経っても進捗を見失わない共同作業者として機能します。

代替案との比較 ジェミニ 3 プロ いくつかのコーディングテストではGPT-5.1-Codex-Maxが有利である 発表されたデータによると、 賢明な方法は、これらの結果を私たち自身の環境と実際のワークロードで検証することです。 組織のパイプラインで標準化する前に。

疲れることなく技術的なマラソンに耐えられるコード駆動型AIを必要とする人は誰でも、 GPT-5.1-コーデックス-Max 継続性、デフォルトのセキュリティ、トークンの効率性に特化したオプション; 要求の厳しいリズムを持つスペインやヨーロッパのチームでは、これらの一連の品質が、より迅速な納品とより細かいコード保守につながります。

私はテクノロジー愛好家であり、その「オタク」の興味を職業に変えています。私は 10 年以上、純粋な好奇心から最先端のテクノロジーを使用し、あらゆる種類のプログラムをいじくり回してきました。現在はコンピューター技術とビデオゲームを専門にしています。これは、私が 5 年以上、テクノロジーやビデオ ゲームに関するさまざまな Web サイトに執筆し、誰にでも理解できる言語で必要な情報を提供することを目的とした記事を作成しているためです。

ご質問がございましたら、私の知識は Windows オペレーティング システムから携帯電話用の Android に関連するあらゆるものまで多岐にわたります。そして、私はあなたに対して、いつでも喜んで数分を費やして、このインターネットの世界であなたが抱いている疑問を解決するお手伝いをしたいと考えています。