- AI-søppel oversvømmer nettet med massivt, overfladisk og villedende innhold, noe som skader tillit og opplevelse.

- Plattformer, reguleringer og tagging-/proveniensteknikker er i utvikling, men insentiver belønner fortsatt viralitet.

- AI hjelper også: deteksjon, verifisering og kuratering med menneskelig tilsyn og kvalitetsdata.

Uttrykket «AI-søppel» har sneket seg inn i våre digitale samtaler for å beskrive skredet av dårlig innhold som metter internett. Utover støyen snakker vi om materiale massivt generert av kunstig intelligens-verktøy som prioriterer klikk og inntektsgenerering fremfor sannferdighet, nytte eller originalitet.

Akademiske eksperter, journalister og kommunikasjonsfolk har advart om et fenomen som ikke bare er en plage: undergraver tillit, forvrenger informasjonsøkosystemet og fortrenger menneskelig arbeid av høy kvalitet. Problemet er ikke nytt, men dets nåværende hastighet og omfang, drevet av generativ AI og anbefalingsalgoritmer, har gjort det til en tverrgående utfordring for brukere, plattformer, merkevarer og regulatorer.

Hva mener vi med «AI-søppel»?

AI-søppel (ofte omtalt som «AI-slop») omfatter Tekst, bilder, lyd eller video av lav til middels kvalitet, produsert raskt og billig med generative modeller. Dette er ikke bare åpenbare feil, men overfladiskhet, repetisjon, unøyaktigheter og tekster som later som de er autoriteter uten grunnlag.

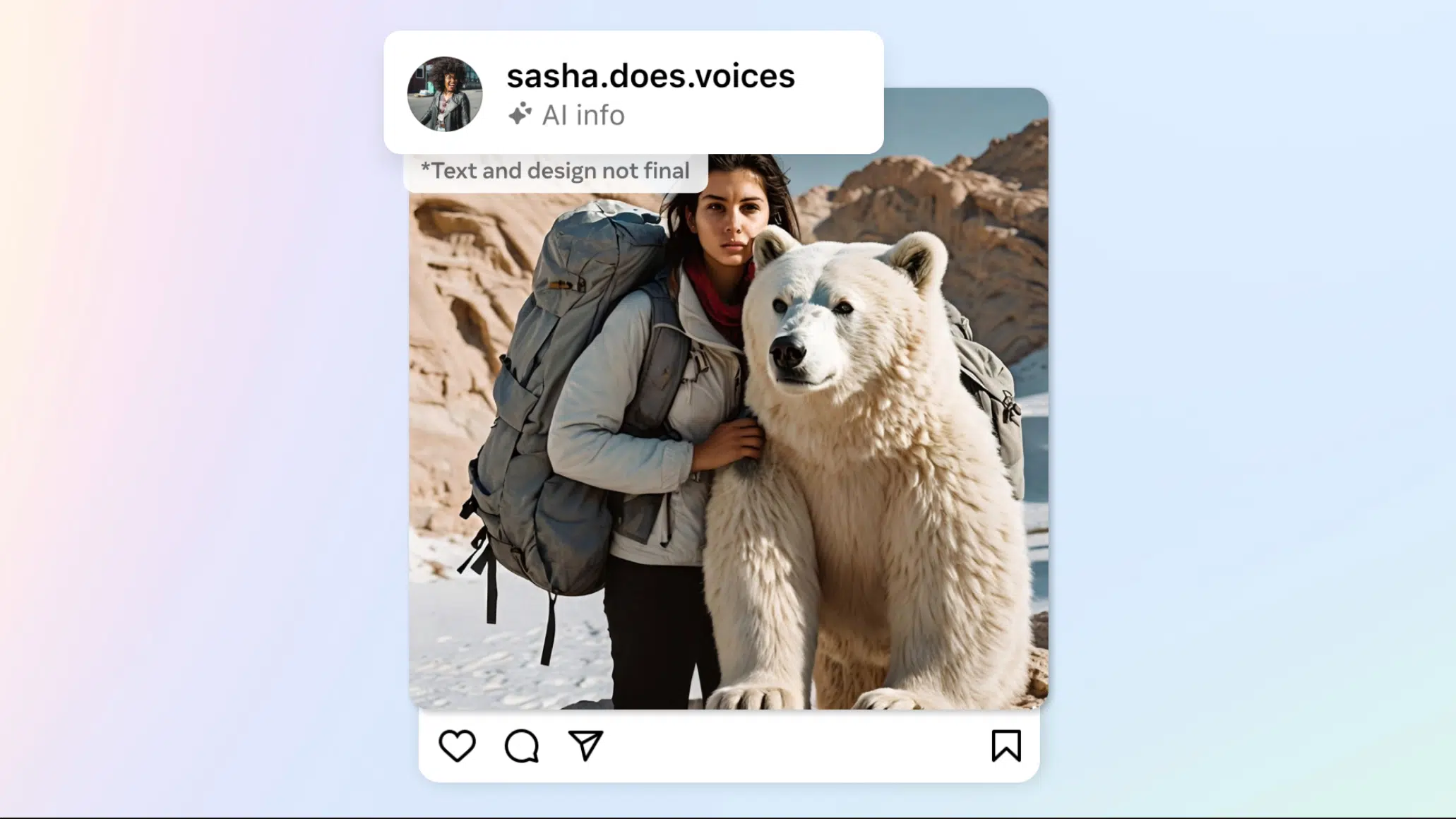

Nyere eksempler spenner fra virale bilder som en «Jesus laget av reker» eller oppdiktede emosjonelle scener – en jente som redder en valp i en flom – til Hyperrealistiske klipp av ikke-eksisterende gateintervjuer med seksualisert estetikk, generert med verktøy som Veo 3 og optimalisert for å samle visninger på sosiale medier. Innen musikk, oppfunnet band har eksplodert på strømmetjenester med syntetiske sanger og fiktive biografiske historier.

Utover underholdning berører fenomenet en følsom nerve: magasiner er åpne for samarbeid, som f.eks. Clarkesworld, måtte de midlertidig stenge forsendelser på grunn av flommen av automatiserte tekstmeldinger; til og med Wikipedia lider byrden av å moderere middelmådig AI-generert input. Alt dette gir næring til en følelse av metning som Det kaster bort tid og undergraver selvtilliten i det vi leser og ser.

Medieforskning og -analyse har videre dokumentert at noen av de raskest voksende kanalene er avhengige av AI-innhold designet for å maksimere reaksjoner – fra «zombiefotball» til kattefotoromaner – som forsterker plattformenes belønningssyklus og legger mer berikende forslag til side.

Hvordan det påvirker oss: brukeropplevelse, feilinformasjon og tillit

Den viktigste konsekvensen for publikum er bortkastet tid filtrere det trivielle fra det verdifulle. Den daglige belastningen forsterkes når AI-søppel brukes ondsinnet til å sår forvirring og feilinformasjonUnder orkanen Helene sirkulerte falske bilder som ble brukt til å angripe politiske ledere, og som viste at Selv det klart syntetiske kan manipulere oppfatninger hvis den forbrukes i full hastighet.

Kvaliteten på opplevelsen lider også av reduksjon av menneskelig tilbakeholdenhet på store plattformer. Rapporter indikerer kutt hos Meta, YouTube og X, og erstatning av utstyr med automatiserte systemer som i praksis ikke har klart å demme opp for utviklingen. Resultatet er en tillitskrise økende: mer støy, mer metning og brukere som er mer skeptiske til hva de forbruker.

Paradoksalt nok, noe syntetisk innhold De fungerer så bra i målinger som, selv om de oppdages som AI-genererte, promoteres for sin evne til å engasjere seg. Det er det gamle dilemmaet mellom hva som holder på oppmerksomheten og hva som tilfører verdiHvis algoritmer prioriterer førstnevnte, blir nettet fylt med iøynefallende, men tomme biter, med en direkte innvirkning på tilfredsheten til menneskene som bruker disse plattformene.

Og vi snakker ikke bare om brukere: kunstnere, journalister og skapere lider. økonomisk fortrengning Når feeder prioriterer billigproduserte artikler som gir visninger og inntekter, er AI-søppel ikke bare estetisk eller filosofisk: har vesentlige effekter på oppmerksomhetsøkonomien og de som tjener til livets opphold ved å tilby kvalitetsinnhold.

Søppeløkonomien: insentiver, triks og innholdsfabrikker

Bak «slurven» er det en velsmurt maskin. Kombinasjonen av billige generative modeller y bonusprogrammer plattformer basert på rekkevidde og interaksjon har gitt opphav til globale innholds"fabrikker". Innholdsskapere som den nevnte administratoren av dusinvis av Facebook-sider demonstrerer at med ledetekster, visuelle generatorer og en følelse av gripeevne kan du tiltrekke millioner av seere og samle regelmessige bonuser uten store investeringer.

Formelen er enkel: iøynefallende ideer – religion, militær, dyreliv, fotball – fremskynder modellen, massepubliseringen og optimalisering for reaksjonerJo mer «HVA?», jo bedre. Systemet straffer det ikke bare, men belønner det noen ganger, fordi passer med målet om å maksimere forbrukstidenNoen skapere kompletterer det med AI-genererte tråder på X, e-bøker på markedsplasser eller syntetiske musikklister, som støtter en undergrunnsinnholdsøkonomi.

Scenen har sitt økosystem av «tjenester»: monetiseringsguruer, forum og et stort antall grupper der de utveksler triks, de selger maler og oppgi kontoer i mer lønnsomme markeder. Du trenger ikke superintelligens for å forstå dette: AI er her. fungerer som et markedsføringsverktøy i stor skala, optimalisert for uendelig rulling og engangsforbruk.

Parallelt dukker det opp «ledetråder» om bruken av LLM i sammenhenger der bør ikke gå ubemerket hen: artikler med typiske assistentslagord, oppblåste bibliografier eller tekster med uforholdsmessige språklige tikk. Forskere har oppdaget titusenvis av akademiske artikler med spor av automatisk generering, som ikke bare er et spørsmål om form: devaluerer vitenskapelig kvalitet og forurenser sitasjonsnettverk.

Moderasjon, vann og etiketter: hva prøver vi å oppnå?

Den tekniske og regulatoriske responsen går fremover, men det er ikke en tryllestav. På plattformnivå utforsker de automatiske filtre, dupliseringsdetektorer, forfatterskapsverifisering og skilt som gjør at det repetitive kan degraderes og det originale kan opphøyes. Innenfor det juridiske feltet, Den europeiske union har tatt grep med AI-loven, som krever merking av syntetisk innhold og styrker åpenheten, samtidig som USA mangler fortsatt av en tilsvarende føderal standard, avhengig av frivillige forpliktelser.

Kina har på sin side fremmet regler for begrensning av produksjon og merking av automatisert innhold, som krever nøye bruk av opplæringsdata og respekt for åndsverk. I tråd med alt det ovennevnte, mekanismer for vannmerking y opprinnelse å spore opprinnelsen og transformasjonene av innhold over tid.

Problemer? Flere. Merkingen er ujevnt påført, vannmerking er skjøre for utgaver og opprinnelsessporing hindres av mangel på standarder og vanskeligheter med å skille menneskelige fra syntetiske med høy pålitelighet. I områder utenfor store markeder er håndhevingen enda mer slappe, noe som gjør hele regioner mer utsatt til informasjonsforurensning.

Selv om det oppfattes fremgang – til og med YouTube har annonsert kutt i betalinger til «uautentisk» eller «massivt» innhold – for øyeblikket innvirkningen er begrensetVirkeligheten er sta: mens forretningsinsentiver belønner viralitet, AI-søppelproduksjon kommer ikke til å stoppe seg selv.

Når AI er problemet … og en del av løsningen

Paradokset: den samme teknologien som genererer støy kan hjelpe klassifisere, oppsummere, kontrastere kilder og oppdage mistenkelige mønstreAI er allerede trent til å identifisere overfladiskhet, manipulasjon eller typiske tegn på automatisering; kombinert med menneskelig dømmekraft og klare regler, kan være en god brannmur.

Digital kompetanse er en annen pilar. Å forstå hvordan produserer og distribuerer Innhold beskytter oss mot bedrag. Verktøy for annotering i fellesskapet eller rapporteringssystemer De bidrar til å kontekstualisere og stoppe skadelig innhold, spesielt når nettverk, per design, prioriterer oppmerksomhet. Uten krevende brukere er kampen tapt ved kilden.

Det spiller også en rolle hvordan vi trener modellene. Hvis økosystemet er fylt med syntetisk materiale og det materialet gir næring til nye modeller, vil det oppstå et fenomen av kumulativ nedbrytningNyere forskning viser at ved å gi tilbakemeldinger til modeller med sine egne resultater, forvirringen øker og teksten kan føre til absurde uoverensstemmelser – som lister over umulige kaniner – en prosess som kalles «modellkollaps».

Å redusere denne effekten krever høykvalitets og varierte originaldata, sporbarhet av opprinnelse og prøvetaking som garanterer en minimal tilstedeværelse av menneskelig innhold i hver generasjon. I underrepresenterte språk og samfunn er risikoen for forvrengning større, noe som krever en politikk som helbredelse og balanse enda mer forsiktig.

Utilsiktet skade: Vitenskap, kultur og forskning

AI-søppeleffekten krysser grensene for fritid. I akademia, normalisering av middelmådige tekster og presset om å publisere kan føre til automatiske snarveier som lavere standarderBibliotekarer oppdager allerede AI-genererte bøker med absurde råd – fra usannsynlige oppskrifter til farlige guider, som for eksempel manualer for soppidentifisering som kan sette helsen din i fare.

Språklige verktøy som kartla språkbruk på internett vurderer å stoppe oppdateringer på grunn av forurensning av korpusetOg i søkemotorer kan de genererte sammendragene arve feil og presentere dem med en autoritetsfull tone, som mater teori (halvt spøk, halvt seriøs) om et «dødt» internett der roboter lager noe for roboter.

For markedsføring og bedriftskommunikasjon betyr dette svak kommunikasjon, metning av irrelevante publikasjoner og SEO-forringelse på grunn av oppblåstheten av ubetydelige sider. Omdømmekostnaden ved spredning unøyaktig informasjon er høy, og gjenopprettingen av tilliten går sakte.

Strategier for merkevarer og skapere: å heve standarden

Stilt overfor et mettet miljø, Differensiering innebærer å humanisere innhold med ekte historier, verifiserte data og ekspertstemmer.. Den kreativitet og Dokumentert originalitet er en sjelden ressursDet er tilrådelig å prioritere dem fremfor masseproduksjon.

AI må tilpasse seg merkevarestemme og verdier, ikke omvendt. Dette innebærer tilpasning, stilguider, eget korpus og krevende menneskelige vurderinger før publisering. Målet: tekster som tilfører verdi og ikke bare fyller ut hullene.

For SEO er kvalitet bedre enn kvantitet. Unngå setningsmaler, korriger typiske visuelle feil (hender, tekst på bilder), bidrar unike perspektiver og tegn på forfatterskap. Kombinasjonen av AI og menneskelig ekspert – med klare kriterier og sjekklister – er fortsatt gullstandarden. Og ja, vi må akseptere at overflod har skapt en mangel på verdiNår alt kan genereres umiddelbart, er forskjellen strenghet, fokus og kriterierDet er det bærekraftige konkurransefortrinnet.

Når man ser på dagens landskap, er utfordringen ikke bare teknisk: Så lenge algoritmer belønner prangende arbeid og det finnes insentiver til å produsere i bulk, vil AI-søppelet fortsette å strømme på.Løsningen ligger i å regulere med sunn fornuft, forbedre sporbarheten, øke mediekunnskapen og fremfor alt investere i menneskelig innhold av høy kvalitet som fortjener vår tid.

Jeg er en teknologientusiast som har gjort sine "geek"-interesser til et yrke. Jeg har brukt mer enn 10 år av livet mitt på å bruke banebrytende teknologi og fikse med alle slags programmer av ren nysgjerrighet. Nå har jeg spesialisert meg på datateknologi og videospill. Dette er fordi jeg i mer enn 5 år har skrevet for forskjellige nettsteder om teknologi og videospill, og laget artikler som prøver å gi deg den informasjonen du trenger på et språk som er forståelig for alle.

Hvis du har spørsmål, spenner min kunnskap fra alt relatert til Windows-operativsystemet samt Android for mobiltelefoner. Og mitt engasjement er til deg, jeg er alltid villig til å bruke noen minutter og hjelpe deg med å løse eventuelle spørsmål du måtte ha i denne internettverdenen.