- SAM 3 wprowadza segmentację obrazów i wideo w oparciu o tekst i przykłady wizualne, wykorzystując słownik obejmujący miliony pojęć.

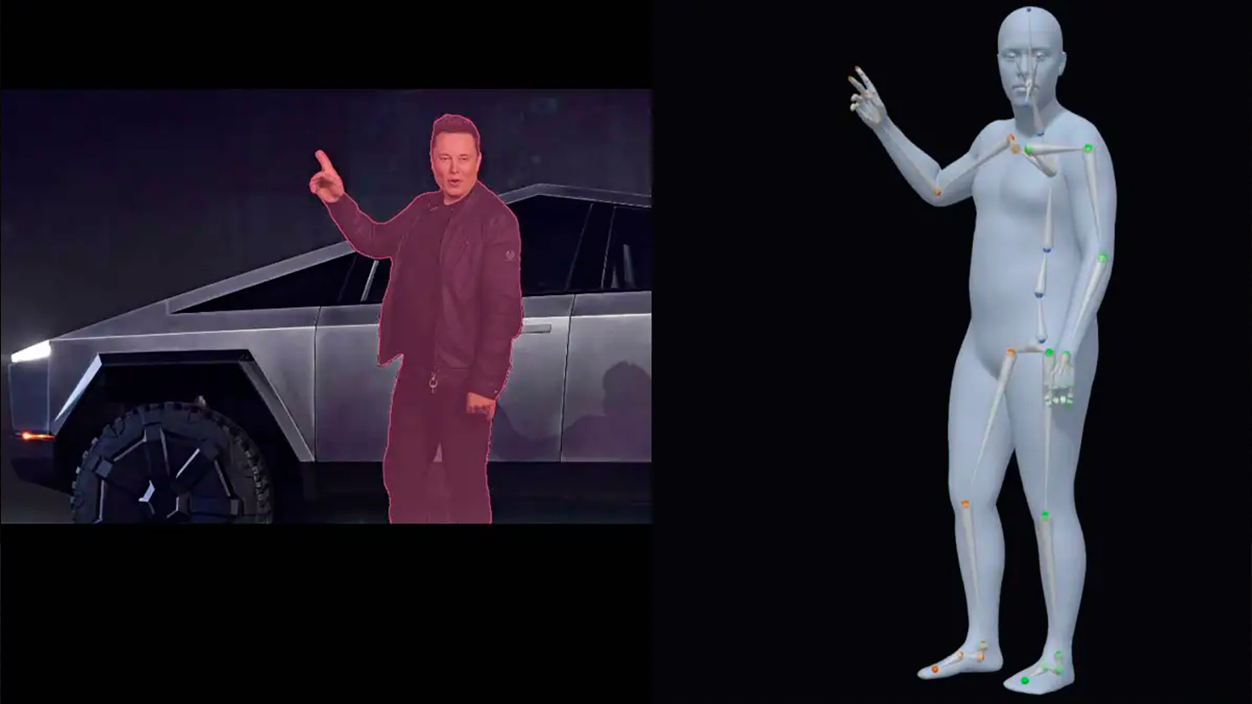

- SAM 3D umożliwia rekonstrukcję obiektów, scen i ciał ludzkich w 3D na podstawie pojedynczego obrazu, przy użyciu otwartych modeli.

- W Segment Anything Playground modele można testować bez konieczności posiadania wiedzy technicznej, korzystając z praktycznych i kreatywnych szablonów.

- Meta udostępnia wagi, punkty kontrolne i nowe testy porównawcze, aby programiści i badacze z Europy i reszty świata mogli zintegrować te możliwości ze swoimi projektami.

Meta podjęła kolejny krok w swoim zobowiązaniu sztuczna inteligencja zastosowana w komputerowym widzeniu z wprowadzenie na rynek SAM 3 i SAM 3D, dwa modele rozszerzające rodzinę Segment Anything i że Ich celem jest zmiana sposobu, w jaki pracujemy ze zdjęciami i filmamiFirma chce, aby narzędzia te nie pozostały jedynie eksperymentem laboratoryjnym, lecz służyły zarówno profesjonalistom, jak i użytkownikom bez wykształcenia technicznego.

Dzięki temu nowemu pokoleniu Meta skupia się na poprawić wykrywanie obiektów i segmentację i przynosząc trójwymiarową rekonstrukcję dla znacznie szerszej publicznościOd edycji wideo po wizualizację produktów dla handlu elektronicznego w Hiszpanii i pozostałych krajach Europy, firma przewiduje scenariusz, w którym Wystarczy, że opiszesz słowami, co chcesz zrobić, a sztuczna inteligencja wykona za ciebie większość ciężkiej pracy..

Co oferuje SAM 3 w porównaniu do poprzednich wersji?

SAM 3 jest pozycjonowany jako bezpośrednia ewolucja modeli segmentacji, które Meta zaprezentowała w 2023 i 2024 roku, znanych jako SAM 1 i SAM 2. Wczesne wersje koncentrowały się na identyfikacji pikseli należących do poszczególnych obiektów, głównie przy użyciu wskazówek wizualnych, takich jak kropki, pola lub maski, a w przypadku SAM 2 na śledzeniu obiektów w całym filmie niemal w czasie rzeczywistym.

Kluczowym nowym osiągnięciem jest to, że SAM 3 rozumie bogate i precyzyjne podpowiedzi tekstowenie tylko ogólne etykiety. Podczas gdy wcześniej używano prostych określeń, takich jak „samochód” czy „autobus”, nowy model jest w stanie reagować na znacznie bardziej szczegółowe opisy, na przykład „żółty autobus szkolny” lub „czerwony samochód zaparkowany na czerwonym pasie”.

W praktyce oznacza to, że wystarczy napisać coś takiego „czerwona czapka baseballowa” aby system mógł zlokalizować i oddzielić wszystkie elementy pasujące do tego opisu na obrazie lub filmie. Ta możliwość doprecyzowania za pomocą słów jest szczególnie przydatna w profesjonalne konteksty edycyjne, analiza reklam lub treści, gdzie często trzeba przyjrzeć się bardzo szczegółowym szczegółom.

Ponadto SAM 3 został zaprojektowany tak, aby integrować się z duże multimodalne modele językoweDzięki temu możesz wyjść poza proste frazy i używać bardziej złożonych instrukcji, takich jak: „Ludzie siedzący, ale nie noszący czerwonej czapki” lub „pieszych, którzy patrzą w kamerę, ale nie mają plecaka”. Ten rodzaj instrukcji łączy w sobie warunki i wykluczenia, które do niedawna trudno było przełożyć na narzędzie do przetwarzania obrazu komputerowego.

Wydajność i skala modelu SAM 3

Meta chciała również podkreślić mniej widoczną, ale kluczową część: skala wydajności technicznej i wiedzy modelu. Według danych firmy, SAM 3 jest w stanie przetworzyć pojedynczy obraz z ponad setką wykrytych obiektów w około 30 milisekund, korzystając z procesora graficznego H200, co jest prędkością bardzo zbliżoną do tej, która jest potrzebna w wymagających procesach roboczych.

W przypadku wideo firma zapewnia, że system utrzymuje wydajność praktycznie w czasie rzeczywistym podczas pracy z około pięcioma obiektami jednocześnie, co umożliwia śledzenie i segmentację ruchomych treści, od krótkich klipów w mediach społecznościowych po bardziej ambitne projekty produkcyjne.

Aby osiągnąć takie zachowanie, Meta zbudowała bazę szkoleniową składającą się z ponad 4 miliony unikalnych koncepcjiPołączenie ludzkich adnotatorów z modelami AI, które pomagają oznaczać duże ilości danych, to połączenie nadzoru ręcznego i automatycznego ma na celu zrównoważenie dokładności i skali — co jest kluczowe dla zapewnienia, że model dobrze reaguje na zróżnicowane dane wejściowe w kontekście europejskim, latynoamerykańskim i innych rynków.

Firma opracowuje SAM 3 w ramach tego, co nazywa Kolekcja Segment AnythingRodzina modeli, testów porównawczych i zasobów zaprojektowana w celu poszerzenia wizualnego rozumienia sztucznej inteligencji. Premierze towarzyszy nowy test porównawczy segmentacji „otwartego słownika”, skoncentrowany na pomiarze stopnia, w jakim system jest w stanie zrozumieć niemal każde pojęcie wyrażone w języku naturalnym.

Integracja z Edits, Vibes i innymi narzędziami Meta

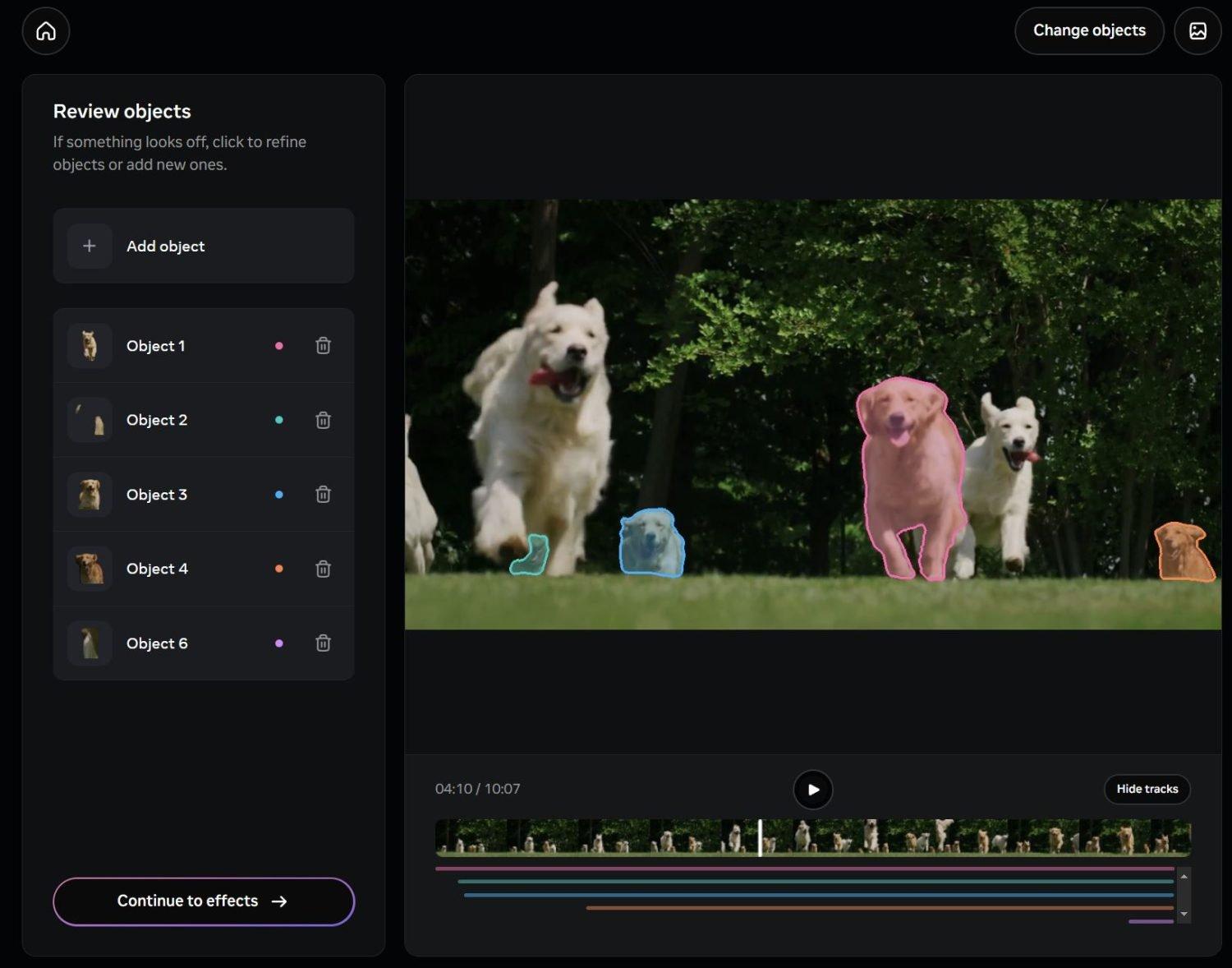

Oprócz komponentu technicznego Meta zaczęła już zintegrować SAM 3 z określonymi produktami przeznaczone do codziennego użytku. Jednym z pierwszych miejsc docelowych będą Edycje, ich aplikacja do tworzenia i edycji filmów, w której pomysł polega na tym, że użytkownik może wybrać konkretne osoby lub obiekty, dodać do nich prosty opis tekstowy i zastosować efekty, filtry lub zmiany tylko do tych części nagrania.

Inną drogę integracji znajdziemy w Wibracje w aplikacji Meta AI i platformie meta.aiW tym środowisku segmentacja tekstu zostanie połączona z narzędziami generatywnymi, co umożliwi tworzenie nowych rozwiązań edycyjnych i kreatywnych, takich jak niestandardowe tła, efekty ruchu lub selektywne modyfikacje zdjęć przeznaczone dla sieci społecznościowych, które cieszą się dużą popularnością w Hiszpanii i w innych krajach Europy.

Propozycja firmy jest taka, aby te możliwości nie ograniczały się do studiów zawodowych, ale raczej sięgały... niezależni twórcy, małe agencje i zaawansowani użytkownicy którzy na co dzień pracują z treściami wizualnymi. Możliwość segmentowania scen poprzez pisanie opisów w języku naturalnym skraca krzywą uczenia się w porównaniu z tradycyjnymi narzędziami opartymi na ręcznych maskach i warstwach.

Jednocześnie Meta utrzymuje otwarte podejście do zewnętrznych programistów, sugerując, że aplikacje stron trzecich - od narzędzi do edycji po rozwiązania do analizy wideo w handlu detalicznym lub branży bezpieczeństwa - mogą polegać na SAM 3, o ile przestrzegana jest polityka użytkowania danej firmy.

SAM 3D: Trójwymiarowa rekonstrukcja z pojedynczego obrazu

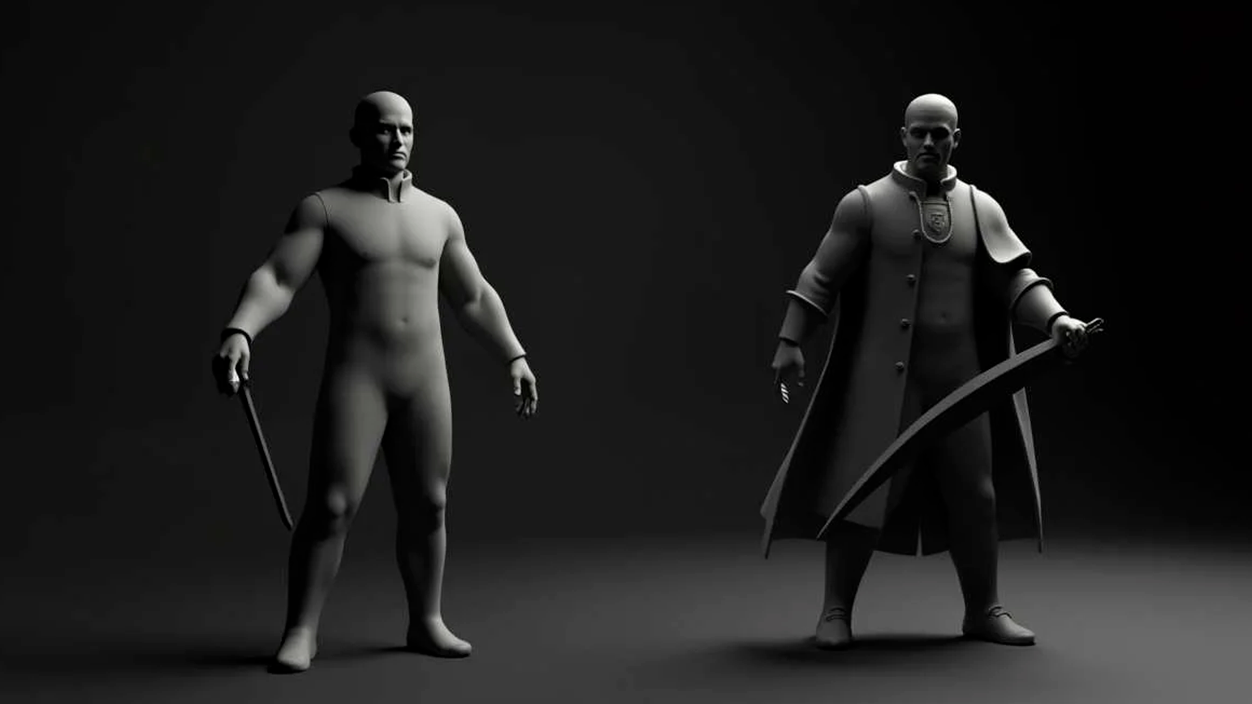

Drugą ważną wiadomością jest to, że SAM 3Dsystem zaprojektowany do wykonywania rekonstrukcje trójwymiarowe Zaczynając od obrazów 2D. Zamiast konieczności wykonywania wielu zdjęć pod różnymi kątami, model ma na celu wygenerowanie wiarygodnej reprezentacji 3D z jednego zdjęcia, co jest szczególnie interesujące dla tych, którzy nie dysponują specjalistycznym sprzętem do skanowania ani procedurami.

SAM 3D składa się z dwóch modeli open-source o różnych funkcjach: Obiekty SAM 3Dskupiony na rekonstrukcji obiektów i scen oraz Nadwozie SAM 3D, ukierunkowany na ocenę kształtu i budowy ciała człowieka. To rozdzielenie pozwala na dostosowanie systemu do bardzo różnych zastosowań, od katalogów produktów po aplikacje zdrowotne i sportowe.

Według Meta, obiekty SAM 3D oznaczają Nowy test wydajności w rekonstrukcji 3D wspomaganej sztuczną inteligencjąZ łatwością przewyższając poprzednie metody w zakresie kluczowych wskaźników jakości. Aby dokładniej ocenić wyniki, firma nawiązała współpracę z artystami w celu stworzenia obiektów artystycznych SAM 3D, zbioru danych zaprojektowanego specjalnie do oceny wierności i szczegółowości rekonstrukcji szerokiej gamy obrazów i obiektów.

Postęp ten otwiera drzwi do praktycznych zastosowań w takich obszarach jak: robotyka, nauka, medycyna sportowa czy kreatywność cyfrowaNa przykład w robotyce może pomóc systemom lepiej zrozumieć objętość obiektów, z którymi wchodzą w interakcję; w badaniach medycznych lub sportowych może pomóc w analizie postawy i ruchu ciała; a w projektowaniu kreatywnym służy jako podstawa do generowania modeli 3D na potrzeby animacji, gier wideo lub doświadczeń immersyjnych.

Jedną z pierwszych już widocznych komercyjnych aplikacji jest funkcja „Widok w pokoju” de Facebook Marketplaceco pozwala na wizualizację wyglądu mebla lub przedmiotu dekoracyjnego w rzeczywistym pomieszczeniu przed jego zakupem. Dzięki SAM 3D, Meta dąży do udoskonalenia tego typu doświadczeń, co jest szczególnie istotne dla europejskiego handlu elektronicznego, w którym zwrot produktów z powodu niespełnionych oczekiwań wiąże się ze wzrastającymi kosztami.

Segment Anything Playground: środowisko do eksperymentowania

Aby umożliwić użytkownikom przetestowanie tych możliwości bez instalowania czegokolwiek, Meta włączyła Plac zabaw Segment AnythingTo platforma internetowa, która umożliwia przesyłanie obrazów lub filmów i eksperymentowanie z SAM 3 i SAM 3D bezpośrednio z przeglądarki. Idea polega na tym, że każdy, kto interesuje się wizualną sztuczną inteligencją, może odkryć jej możliwości bez konieczności znajomości programowania.

W przypadku SAM 3, Playground umożliwia segmentację obiektów za pomocą krótkie frazy lub szczegółowe instrukcjeŁączenie tekstu z, w razie potrzeby, przykładami wizualnymi. Upraszcza to typowe zadania, takie jak zaznaczanie osób, samochodów, zwierząt lub określonych elementów sceny i stosowanie do nich określonych działań, od efektów estetycznych po rozmycie lub zamianę tła.

Pracując z SAM 3D platforma umożliwia Odkryj sceny z nowej perspektywyPrzestawiaj obiekty, stosuj efekty trójwymiarowe lub generuj alternatywne widoki. Dla osób pracujących w projektowaniu, reklamie lub tworzeniu treści 3D, oferuje szybki sposób na prototypowanie pomysłów bez konieczności korzystania ze skomplikowanych narzędzi technicznych od samego początku.

Na placu zabaw znajduje się również szereg gotowe szablony Funkcje te są ukierunkowane na bardzo specyficzne zadania. Obejmują one praktyczne opcje, takie jak pikselowanie twarzy lub tablic rejestracyjnych w celu zachowania prywatności, a także efekty wizualne, takie jak smugi ruchu, selektywne podświetlenie lub reflektory na interesujących obszarach w materiale wideo. Tego typu funkcje mogą być szczególnie przydatne w procesach pracy twórców mediów cyfrowych i treści w Hiszpanii, gdzie produkcja krótkich filmów i treści do mediów społecznościowych jest stała.

Otwarte zasoby dla programistów i badaczy

Zgodnie ze strategią, którą Meta zastosowała w innych wydaniach AI, firma zdecydowała się udostępnić znaczną część zasoby techniczne związane z SAM 3 i SAM 3DPo pierwsze, opublikowano wagi modelu, nowy punkt odniesienia skupiający się na segmentacji otwartego słownictwa oraz dokument techniczny szczegółowo opisujący jego rozwój.

W przypadku SAM 3D dostępne są następujące opcje: punkty kontrolne modelu, kod wnioskowania i zestaw danych ewaluacyjnych następnej generacji. Ten zbiór danych zawiera znaczną różnorodność obrazów i obiektów, które mają wykraczać poza tradycyjne punkty odniesienia 3D, zapewniając większy realizm i złożoność, co może być bardzo przydatne dla europejskich grup badawczych zajmujących się przetwarzaniem obrazu i grafiką komputerową.

Firma Meta ogłosiła również współpracę z platformami adnotacji, takimi jak Roboflow, której celem jest umożliwienie programistom i firmom Wprowadź własne dane i dostosuj SAM 3 do konkretnych potrzeb. Otwiera to drogę do rozwiązań sektorowych, od inspekcji przemysłowej po analizę ruchu miejskiego, w tym projektów dziedzictwa kulturowego, w których ważna jest precyzyjna segmentacja elementów architektonicznych lub artystycznych.

Wybierając stosunkowo otwarte podejście, firma chce zapewnić ekosystemowi programistów, uniwersytety i startupy - w tym te działające w Hiszpanii i reszcie Europy - mogą eksperymentować z tymi technologiami, integrować je ze swoimi produktami i ostatecznie wnosić przypadki użycia wykraczające poza te, które Meta może opracować wewnętrznie.

Dzięki SAM 3 i SAM 3D firma Meta ma zamiar skonsolidować bardziej elastyczna i dostępna platforma wizualnej sztucznej inteligencjigdzie segmentacja sterowana tekstem i rekonstrukcja 3D z pojedynczego obrazu nie są już możliwościami zarezerwowanymi dla wysoce wyspecjalizowanych zespołów. Potencjalny wpływ rozciąga się od codziennej edycji wideo po zaawansowane zastosowania w nauce, przemyśle i e-commerce, w kontekście, w którym połączenie języka, wizji komputerowej i kreatywności staje się standardowym narzędziem pracy, a nie tylko technologiczną obietnicą.

Jestem entuzjastą technologii, który swoje „geekowskie” zainteresowania przekształcił w zawód. Spędziłem ponad 10 lat mojego życia, korzystając z najnowocześniejszych technologii i majsterkując przy wszelkiego rodzaju programach z czystej ciekawości. Teraz specjalizuję się w technologii komputerowej i grach wideo. Dzieje się tak dlatego, że od ponad 5 lat piszę dla różnych serwisów poświęconych technologii i grom wideo, tworząc artykuły, których celem jest dostarczenie potrzebnych informacji w języku zrozumiałym dla każdego.

Jeśli masz jakieś pytania, moja wiedza obejmuje wszystko, co jest związane z systemem operacyjnym Windows, a także Androidem dla telefonów komórkowych. Moje zaangażowanie jest wobec Ciebie. Zawsze jestem gotowy poświęcić kilka minut i pomóc Ci rozwiązać wszelkie pytania, jakie możesz mieć w tym internetowym świecie.