- SAM 3-segment med detaljerade textuppmaningar och integrerar syn och språk för större noggrannhet.

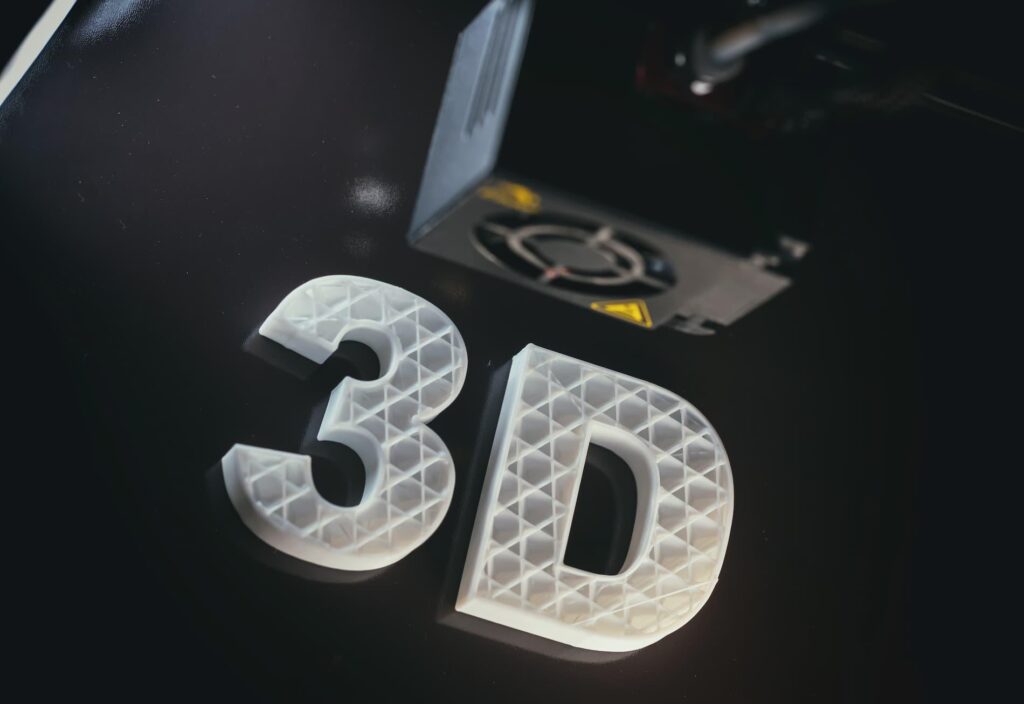

- SAM 3D rekonstruerar 3D-objekt och kroppar från en enda bild med hjälp av öppna resurser.

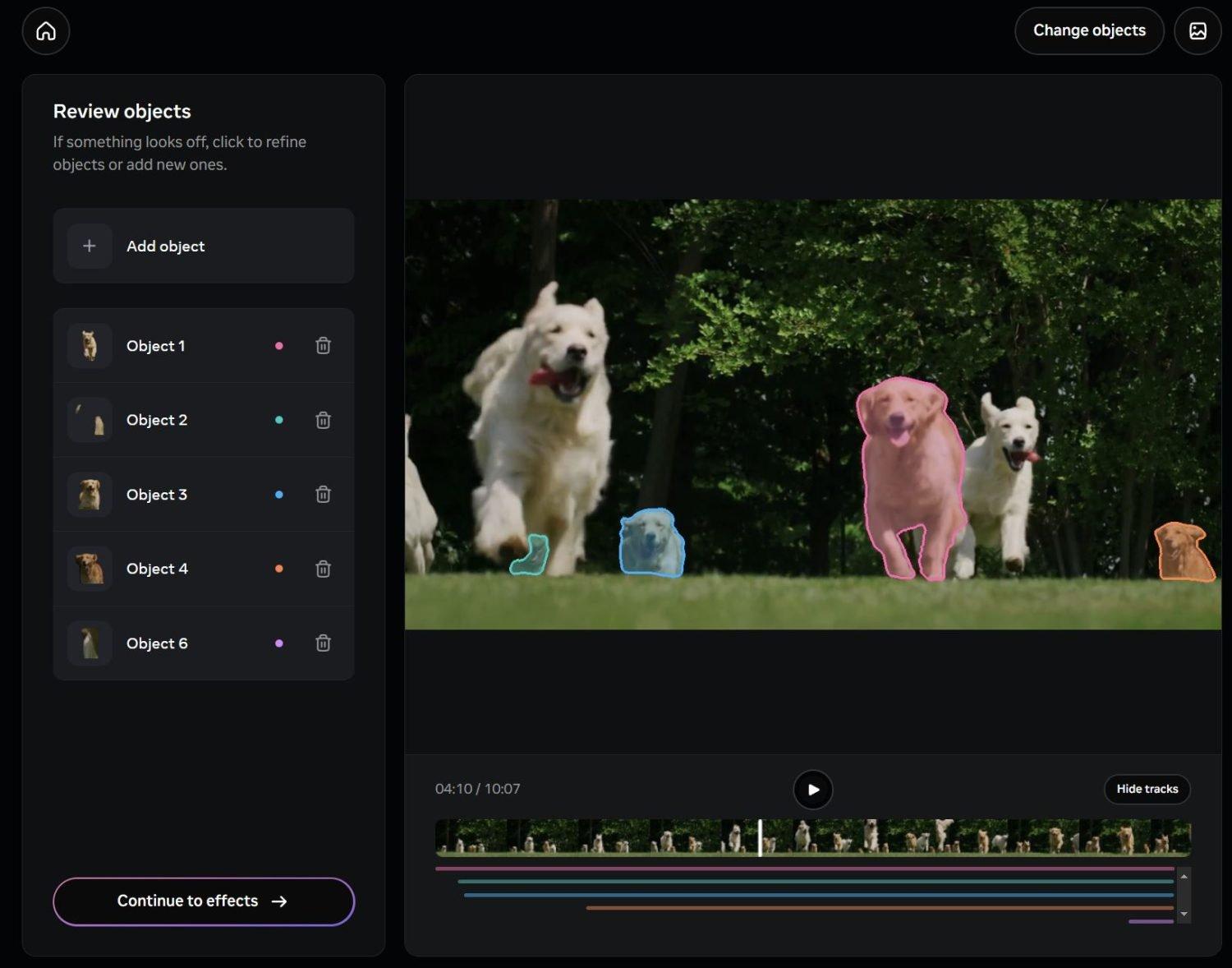

- Med Playground kan du testa segmentering och 3D utan teknisk kunskap eller installation.

- Applikationer inom redigering, marknadsplats och områden som utbildning, vetenskap och sport.

¿Hur konverterar man människor och objekt till 3D-modeller med SAM 3D? Artificiell intelligens tillämpad på visuella element har stor inverkan, och nu är det, förutom att exakt skära ut objekt, möjligt konvertera en enskild bild till en 3D-modell Redo att utforska från flera vinklar. Meta har introducerat en ny generation verktyg som överbryggar redigering, visuell världsförståelse och tredimensionell rekonstruktion utan att kräva avancerad utrustning eller kunskap.

Vi pratar om SAM 3 och SAM 3D, två modeller som kommer för att förbättra detektering, spårning och segmentering, och för att ge 3D-rekonstruktion av objekt och människor till en bred publik. Deras förslag innebär att man förstår textinstruktioner och visuella signaler samtidigt, så att det är lika enkelt att klippa, omvandla och rekonstruera element som att skriva vad vi vill eller göra några få klick.

Vad är SAM 3 och SAM 3D och hur skiljer de sig?

Metas Segment Anything-familj utökas med två nya tillskott: SAM 3 och SAM 3D. Den förra fokuserar på att identifiera, spåra och segmentera objekt i foton och videor med nästa generations noggrannhet, medan den senare Rekonstruerar 3D-geometri och utseende från en enda bildinklusive människor, djur eller vardagsprodukter.

Den funktionella skillnaden är tydlig: SAM 3 hanterar "förståelsen och separeringen" av visuellt innehåll, och SAM 3D använder den förståelsen för att "skapa" en tredimensionell volym. Med denna parning blir ett arbetsflöde som tidigare krävde komplex programvara eller specialiserade skannrar... mycket mer tillgängligt och snabbare.

Dessutom är SAM 3 inte begränsat till grundläggande visuella instruktioner. Det tillhandahåller segmentering guidad av naturligt språk som kan tolka mycket exakta beskrivningarVi pratar inte längre bara om "bil" eller "boll", utan om fraser som "röd basebollkeps" för att hitta just dessa element i en scen, även genom hela en video.

Samtidigt finns SAM 3D i två kompletterande varianter: SAM 3D Objects, med fokus på objekt och sceneroch SAM 3D Body, utbildad för att uppskatta mänsklig form och kropp. Denna specialisering gör att den kan täcka allt från konsumtionsvaror till porträtt och poser, vilket öppnar dörren för kreativa, kommersiella och vetenskapliga tillämpningar.

Hur lyckas de segmentera och rekonstruera från en enda bild?

Nyckeln ligger i en arkitektur som tränas på stora datamängder för att etablera direkta länkar mellan ord och pixlar. Modellen förstår skriftliga instruktioner och visuella signaler (klick, punkter eller rutor) samtidigt, så att översätta en begäran till specifika områden av ett foto eller en videobildruta.

Denna förståelse av språket går utöver traditionella klassnamn. SAM 3 kan hantera komplexa instruktioner, undantag och nyanser, vilket möjliggör frågor som "personer som sitter ner och inte bär röd hatt". Denna kompatibilitet med detaljerade textmeddelanden Det löser en historisk begränsning hos tidigare modeller, som tenderade att förvirra detaljerade begrepp.

Sedan kommer SAM 3D in i bilden: den börjar med en bild och genererar en tredimensionell modell som låter dig se objektet från andra perspektiv, omorganisera scenen eller tillämpa 3D-effekter. I praktiken integreras den med den tidigare segmenteringen för att isolera det som intresserar oss och därmed... Bygg om i 3D utan komplicerade mellansteg.

Nya funktioner jämfört med tidigare generationer

SAM 1 och SAM 2 revolutionerade segmenteringen genom att i hög grad förlita sig på visuella ledtrådar. De hade dock svårt när de ombads att ge långa tolkningar eller nyanserade instruktioner på naturligt språk. SAM 3 bryter igenom den barriären genom att införliva multimodal förståelse som kopplar samman text och bild mer direkt.

Meta ackompanjerar framstegen med ett nytt riktmärke av öppen ordförrådssegmenteringUtformad för att utvärdera textstyrd segmentering i verkliga scenarier, och med publiceringen av SAM 3-vikterna. På så sätt kan forskare och utvecklare noggrant mäta och jämföra resultat mellan metoder.

I sin omdesign förbättras SAM 3D Objects avsevärt jämfört med tidigare metoder, enligt data som delats av Meta, som också släpper kontrollpunkter, inferenskod och en utvärderingsuppsättning. Tillsammans med SAM 3D Body släpper företaget SAM 3D Artist Objects, en ny datauppsättning skapad tillsammans med konstnärer för att bedöma 3D-kvalitet i en mängd olika bilder.

Verkliga tillämpningar och omedelbara användningsfall

Meta integrerar dessa funktioner i sina produkter. I ”Edits”, deras videoverktyg för Instagram och Facebook, används redan avancerad segmentering för att tillämpa effekter på videor. specifika personer eller föremål utan att påverka resten av bilden. Detta underlättar bakgrundsändringar, selektiva filter eller riktade transformationer utan att offra kvaliteten.

Vi kommer även att se dessa funktioner i Vibes, i Meta AI-appen och på meta.ai-plattformen, med nya redigerings- och kreativa upplevelser. Genom att tillåta komplexa instruktioner kan användaren beskriva vad de vill ändra, och systemet kommer att reagera därefter. automatiserar efterproduktionsuppgifter som brukade vara mödosamt.

Inom handeln utmärker sig Facebook Marketplaces "View in Room" och hjälper användare att visualisera hur möbler eller lampor skulle se ut i deras hem tack vare automatiskt genererade 3D-modeller. Denna funktion minskar osäkerheten och förbättrar köpbeslutet, en viktig punkt när vi inte fysiskt kan se produkten.

Effekten sträcker sig till robotik, vetenskap, utbildning och idrottsmedicin. 3D-rekonstruktion från enkla fotografier kan mata simulatorer, skapa anatomiska referensmodeller och stödja analysverktyg som tidigare krävde specialutrustning. Allt detta främjar nya arbetsflöden inom forskning och utbildning.

Segment Anything Playground: testa och skapa utan friktion

För att demokratisera åtkomst har Meta lanserat Segmentera vad som helst LekplatsEn webbplats där vem som helst kan ladda upp bilder eller videor och experimentera med SAM 3 och SAM 3D. Dess gränssnitt påminner om den "trollstaven" i klassiska redigerare, med fördelen att vi kan skriva vad vi vill välja eller förfina med några få klick.

Dessutom erbjuder Playground färdiga mallar. Dessa inkluderar praktiska alternativ som pixelerade ansikten eller registreringsskyltaroch mer kreativa effekter som rörelsespår eller spotlights. Detta gör det möjligt att uppnå identitetsskyddande uppgifter eller iögonfallande effekter på några sekunder.

Utöver segmentering kan användare utforska scener från nya perspektiv, omorganisera dem eller tillämpa tredimensionella effekter med SAM 3D. Målet är att vem som helst, utan förkunskaper om 3D eller datorseende, ska kunna göra det. uppnå acceptabla resultat på några minuter och utan att installera någonting.

Modeller, öppna resurser och utvärdering

Meta har släppt resurser för att hjälpa communityn att utveckla den senaste tekniken. För SAM 3 finns följande tillgängliga: modellvikter tillsammans med ett riktmärke för öppen vokabulär och en teknisk rapport som i detalj beskriver arkitekturen och utbildningen. Detta underlättar reproducerbarhet och rättvisa jämförelser.

På 3D-fronten har företaget släppt kontrollpunkter, inferenskod och nästa generations bedömningssvit. Dualiteten mellan SAM 3D Objects och SAM 3D Body möjliggör omfattande täckning. allmänna föremål och människokroppen med mätvärden anpassade till varje fall, något som är viktigt för att bedöma geometrisk och visuell trohet.

Att samarbeta med konstnärer för att skapa SAM 3D Artist Objects introducerar estetiska och mångfaldskriterier i utvärderingen, inte bara tekniska. Detta är nyckeln till att göra 3D-rekonstruktion användbar i kreativa och kommersiella miljöerdär den kvalitet som människor uppfattar gör skillnaden.

Textsegmentering: exempel och fördelar

Med SAM 3 kan du skriva "röd basebollkeps" och systemet identifierar alla träffar i en bild eller i en video. Denna noggrannhet öppnar dörren för redigeringsarbetsflöden där det räcker med att bara skriva "röd basebollkeps". korta och tydliga meningar att separera element och tillämpa effekter eller transformationer på dem.

Kompatibilitet med multimodala språkmodeller möjliggör mer omfattande instruktioner, inklusive undantag eller villkor ("personer som sitter ner och inte bär röd mössa"). Denna flexibilitet minskar manuell arbetstid och minskar urvalsfel som tidigare korrigerats för hand.

För team som skapar innehåll i stor skala accelererar textdriven segmentering pipelines och gör det enklare att standardisera resultat. Inom marknadsföring kan till exempel konsekvens upprätthållas genom att tillämpa filter på en produktfamilj, något som förbättrar tid och kostnader av produktionen.

Redigering i sociala medier och digital kreativitet

Integrationen i Edits ger avancerade efterproduktionsfunktioner till Instagram- och Facebook-skapare. Ett filter som tidigare krävde komplexa masker kan nu appliceras med ett textkommando och några få klick, samtidigt som kanterna och de fina detaljerna stabilt bildruta för bildruta.

För korta stycken, där publiceringsschemat är viktigt, är denna automatisering guld värd. Att ändra ett klipps bakgrund, markera endast en person eller omvandla ett specifikt objekt kräver inte längre manuella arbetsflöden, och det demokratiserar effekter som tidigare var exklusiva för yrkesverksamma.

Samtidigt utökar Vibes och meta.ai utbudet av upplevelser med språkdriven redigering och kreativitet. Genom att kunna beskriva i detalj vad vi vill ha förkortas språnget från idé till resultat, vilket innebär mer kreativa iterationer på kortare tid.

Handel, vetenskap och sport: bortom underhållning

”View in Room” på Facebook Marketplace exemplifierar det praktiska värdet: att se en lampa eller möbel i vardagsrummet innan man köper minskar returkostnaderna och bygger förtroende. Bakom det finns en pipeline som, med början i bilder, genererar en 3D-modell för visualisering kontextuella.

Inom vetenskap och utbildning minskar rekonstruktion från enkla fotografier kostnaden för att skapa undervisningsmaterial och realistiska simulatorer. En AI-genererad anatomisk modell kan användas som ett stödverktyg i klassrum eller i... biomekanisk analysaccelererar innehållsförberedelser.

Inom idrottsmedicin ger kombinationen av kroppssammansättningsanalys och formrekonstruktion verktyg för att studera ställningar och rörelser utan dyr utrustning. Detta öppnar upp möjligheter för mer frekventa utvärderingar och fjärrövervakning.

Integritet, etik och god praxis

Kraften i dessa verktyg kräver ansvar. Att manipulera bilder av människor utan deras samtycke kan leda till juridiska och etiska problem. Det är lämpligt att undvika att rekonstruera bilder. okända ansiktenDela inte modeller utan tillstånd och ändra inte känsliga scener som kan orsaka förvirring eller skada.

Meta tillkännager kontroller för att minska missbruk, men det yttersta ansvaret ligger hos användaren av tekniken. Det är lämpligt att verifiera bildernas ursprung, skydda personuppgifter och bedöma sammanhanget innan 3D-modeller publiceras som kan exponera privat information.

I professionella miljöer bidrar det till ansvarsfull användning att etablera gransknings- och samtyckespolicyer och tydligt märka AI-genererat innehåll. Att utbilda teamet i dessa ämnen hjälper till att förhindra dåliga vanor redan reagerar snabbt på incidenter.

Hur man konverterar personer och objekt till 3D-modeller med SAM 3D: Så här kommer du igång

Om du vill experimentera direkt är Anything Playground-segmentet vägen dit. Där kan du ladda upp ett foto eller en video, skriva in det du vill välja och testa 3D-rekonstruktionsalternativ i ett enkelt gränssnitt. För tekniska profiler, [finns fler alternativ]. vikter, kontrollpunkter och kod som underlättar skräddarsydda tester.

Forskare, utvecklare och konstnärer har ett ekosystem som inkluderar riktmärken, utvärderingsdata och dokumentation. Målet är att skapa en gemensam grund för att mäta framsteg och påskynda implementeringen inom olika sektorerfrån digital kreativitet till robotik.

Det mest intressanta är att detta språng inte är reserverat för specialister: inlärningskurvan blir kortare och funktionerna når vardagliga appar. Allt tyder på att redigering och 3D kommer att fortsätta integreras i arbetsflöden där naturligt språk är gränssnittet.

Med SAM 3 och SAM 3D erbjuder Meta textsegmentering och rekonstruktion av enskilda bilder till kreatörer och team av alla storlekar. En solid grund skapas mellan Playground, integration i redigeringar, öppna resurser och applikationer inom handel, utbildning och sport. nytt sätt att arbeta med bilder och volym som kombinerar noggrannhet, tillgänglighet och ansvar.

Brinner för teknik sedan han var liten. Jag älskar att vara uppdaterad inom branschen och framför allt kommunicera den. Det är därför jag har varit dedikerad till kommunikation på teknik- och videospelswebbplatser i många år nu. Du kan hitta mig som skriver om Android, Windows, MacOS, iOS, Nintendo eller något annat relaterat ämne som du tänker på.