- SAM 3 впроваджує сегментацію зображень та відео на основі текстових та візуальних прикладів, зі словником із мільйонів концепцій.

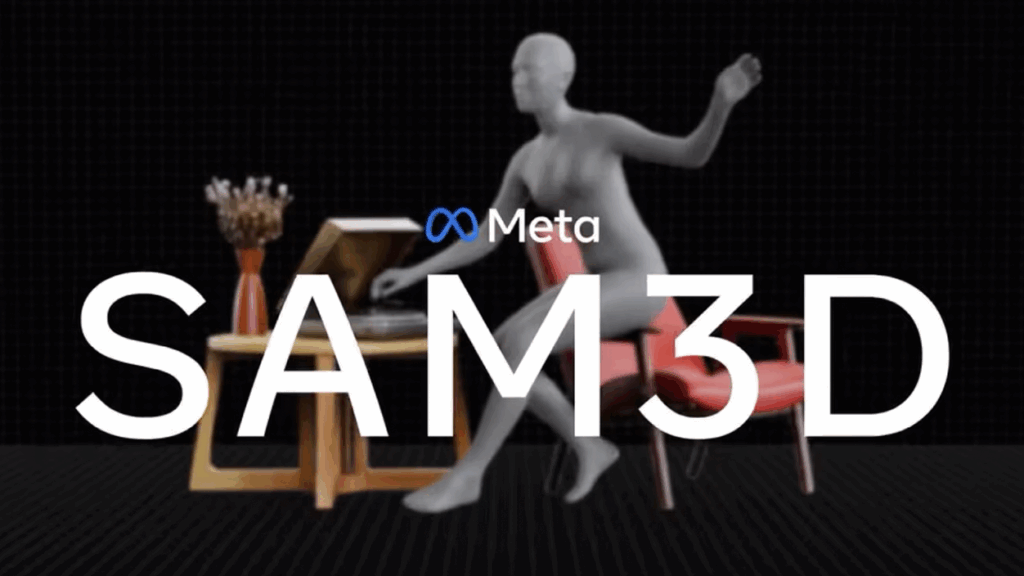

- SAM 3D дозволяє реконструювати об'єкти, сцени та людські тіла у 3D з одного зображення, використовуючи відкриті моделі.

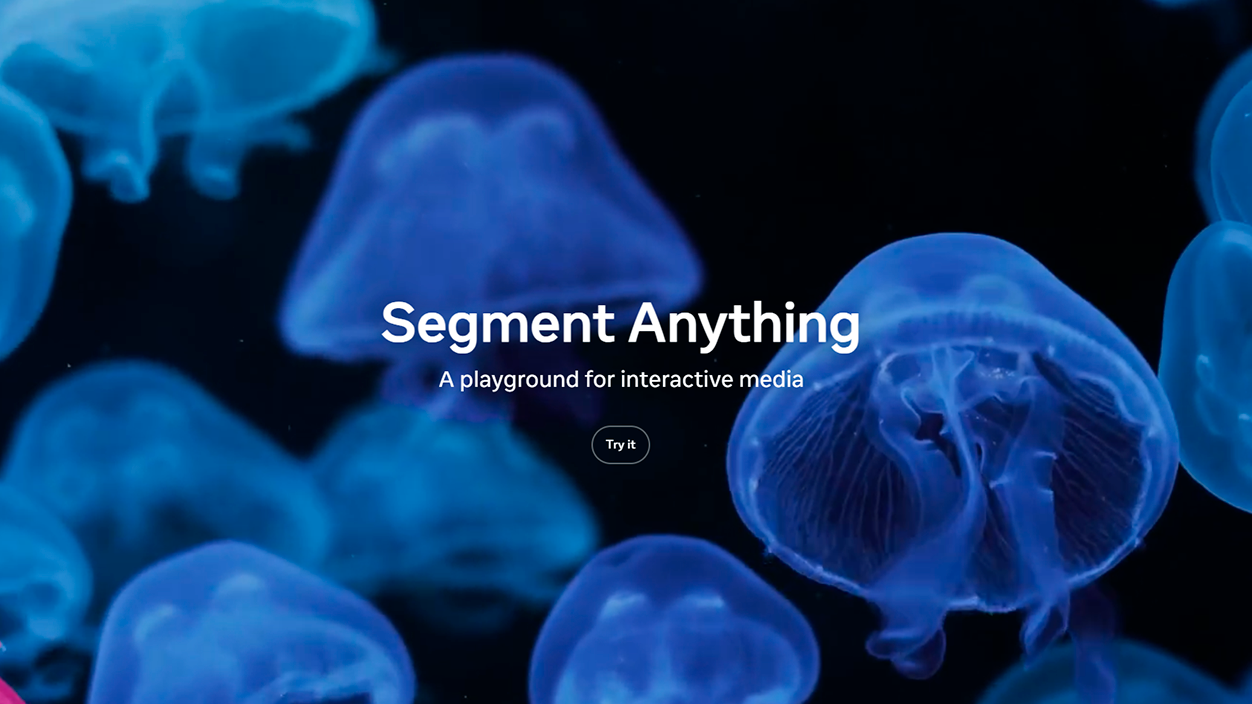

- Моделі можна тестувати без технічних знань у Segment Anything Playground за допомогою практичних та креативних шаблонів.

- Meta випускає ваги, контрольні точки та нові бенчмарки, щоб розробники та дослідники в Європі та решті світу могли інтегрувати ці можливості у свої проекти.

Meta зробила ще один крок у виконанні своїх зобов'язань штучний інтелект, застосований до комп'ютерного зору з Запуск SAM 3 та SAM 3D, дві моделі, що розширюють сімейство Segment Anything, і що Вони прагнуть змінити спосіб роботи з фотографіями та відео.Компанія аж ніяк не залишається лабораторним експериментом, а хоче, щоб ці інструменти використовувалися як професіоналами, так і користувачами без технічної освіти.

З цим новим поколінням Meta зосереджується на покращити виявлення та сегментацію об'єктів і, залучаючи тривимірна реконструкція для набагато ширшої аудиторіїВід відеомонтажу до візуалізації продуктів для електронної комерції в Іспанії та решті Європи, компанія передбачає сценарій, у якому Простого опису того, що ви хочете зробити, достатньо для того, щоб ШІ виконав більшу частину важкої роботи..

Що пропонує SAM 3 порівняно з попередніми версіями?

SAM 3 позиціонується як пряма еволюція моделей сегментації, представлених Meta у 2023 та 2024 роках, відомих як SAM 1 та SAM 2. Ці ранні версії зосереджувалися на визначенні того, які пікселі належать кожному об'єкту, головним чином за допомогою візуальних підказок, таких як точки, прямокутники або маски, а у випадку SAM 2 – відстеження об'єктів протягом усього відео майже в режимі реального часу.

Ключовою новою розробкою зараз є те, що SAM 3 розуміє насичені та точні текстові підказкине просто загальні позначення. У той час як раніше використовувалися прості терміни, такі як «автомобіль» чи «автобус», нова модель здатна реагувати на набагато конкретніші описи, наприклад, «жовтий шкільний автобус» або «червоний автомобіль припаркований подвійно».

На практиці це означає, що достатньо написати щось на кшталт "Червона бейсболка" щоб система могла знаходити та розділяти всі елементи, що відповідають цьому опису, на зображенні чи відео. Ця здатність уточнювати за допомогою слів особливо корисна в професійні редагування, реклама чи аналіз контенту, де часто доводиться звертати увагу на дуже конкретні деталі.

Крім того, SAM 3 був розроблений для інтеграції з великі мультимодальні мовні моделіЦе дозволяє вам виходити за рамки простих фраз і використовувати складні інструкції, такі як: «Люди сидять, але не носять червоних кепок» або «пішоходи, які дивляться в камеру, але без рюкзака». Цей тип інструкцій поєднує умови та винятки, які донедавна було важко перекласти в інструмент комп’ютерного зору.

Продуктивність та масштаб моделі SAM 3

Мета також хотіла виділити менш помітну, але важливу частину: технічна продуктивність та масштаб знань моделі. Згідно з даними компанії, SAM 3 здатний обробляти одне зображення з більш ніж сотнею виявлених об'єктів приблизно за 30 мілісекунд за допомогою графічного процесора H200, що є швидкістю, дуже близькою до необхідної для вимогливих робочих процесів.

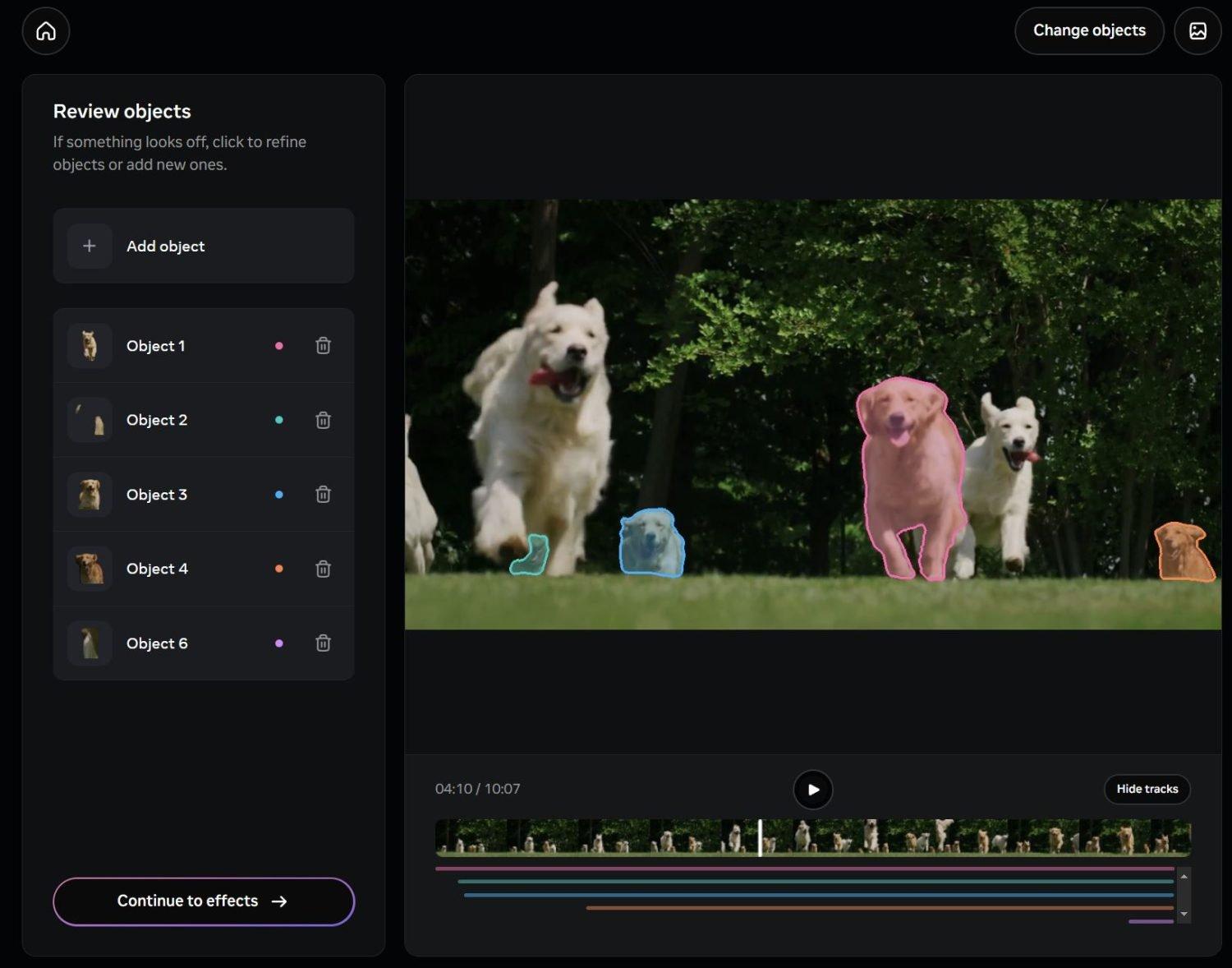

У випадку з відео, фірма запевняє, що система підтримує продуктивність. практично в режимі реального часу при роботі приблизно з п'ятьма одночасними об'єктами, що робить його придатним для відстеження та сегментації рухомого контенту, від коротких кліпів із соціальних мереж до більш амбітних виробничих проектів.

Щоб досягти такої поведінки, Meta створила тренувальну базу з більш ніж 4 мільйони унікальних концепційПоєднуючи людські анотатори з моделями штучного інтелекту для маркування великих обсягів даних, це поєднання ручного та автоматизованого контролю має на меті збалансувати точність і масштаб, що є ключовим для забезпечення того, щоб модель добре реагувала на різноманітні вхідні дані в європейському, латиноамериканському та інших ринкових контекстах.

Компанія вписує SAM 3 у те, що вона називає Колекція Segment AnythingСімейство моделей, бенчмарків та ресурсів, розроблених для розширення візуального розуміння ШІ. Запуск супроводжується новим бенчмарком для сегментації «відкритого словника», зосередженим на вимірюванні ступеня, до якого система може зрозуміти майже будь-яку концепцію, виражену природною мовою.

Інтеграція з Edits, Vibes та іншими інструментами Meta

Окрім технічної складової, Meta вже почала інтегрувати SAM 3 у певні продукти які призначені для щоденного використання. Одним із перших пунктів призначення будуть Редагування, їх додаток для створення та редагування відео, ідея якого полягає в тому, що користувач може вибрати певних людей або об'єкти за допомогою простого текстового опису та застосувати ефекти, фільтри або зміни лише до цих частин відеоматеріалу.

Ще один шлях для інтеграції можна знайти в Vibes, у застосунку Meta AI та на платформі meta.aiУ цьому середовищі сегментація тексту буде поєднуватися з генеративними інструментами для створення нових можливостей редагування та творчого досвіду, таких як користувацькі фони, ефекти руху або вибіркова модифікація фотографій, розроблена для соціальних мереж, які дуже популярні в Іспанії та решті Європи.

Пропозиція компанії полягає в тому, щоб ці можливості не обмежувалися професійним навчанням, а радше поширювалися... незалежні творці, невеликі агентства та досвідчені користувачі які щодня працюють з візуальним контентом. Можливість сегментувати сцени, пишучи описи природною мовою, зменшує криву навчання порівняно з традиційними інструментами, що базуються на ручних масках та шарах.

Водночас, Meta підтримує відкритий підхід до зовнішніх розробників, що свідчить про те, що сторонні програми – від інструментів редагування до рішень для відеоаналітики в роздрібній торгівлі чи безпеці – можуть покладатися на SAM 3, якщо дотримуються політики використання компанії.

SAM 3D: Тривимірна реконструкція з одного зображення

Інша велика новина полягає в тому, СЕМ 3Dсистема, призначена для виконання тривимірні реконструкції починаючи з 2D-зображень. Замість необхідності робити кілька знімків з різних ракурсів, модель прагне створити надійне 3D-зображення з однієї фотографії, що особливо цікаво для тих, хто не має спеціалізованого обладнання для сканування або робочих процесів.

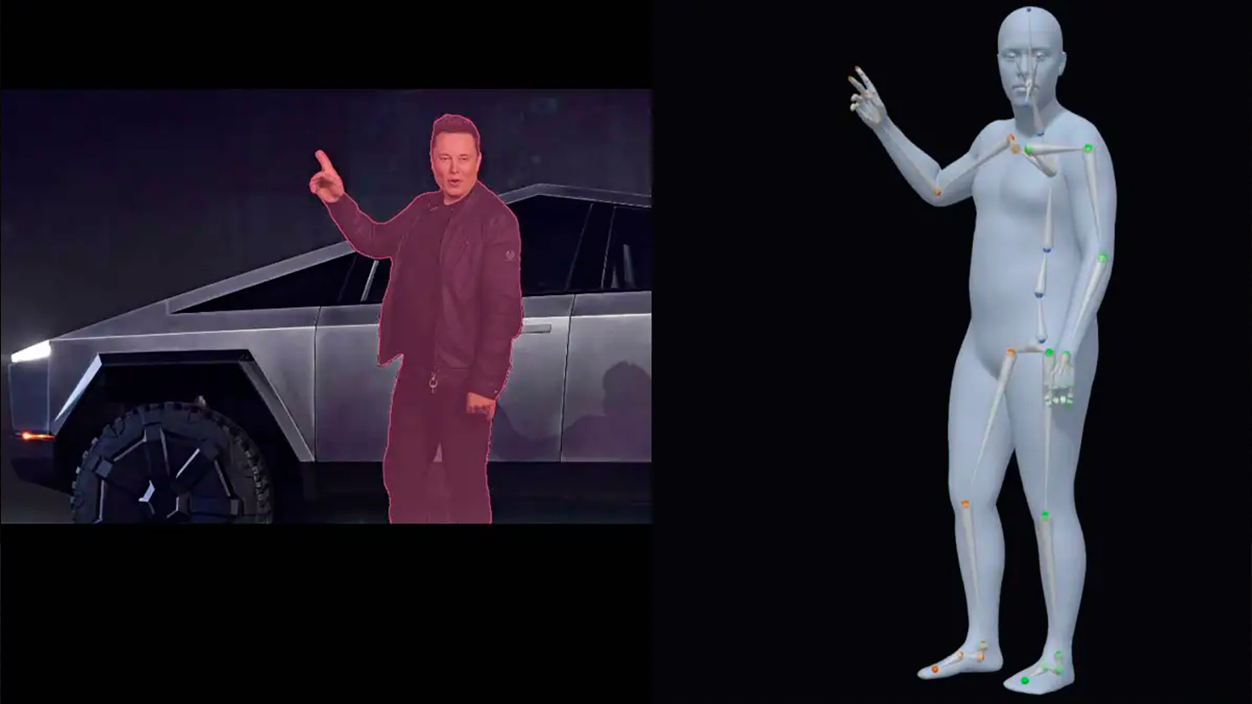

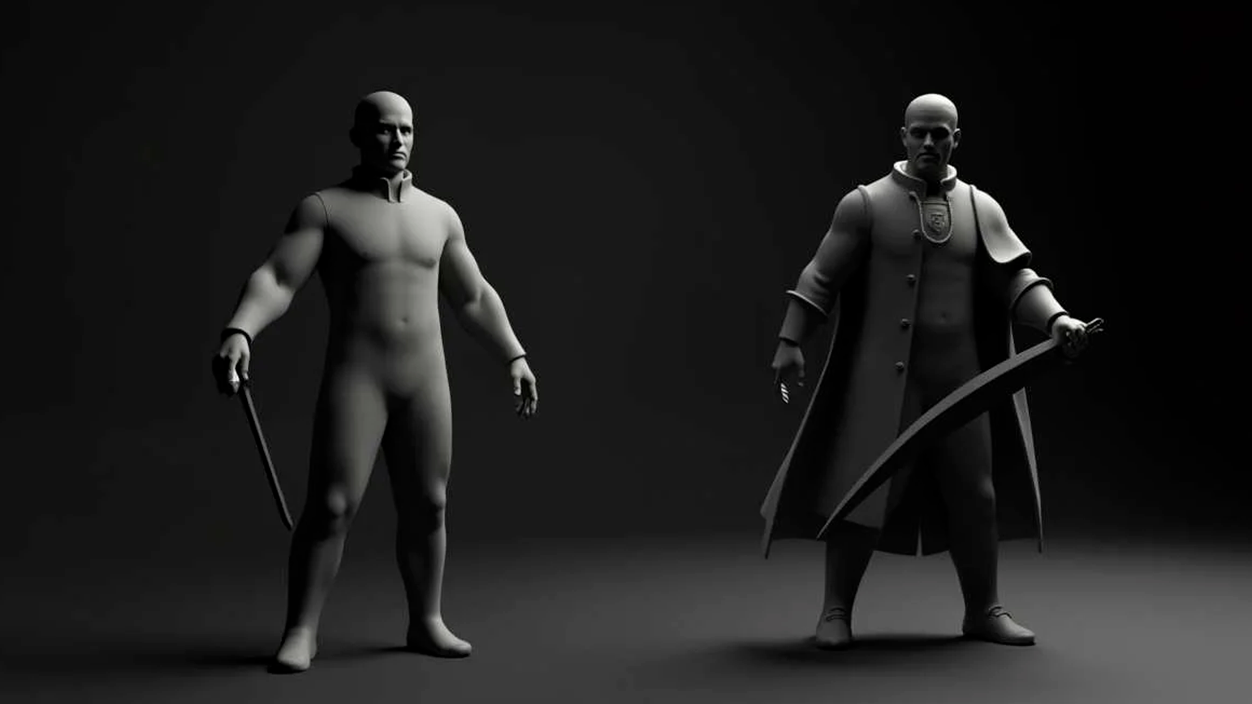

SAM 3D складається з двох моделей з відкритим кодом, які мають різні функції: 3D-об'єкти SAMзосереджений на реконструкції об'єктів та сцен, і SAM 3D Body, спрямований на оцінку форми та тіла людини. Такий поділ дозволяє адаптувати систему до дуже різних випадків використання, від каталогів продукції до застосувань у сфері охорони здоров'я чи спорту.

Згідно з Meta, SAM 3D Objects позначає Новий еталон продуктивності в 3D-реконструкції за допомогою штучного інтелектулегко перевершуючи попередні методи за ключовими показниками якості. Для більш ретельної оцінки результатів компанія співпрацювала з художниками над створенням SAM 3D Artist Objects – набору даних, спеціально розробленого для оцінки точності та деталізації реконструкцій широкого спектру зображень та об’єктів.

Цей прогрес відкриває шлях до практичного застосування в таких галузях, як робототехніка, наука, спортивна медицина або цифрова креативністьНаприклад, у робототехніці це може допомогти системам краще зрозуміти об'єм об'єктів, з якими вони взаємодіють; у медичних чи спортивних дослідженнях це може допомогти проаналізувати поставу та рухи тіла; а в креативному дизайні це служить основою для створення 3D-моделей для анімації, відеоігор або захопливих вражень.

Одним з перших комерційних застосувань, які вже видно, є функція "Вид у номері" de Маркетплейс Facebookщо дозволяє вам візуалізувати, як виглядатиме предмет меблів або декору в реальній кімнаті, перш ніж купувати його. За допомогою SAM 3D, Мета прагне вдосконалити цей тип досвіду, що є надзвичайно актуальним для європейської електронної комерції, де повернення товарів через невиконані очікування тягне за собою зростаючі витрати.

Дитячий майданчик Segment Anything: середовище для експериментів

Щоб дозволити громадськості протестувати ці можливості без встановлення будь-чого, Meta увімкнула Дитячий майданчик Segment AnythingЦе веб-платформа, яка дозволяє завантажувати зображення або відео та експериментувати з SAM 3 та SAM 3D безпосередньо з вашого браузера. Ідея полягає в тому, що кожен, хто цікавиться візуальним штучним інтелектом, може дослідити його можливості без будь-яких знань програмування.

У випадку SAM 3, ігровий майданчик дозволяє сегментувати об'єкти за допомогою короткі фрази або детальні інструкціїПоєднання тексту та, за бажанням, візуальних прикладів. Це спрощує поширені завдання, такі як вибір людей, автомобілів, тварин або певних елементів сцени та застосування до них певних дій, від естетичних ефектів до розмиття або заміни фону.

Під час роботи з SAM 3D платформа дає змогу Досліджуйте сцени з нових ракурсівпереставляти об'єкти, застосовувати тривимірні ефекти або створювати альтернативні вигляди. Для тих, хто працює в дизайні, рекламі або 3D-контенті, це пропонує швидкий спосіб прототипування ідей без необхідності використовувати складні технічні інструменти з самого початку.

Дитячий майданчик також включає серію Готові до використання шаблони Ці функції орієнтовані на виконання дуже специфічних завдань. Вони включають практичні опції, такі як пікселізація облич або номерних знаків з міркувань конфіденційності, а також візуальні ефекти, такі як сліди руху, вибіркові виділення або прожектори на областях, що цікавлять відео. Ці типи функцій можуть бути особливо корисними для робочих процесів цифрових медіа та творців контенту в Іспанії, де виробництво коротких відео та контенту для соціальних мереж є постійним процесом.

Відкриті ресурси для розробників та дослідників

Відповідно до стратегії, якої Meta дотримувалася в інших релізах ШІ, компанія вирішила випустити значну частину технічні ресурси, пов'язані з SAM 3 та SAM 3DПо-перше, оприлюднено ваги моделі, новий бенчмарк, зосереджений на сегментації відкритого словника, та технічний документ, що детально описує його розробку.

У випадку SAM 3D доступні наступні можливості: контрольні точки моделі, код виведення та набір даних для оцінювання наступного покоління. Цей набір даних містить значну різноманітність зображень та об'єктів, що спрямовані на вихід за рамки традиційних 3D-опорних точок, забезпечуючи більший реалізм та складність, що може бути дуже корисним для європейських дослідницьких груп, що працюють у галузі комп'ютерного зору та графіки.

Meta також оголосила про співпрацю з платформами для анотацій, такими як Roboflow, з метою надання розробникам та компаніям можливості Введіть власні дані та налаштуйте SAM 3 відповідно до конкретних потреб. Це відкриває шлях до галузевих рішень, від промислової інспекції до аналізу міського руху, включаючи проекти культурної спадщини, де важливо точно сегментувати архітектурні чи художні елементи.

Обираючи відносно відкритий підхід, компанія прагне забезпечити, щоб екосистема розробників, університети та стартапи – зокрема ті, що працюють в Іспанії та решті Європи, – можуть експериментувати з цими технологіями, інтегрувати їх у власні продукти та, зрештою, створювати варіанти використання, що виходять за рамки тих, які Meta може розробляти самостійно.

За допомогою SAM 3 та SAM 3D, Meta прагне консолідувати гнучкіша та доступніша візуальна платформа штучного інтелектуде сегментація з використанням тексту та 3D-реконструкція з одного зображення більше не є можливостями, доступними лише вузькоспеціалізованим командам. Потенційний вплив поширюється від повсякденного відеомонтажу до передових застосувань у науці, промисловості та електронній комерції, в контексті, де поєднання мови, комп'ютерного зору та креативності стає стандартним робочим інструментом, а не просто технологічною обіцянкою.

Я ентузіаст технологій, який перетворив свої "гікові" інтереси на професію. Я провів понад 10 років свого життя, користуючись передовими технологіями та возячись із усіма видами програм із чистої цікавості. Зараз я спеціалізуюся на комп’ютерних технологіях та відеоіграх. Це тому, що більше 5 років я писав для різних веб-сайтів про технології та відеоігри, створюючи статті, які прагнуть надати вам необхідну інформацію мовою, зрозумілою для всіх.

Якщо у вас є запитання, я знаю все, що стосується операційної системи Windows, а також Android для мобільних телефонів. І я зобов’язаний перед вами, я завжди готовий витратити кілька хвилин і допомогти вам вирішити будь-які запитання, які можуть виникнути в цьому світі Інтернету.