- Modelo rápido y económico para codificación agéntica con trazas visibles y contexto 256k.

- Acceso vía SDK gRPC de xAI o REST con OpenRouter/CometAPI, con ACLs y caché.

- Llamada de funciones y salidas JSON para flujos de test-fix, CI e IDE.

- Mejores prácticas: prompts claros, iteración corta, seguridad y métricas.

Los desarrolladores que buscan acelerar su flujo de trabajo encuentran en Grok Code Fast 1 un aliado de primer nivel, ya que combina velocidad, coste competitivo y trazas de razonamiento visibles que permiten guiar al modelo con precisión mientras se itera sobre código complejo.

Más allá del marketing, lo potente es que este modelo de xAI está pensado para codificación agéntica real: planifica, invoca herramientas y estructura salidas para integrarse con IDE, pipelines y servicios REST compatibles; todo ello sosteniendo una gran ventana de contexto que evita recortes en bases de código largas.

Qué es Grok Code Fast 1 y por qué importa

Grok Code Fast 1 (modelo grok-code-fast-1) es una variante enfocada de la familia Grok de xAI orientada a tareas de desarrollo: genera funciones, optimiza algoritmos, integra sistemas y, sobre todo, actúa como un “pair programmer” con herramientas (búsqueda, pruebas, edición de archivos) y razonamiento transmisible para inspección durante la ejecución.

Esta especialización prioriza dos ejes: latencia interactiva para usos dentro del editor/CI y eficiencia de costes por token para trabajo de alto volumen. Frente a LLM generalistas, su objetivo no es la multimodalidad total, sino clavar el ciclo del dev: leer, proponer, probar y repetir con mínima fricción.

La plataforma destaca por exponer rastros de razonamiento en streaming y por soportar llamadas de funciones y salidas estructuradas (JSON). En la práctica, esto facilita automatizar bucles de varios pasos (buscar → editar → test → validar) con control y trazabilidad a nivel de tokens.

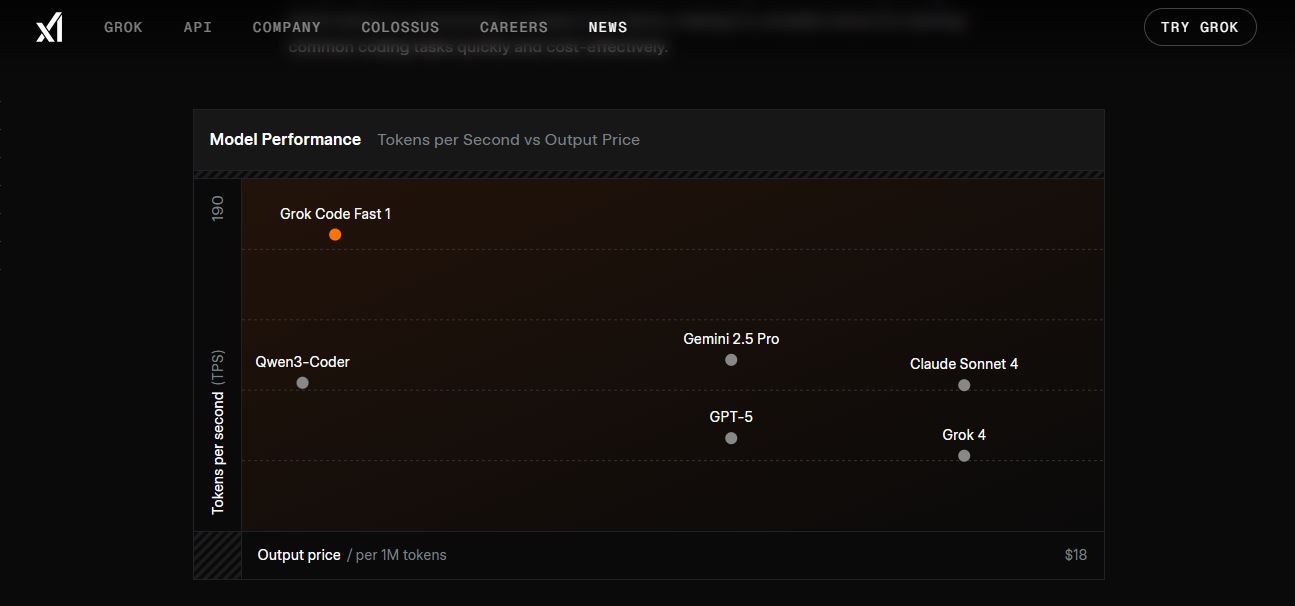

En términos de rendimiento, se han observado cifras como ≈190 tokens/segundo, tiempos instantáneos para completar líneas, menos de 1 s para funciones de 5-10 líneas, cerca de 2-5 s para componentes de 50+ líneas y 5-10 s para refactorizaciones grandes. Según referencias compartidas, supera modelos tipo LLaMA en HumanEval y roza un 70,8% en benchmarks como SWE-Bench-Verified.

Diseño técnico que posibilita la velocidad

El modelo admite una ventana de contexto de hasta 256.000 tokens, útil para ingerir repositorios, documentación y largas conversaciones sin truncamientos, reduciendo reenvíos redundantes de contexto.

La plataforma implementa caché de prefijos: cuando iteras con el mismo prompt base, los tokens cacheados reducen coste y latencia (precio de token cacheado inferior), algo clave en flujos agénticos de múltiples pasos.

Además, la API de Grok soporta definiciones de herramientas/funciones estructuradas para ser llamadas durante el razonamiento; esto evita hacks frágiles, simplifica el parsing y permite coordinar varias herramientas con mayor fiabilidad.

Operativamente, el servicio se aloja en la región us-east-1, algo a tener en cuenta si optimizas latencias en Norteamérica o balanceas entre proveedores y regiones.

Precios, límites y disponibilidad

El modelo se factura por uso con tarifas publicadas como $0,20/M tokens de entrada, $1,50/M tokens de salida y $0,02/M tokens en caché. Este esquema favorece sesiones largas con prefijos constantes y múltiples iteraciones.

Los límites por defecto reportados son 480 solicitudes por minuto y 2.000.000 de tokens por minuto. Con ellos se evita abuso a la vez que se habilita un uso intensivo a escala de equipo o CI.

A diferencia de otros modelos, Grok Code Fast 1 no incorpora búsqueda en vivo: debes aportar el conocimiento y los datos relevantes en el prompt o mediante herramientas definidas en tu orquestación.

En listados de terceros y foros se citan comparativas de coste frente a modelos más grandes (p. ej., GPT-5 salida ≈ $18/M tokens frente a $1,50/M de Grok CF1), lo que refuerza su posicionamiento en tareas de desarrollo de alto volumen.

Requisitos previos para acceder

Antes de lanzar la primera petición, necesitarás una cuenta vinculada a X (xAI autentica con credenciales X), y un entorno con Python 3.8+, pip y soporte de variables de entorno para gestionar tu clave con seguridad.

Para el acceso directo, xAI prioriza SDK y comunicaciones gRPC, lo que mejora el rendimiento; si prefieres REST, puedes usar OpenRouter o pasarelas como CometAPI que exponen endpoints compatibles con OpenAI.

En la generación de claves conviene definir ACLs estrictas (por ejemplo, permiso sampler:write) para limitar acciones; así reduces superficie de riesgo si una credencial se filtra o un entorno se compromete.

Al terminar la configuración, ejecuta una verificación rápida del SDK para confirmar conectividad y permisos. Si falla, revisa red, ACLs y versión del paquete.

Crear la clave de API en PromptIDE (xAI)

Accede a ide.x.ai con tu cuenta de X, abre el menú de perfil y entra en «API Keys». Desde ahí, pulsa «Create API Key» y personaliza las ACL según lo que vayas a hacer con el modelo (desde finalizaciones básicas a llamadas avanzadas de herramientas).

La clave se muestra una sola vez, cópiala y guárdala a buen recaudo. Se recomienda almacenarla en una variable de entorno XAI_API_KEY para evitar hardcodear secretos en repositorios.

Más tarde podrás revocar, rotar o ajustar permisos desde el mismo panel si lo necesitas, por ejemplo si detectas uso anómalo o cambian los flujos de trabajo.

Para una comprobación express, algunos SDK exponen métodos tipo does_it_work(); úsalo para asegurarte de que la autenticación y el alcance son correctos antes de invertir tiempo en integrar.

Instalación y configuración del SDK de xAI

Instala el SDK con pip install xai-sdk, exporta la variable de entorno con tu clave (export XAI_API_KEY=…) y crea una instancia de Client() en tu aplicación para comenzar.

El SDK se encarga de gestionar gRPC de forma transparente, soporta operaciones asíncronas de alto rendimiento y permite seleccionar el modelo por nombre, p. ej., «grok-code-fast-1».

Si algo no responde como esperabas, actualiza paquetes (pip), revisa conectividad corporativa y verifica los scopes de la clave; muchas incidencias provienen de permisos insuficientes.

Una vez operativo, podrás ajustar parámetros como temperatura o top_p para balancear creatividad frente a determinismo en tus flujos.

Acceso REST con OpenRouter y pasarelas de terceros

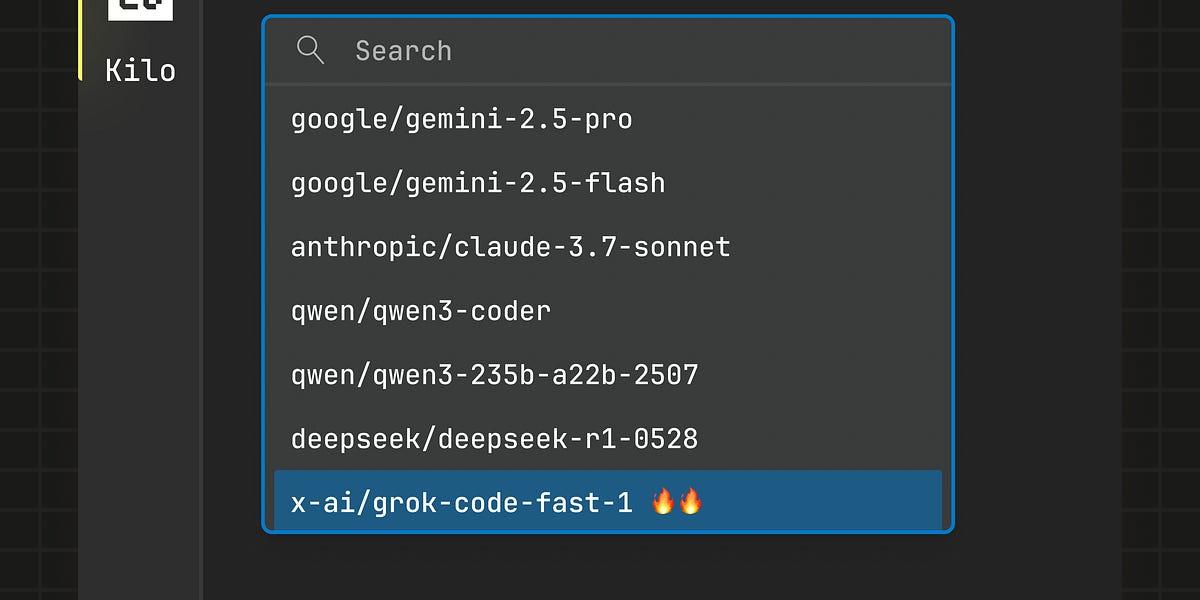

Si en tu infraestructura encaja mejor HTTP, OpenRouter expone una interfaz de estilo OpenAI con base «https://openrouter.ai/api/v1» y modelos como «x-ai/grok-code-fast-1». Solo tienes que inyectar tu clave y definir los mensajes.

Ejemplo con el SDK de OpenAI compatible, útil para normalizar parámetros entre proveedores y reutilizar tooling existente (añade cabeceras como HTTP-Referer si quieres trazabilidad de orígenes).

from openai import OpenAI

client = OpenAI(

base_url="https://openrouter.ai/api/v1",

api_key="<TU_CLAVE_OPENROUTER>"

)

resp = client.chat.completions.create(

model="x-ai/grok-code-fast-1",

messages=[

{"role": "user", "content": "Genera un algoritmo de ordenación con explicación rápida"}

]

)

print(resp.choices[0].message.content)

También hay proveedores como CometAPI que actúan de puente REST compatible con OpenAI y listan el mismo contexto 256k. Un ejemplo directo con requests podría verse así:

import os, requests

COMET_KEY = os.getenv("COMETAPI_API_KEY")

BASE = "https://api.cometapi.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {COMET_KEY}",

"Content-Type": "application/json",

}

payload = {

"model": "grok-code-fast-1",

"messages": [

{"role": "system", "content": "Eres Grok Code Fast 1, un asistente de código muy rápido."},

{"role": "user", "content": "Escribe una función en Python que fusione dos listas ordenadas."}

],

"max_tokens": 300,

"stream": False

}

resp = requests.post(BASE, json=payload, headers=headers)

resp.raise_for_status()

print(resp.json())

En estos escenarios, los precios anunciados por los agregadores suelen alinearse con xAI y sin recargos adicionales; confirma siempre la disponibilidad, límites y posibles colas por proveedor.

Uso avanzado: herramientas y salidas estructuradas

El modelo brilla en flujos agénticos donde puede invocar herramientas (tests, linters, grep, git) y mezclar sus resultados con el plan de acción. Define tus herramientas con nombre, descripción y parámetros para que el motor decida cuándo llamarlas.

Si necesitas respuestas procesables, activa el modo JSON (response_format tipo json_object) y diseña esquemas tipados para diffs, resúmenes o planes de refactorización; esto simplifica la validación automática.

Valida siempre lo que retornen tus herramientas (p. ej., salida de tests), captura errores y aplica backoff exponencial si topas con límites de tasa. El objetivo es que el bucle planificar → ejecutar → verificar sea estable.

Gracias a la ventana 256k y la caché de prefijos, puedes mantener conversaciones largas por archivo o repo sin perder contexto ni disparar costes por token repetido.

Integración con IDE y servicios: Copilot, Cursor, Cline, Kilo Code

Grok Code Fast 1 ya aparece en integraciones con IDE y herramientas de terceros. Se citan vistas previas en GitHub Copilot y presencia en soluciones como Cursor o Cline, incluso con periodos promocionales gratuitos.

Según el changelog de GitHub (26/08/2025), Copilot anunció un acceso gratuito en vista previa hasta el 10 de septiembre de 2025 (PDT); en algunas guías se mencionan fechas cercanas (incluso 2/09) y, por momentos, el modelo siguió marcado como gratis en la interfaz. Lo prudente es verificar dentro del selector de modelo del IDE para confirmar el estado actual.

Otros socios, como Kilo Code (extensión para VS Code), han comunicado acceso gratuito por tiempo limitado (mínimo una semana de lanzamiento), con uso sin límites aparentes a cambio de optar por compartir datos de uso para mejorar el modelo.

En cualquier caso, si tu equipo ya usa Copilot/Cursor/Cline, merece la pena probar la suscripción voluntaria o BYOK (trae tu propia clave) y medir latencias y calidad en tus repos reales.

Patrones de integración recomendados

- IDE-first: emplea prompts cortos que pidan cambios pequeños y comprobables (genera un parche, ejecuta tests, reitera). Mantén el loop cerrado para acortar el tiempo de feedback.

- Automatización de CI: clasifica fallos, sugiere fixes, o genera pruebas unitarias nuevas; por precio/latencia, Grok CF1 encaja bien en ejecuciones frecuentes.

- Orquestación de agentes: habilita herramientas con guardarraíles; ejecuta parches en entornos de pruebas; exige revisión humana en cambios sensibles; usa reasoning visible para auditar el plan.

- Consejos rápidos: pasa archivos exactos o ventanas acotadas, prefiere formatos tipados (JSON/diff), registra llamadas y resultados para reproducibilidad.

Despliegue por fases en equipos

Sigue un plan de adopción: semanas 1-2, pruebas individuales; 3-4, pilotos de bajo riesgo; 5-6, define procesos y plantillas; 7-8, despliegue amplio con métricas.

Incluye una lista de control de calidad: ¿compila sin errores? ¿hay riesgos de seguridad obvios? ¿cumple estándares de estilo y mantenibilidad?

Evita sesgos comunes: no delegues pensamiento crítico, no omitas testing, no ignores seguridad ni dejes prompts vagos sin contexto.

Mide impacto con métricas de velocidad (tiempo por tarea, errores corregidos/sesión), calidad (tasa de bugs, mantenibilidad) y aprendizaje (mejores prácticas asimiladas).

Notas sobre acceso gratuito y disponibilidad

Varias fuentes señalan periodos de acceso gratuito temporal en integraciones (Copilot, Cursor, Cline, Kilo Code). Se citan ventanas como del 26/08 al 10/09/2025 (PDT) en Copilot, o promociones de al menos una semana en socios de lanzamiento.

Dado que estas ventanas cambian, comprueba el selector de modelo en tu IDE o la documentación del proveedor. Si el modelo aparece como gratis, aprovéchalo para evaluar latencia, calidad y coste antes de un uso extensivo.

Si te quedas con una idea: Grok Code Fast 1 está construido para trabajar como un asistente de código ágil, con trazas de razonamiento, herramientas y salidas estructuradas; si planificas prompts claros, aprovechas la caché y blindas la integración con ACLs y pruebas, puedes acelerar entregas sin disparar el gasto y con control granular sobre cada paso.

Redactor especializado en temas de tecnología e internet con más de diez años de experiencia en diferentes medios digitales. He trabajado como editor y creador de contenidos para empresas de comercio electrónico, comunicación, marketing online y publicidad. También he escrito en webs de economía, finanzas y otros sectores. Mi trabajo es también mi pasión. Ahora, a través de mis artículos en Tecnobits, intento explorar todas las novedades y nuevas oportunidades que el mundo de la tecnología nos ofrece día a día para mejorar nuestras vidas.