- GPT-5-Codex especializa GPT-5 para flujos de ingeniería agentivos: planifica, prueba y corrige hasta entregar PR verificables.

- Integra CLI, IDE y GitHub, con razonamiento dinámico de segundos a horas y ahorro de tokens en turnos breves.

- Mejora en benchmarks como SWE-bench Verified y aporta controles de seguridad, aunque requiere revisión humana.

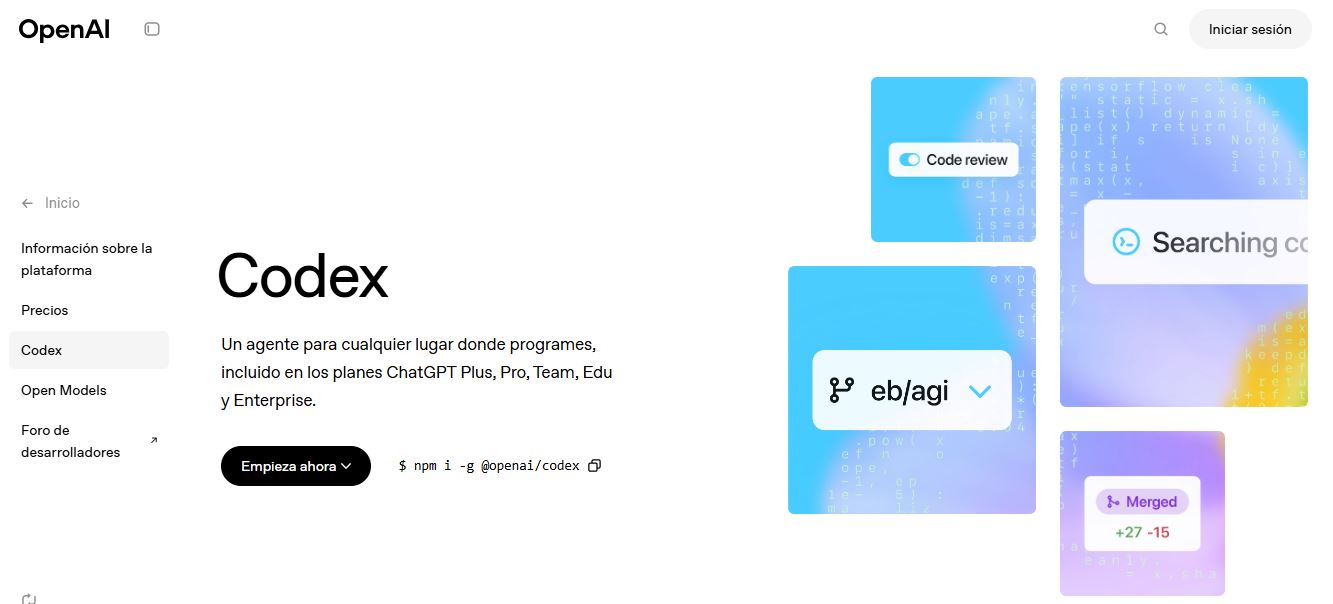

- Accesible en productos Codex/ChatGPT; API “próximamente”, con opciones multivendor como CometAPI y herramientas como Apidog.

En el ecosistema de herramientas de desarrollo asistidas por IA, GPT-5-Codex emerge como la apuesta de OpenAI para llevar la ayuda a la codificación a un plano realmente agentivo, capaz de planificar, ejecutar, probar y pulir cambios de código dentro de flujos reales.

No se trata de otro autocompletado más: su propuesta va de resolver tareas completas, encajar en PR y pasar baterías de tests, con un comportamiento más cercano al de un compañero técnico que al de un simple asistente conversacional. Ese es el tono de esta nueva iteración: más fiable, más práctica y pensada para las rutinas de ingeniería del día a día.

¿Qué es GPT-5-Codex y por qué existe?

GPT‑5‑Codex es, en esencia, una especialización de GPT‑5 centrada en la ingeniería de software y en flujos agentivos. En lugar de priorizar la charla general, su entrenamiento y ajuste con refuerzo se enfocan en ciclos de “generar → ejecutar pruebas → corregir → repetir”, en redactar PR y refactorizar con criterio, y en seguir convenciones de proyecto. OpenAI lo posiciona como heredero de las iniciativas Codex previas, pero apoyado en la base de razonamiento y escalado de GPT‑5 para profundizar en tareas multiarchivo y procesos de varios pasos con mayor fiabilidad.

La motivación es pragmática: los equipos necesitan algo que vaya más allá de sugerir un snippet aislado. La propuesta de valor está en pasar de “te escribo una función” a “te entrego una característica con tests que pasan”, con un modelo que comprende la estructura del repo, aplica parches, re‑lanza pruebas y deja una PR legible y alineada con las normas de la casa.

Cómo está diseñado y entrenado: arquitectura y optimizaciones

En lo arquitectónico, GPT‑5‑Codex hereda la base transformadora de GPT‑5 (propiedades de escalado, mejoras de razonamiento) y suma un ajuste específico para ingeniería. El entrenamiento se centra en escenarios reales: refactorizaciones multiarchivo, ejecución de suites de pruebas, sesiones de depuración y revisión con señales de preferencia humana, de modo que el objetivo no es solo generar texto correcto, sino maximizar ediciones precisas, tests aprobados y feedback de revisión útil.

La capa “agentiva” es clave. El modelo aprende a decidir cuándo invocar herramientas, cómo incorporar salidas de pruebas a sus siguientes pasos, y cómo cerrar el ciclo entre síntesis y verificación. Se entrena en trayectorias en las que emite acciones (p. ej., “ejecutar prueba X”), observa resultados y condiciona su generación posterior, lo que permite un comportamiento coherente en secuencias largas.

Entrenamiento impulsado por ejecución y RLHF aplicado a código

A diferencia de un ajuste genérico de chat, el refuerzo incorpora la ejecución real del código y la validación automática. Los bucles de feedback proceden tanto de los resultados de las pruebas como de preferencias humanas, abordando la asignación de crédito temporal en secuencias de varios pasos (crear PR, ejecutar suites, corregir fallos). El contexto escala a tamaño repositorio, para aprender dependencias, convenciones de nombres y efectos transversales en la base de código.

Este enfoque con “entornos instrumentados” permite que el modelo interiorice prácticas de ingeniería (por ejemplo, mantener el comportamiento en refactorizaciones grandes, escribir diferencias claras, o seguir la etiqueta de PR estándar), lo que reduce la fricción al integrarse en equipos que ya operan con CI y revisiones formales.

Uso de herramientas y coordinación con el entorno

Históricamente, Codex combinaba su salida con un runtime ligero que podía abrir archivos o lanzar pruebas. En GPT‑5‑Codex, esa coordinación se intensifica: aprende cuándo y cómo llamar a herramientas y “lee” de vuelta los resultados, cerrando el círculo entre el plano del lenguaje y la validación programática. En la práctica, eso se traduce en menos intentos a ciegas y más iteración informada por el feedback del sistema de pruebas.

Qué puede hacer: capacidades y “tiempo de pensamiento” adaptativo

Una de las apuestas diferenciales es la duración de razonamiento variable: solicitudes triviales responden rápido y barato, mientras que una refactorización compleja puede abrir una ventana de “pensamiento” prolongada para estructurar el cambio, aplicar parches y re‑probar. En turnos cortos, además, consume muchos menos tokens que GPT‑5 general, con ahorros de hasta el 93,7 % en tokens en interacciones pequeñas, lo que ayuda a contener costes.

En cuanto a funciones, arranca proyectos con scaffolding completo (CI, pruebas, docs), ejecuta ciclos de prueba‑reparación de manera autónoma, aborda refactorizaciones multiarchivo manteniendo comportamiento, redacta descripciones de PR con cambios bien presentados y razona a través de gráficos de dependencias y límites de API con más solidez que un modelo genérico de chat.

Cuando trabaja en la nube, admite entradas y salidas visuales: puede recibir capturas de pantallas y adjuntar artefactos (por ejemplo, screenshots de la UI resultante) a las tareas, algo muy útil en depuración front‑end y QA visual. Ese vínculo visual‑código es especialmente práctico para validar diseños o verificar que una regresión gráfica se ha corregido.

Integraciones en el flujo de trabajo: CLI, IDE y GitHub/Cloud

Codex no se queda en el navegador. La Codex CLI se ha rediseñado en torno a flujos agentivos, con adjuntos de imágenes, lista de tareas, soporte para herramientas externas (búsqueda web, MCP), una interfaz de terminal mejorada y un modo de permisos simplificado a tres niveles (solo lectura, automático y acceso completo). Todo pensado para hacer más fiable la colaboración con el agente desde la terminal.

En el editor, la extensión de Codex para IDE integra el agente en VS Code (y forks) para previsualizar diffs locales, mover tareas entre la nube y el entorno local conservando el contexto, e invocar al modelo con el archivo actual a la vista. Ver y manipular resultados en el propio editor reduce cambios de contexto y acelera iteraciones.

En la nube y en GitHub, las tareas pueden revisar PR automáticamente, levantar contenedores efímeros y adjuntar logs y capturas a los hilos de revisión. La infraestructura mejorada aporta grandes recortes en latencia gracias al caché de contenedores, con reducciones de tiempo del orden del 90 % en algunas tareas repetitivas.

Limitaciones y en qué terrenos rinde mejor o peor

La especialización tiene su precio: en evaluaciones no relacionadas con código, GPT‑5‑Codex puede rendir algo por debajo de GPT‑5 generalista. Y su comportamiento agentivo está acoplado a la calidad del set de pruebas: en repos con poca cobertura, la verificación automática flaquea y la supervisión humana vuelve a ser indispensable.

Destaca en refactorizaciones complejas, scaffolding de proyectos grandes, escritura y corrección de tests, seguimiento de expectativas de PR y diagnóstico de fallos multiarchivo. Es menos adecuado donde hace falta conocimiento privado no incluido en el workspace o en ámbitos de “cero errores” sin revisión humana (crítico en seguridad), donde la prudencia manda.

Rendimiento: benchmarks y resultados reportados

En pruebas con enfoque agentivo como SWE‑bench Verified, OpenAI reporta que GPT‑5‑Codex supera a GPT‑5 en tasa de éxito sobre 500 tareas de ingeniería de software reales. Parte del valor está en que la evaluación abarca casos más completos (ya no solo 477, sino 500 tareas probables), y en mejoras visibles en métricas de refactorización extraídas de repos grandes. Se citan saltos notables en determinados indicadores de alta verbosidad, si bien se advierte de matices de reproducibilidad y configuración de pruebas.

La lectura crítica sigue siendo obligatoria: las diferencias de subconjuntos, la verbosidad y los costes pueden sesgar comparaciones. Aun así, el patrón que se repite en reseñas independientes es que el comportamiento agentivo ha dado un salto, y que las fortalezas en refactorización no siempre se traducen a mejor precisión “en crudo” en todas las tareas.

Acceso hoy: dónde usar GPT-5-Codex

OpenAI ha integrado GPT‑5‑Codex en las experiencias de producto de Codex: CLI, extensión IDE, nube e hilos de revisión en GitHub, además de su presencia en la app de ChatGPT para iOS. En paralelo, la compañía ha señalado disponibilidad para suscriptores Plus, Pro, Business, Edu y Enterprise dentro del ecosistema Codex/ChatGPT, con el acceso por API anunciado como “próximamente” más allá de los flujos nativos de Codex.

Para quien arranque vía API, la llamada sigue el patrón habitual de SDK. Un ejemplo básico en Python tendría este aspecto:

import openai

openai.api_key = "tu-api-key"

resp = openai.ChatCompletion.create(

model="gpt-5-codex",

messages=[{"role":"user","content":"Genera una función en Python para ordenar una lista."}]

)

print(resp.choices[0].message.content)También se menciona la disponibilidad a través de proveedores compatibles con la API de OpenAI, y que la tarificación sigue un esquema por tokens con condiciones empresariales específicas según planes. Herramientas como Apidog ayudan a simular respuestas y probar casos extremos sin consumo real, facilitando documentación (OpenAPI) y generación de clientes.

VS Code mediante GitHub Copilot: vista previa pública

En Visual Studio Code, el acceso llega a través de Copilot en vista previa pública (requisitos de versión y plan aplican). Los administradores lo activan a nivel de organización (Business/Enterprise) y usuarios Pro pueden seleccionarlo en Copilot Chat. Los modos agentivos de Copilot (preguntar, editar, agente) se benefician de la persistencia y autonomía del modelo para depurar scripts paso a paso y proponer soluciones.

Conviene recordar que la implementación se libera de forma gradual, por lo que no todos los usuarios la ven a la vez. Complementariamente, Apidog proporciona pruebas de API desde VS Code, útil para asegurar integraciones robustas sin costes ni latencias de producción.

Seguridad, controles y salvaguardas

OpenAI enfatiza múltiples capas: entrenamiento de seguridad para resistir inyecciones e impedir conductas de riesgo, y controles de producto como ejecución por defecto en entornos aislados, acceso a red configurable, modos de aprobación de comandos, registros de terminal y citaciones para trazabilidad. Estas barreras son lógicas cuando un agente puede instalar dependencias o ejecutar procesos.

Hay, además, limitaciones conocidas que requieren supervisión humana: no sustituye a los revisores, los benchmarks tienen letra pequeña, y los LLM pueden alucinar (URLs inventadas, dependencias mal interpretadas). Validar con pruebas y una pasada humana sigue siendo innegociable antes de llevar cambios a producción.

Tiempo de razonamiento dinámico: de segundos a siete horas

Una de las afirmaciones más llamativas es la capacidad de ajustar el esfuerzo computacional en tiempo real: desde contestar en segundos para peticiones pequeñas hasta dedicar varias horas a tareas complejas y frágiles, reintentando pruebas y corrigiendo fallos. A diferencia de un enrutador que decide a priori, el propio modelo puede reasignar recursos minutos después si detecta que la tarea lo exige.

Este enfoque convierte a Codex en un colaborador más eficaz en trabajos largos e inestables (grandes refactorizaciones, integraciones de varios servicios, depuración extendida), algo que hasta ahora quedaba fuera del alcance de los autocompletados tradicionales.

CometAPI y acceso multivendor

Para equipos que quieren evitar el bloqueo de proveedor y moverse rápido, CometAPI ofrece una única interfaz para más de 500 modelos (OpenAI GPT, Gemini, Claude, Midjourney, Suno y más), unificando autenticación, formato y manejo de respuestas. La plataforma se compromete a incorporar GPT‑5‑Codex en paralelo a su lanzamiento oficial, además de exponer GPT‑5, GPT‑5 Nano y GPT‑5 Mini, con un Playground y guía de API para acelerar pruebas.

Este enfoque permite iterar sin rehacer integraciones cada vez que llega un modelo nuevo, controlar costes y mantener independencia. Mientras tanto, se invita a explorar otros modelos en el Playground y a revisar la documentación para una adopción ordenada.

Más novedades de producto: revisiones, front‑end y CLI

OpenAI indica que GPT‑5‑Codex se ha entrenado específicamente para revisar código y detectar fallos críticos, escaneando el repo, ejecutando el código y las pruebas y validando correcciones. En evaluaciones con repos populares y expertos humanos, se observa menor proporción de comentarios incorrectos o irrelevantes, lo que ayuda a centrar la atención.

En front‑end, se reporta un desempeño fiable y mejoras en preferencias humanas en la creación de sitios móviles. En escritorio, puede generar aplicaciones atractivas. La CLI de Codex se ha reconstruido para flujos agentivos, con adjuntos de imágenes para decisiones de diseño, lista de tareas y mejor formateo de llamadas a herramientas y diffs; además, integra búsqueda web y MCP para conectar con datos/herramientas externas de forma segura.

Accesibilidad, planes y despliegue gradual

El modelo está desplegado en terminales, IDE, GitHub y ChatGPT para usuarios Plus/Pro/Business/Edu/Enterprise, con la API planeada para más adelante. No se detallan diferencias finas de límites por plan, y el acceso puede aparecer de forma escalonada, algo habitual en vistas previas y lanzamientos por oleadas.

En cuanto a costes, los precios siguen esquemas por tokens y niveles de uso; para empresas, la conversación suele pasar por Business/Pro y la evaluación de sesiones y cargas. Dado el “tiempo de pensamiento” variable, conviene definir políticas de ejecución y límites claros para evitar sorpresas.

Para pruebas y validación, Apidog encaja bien al simular respuestas, importar especificaciones OpenAPI y facilitar la generación de clientes; y proveedores como OpenRouter ofrecen compatibilidad de API con rutas alternativas por coste o redundancia.

Mirando todo el conjunto, GPT‑5‑Codex consolida la transición de “autocompletar” a “entregar características”: un agente que piensa lo justo o lo necesario según la tarea, integrado en las herramientas diarias, con seguridad por capas y una orientación clara a resultados verificables en ingeniería. Para equipos de todos los tamaños, es una oportunidad real de ganar velocidad sin renunciar a control y calidad.

Redactor especializado en temas de tecnología e internet con más de diez años de experiencia en diferentes medios digitales. He trabajado como editor y creador de contenidos para empresas de comercio electrónico, comunicación, marketing online y publicidad. También he escrito en webs de economía, finanzas y otros sectores. Mi trabajo es también mi pasión. Ahora, a través de mis artículos en Tecnobits, intento explorar todas las novedades y nuevas oportunidades que el mundo de la tecnología nos ofrece día a día para mejorar nuestras vidas.