- Ejecución 100 % local de MusicGen: privacidad, control y rapidez.

- Entorno preparado con Python, PyTorch, FFmpeg y Audiocraft.

- Optimiza rendimiento eligiendo tamaño de modelo y GPU adecuada.

- Flujo creativo completo sin depender de almacenamiento en la nube.

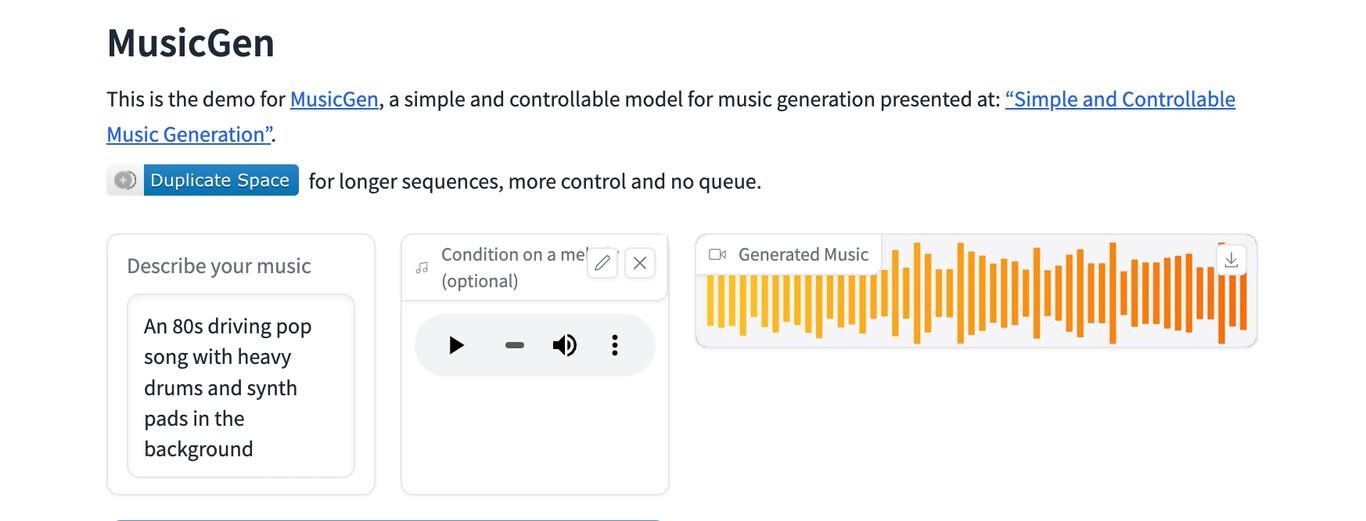

¿Cómo usar MusicGen de Meta en local? Generar música con inteligencia artificial sin depender de servicios externos es totalmente posible hoy en día. MusicGen de Meta puede funcionar íntegramente en tu ordenador, evitando subir muestras o resultados a la nube y manteniendo el control de tus datos en todo momento. Esta guía te acompaña desde cero para que lo consigas paso a paso, con recomendaciones prácticas, consideraciones de rendimiento y trucos que marcan la diferencia.

Una de las ventajas de trabajar en local es la libertad para experimentar sin límites de cuota, sin esperas por servidores saturados y con mayor privacidad. A diferencia de soluciones en la nube como los SDK de almacenamiento y autenticación pensados para apps móviles, aquí no necesitas delegar tu audio en terceros: los modelos, los prompts y las pistas generadas se quedan contigo.

Qué es MusicGen y por qué ejecutarlo en local

MusicGen es un modelo de generación musical desarrollado por Meta capaz de crear piezas a partir de descripciones de texto y, en algunas variantes, condicionar el resultado con una melodía de referencia. Su propuesta combina facilidad de uso con una sorprendente calidad musical, ofreciendo distintos tamaños de modelo para equilibrar fidelidad y consumo de recursos del equipo.

La ejecución en local tiene varias implicaciones clave. En primer lugar, la privacidad: tu voz, tus samples y tus composiciones no tienen que salir de tu máquina. En segundo lugar, la velocidad de iteración: no dependes del ancho de banda para subir archivos ni de un backend remoto. Y, por último, el control técnico: puedes fijar versiones de librerías, congelar pesos y trabajar desconectado sin sorpresas por cambios de API.

Conviene entender el contraste con las soluciones de almacenamiento en la nube. Por ejemplo, en el ecosistema de móviles, Firebase facilita a desarrolladores iOS y de otras plataformas guardar audio, imágenes y vídeo mediante SDK robustos, autenticación integrada y una pareja natural con Realtime Database para datos de texto. Este enfoque es ideal cuando necesitas sincronización, colaboración o publicación rápida. Pero si tu prioridad es no subir nada a servidores externos, ejecutar MusicGen en tu propio equipo evita ese paso por completo.

La comunidad también juega a tu favor. En espacios abiertos y no oficiales como r/StableDiffusion, se comparte y debate el estado del arte de herramientas creativas basadas en modelos generativos. Es un lugar para publicar piezas, resolver dudas, abrir debates, aportar tecnología y curiosear todo lo que se mueve en el mundillo. Esa cultura open source y exploratoria encaja genial con usar MusicGen en local: pruebas, iteras, documentas y ayudas a otros que vienen detrás. Tú decides el ritmo y el enfoque.

Si al investigar te topas con fragmentos técnicos ajenos al flujo musical —por ejemplo, bloques de estilos CSS con scope o snippets de front-end— recuerda que no son relevantes para generar sonido, pero aparecen a veces en páginas que recopilan recursos. Lo útil es centrarte en dependencias reales de audio y en los binarios que sí vas a necesitar en tu sistema.

Como curiosidad, en algunos listados de recursos encontrarás referencias a materiales académicos o propuestas de proyectos en PDF alojados en sitios universitarios. Aunque resulten interesantes para inspirarte, para ejecutar MusicGen en local lo fundamental es tu entorno de Python, las librerías de audio y los pesos del modelo.

Requisitos y preparación del entorno

Antes de generar la primera nota, confirma que tu equipo cumple unas condiciones mínimas. En CPU se puede, pero la experiencia mejora muchísimo con GPU. Una tarjeta con soporte CUDA o Metal y al menos 6-8 GB de VRAM permite usar modelos más grandes y tiempos de inferencia razonables.

Sistemas operativos compatibles: Windows 10/11, macOS (preferible Apple Silicon para buen rendimiento) y distribuciones Linux habituales. Necesitarás Python 3.9–3.11, gestor de entornos (Conda o venv), y FFmpeg para codificar/decodificar audio. En GPU NVIDIA instala PyTorch con CUDA apropiado; en macOS con Apple Silicon, la build para MPS; en Linux, la que corresponda a tus drivers.

Los pesos del modelo de MusicGen se descargan cuando lo invocas por primera vez desde las librerías correspondientes (como Audiocraft de Meta). Si quieres operar sin conexión, descárgalos previamente y configura las rutas locales para que la ejecución no intente tocar internet. Esto es clave cuando trabajas en entornos cerrados.

Sobre almacenamiento: aunque herramientas como Firebase Storage estén pensadas para guardar y recuperar archivos en la nube con autenticación y SDK potentes, nuestro objetivo aquí es no depender de esos servicios. Guarda tus WAV/MP3 en carpetas locales y versiona con Git LFS si necesitas control de cambios sobre binarios.

Por último, prepara el audio I/O. FFmpeg es imprescindible para conversiones a formatos estándar y para limpiar o recortar muestras de referencia. Comprueba que ffmpeg está en tu PATH y que puedes invocarlo desde la consola.

Instalación paso a paso en un entorno aislado

Te propongo un flujo compatible con Windows, macOS y Linux usando Conda. Si prefieres venv, adapta los comandos según tu gestor de entornos.

# 1) Crear y activar entorno

conda create -n musicgen python=3.10 -y

conda activate musicgen

# 2) Instalar PyTorch (elige tu variante)

# NVIDIA CUDA 12.x

pip install --upgrade pip

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

# CPU puro (si no tienes GPU)

# pip install torch torchvision torchaudio

# Apple Silicon (MPS)

# pip install torch torchvision torchaudio

# 3) FFmpeg

# Windows (choco) -> choco install ffmpeg

# macOS (brew) -> brew install ffmpeg

# Linux (apt) -> sudo apt-get install -y ffmpeg

# 4) Audiocraft (incluye MusicGen)

pip install git+https://github.com/facebookresearch/audiocraft

# 5) Opcional: manejo de audio y utilidades extra

pip install soundfile librosa numpy scipySi tu entorno no permite instalar desde Git, puedes clonar el repositorio y hacer una instalación editable. Esta vía facilita fijar commits concretos para reproducibilidad.

git clone https://github.com/facebookresearch/audiocraft.git

cd audiocraft

pip install -e .Probar que todo funciona en CLI

Una forma rápida de validar la instalación es lanzar la demo de línea de comandos incluida en Audiocraft. Así confirmas que los pesos se descargan y que la inferencia arranca correctamente en tu CPU/GPU.

python -m audiocraft.demo.cli --help

# Generar 10 segundos de música con un prompt simple

python -m audiocraft.demo.cli \

--text 'guitarra acústica relajada con ritmo suave' \

--duration 10 \

--model musicgen-small \

--output ./salidas/clip_relajado.wavLa primera ejecución puede tardar más porque descargará el modelo. Si no quieres conexiones salientes, descarga antes los checkpoints y sitúalos en el directorio de caché que use tu entorno (por ejemplo, en ~/.cache/torch o el que indique Audiocraft) y desactiva la red.

Uso desde Python: control fino

Para flujos más avanzados, invoca MusicGen desde Python. Esto te permite setear semilla, número de candidatos, temperatura y trabajar con pistas condicionadas por melodías de referencia.

from audiocraft.models import MusicGen

from audiocraft.data.audio import audio_write

import torch

# Elige el tamaño: 'small', 'medium', 'large' o 'melody'

model = MusicGen.get_pretrained('facebook/musicgen-small')

model.set_generation_params(duration=12, top_k=250, top_p=0.98, temperature=1.0)

prompts = [

'sintetizadores cálidos, tempo medio, ambiente cinematográfico',

'batería electrónica con bajo contundente, estilo synthwave'

]

with torch.no_grad():

wav = model.generate(prompts) # [batch, channels, samples]

for i, audio in enumerate(wav):

audio_write(f'./salidas/track_{i}', audio.cpu(), model.sample_rate, format='wav')Si quieres condicionar con una melodía, usa el modelo de tipo melody y pasa tu clip de referencia. Este modo respeta contornos melódicos y reinterpreta el estilo según el prompt.

from audiocraft.models import MusicGen

from audiocraft.data.audio import load_audio, audio_write

model = MusicGen.get_pretrained('facebook/musicgen-melody')

model.set_generation_params(duration=8)

melody, sr = load_audio('./refs/melodia.wav', sr=model.sample_rate)

prompts = ['árpegios brillantes con pads espaciales']

wav = model.generate_with_chroma(prompts, melody[None, ...])

audio_write('./salidas/con_melodia', wav[0].cpu(), model.sample_rate, format='wav')Trabajar sin conexión y gestionar los modelos

Para un flujo 100 % local, descarga los checkpoints y configura variables de entorno o rutas para que Audiocraft los encuentre. Mantén un inventario de versiones y pesos para reproducibilidad y para evitar descargas accidentales si desactivas la red.

- Elige tamaño del modelo según tu VRAM: small consume menos y responde más rápido.

- Guarda una copia de seguridad de los pesos en un disco local o externo.

- Documenta qué commit de Audiocraft y qué build de PyTorch usas.

Si utilizas varias máquinas, puedes crear un mirror interno con tus librerías y pesos, siempre en red local y sin exponer nada a internet. Es práctico para equipos de producción con políticas estrictas.

Mejores prácticas de prompts y parámetros

La calidad del prompt influye mucho. Describe instrumentos, tempo, atmósfera y referencias estilísticas. Evita peticiones contradictorias y mantén frases concisas pero ricas en contenido musical.

- Instrumentación: guitarra acústica, piano íntimo, cuerdas suaves, batería lo-fi.

- Ritmo y tempo: 90 BPM, medio tiempo, groove marcado.

- Ambiente: cinematográfico, íntimo, oscuro, ambiental, alegre.

- Producción: reverb sutil, compresión moderada, saturación analógica.

Sobre parámetros: top_k y top_p controlan la diversidad; temperature ajusta la creatividad. Comienza con valores moderados y muévete gradualmente hasta encontrar el punto dulce para tu estilo.

Rendimiento, latencia y calidad

Con CPU, la inferencia puede ser lenta, especialmente en modelos más grandes y duraciones largas. En GPU moderna los tiempos bajan drásticamente. Considera estas pautas:

- Empieza con clips de 8–12 segundos para iterar ideas.

- Genera varias variaciones cortas y concatena las mejores.

- Haz upsampling o postproducción en tu DAW para pulir el resultado.

En macOS con Apple Silicon, MPS ofrece un término medio entre CPU y GPU dedicada. Actualiza a versiones recientes de PyTorch para exprimir mejoras de rendimiento y memoria.

Postproducción y flujo con tu DAW

Una vez generados tus WAV, impórtalos a tu DAW favorito. Ecualización, compresión, reverbs y edición te permiten transformar clips prometedores en piezas completas. Si necesitas stems o separación por instrumentos, apóyate en herramientas de separación de fuentes para recombinar y mezclar.

Trabajar 100 % en local no impide colaborar: comparte únicamente los archivos finales por los canales privados que prefieras. No es necesario publicar ni sincronizar con servicios en la nube si tu política de privacidad lo desaconseja.

Problemas habituales y cómo resolverlos

Errores de instalación: versiones incompatibles de PyTorch o CUDA suelen ser la causa. Verifica que la build de torch coincide con tu driver y sistema. Si usas Apple Silicon, asegúrate de no instalar wheels sólo para x86.

Descargas bloqueadas: si no quieres que el equipo se conecte a internet, coloca los pesos en la caché esperada por Audiocraft y deshabilita cualquier llamada externa. Comprueba permisos de lectura en las carpetas.

Audio corrupto o silencioso: revisa el sample rate y el formato. Convierte tus fuentes con ffmpeg y mantén una frecuencia común (p. ej., 32 o 44.1 kHz) para evitar artefactos.

Rendimiento pobre: reduce el tamaño del modelo o la duración del clip, cierra procesos que consuman VRAM y sube gradualmente la complejidad cuando veas márgenes libres.

Cuestiones de licencia y uso responsable

Consulta la licencia de MusicGen y de cualquier dataset que uses para referencia. Generar en local no te exime de cumplir derechos de autor. Evita prompts que imiten de forma directa obras o artistas protegidos y apuesta por estilos y géneros generales.

Comparativa conceptual: nube vs local

Para equipos que desarrollan apps, servicios como Firebase Storage ofrecen SDKs con autenticación y gestión de ficheros de audio, imagen y vídeo, además de una base de datos en tiempo real para textos. Ese ecosistema es ideal cuando necesitas sincronizar usuarios y contenido. En cambio, para un flujo creativo privado con MusicGen, el modo local evita latencias, cuotas y exposición de datos.

Piensa en ello como dos carriles distintos. Si quieres publicar, compartir o integrar resultados en apps móviles, un backend en la nube es útil. Si tu objetivo es prototipar y crear sin subir nada, céntrate en tu entorno, tus pesos y tu disco local.

Cómo usar MusicGen de Meta en local: Recursos y comunidad

Los foros y subreddits de herramientas generativas son un buen termómetro de novedades y técnicas. En particular, existen comunidades no oficiales que abrazan proyectos de código abierto, donde puedes publicar arte, plantear dudas, abrir debates, contribuir con tecnología o simplemente curiosear. La comunidad abre puertas que la documentación formal no siempre cubre.

También encontrarás propuestas y documentos técnicos en repositorios académicos y webs universitarias, a veces en PDF descargables. Úsalos como inspiración metodológica, pero mantén tu foco práctico en dependencias y flujos de audio reales para que MusicGen corra fino en tu equipo.

Con todo lo anterior, ya tienes claro cómo montar el entorno, generar tus primeras piezas y mejorar resultados sin exponer tu material a terceros. La combinación de un buen setup local, prompts cuidados y una dosis de postproducción te dará un flujo creativo potente y totalmente bajo tu control. Ahora ya sabes cómo usar MusicGen de Meta en local.

Apasionado de la tecnología desde pequeñito. Me encanta estar a la última en el sector y sobre todo, comunicarlo. Por eso me dedico a la comunicación en webs de tecnología y videojuegos desde hace ya muchos años. Podrás encontrarme escribiendo sobre Android, Windows, MacOS, iOS, Nintendo o cualquier otro tema relacionado que se te pase por la cabeza.