- Nuevo modelo especializado en programación con compactación para sesiones largas sin perder coherencia.

- Mejoras medibles en benchmarks (SWE-Bench, SWE-Lancer, Terminal-Bench) y uso de menos tokens.

- Disponible para Plus, Pro, Business, Edu y Enterprise; integración en herramientas Codex; API pública prevista.

- Entorno aislado y sin red por defecto, con controles de seguridad y supervisión.

OpenAI ha presentado GPT-5.1-Codex-Max, un nuevo modelo de inteligencia artificial orientado a desarrollo de software que llega con la promesa de mantener el rumbo en proyectos largos sin perder el contexto. En la práctica, hablamos de una evolución de Codex capaz de sostener tareas complejas durante horas, con mejoras en eficiencia y velocidad que se notan en flujos reales de trabajo.

La gran novedad está en su capacidad para razonar de forma sostenida gracias a una técnica de gestión de memoria denominada compactación. Este enfoque permite que, antes de saturar la ventana de contexto, el sistema identifique redundancias, resuma lo accesorio y conserve lo esencial, evitando así los olvidos típicos que encallan tareas de larga duración.

¿Qué es GPT-5.1-Codex-Max?

Se trata de un modelo específico para programación optimizado para tareas de ingeniería de software extendidas, desde la revisión de código hasta la generación de pull requests y el soporte al desarrollo frontend. A diferencia de generaciones anteriores, está entrenado para mantener consistencia durante jornadas de trabajo prolongadas y en repositorios de tamaño considerable.

OpenAI sitúa a GPT-5.1-Codex-Max un peldaño por encima de Codex al permitir flujos continuos de 24 horas o más sin degradar resultados. Para quienes construyen producto, esto significa menos interrupciones por límites de contexto y menos pérdida de tiempo reexplicando tareas en iteraciones sucesivas.

Novedades técnicas y la técnica de compactación

La clave está en la compactación del historial: el modelo identifica qué partes del contexto son prescindibles de forma literal, las resume y conserva referencias críticas para seguir con la tarea sin atascar la memoria. Este mecanismo también se menciona como “compresión” en algunos materiales, pero describe el mismo proceso de depuración inteligente del contexto.

Con esta base, GPT-5.1-Codex-Max puede seguir iterando sobre código, corregir errores y refactorizar módulos enteros sin que la ventana de contexto sea un cuello de botella. En escenarios de uso intensivo, reduce también el número de tokens necesarios para pensar, lo que impacta en coste y latencia.

El modelo incorpora un modo de razonamiento “extra alto” para problemas difíciles, con el objetivo de profundizar en análisis cuando la tarea lo requiere, manteniendo la coherencia de la salida en procesos con muchos pasos y dependencias.

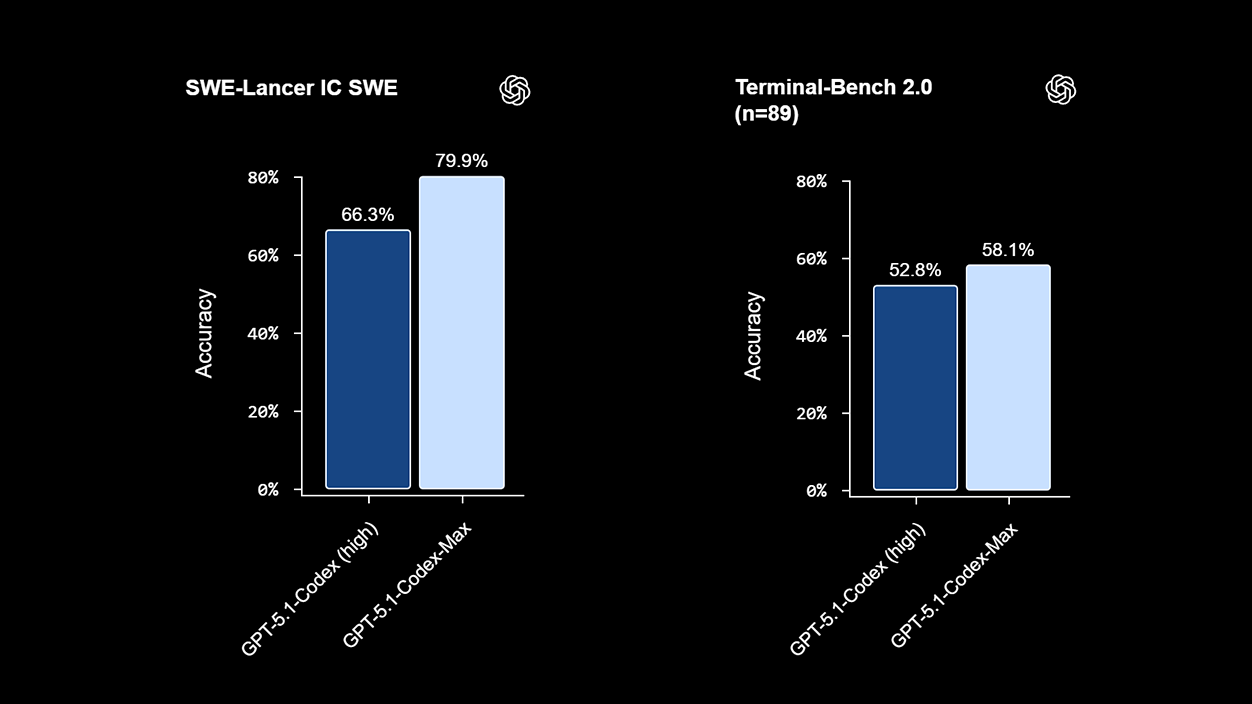

Rendimiento y benchmarks: qué dicen las cifras

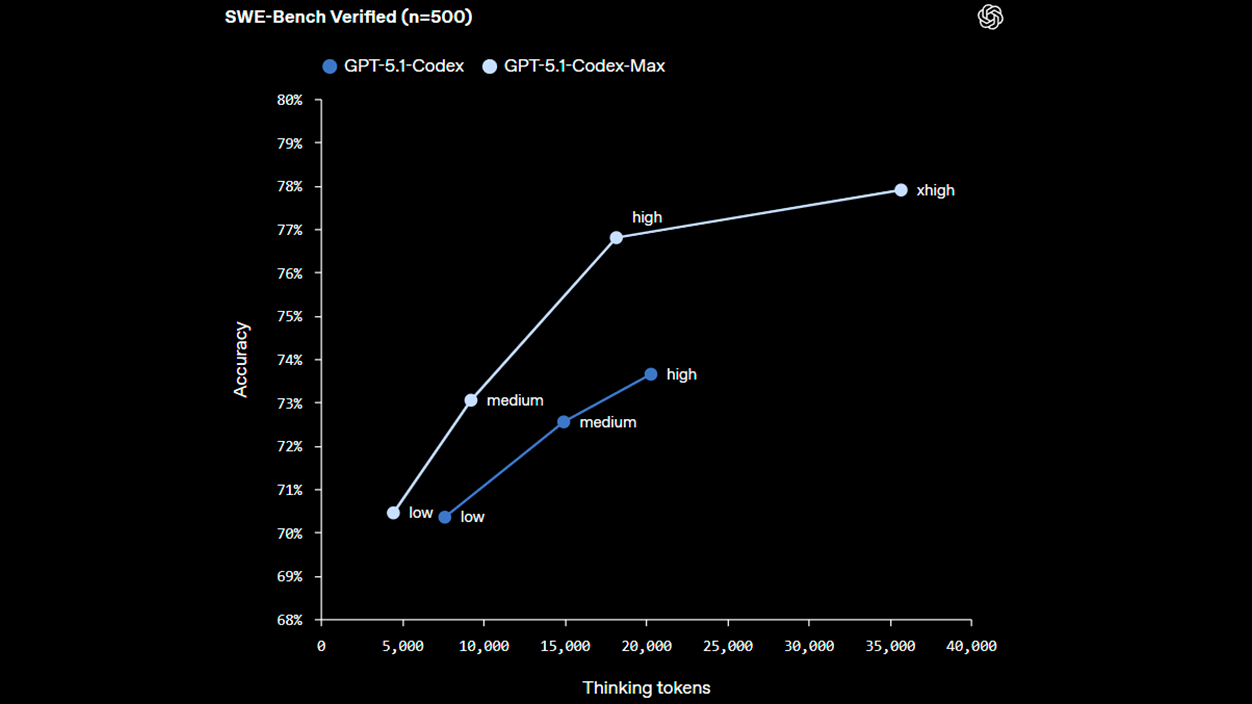

En evaluaciones internas centradas en programación, GPT-5.1-Codex-Max mejora con respecto a su predecesor en distintos frentes, con tasas de acierto más altas y mayor eficiencia de tokens. Estos resultados, comunicados por OpenAI, reflejan pruebas sobre tareas reales de ingeniería y baterías como SWE-Bench Verified, SWE-Lancer IC SWE y Terminal-Bench 2.0.

Entre los datos compartidos, el modelo alcanza alrededor de 77,9% en SWE-Bench Verified (frente a 73,7% de GPT-5.1-Codex), registra 79,9% en SWE-Lancer IC SWE y logra 58,1% en Terminal-Bench 2.0. Además, en contextos prolongados se han medido incrementos de velocidad del 27% al 42% en tareas típicas frente a Codex, según las mismas fuentes.

En comparativas divulgadas con otros modelos, como Gemini 3 Pro, OpenAI apunta a una ligera ventaja en varios puntos de referencia de codificación, e incluso paridad en pruebas competitivas como LiveCodeBench Pro. Conviene tener presente que estas cifras proceden de mediciones internas y pueden variar en entornos de producción.

Integraciones, herramientas y disponibilidad en España y Europa

GPT-5.1-Codex-Max ya está operativo en superficies basadas en Codex: la CLI oficial, extensiones para IDE y servicios de revisión de código del ecosistema de OpenAI. La compañía indica que el acceso vía API pública llegará en una fase posterior, lo que permite a los equipos empezar a probarlo hoy en las herramientas nativas mientras preparan integraciones a medida.

En cuanto a disponibilidad comercial, los planes ChatGPT Plus, Pro, Business, Edu y Enterprise incluyen el nuevo modelo desde su lanzamiento. Usuarios y organizaciones en España y el resto de la Unión Europea con estas suscripciones pueden activarlo en sus flujos, sin necesidad de despliegues adicionales, siempre que utilicen las superficies compatibles de Codex.

OpenAI también señala que el modelo está optimizado para funcionar en entornos Windows, ampliando el alcance más allá de Unix y facilitando su adopción en empresas con parques mixtos de desarrollo y herramientas corporativas estandarizadas.

Seguridad operativa y controles de riesgo

Para reducir el riesgo en ejecuciones largas, el modelo opera en un espacio de trabajo aislado, sin permisos para escribir fuera de su ámbito por defecto. Asimismo, la conectividad a red está desactivada salvo habilitación explícita por parte del desarrollador responsable, reforzando la privacidad.

El entorno incorpora mecanismos de monitorización que detectan actividad anómala e interrumpen procesos si se sospecha de usos indebidos. Esta configuración busca equilibrar la autonomía del agente con garantías razonables para equipos que gestionan código sensible o repositorios críticos.

Casos de uso donde más aporta

La principal ventaja aparece en trabajos que exigen memoria persistente y continuidad: refactorizaciones extensas, depuraciones que requieren seguimiento prolongado, revisiones continuas de código y automatización de pull requests en repositorios grandes. En estas tareas, la compactación reduce el “desgaste” del contexto y sostiene la coherencia.

Para startups y equipos técnicos, delegar estos procesos en un modelo estable permite ganar foco en prioridades de producto, acelerar entregas y disminuir errores derivados de la fatiga o la repetición manual. Todo ello, con un consumo de tokens más ajustado que en versiones previas.

- Proyectos multimódulo donde la continuidad entre sesiones es determinante.

- CI/CD asistido con comprobaciones y correcciones que avanzan en segundo plano.

- Soporte a frontend y revisiones con contexto transversal en historias de usuario complejas.

- Análisis de fallos y debugging de larga duración sin reexplicar el caso cada pocas horas.

Diferencias frente a Codex y otros modelos

La gran divergencia respecto a Codex clásico no está solo en la potencia bruta, sino en la gestión eficaz del contexto a largo plazo. Codex destacaba en tareas puntuales; Codex-Max está pensado para procesos sostenidos, donde el modelo actúa como un colaborador que no pierde el hilo con el paso de las horas.

Las comparativas con alternativas como Gemini 3 Pro se inclinan a favor de GPT-5.1-Codex-Max en varios test de codificación según los datos difundidos, si bien lo prudente es validar estos resultados en entornos propios y con cargas de trabajo reales antes de estandarizarlo en la pipeline de una organización.

Quien necesite una IA de código que aguante maratones técnicos sin fatigarse encontrará en GPT-5.1-Codex-Max una opción especialmente orientada a continuidad, seguridad por defecto y eficiencia en tokens; un conjunto de cualidades que, en equipos de España y Europa con ritmos exigentes, puede traducirse en entregas más rápidas y un mantenimiento más fino del código.

Soy un apasionado de la tecnología que ha convertido sus intereses «frikis» en profesión. Llevo más de 10 años de mi vida utilizando tecnología de vanguardia y trasteando todo tipo de programas por pura curiosidad. Ahora me he especializado en tecnología de ordenador y videojuegos. Esto es por que desde hace más de 5 años que trabajo redactando para varias webs en materia de tecnología y videojuegos, creando artículos que buscan darte la información que necesitas con un lenguaje entendible por todos.

Si tienes cualquier pregunta, mis conocimientos van desde todo lo relacionado con el sistema operativo Windows así como Android para móviles. Y es que mi compromiso es contigo, siempre estoy dispuesto a dedicarte unos minutos y ayudarte a resolver cualquier duda que tengas en este mundo de internet.