- Seedance 2.0 es el modelo multimodal de ByteDance capaz de generar vídeos hiperrealistas combinando texto, imagen, audio y clips de referencia.

- La herramienta ha provocado una fuerte reacción en Hollywood por el uso de actores y personajes protegidos por derechos de autor sin permiso.

- ByteDance afirma que reforzará las salvaguardas y Seedance 2.0 ya bloquea buena parte de los intentos de generar contenido con copyright.

- Su despliegue global y la integración en plataformas como RecCloud anticipan un cambio profundo en la creación audiovisual profesional y amateur.

En apenas unos días, Seedance 2.0 ha pasado de ser una curiosidad técnica a convertirse en el nuevo epicentro del debate sobre la inteligencia artificial. El modelo de vídeo generativo de ByteDance, matriz de TikTok y CapCut, está demostrando una capacidad inédita para crear escenas con aspecto cinematográfico a partir de simples instrucciones de texto y otros materiales de referencia.

Su impacto no se limita a China. Los clips hiperrealistas generados con Seedance 2.0 han inundado X, TikTok y otras plataformas, con ejemplos tan llamativos como una pelea entre Tom Cruise y Brad Pitt en una azotea derruida o versiones imposibles de personajes de anime y superhéroes. Ese mismo éxito viral ha encendido todas las alarmas en Hollywood y ha reabierto, con mucha más fuerza, el debate sobre el copyright en la era de la IA generativa.

Qué es Seedance y cómo ha evolucionado a Seedance 2.0

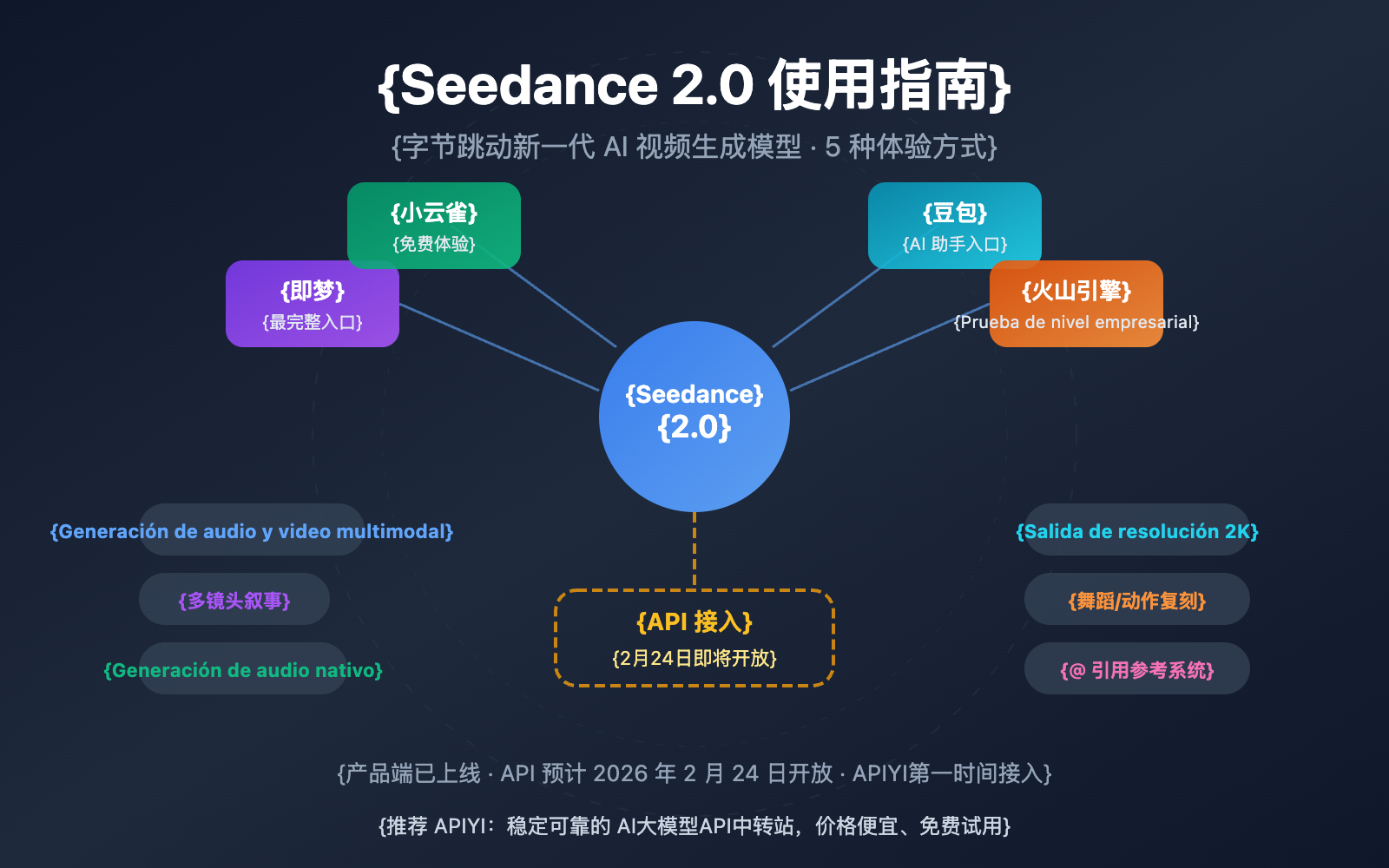

Seedance forma parte de la familia de modelos de inteligencia artificial “Seed” desarrollada por ByteDance, que incluye sistemas para imágenes (Seedream), edición (Seededit), 3D (Seed3D), traducción de voz en tiempo real (Seed LiveInterpret) o generación musical (Seed-Music). Dentro de este ecosistema, Seedance se centra en un objetivo muy concreto: crear vídeo a partir de descripciones en lenguaje natural. En un panorama competitivo han surgido también otros desarrollos relevantes como el nuevo modelo de Anthropic.

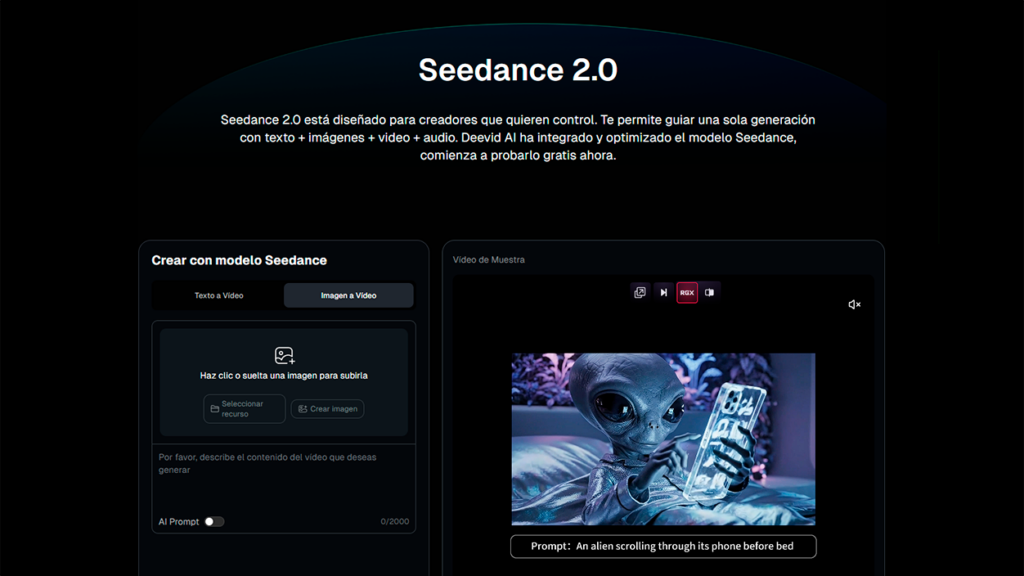

A nivel técnico, Seedance 2.0 es un modelo multimodal, es decir, no solo procesa texto, sino también imágenes, audio y fragmentos de vídeo como entrada. El usuario puede escribir un prompt, subir una foto de referencia, añadir un clip de voz o un sonido ambiental y dejar que el sistema genere una secuencia de varios segundos con imagen y sonido sincronizados.

El modelo ha sido entrenado para interpretar instrucciones complejas en lenguaje cotidiano, comprender acciones, emociones, movimientos de cámara y detalles de la escena. A partir de ahí construye un metraje corto, con diálogos o efectos de audio generados automáticamente cuando así se le pide.

Frente a su primera versión, Seedance 2.0 mejora de forma notable el realismo físico y la consistencia visual: los objetos se mueven de manera coherente con la gravedad, las colisiones y el entorno; los personajes mantienen su aspecto entre planos; y la iluminación y los reflejos se ajustan con más precisión a cada escena.

En cuanto a duración, dependiendo de la configuración, el sistema es capaz de producir clips de entre 4 y 15 segundos, cubriendo desde pequeños planos de acción hasta microtráilers con varios cortes de cámara.

Funciones clave: vídeo multimodal con enfoque cinematográfico

Una de las grandes bazas de Seedance 2.0 es su capacidad para combinar múltiples fuentes de información. El usuario puede partir de un simple mensaje de texto, pero también se le permite aportar fotografías, breves vídeos o audios que sirven como guía para personajes, escenarios, estilo visual o tono sonoro.

Esto se traduce en que es posible, por ejemplo, generar una escena completa a partir de una conversación grabada, dejando que la IA imagine los planos, el movimiento de cámara y la puesta en escena. O crear un vídeo que continúe una foto, extendiendo el encuadre y animando a un personaje estático con una voz sintética coherente.

Seedance 2.0 incorpora lo que ByteDance denomina multi‑lens storytelling, una técnica pensada para mantener al mismo personaje con la misma apariencia a través de distintos cortes de cámara. Así, una secuencia puede alternar primeros planos, planos generales o tomas laterales sin que cambien rasgos faciales, ropa o peinado, algo especialmente relevante si se quiere construir relatos algo más complejos.

En el plano técnico, el modelo exporta en resolución de hasta 2K y, según datos proporcionados por la propia compañía, genera los resultados con una velocidad aproximadamente un 30 % superior respecto a la versión 1.5. Usuarios que han tenido acceso anticipado destacan también movimientos de cámara muy suaves, reflejos cuidados y un audio estéreo de doble canal que refuerza la sensación de estar viendo un fragmento de película real.

Esta combinación de calidad visual, sonido adaptado y facilidad de uso explica por qué, con prompts tan simples como “Will Smith comiendo espaguetis” o “dos samuráis luchando bajo la lluvia en una azotea”, los resultados han sorprendido incluso a expertos que llevan años probando modelos de IA generativa.

Disponibilidad, acceso y primeras integraciones en plataformas

A día de hoy, Seedance 2.0 no está disponible de forma abierta y generalizada en todo el mundo. El modelo se ofrece principalmente a través de servicios del ecosistema ByteDance en China, integrado en herramientas como Jianying/CapCut y en funciones vinculadas a Douyin, la versión china de TikTok.

Fuera del mercado chino, el acceso sigue siendo limitado. Algunos usuarios seleccionados han podido probar versiones beta mediante plataformas intermediarias o servicios que ya preparan su integración, pero no existe todavía un lanzamiento masivo orientado directamente a Europa o España.

La excepción más clara es RecCloud, una plataforma de productividad de vídeo basada en IA con sede en Estados Unidos, que ha anunciado soporte completo para Seedance 2.0 desde el día de su lanzamiento global oficial. Según la compañía, su infraestructura está lista para que, en cuanto se active el modelo a nivel mundial, creadores y empresas puedan generar clips directamente desde su interfaz, sin pasos intermedios ni migraciones.

RecCloud promete ofrecer, a través de esta integración, todas las capacidades multimodales de Seedance 2.0: combinación de texto, imagen, audio y vídeo como entrada; continuidad visual entre planos; control de estilo de cámara; y exportaciones de alta calidad listas para redes sociales, educación, marketing o proyectos narrativos.

Esta estrategia de “llegar el primer día” refleja un cambio de tendencia en el sector: las plataformas de creación de vídeo empiezan a competir por integrar de inmediato los modelos de referencia, conscientes de que el tiempo de espera entre anuncio y disponibilidad se ha convertido en un factor clave para captar y retener usuarios.

Vídeos virales, anime y escenas imposibles: el fenómeno Seedance 2.0

El salto de Seedance 2.0 al primer plano mediático no se ha debido a comunicados oficiales, sino a una cascada de vídeos virales compartidos por usuarios que tenían acceso anticipado. Redes como X y TikTok se llenaron de clips donde se recreaban peleas imposibles, escenas de anime hiperrealistas o secuencias que parecían sacadas de grandes superproducciones.

Entre los ejemplos más comentados están las batallas entre personajes de animación como Doraemon o luchadores de sagas populares de anime, así como la famosa escena de unos 15 segundos donde Tom Cruise y Brad Pitt se enfrentan en lo alto de un edificio en ruinas. El detalle de los gestos, la iluminación y el ritmo de montaje hizo que muchos usuarios confundieran estas creaciones con fragmentos de películas reales.

Varias pruebas realizadas por creadores de contenido especializados en IA, como el divulgador español Carlos Santana (Dot CSV), han servido para exponer el potencial del modelo. En sus demostraciones se aprecian reflejos coherentes en objetos secundarios, continuidad entre planos y bandas sonoras ajustadas a la acción, con fallos puntuales difíciles de detectar para un espectador no entrenado.

Ese nivel de acabado ha llevado a algunos analistas a comparar el momento actual con la llegada de herramientas como Photoshop a principios de los años noventa: tecnologías que, aun siendo imperfectas en su primera versión comercial, marcan un punto de inflexión en la forma de producir contenido visual.

Todo ello alimenta la sensación de que, más pronto que tarde, guionistas, pequeños estudios o incluso aficionados podrán producir cortos, pilotos de series o tráilers complejos con presupuestos muy reducidos, eligiendo qué escenas rodar en el mundo real y cuáles delegar a la IA.

La respuesta de Hollywood: copyright, derechos de imagen y empleo

El entusiasmo tecnológico ha venido acompañado de una reacción muy crítica por parte de la industria cinematográfica estadounidense. Estudios y sindicatos consideran que Seedance 2.0 ha cruzado varias líneas rojas, tanto en materia de copyright como en el uso de la imagen y la voz de intérpretes sin su consentimiento.

La Motion Picture Association (MPA), que agrupa a gigantes como Disney, Warner Bros. Discovery, Sony, Paramount, Universal, Netflix, Prime Video y Amazon MGM Studios, ha acusado a ByteDance de permitir un “uso masivo y no autorizado” de obras protegidas por derechos de autor. En sus comunicados, la MPA sostiene que el servicio se lanzó sin garantías suficientes para evitar infracciones y pide a la empresa china que cese de inmediato las actividades consideradas ilícitas.

Disney y Paramount han ido un paso más allá, enviando cartas formales de cese y desistimiento en las que denuncian que sus catálogos habrían sido utilizados para entrenar el modelo sin permiso ni compensación. En el caso de Disney, la compañía habla directamente de una “biblioteca pirata” de personajes y franquicias integradas en el sistema.

Los sindicatos también se han pronunciado. SAG‑AFTRA, que representa a actores y actrices en Estados Unidos, califica el comportamiento de ByteDance como “una infracción flagrante” de los derechos de sus miembros, señalando el uso no autorizado de voces e imágenes. Para estas organizaciones, el problema no es solo jurídico, sino también laboral: temen una sustitución progresiva de tareas creativas y técnicas por sistemas de IA en guion, interpretación, doblaje, animación o efectos visuales.

Figuras del sector como Rhett Reese, guionista de la saga Deadpool, han expresado abiertamente su inquietud. Tras ver el famoso vídeo de Pitt contra Cruise generado con Seedance 2.0, reconoció que la calidad del clip le impresionó y que teme por el futuro profesional de muchos colegas, convencido de que Hollywood podría cambiar drásticamente en pocos años.

De la permisividad inicial al bloqueo de personajes con copyright

La presión de los estudios y las quejas públicas han tenido efectos visibles en el comportamiento de la herramienta. Usuarios que experimentaron con Seedance 2.0 durante los primeros días de pruebas lograron generar vídeos con personajes claramente protegidos, desde héroes de sagas de animación hasta protagonistas de series de televisión muy conocidas.

En la fase más reciente de las pruebas, sin embargo, el sistema ha comenzado a bloquear de forma activa las peticiones que incluyen nombres y propiedades intelectuales bajo copyright. Cuando un usuario intenta recrear, por ejemplo, una escena con los personajes de Friends u otros iconos de Hollywood, Seedance responde explicando que no puede generar ese contenido por problemas de derechos de autor.

La propia herramienta propone alternativas con personajes genéricos o diseños originales, y llega a rechazar prompts que piden figuras “parecidas” a personajes protegidos. Este cambio de comportamiento sugiere que ByteDance ha introducido filtros más estrictos, probablemente como respuesta a las demandas y a las advertencias legales recibidas desde Estados Unidos.

Plataformas que ofrecen acceso a Seedance 2.0 confirman este giro. En pruebas realizadas desde medios especializados se observa que, aunque algunos contenidos polémicos circularon en los primeros días, actualmente es muy difícil generar clips que reproduzcan de forma directa IP de grandes estudios. La compañía también ha reconocido públicamente que está fortaleciendo las salvaguardas para impedir el uso no autorizado de propiedades intelectuales e imágenes personales.

Todo ello se produce mientras la demanda de acceso al modelo no deja de crecer, con tiempos de espera elevados y una infraestructura que aún se percibe como inestable. Es un recordatorio de que, más allá del debate jurídico, hay una presión de mercado considerable para que este tipo de herramientas llegue al gran público cuanto antes.

Impacto potencial en la creación audiovisual en España y Europa

Aunque por ahora el acceso a Seedance 2.0 en España y el resto de Europa es muy reducido, el debate que ha generado anticipa cambios que afectarán de lleno a creadores, productoras y televisiones del continente. La posibilidad de producir tráilers, anuncios o pequeñas piezas narrativas con aspecto profesional y coste reducido resulta especialmente atractiva para pymes y profesionales independientes.

Para la industria audiovisual europea, que ya ha vivido la irrupción de las plataformas de streaming, la llegada de modelos como Seedance 2.0 puede suponer otra vuelta de tuerca en la competencia por la atención del público. Una productora pequeña podría apoyarse en estas herramientas para elaborar maquetas visuales, pruebas de concepto o incluso escenas finales que hasta ahora requerían equipos y presupuestos elevados.

Al mismo tiempo, existe preocupación por el impacto sobre el empleo. Tareas como la creación de extras digitales, ciertos efectos de posproducción, animaciones sencillas o doblajes automáticos podrían automatizarse en parte, reduciendo la necesidad de equipos humanos en determinadas fases de los proyectos.

En España, donde el sector audiovisual combina grandes producciones con un tejido de empresas muy fragmentado, es previsible que convivan posiciones muy distintas: desde quienes vean en Seedance 2.0 una herramienta para abaratar costes y experimentar con nuevos formatos, hasta quienes reclamen regulaciones fuertes para proteger la autoría, la imagen y los derechos laborales.

Lo que sí parece claro es que, de cara a los próximos años, la alfabetización en IA y el manejo de herramientas de vídeo generativo se convertirán en competencias cada vez más valoradas, tanto en estudios de cine y televisión como en agencias de publicidad, medios digitales y creadores de contenido independientes.

Con Seedance 2.0, ByteDance ha demostrado hasta dónde puede llegar hoy la generación de vídeo por inteligencia artificial: clips cortos de apariencia casi cinematográfica, creados en segundos y con una combinación muy flexible de texto, imagen y sonido. El coste de ese avance es un choque frontal con la industria del entretenimiento tradicional, que ve en este modelo un riesgo para sus derechos de autor, la imagen de sus talentos y el sustento de miles de profesionales. Mientras Hollywood presiona para imponer límites y licencias obligatorias, compañías tecnológicas y plataformas de creación se preparan para integrar estas funciones en sus servicios desde el primer día. Falta por ver si las nuevas salvaguardas anunciadas por ByteDance serán suficientes para encajar Seedance 2.0 en un marco legal y económico más estable, o si este será solo el primer episodio de una larga serie de conflictos entre la IA generativa y el negocio audiovisual tal y como lo conocemos.

Soy un apasionado de la tecnología que ha convertido sus intereses «frikis» en profesión. Llevo más de 10 años de mi vida utilizando tecnología de vanguardia y trasteando todo tipo de programas por pura curiosidad. Ahora me he especializado en tecnología de ordenador y videojuegos. Esto es por que desde hace más de 5 años que trabajo redactando para varias webs en materia de tecnología y videojuegos, creando artículos que buscan darte la información que necesitas con un lenguaje entendible por todos.

Si tienes cualquier pregunta, mis conocimientos van desde todo lo relacionado con el sistema operativo Windows así como Android para móviles. Y es que mi compromiso es contigo, siempre estoy dispuesto a dedicarte unos minutos y ayudarte a resolver cualquier duda que tengas en este mundo de internet.