- Auditar textos generados por IA exige combinar revisión manual, conocimiento de sesgos algorítmicos y apoyo de herramientas automáticas, sin confiar ciegamente en ninguna de ellas.

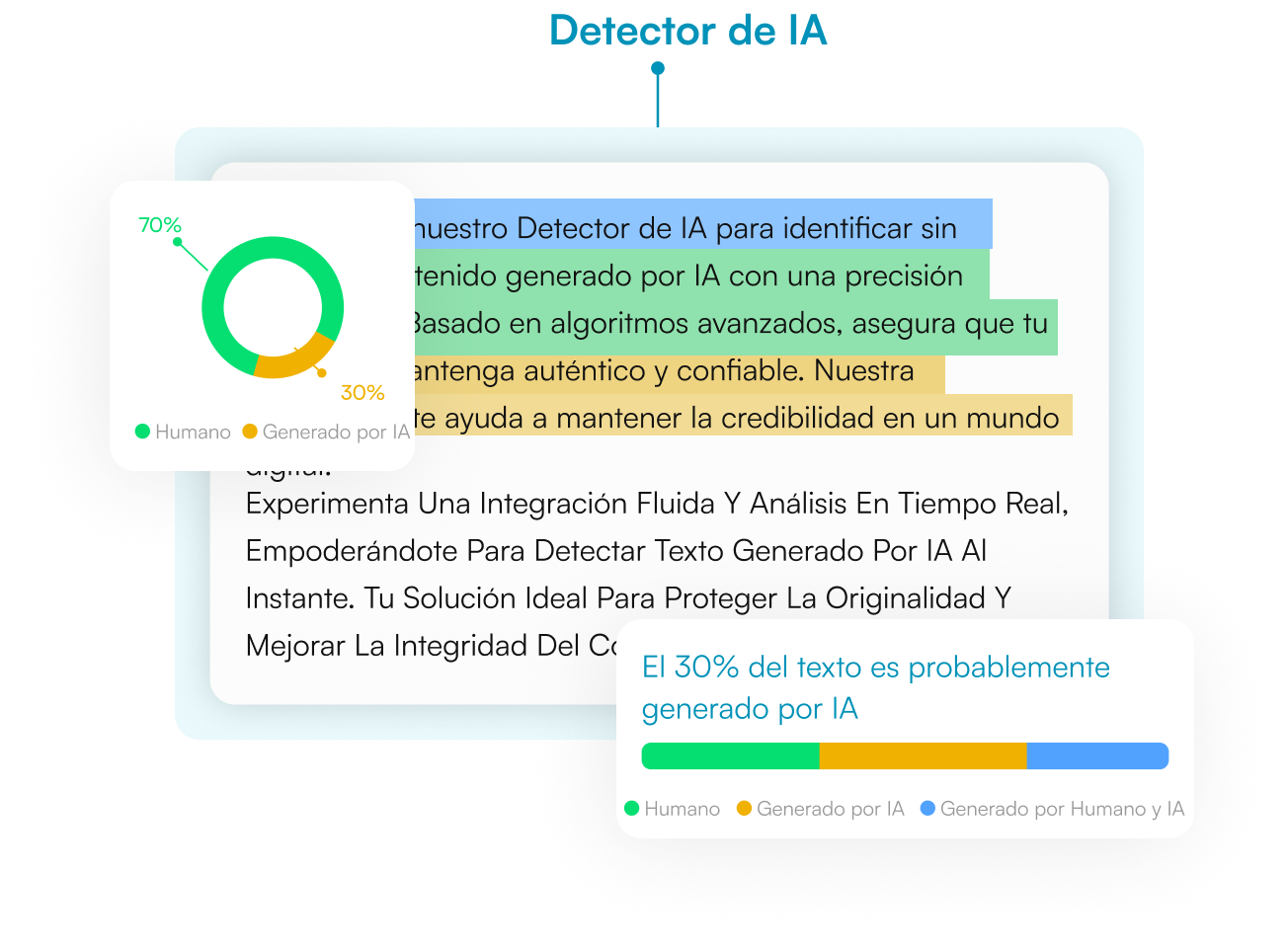

- Los detectores de contenido IA ayudan, pero sufren falsos positivos y pueden discriminar a ciertos grupos, por lo que deben usarse solo como indicio inicial, nunca como prueba definitiva.

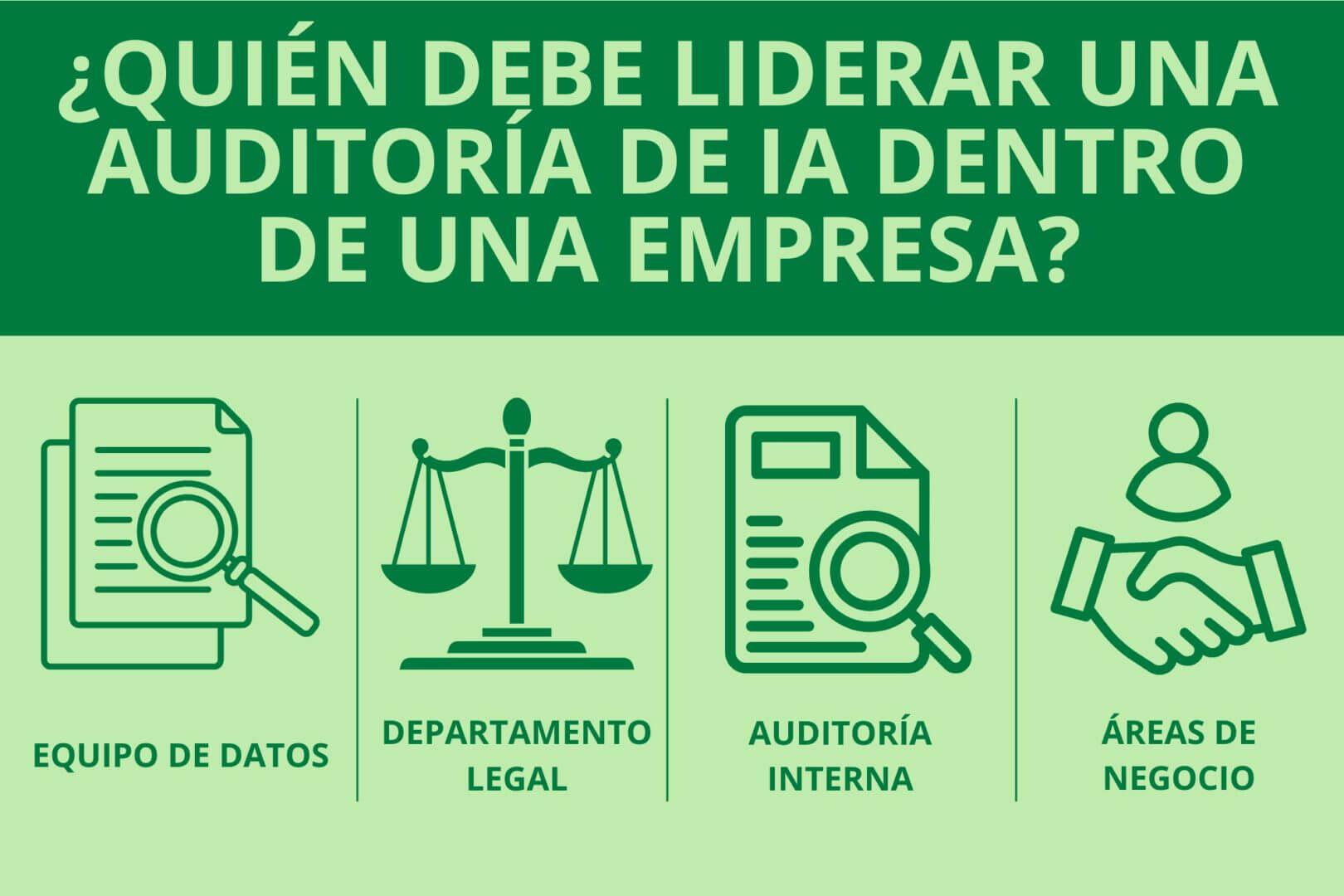

- La auditoría de sesgos en IA requiere marcos formales, criterios claros, auditores independientes y herramientas técnicas para medir impacto dispar, gobernanza y riesgos sociotécnicos.

- En contextos académicos, científicos y profesionales es clave verificar autoría, exactitud factual y calidad ética del texto, así como la fiabilidad de las fuentes y del entorno de publicación.

¿Cómo auditar un texto generado por IA para detectar errores y sesgos? Hoy en día es perfectamente posible que un informe médico, un trabajo universitario o un artículo web hayan sido redactados, en todo o en parte, por un modelo de IA. Y, sin embargo, seguimos necesitando saber si ese contenido es fiable, ético y respetuoso con las personas a las que afecta. La cuestión ya no es solo “¿lo ha escrito una IA o un humano?”, sino cómo auditar ese texto para detectar errores, sesgos y riesgos antes de darle por bueno.

La mala noticia es que ningún sistema actual puede decirnos con certeza absoluta si un texto viene de una máquina. La buena es que, combinando análisis lingüístico, comprobación de hechos, marcos de auditoría de sesgos y herramientas especializadas, podemos acercarnos bastante a una evaluación responsable. Vamos a ver, paso a paso, cómo hacerlo en la práctica sin caer en soluciones mágicas ni en miedos infundados.

Por qué es necesario auditar textos generados por IA

La aparición de modelos de lenguaje masivo (LLM) como ChatGPT, Gemini, Claude o Llama ha multiplicado la generación automática de texto: ensayos, noticias, reseñas, informes técnicos, resúmenes científicos, correos y hasta cartas de motivación. Estos modelos funcionan estimando probabilísticamente qué palabra es más probable que venga a continuación dado el contexto, a partir de enormes corpus de libros, webs y otros textos.

Este enfoque probabilístico explica por qué la prosa de la IA suele sonar tan pulida: produce frases fluidas, con gramática impecable y un tono razonablemente neutro. Pero también muestra sus límites: el modelo no “sabe” si lo que dice es cierto, ni comprende las implicaciones éticas, jurídicas o sociales de sus respuestas. Le basta con que la frase sea verosímil, no necesariamente verdadera.

Las consecuencias son claras: un texto generado por IA puede incurrir en errores factuales, sesgos contra determinados grupos, divulgación indebida de datos personales, plagio encubierto o referencias bibliográficas inventadas. En campos críticos como medicina, justicia, finanzas, selección de personal o educación, estos fallos pueden traducirse en daños reales.

De ahí que se esté consolidando la idea de la auditoría de textos y sistemas de IA como pieza clave de la gobernanza algorítmica: igual que una auditoría financiera certifica la fiabilidad de unas cuentas, una auditoría de IA aspira a revisar el desempeño, la equidad y la transparencia de los sistemas que generan o apoyan decisiones automatizadas.

Detectar si un texto procede de IA: límites, patrones y herramientas

Aunque la tentación es enorme, no existe un software infalible que marque en verde lo humano y en rojo lo generado por IA. La propia OpenAI retiró en 2023 su AI Text Classifier por baja precisión. Mozilla Foundation ha señalado que el texto de IA no es “lo bastante distinto” al humano como para diferenciarlo de forma consistente, y estudios independientes confirman que ni humanos ni detectores automáticos pasan del aprobado alto en esta tarea.

Aun así, hay tres grandes vías que podemos combinar en una auditoría básica de autoría: observación de patrones lingüísticos, uso prudente de detectores de IA y contraste con el contexto y el autor.

1. Patrones típicos de escritura generada por IA

Muchos LLM comparten una serie de rasgos que, cuando aparecen juntos, disparan las alarmas. Ninguno es definitivo por sí mismo, pero la combinación de varios sí es un indicio relevante de que estamos ante un texto al menos fuertemente asistido por IA.

- Tono excesivamente neutro y ceremonioso: estilo pulcro, impersonal, con fórmulas muy trilladas y una corrección casi aséptica. La voz humana suele permitirse más ironías, ambigüedades o marcas personales.

- Abuso de enumeraciones y estructuras tipo “10 claves para…”: es una plantilla cómoda para la IA, que replica esquemas de contenidos virales.

- Repetición léxica y sintáctica: palabras comodín (crucial, asegurar, profundo, fundamental), conectores siempre idénticos, longitud de frases sospechosamente uniforme y estructuras que se repiten párrafo tras párrafo.

- Cierres perfectos: conclusiones redondas que reexplican íntegramente el texto con fórmulas como “en conclusión”, “en definitiva”, con un nivel de orden interno que pocos humanos mantienen de forma natural.

- Gramática impecable, puntuación “demasiado perfecta”: pocos errores, pero a veces un uso de comas, guiones o dos puntos muy normativo y repetitivo que transmite una sensación ligeramente artificial.

- Calcos del inglés: uso raro de mayúsculas en títulos, giros calcados del inglés o una especie de “español neutro” sin regionalismos ni rasgos locales, especialmente en temas donde lo normal sería un poco de color local.

En el ámbito científico, educativo o técnico se suman otros síntomas: referencias bibliográficas que no existen, DOI que no coinciden con los títulos citados, autores imposibles de rastrear o citas que no guardan una relación real con el tema. Todo esto es material de auditoría claro.

2. Detectores de IA: útiles, pero jamás decisivos

En los últimos años han aparecido numerosas herramientas que prometen clasificar un texto como humano o generado por IA: GPTZero, Copyleaks, ZeroGPT, Originality.ai, Turnitin AI, entre otras. Muchas se basan en métricas como la perplejidad (lo predecible que resulta cada palabra) y la burstiness o “rafagosidad” (variación en la longitud de las frases). En general, los textos humanos presentan más variación y sorpresas que la prosa de un modelo estándar.

Estos detectores pueden ser muy útiles como señal inicial, sobre todo si destacan párrafos concretos con alta probabilidad de IA. Pero presentan varios problemas serios para una auditoría responsable:

- Falsos positivos y falsos negativos: un 1 % de error en cohortes masivas de estudiantes o solicitantes de empleo significa decenas de personas honestas marcadas a fuego como tramposas.

- Sesgos contra hablantes no nativos: estudios de universidades como Stanford han mostrado que textos de estudiantes extranjeros son marcados como IA con más frecuencia, porque su estilo puede ser menos variado o más “manual de gramática” que el de un nativo.

- Carrera armamentística con “humanizadores”: basta pasar un texto de ChatGPT por herramientas como QuillBot o Clever AI Humanizer, introducir errores leves o añadir coloquialismos para reducir enormemente la probabilidad detectada.

- Desfase constante: cada salto generacional en los modelos (GPT‑4o, Claude Sonnet 4, Gemini 2.5…) obliga a reentrenar al detector; durante meses, el modelo generador va por delante.

Por todo ello, instituciones de referencia recomiendan usar estos sistemas solo como apoyo orientativo y nunca como prueba concluyente. En una auditoría seria, el detector es un sensor, no un juez.

3. Contrastar con el autor y el contexto

En entornos educativos, laborales o de revisión editorial, una de las técnicas más efectivas sigue siendo la más sencilla: hablar con la persona que firma el texto. Pocas cosas revelan antes un uso acrítico de la IA que pedir a alguien que explique con sus palabras un argumento complejo que aparece en el documento.

Formas prácticas de hacerlo en una auditoría:

- Entrevistas breves o defensas orales: pedir al autor que explique pasajes clave, justifique sus fuentes o reconstruya un razonamiento matemático o metodológico.

- Revisión de borradores y versiones: analizar el historial de cambios en Google Docs, sistemas de control de versiones o repositorios para comprobar una evolución natural del texto.

- Tareas localizadas y contextualizadas: cuando el contenido incluye experiencias personales, datos locales o referencias concretas a una organización, es mucho más fácil detectar un “copypaste” o una redacción genérica de IA.

La clave aquí es desplazar el foco del producto final al proceso de creación. Un texto puede haber sido asistido por IA y, aun así, ser legítimo si el autor ha revisado, corregido y asumido su contenido. La auditoría debe centrarse en la transparencia y el uso ético, no en la caza de brujas.

Auditar errores factuales, plagio y referencias inventadas

Incluso aunque no podamos estar seguros al 100 % de la autoría, sí podemos auditar con bastante precisión la calidad informativa y la integridad académica de un texto. La IA generativa tiene tres talones de Aquiles: las alucinaciones factuales, el plagio (directo o estructural) y la invención de referencias.

1. Comprobación de hechos y verificación de contenido

Los modelos de IA tienden a “alucinar”: inventan datos, estudios, fechas, cifras o declaraciones que suenan muy bien pero no corresponden a ninguna fuente real. Por eso, en una auditoría rigurosa es obligado someter las afirmaciones clave a verificación externa.

Buenas prácticas para auditar la veracidad de un texto, especialmente en español:

- Exigir y revisar fuentes trazables: si el texto menciona estudios, informes oficiales o datos numéricos, debe poder citar publicaciones, organismos o bases de datos concretos.

- Verificar en bases académicas en español: consultar Dialnet, SciELO, repositorios del CSIC o bases de datos universitarias para comprobar que los artículos citados existen y encajan con el tema.

- Usar verificadores de hechos: plataformas como Maldita.es, Newtral, AFP Factual o Chequeado cuentan con amplios archivos de desinformaciones ya analizadas.

- Contrastar con sitios oficiales: webs de ministerios, organismos reguladores, agencias sanitarias o instituciones internacionales (OMS, ONU, AEPD, etc.) son el estándar de referencia para políticas públicas, datos estadísticos o legislación.

En trabajos académicos o científicos, esto implica también revisar si el diseño metodológico descrito tiene sentido, si las muestras son plausibles, si las conclusiones se derivan lógicamente de los datos y si el lenguaje no exagera los resultados más allá de lo que los datos permiten.

2. Evaluar riesgo de plagio en contenidos apoyados por IA

Desde el punto de vista legal, el debate sobre si un software puede ser “autor” está abierto, pero desde la óptica académica y profesional hay una regla clara: atribuirte como propio un texto generado por IA sin indicarlo ni revisarlo es, como mínimo, una falta ética. Además, la IA puede incurrir en plagio si reproduce pasajes ajenos sin comillas ni referencia.

Una auditoría de plagio en la era de la IA debe contemplar:

- Uso de detectores de similitud: herramientas como Turnitin, Copyleaks u otras soluciones antiplagio siguen siendo útiles para localizar coincidencias textuales con fuentes existentes.

- Revisión cualitativa: incluso si no hay coincidencia literal, un texto puede reproducir la estructura argumental, el orden de secciones o el enfoque de un trabajo previo, lo que se conoce como “plagio estructural”.

- Claridad en la autoría y las ayudas usadas: las instituciones deberían definir si el uso de IA como asistente de redacción es aceptable siempre que se declare, y cómo debe hacerse esa declaración.

En el ámbito jurídico, se suele considerar plagio cuando se vulnera el derecho moral de paternidad: presentar como tuya una obra ajena, sin reconocer al verdadero autor humano. El software no es titular de derechos de autor, pero los humanos cuyos textos alimentan el modelo sí lo son. De ahí la importancia de formar al alumnado y a los profesionales en citación responsable y en límites de uso de contenidos generados.

3. Rastrear referencias bibliográficas ficticias

Uno de los fallos más llamativos de muchos LLM es su tendencia a fabricar referencias y citas científicas inexistentes. El modelo combina nombres de revistas prestigiosas, apellidos de investigadores conocidos y años plausibles para producir algo que parece real, pero no lo es.

En una auditoría de artículos científicos, informes técnicos o trabajos de fin de grado/master, conviene:

- Comprobar la existencia real de cada referencia en bases de datos como CrossRef (para DOIs), PubMed, Google Scholar, Web of Science, Scopus, Dialnet o SciELO.

- Verificar la correspondencia título-DOI: el identificador digital único debe llevar exactamente al artículo cuyo título figura en la bibliografía.

- Revisar la relevancia temática: una IA puede incluir artículos que contienen las mismas palabras clave del prompt, pero cuya temática no encaja realmente con el objeto central del texto.

- Comprobar la trayectoria de los autores citados: en ciencia es raro que un trabajo relevante provenga de autores completamente imposibles de rastrear; la inexistencia de currículos o publicaciones adicionales es un indicio preocupante.

Si una auditoría detecta numerosos estudios inexistentes, citas mal atribuidas o DOI falsos, es muy probable que el texto haya sido generado o al menos “decorado” por una IA sin supervisión adecuada, y conviene tratarlo con mucha cautela.

Auditoría de sesgos en textos y sistemas de IA

Más allá de los errores puntuales, los sistemas de IA pueden incorporar y amplificar de forma sistemática sesgos contra determinados grupos sociales. La auditoría de sesgos no se limita al texto final; requiere examinar el ciclo de vida completo del sistema y su interacción con el entorno.

1. Tipos de sesgo: preexistente, técnico y emergente

Para auditar un texto o un sistema generador conviene distinguir de dónde pueden venir los sesgos:

- Sesgo preexistente: procede de desigualdades y prejuicios sociales que ya estaban en la realidad y en los datos históricos (por ejemplo, menor representación de mujeres en puestos directivos o sobrerrepresentación policial de ciertos barrios).

- Sesgo técnico: se introduce por decisiones de diseño, muestreo, medición o modelado (por ejemplo, elegir umbrales que favorecen sistemáticamente a un grupo, o ignorar la representatividad de las muestras).

- Sesgo emergente: aparece cuando el sistema se despliega en el mundo real y se generan bucles de retroalimentación (por ejemplo, un algoritmo de predicción del crimen que envía más patrullas a un barrio, recoge más delitos y “confirma” su propia sospecha inicial).

En texto, esto se traduce en lenguaje discriminatorio, supuestos injustificados, ejemplos estereotipados o ausencia sistemática de ciertas perspectivas. Una auditoría debe buscar estos patrones y relacionarlos con el contexto de uso del sistema.

2. Auditoría por criterios: un marco inspirado en la auditoría financiera

En el terreno de la regulación (como la Ley Local 144 de Nueva York sobre herramientas automatizadas de decisión en empleo, o la Ley de IA de la Unión Europea), está ganando fuerza el modelo de “auditoría por criterios”, inspirado en las prácticas maduras de la auditoría financiera.

Este enfoque se sostiene en cuatro pilares:

- Criterios de auditoría claros, verificables y públicos: qué significa “equidad”, “no discriminación” o “calidad” debe traducirse en condiciones observables y medibles.

- Evaluadores externos cualificados e independientes: no basta con la autoevaluación; hace falta un tercero que no tenga conflicto de interés con la entidad auditada.

- Divulgación (al menos parcial) de los resultados: la transparencia, incluso en forma resumida, genera presión reputacional para mejorar y permite el escrutinio social.

- Formación y acreditación estándar de los auditores: como ocurre con la contabilidad, se necesitan profesionales formados en metodologías de auditoría, ética y técnicas de IA.

En la práctica, una auditoría por criterios de un sistema que genera o usa textos (por ejemplo, un filtro automatizado de currículums o una IA que ayuda a redactar diagnósticos médicos) combinaría:

- Análisis de impacto dispar: medir si el sistema trata peor a ciertos grupos (por género, edad, origen étnico, discapacidad, etc.).

- Evaluación de la gobernanza interna: políticas, comités éticos, documentación (tarjetas de modelo, fichas de datos), procesos de revisión humana.

- Valoración de riesgos sociotécnicos: escenarios de daño potencial, vulneraciones de derechos fundamentales, efectos secundarios no previstos.

Marcos como ISO/IEC 42001 (Sistemas de Gestión de IA) o ISO 25059 (Calidad de Sistemas de IA) empiezan a ofrecer referencias normalizadas para estructurar estas auditorías, aunque aún queda camino por recorrer.

3. Herramientas y prácticas para medir y mitigar sesgos

Los grandes proveedores tecnológicos (Google, Microsoft, IBM, entre otros) han lanzado toolkits de equidad, explicabilidad y robustez que facilitan la generación de evidencia auditable y existen iniciativas como estándar abierto para agentes que aportan criterios adicionales para gobernanza.

- Detección de sesgos: analizar el rendimiento del modelo o la calidad del texto según atributos sensibles o proxies (por ejemplo, comprobar si ciertos perfiles son sistemáticamente descritos en términos negativos).

- Mitigación en distintas fases: reequilibrar datos de entrenamiento (pre-procesamiento), modificar el algoritmo (in-procesamiento) o ajustar salidas (post-procesamiento) para reducir diferencias injustificadas.

- Explicabilidad: ofrecer argumentos comprensibles de por qué se generó cierto texto o se tomó cierta decisión, facilitando la revisión humana.

- Robustez: verificar que el sistema no se rompe ante entradas adversarias o manipuladas.

En la práctica diaria de auditoría de textos, un paso clave es preparar conjuntos de prueba representativos (incluidos ejemplos contrafactuales) y automatizar parte de las comprobaciones en los pipelines de desarrollo (MLOps), de forma que cada nueva versión del modelo pase por “puertas de calidad” que incluyan medición de sesgos.

Buenas prácticas para auditar textos de IA en educación, empresa y ciencia

Los retos son similares en universidades, empresas y revistas científicas, pero las prioridades cambian. Una auditoría sensata debe adaptarse al contexto sin perder de vista algunos principios comunes.

En educación, el riesgo mayor no es que un alumno listo se “cuelgue” de la IA, sino que se dañe la confianza entre profesorado y estudiantes por acusaciones injustas basadas en detectores poco fiables. Lo mismo ocurre en empresas con procesos de selección o evaluación del desempeño.

Algunas líneas de actuación recomendables:

- Rediseñar la evaluación hacia el proceso: trabajos por etapas, portafolios, escritos en clase, defensas orales breves y seguimiento del historial de versiones disminuyen la dependencia de un texto único y permiten entender cómo se ha construido.

- Integrar la IA como herramienta transparente: definir políticas claras sobre cuándo y cómo se puede usar IA, pedir a los autores que documenten los prompts utilizados y que expliquen en qué medida han corregido o contrastado el resultado.

- Combinar detectores con juicio experto: usar uno o varios detectores como señal previa, pero siempre complementados con lectura crítica, entrevistas y contraste de fuentes.

- Formar en alfabetización en IA y ética: enseñar a las personas a reconocer las limitaciones de estos sistemas, a verificar contenido y a entender las implicaciones de sesgos y alucinaciones.

En revistas científicas y congresos, además de todo lo anterior, tiene sentido incluir pases automáticos de resúmenes y manuscritos por detectores de salida de IA y antiplagio, acompañados de pautas editoriales que obliguen a verificar la existencia de referencias, la coherencia metodológica y el cumplimiento de estándares éticos (por ejemplo, Declaración de Helsinki, GDPR, normativa de protección de datos de salud, etc.).

También es crucial vigilar el ecosistema donde se publica el contenido: las granjas de contenido, webs que imitan medios de comunicación para publicar miles de piezas de baja calidad generadas por IA, se reconocen por su nombre genérico, saturación de anuncios, ausencia de información sobre autores y mezcla de temas dispares. En una auditoría de información pública, identificar estas fuentes como poco fiables ahorra muchos sustos.

En última instancia, auditar un texto generado por IA no consiste en jugar a detective tecnológico, sino en restaurar algo tan básico como la confianza: saber quién asume la responsabilidad de lo escrito, qué evidencias lo respaldan y cómo se han mitigado los daños potenciales. Si combinamos métodos técnicos, revisión humana y marcos éticos sólidos, la IA puede convertirse en una aliada poderosa para escribir mejor, siempre que no olvidemos que el criterio final tiene que seguir siendo humano.

Apasionado de la tecnología desde pequeñito. Me encanta estar a la última en el sector y sobre todo, comunicarlo. Por eso me dedico a la comunicación en webs de tecnología y videojuegos desde hace ya muchos años. Podrás encontrarme escribiendo sobre Android, Windows, MacOS, iOS, Nintendo o cualquier otro tema relacionado que se te pase por la cabeza.