- SAM 3 segmenta con prompts de texto detallados e integra visión y lenguaje para mayor precisión.

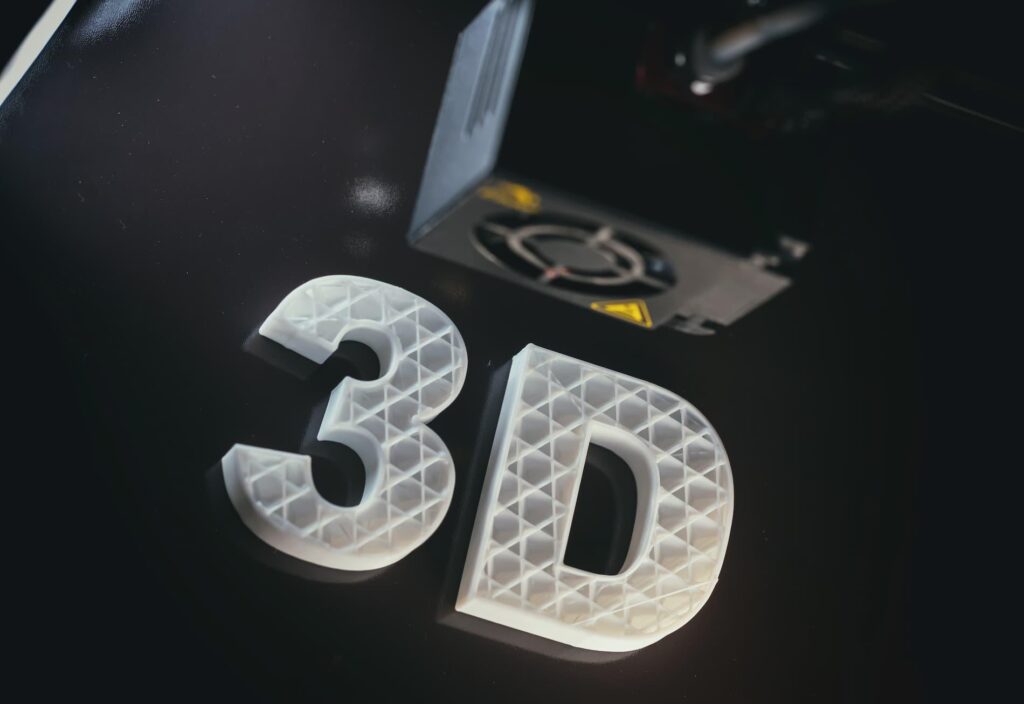

- SAM 3D reconstruye objetos y cuerpos en 3D desde una sola imagen con recursos abiertos.

- Playground permite probar segmentación y 3D sin conocimientos técnicos ni instalación.

- Aplicaciones en Edits, Marketplace y ámbitos como educación, ciencia y deporte.

¿Cómo convertir personas y objetos en modelos 3D con SAM 3D? La inteligencia artificial aplicada a lo visual está pegando fuerte y, ahora, además de recortar objetos con precisión, es posible convertir una sola imagen en un modelo 3D listo para explorar desde múltiples ángulos. Meta ha presentado una nueva generación de herramientas que cruzan edición, comprensión del mundo visual y reconstrucción tridimensional sin necesidad de equipos ni conocimientos avanzados.

Hablamos de SAM 3 y SAM 3D, dos modelos que llegan para mejorar la detección, el seguimiento y la segmentación, y para llevar la reconstrucción 3D de objetos y personas a un público amplio. Su propuesta pasa por entender instrucciones de texto y señales visuales al mismo tiempo, de forma que recortar, transformar y reconstruir elementos sea tan fácil como escribir lo que queremos o hacer unos pocos clics.

Qué son y en qué se diferencian SAM 3 y SAM 3D

La familia Segment Anything de Meta crece con dos novedades: SAM 3 y SAM 3D. El primero se enfoca en identificar, seguir y segmentar objetos en fotos y vídeos con una precisión de nueva generación, mientras que el segundo reconstruye geometría y apariencia en 3D a partir de una sola imagen, incluyendo personas, animales o productos cotidianos.

La diferencia funcional es clara: SAM 3 resuelve la parte de “comprender y separar” el contenido visual, y SAM 3D toma ese entendimiento para “levantar” un volumen tridimensional. Con esta dupla, un flujo que antes requería software complejo o escáneres especializados se vuelve mucho más accesible y rápido.

Además, SAM 3 no se limita a prompts visuales básicos. Aporta una segmentación guiada por lenguaje natural capaz de interpretar descripciones muy precisas. Ya no hablamos solo de “coche” o “balón”, sino de frases como “gorra de béisbol roja” para localizar justo esos elementos en una escena, incluso a lo largo de un vídeo.

Por su parte, SAM 3D llega en dos sabores complementarios: SAM 3D Objects, centrado en objetos y escenas, y SAM 3D Body, entrenado para estimar forma y cuerpo humano. Esa especialización permite cubrir desde objetos de consumo hasta retratos y poses, abriendo la puerta a aplicaciones creativas, comerciales y científicas.

Cómo logran segmentar y reconstruir desde una sola imagen

La clave está en una arquitectura entrenada con grandes volúmenes de datos para establecer vínculos directos entre palabras y píxeles. El modelo entiende indicaciones escritas y señales visuales (clics, puntos o cajas) a la vez, de manera que traduce una petición en áreas precisas de una foto o un fotograma de vídeo.

Ese entendimiento del lenguaje va más allá de los nombres de clase tradicionales. SAM 3 puede manejar instrucciones complejas, exclusiones y matices, lo que habilita consultas del estilo “personas sentadas que no llevan una gorra roja”. Esta compatibilidad con prompts de texto detallados resuelve una limitación histórica de los modelos anteriores, que tendían a confundir conceptos granulares.

Luego entra en juego SAM 3D: partiendo de una imagen, genera un modelo tridimensional que permite ver el objeto desde otras perspectivas, reorganizar la escena o aplicar efectos 3D. En la práctica, se integra con la segmentación previa para aislar lo que nos interesa y, con ello, reconstruir en 3D sin pasos intermedios complicados.

Novedades frente a generaciones anteriores

En su día, SAM 1 y SAM 2 cambiaron las reglas de la segmentación apoyándose sobre todo en indicaciones visuales. Sin embargo, tropezaban cuando les pedíamos interpretaciones largas o instrucciones en lenguaje natural con ciertos matices. SAM 3 rompe ese techo incorporando comprensión multimodal que conecta texto y visión de forma más directa.

Meta acompaña el avance con un nuevo benchmark de segmentación de vocabulario abierto, pensado para evaluar la segmentación guiada por texto en escenarios reales, y con la publicación de los pesos de SAM 3. De este modo, investigadores y desarrolladores pueden medir con rigor y comparar resultados entre métodos.

En reconstrucción, SAM 3D Objects mejora significativamente frente a enfoques anteriores según los datos compartidos por Meta, que también libera puntos de control, código de inferencia y un conjunto de evaluación. Junto a SAM 3D Body, la compañía publica SAM 3D Artist Objects, un nuevo dataset creado con artistas para valorar la calidad 3D en imágenes muy variadas.

Aplicaciones reales y casos de uso inmediatos

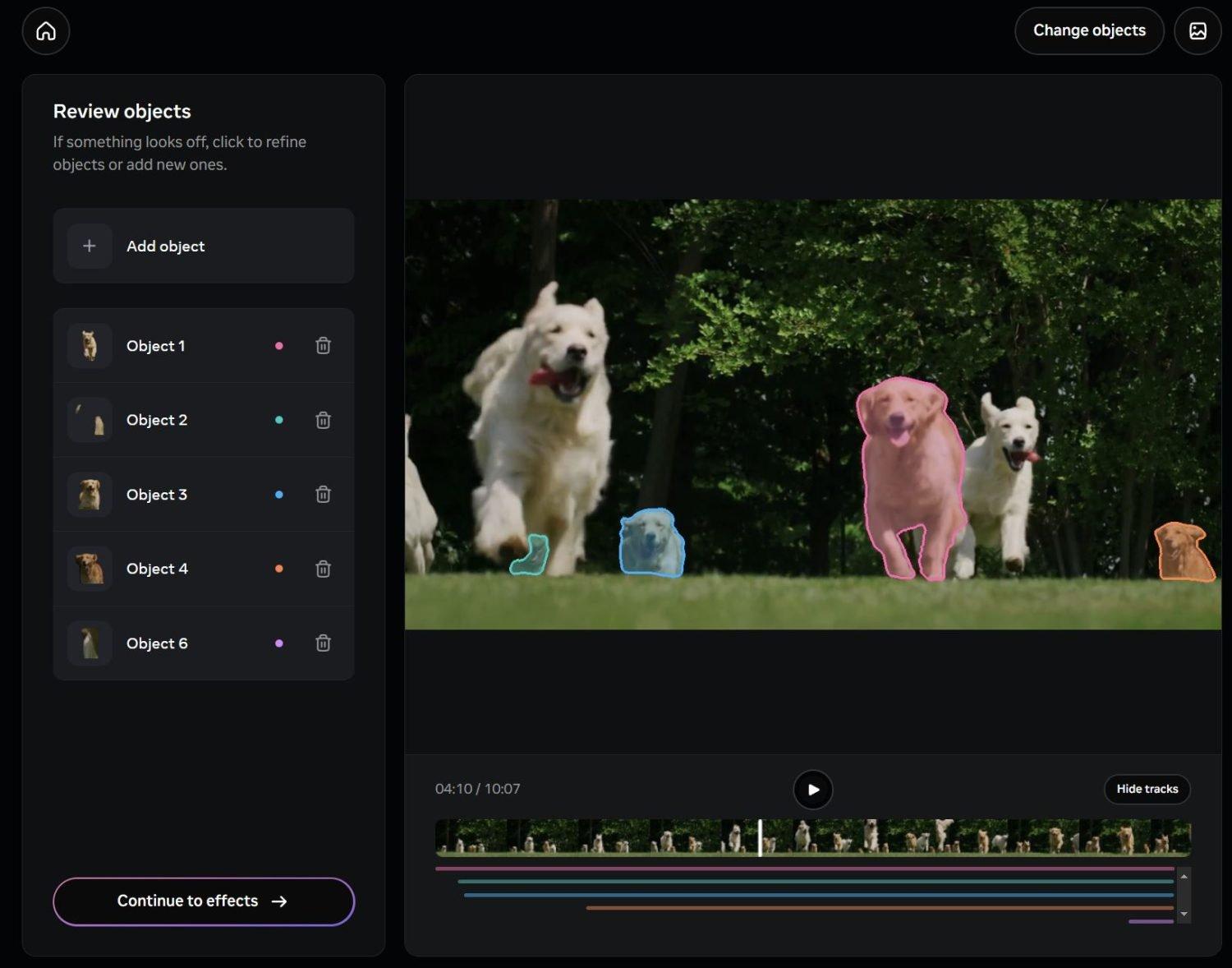

Meta está integrando estas capacidades en sus productos. En “Edits”, su herramienta de vídeo para Instagram y Facebook, ya se aprovecha la segmentación avanzada para aplicar efectos sobre personas u objetos concretos sin tocar el resto de la imagen. Esto facilita cambios de fondo, filtros selectivos o transformaciones puntuales sin sacrificar calidad.

También veremos estas funciones en Vibes, dentro de la app Meta AI y en la plataforma meta.ai, con nuevas experiencias de edición y creatividad. Al permitir indicaciones complejas, el usuario puede describir lo que quiere modificar y el sistema automatiza tareas de posproducción que antes eran laboriosas.

En comercio, destaca “View in Room” de Facebook Marketplace, que ayuda a visualizar cómo quedarían muebles o lámparas en casa gracias a modelos 3D generados automáticamente. Esta funcionalidad reduce incertidumbre y mejora la decisión de compra, un punto clave cuando no podemos ver el producto físicamente.

El impacto se extiende a robótica, ciencia, educación y medicina deportiva. La reconstrucción 3D desde fotografías simples puede alimentar simuladores, crear modelos anatómicos de referencia y apoyar herramientas de análisis que antes exigían equipamiento específico. Todo ello promueve nuevos flujos de trabajo en investigación y formación.

Segment Anything Playground: prueba y crea sin fricción

Para democratizar el acceso, Meta ha lanzado Segment Anything Playground, una web donde cualquiera puede subir imágenes o vídeos y experimentar con SAM 3 y SAM 3D. Su interfaz recuerda a la “varita mágica” de los editores clásicos, con la ventaja de que podemos escribir lo que deseamos seleccionar o refinar con unos clics.

Además, el Playground ofrece plantillas listas para usar. Entre ellas hay opciones prácticas como pixelar rostros o matrículas, y efectos más creativos como trails de movimiento o spotlight. Esto hace que tareas de protección de identidad o efectos llamativos se consigan en segundos.

Más allá de segmentar, el usuario puede explorar escenas desde nuevas perspectivas, reorganizarlas o aplicar efectos tridimensionales con SAM 3D. El objetivo es que cualquiera, sin saber de 3D ni de visión por computador, pueda lograr resultados aceptables en minutos y sin instalar nada.

Modelos, recursos abiertos y evaluación

Meta ha liberado recursos para que la comunidad impulse el estado del arte. Para SAM 3, están disponibles los pesos del modelo junto con un benchmark de vocabulario abierto y un paper técnico que detalla la arquitectura y el entrenamiento. Esto facilita reproducibilidad y comparativas justas.

En el frente 3D, la compañía ha publicado puntos de control, código de inferencia y un conjunto de evaluación de nueva generación. La dualidad SAM 3D Objects y SAM 3D Body permite cubrir objetos generales y cuerpo humano con métricas adaptadas a cada caso, algo imprescindible para valorar la fidelidad geométrica y visual.

La colaboración con artistas para crear SAM 3D Artist Objects introduce un criterio estético y de diversidad en la evaluación, no solo técnico. Esto es clave para que la reconstrucción 3D sea útil en entornos creativos y comerciales, donde la calidad percibida por personas marca la diferencia.

Segmentación por texto: ejemplos y ventajas

Con SAM 3, es posible escribir “gorra de béisbol roja” y que el sistema identifique todas las coincidencias en una imagen o a lo largo de un vídeo. Esta precisión abre la puerta a flujos de edición donde bastan frases cortas y claras para separar elementos y aplicarles efectos o transformaciones.

La compatibilidad con modelos de lenguaje multimodal permite instrucciones más ricas, incluidas exclusiones o condiciones (“personas sentadas que no llevan una gorra roja”). Esta flexibilidad reduce horas de trabajo manual y disminuye errores de selección que antes se corregían a mano.

Para equipos que crean contenido a gran escala, la segmentación guiada por texto acelera pipelines y facilita estandarizar resultados. En marketing, por ejemplo, se puede mantener consistencia al aplicar filtros a una familia de productos, algo que mejora tiempos y costes de producción.

Edición en redes sociales y creatividad digital

La integración en Edits acerca funciones de posproducción avanzada a creadores de Instagram y Facebook. Un filtro que antes requería máscaras complejas ahora puede aplicarse con una instrucción de texto y unos clics, manteniendo los bordes y detalles finos de forma estable fotograma a fotograma.

Para piezas cortas, donde el ritmo de publicación importa, esta automatización es oro. Cambiar el fondo de un clip, resaltar solo a una persona o transformar un objeto concreto ya no exige flujos de trabajo artesanales, y eso democratiza efectos que antes eran exclusivos de profesionales.

En paralelo, Vibes y meta.ai amplían el abanico de experiencias con edición y creatividad guiadas por lenguaje. Al poder describir con detalle lo que queremos, el salto de la idea al resultado se acorta, lo que se traduce en más iteraciones creativas en menos tiempo.

Comercio, ciencia y deporte: más allá del entretenimiento

“View in Room” en Facebook Marketplace ejemplifica el valor práctico: ver una lámpara o un mueble en tu salón antes de comprar reduce devoluciones y da confianza. Detrás hay un pipeline que, partiendo de imágenes, genera un modelo 3D para visualización contextual.

En ciencia y educación, reconstruir desde fotos simples abarata la creación de materiales didácticos y simuladores realistas. Un modelo anatómico generado por IA puede servir de apoyo en clases o en análisis biomecánicos, acelerando la preparación de contenidos.

En medicina deportiva, la combinación de estimación del cuerpo con reconstrucción de la forma brinda herramientas para estudiar posturas y movimientos sin equipamiento caro. Eso abre posibilidades para evaluaciones más frecuentes y seguimientos remotos.

Privacidad, ética y buenas prácticas

La potencia de estas herramientas exige responsabilidad. Manipular imágenes de personas sin consentimiento puede acarrear problemas legales y éticos. Lo recomendable es evitar reconstruir rostros ajenos, no compartir modelos sin permiso y no alterar escenas sensibles que puedan causar confusión o daño.

Meta anuncia controles para mitigar usos indebidos, pero la responsabilidad final recae en quien utiliza la tecnología. Conviene verificar la procedencia de las imágenes, proteger datos personales y valorar el contexto antes de publicar modelos 3D que puedan exponer información privada.

En entornos profesionales, establecer políticas de revisión y consentimiento, y etiquetar claramente contenidos generados por IA, contribuye a un uso responsable. La formación del equipo en estos temas ayuda a prevenir malas prácticas y a responder con rapidez ante incidencias.

Cómo convertir personas y objetos en modelos 3D con SAM 3D: Cómo empezar

Si quieres experimentar ya, el Segment Anything Playground es la puerta de entrada. Allí puedes cargar una foto o un vídeo, escribir qué deseas seleccionar y probar opciones de reconstrucción 3D bajo una interfaz sencilla. Para perfiles técnicos, están disponibles pesos, checkpoints y código que facilitan pruebas a medida.

Investigadores, desarrolladores y artistas cuentan con un ecosistema que incluye benchmarks, datasets de evaluación y documentación. El objetivo es sentar bases comunes para medir progreso y acelerar la adopción en diferentes sectores, desde la creatividad digital hasta la robótica.

Lo más interesante es que este salto no queda reservado a especialistas: la curva de aprendizaje se reduce y las funciones llegan a apps cotidianas. Todo apunta a que la edición y el 3D seguirán integrándose en flujos donde el lenguaje natural es la interfaz.

Con SAM 3 y SAM 3D, Meta acerca segmentación por texto y reconstrucción desde una sola imagen a creadores y equipos de todos los tamaños. Entre el Playground, la integración en Edits, los recursos abiertos y las aplicaciones en comercio, educación y deporte, se está consolidando una nueva forma de trabajar con imágenes y volumen que combina precisión, accesibilidad y responsabilidad.

Apasionado de la tecnología desde pequeñito. Me encanta estar a la última en el sector y sobre todo, comunicarlo. Por eso me dedico a la comunicación en webs de tecnología y videojuegos desde hace ya muchos años. Podrás encontrarme escribiendo sobre Android, Windows, MacOS, iOS, Nintendo o cualquier otro tema relacionado que se te pase por la cabeza.