- Stable Diffusion 3 mantiene un ecosistema abierto para ejecutar y personalizar modelos en tu PC con total control.

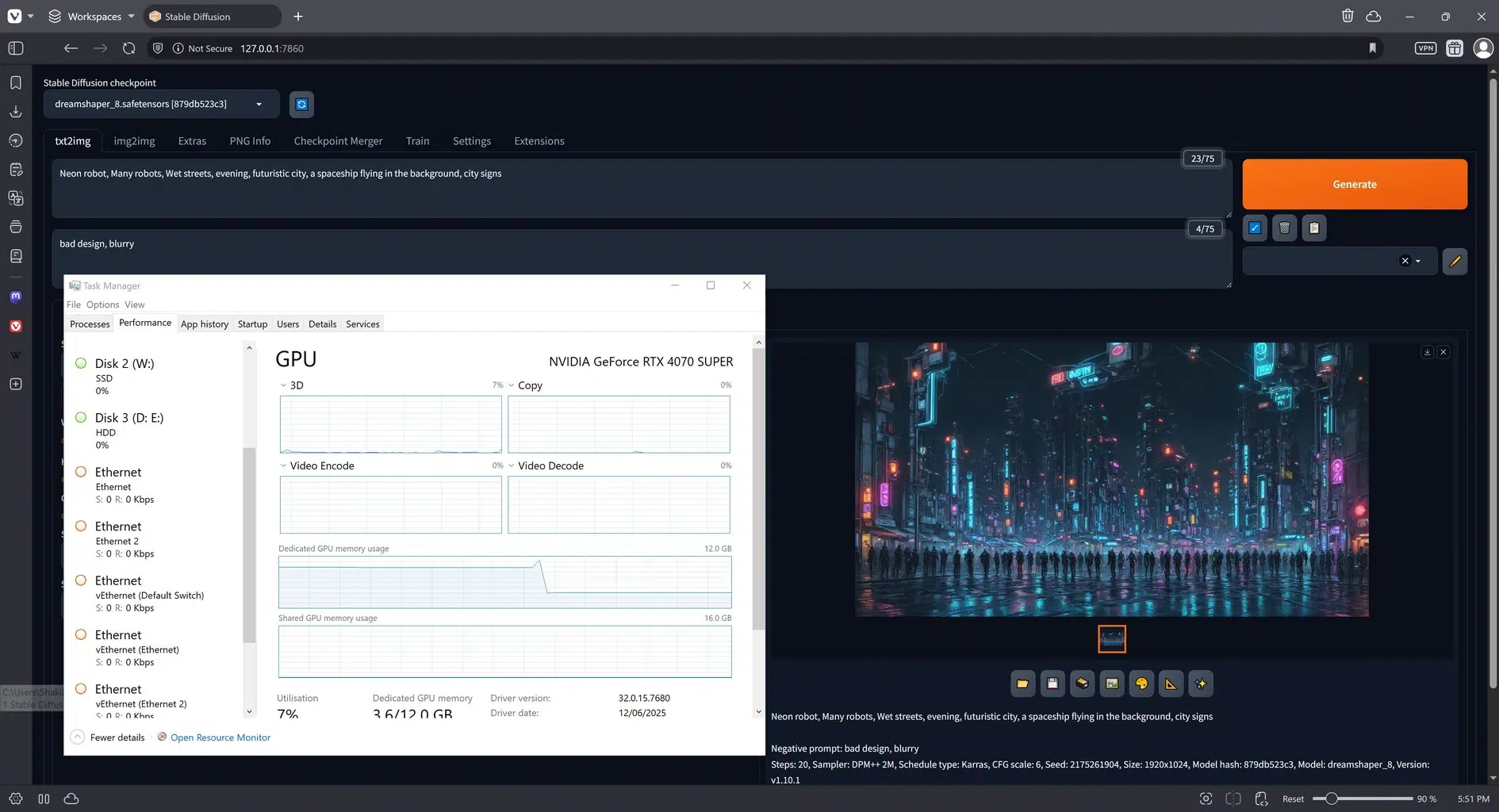

- Con 8 GB de VRAM o más obtendrás mejor rendimiento; también es posible usar CPU para pruebas básicas.

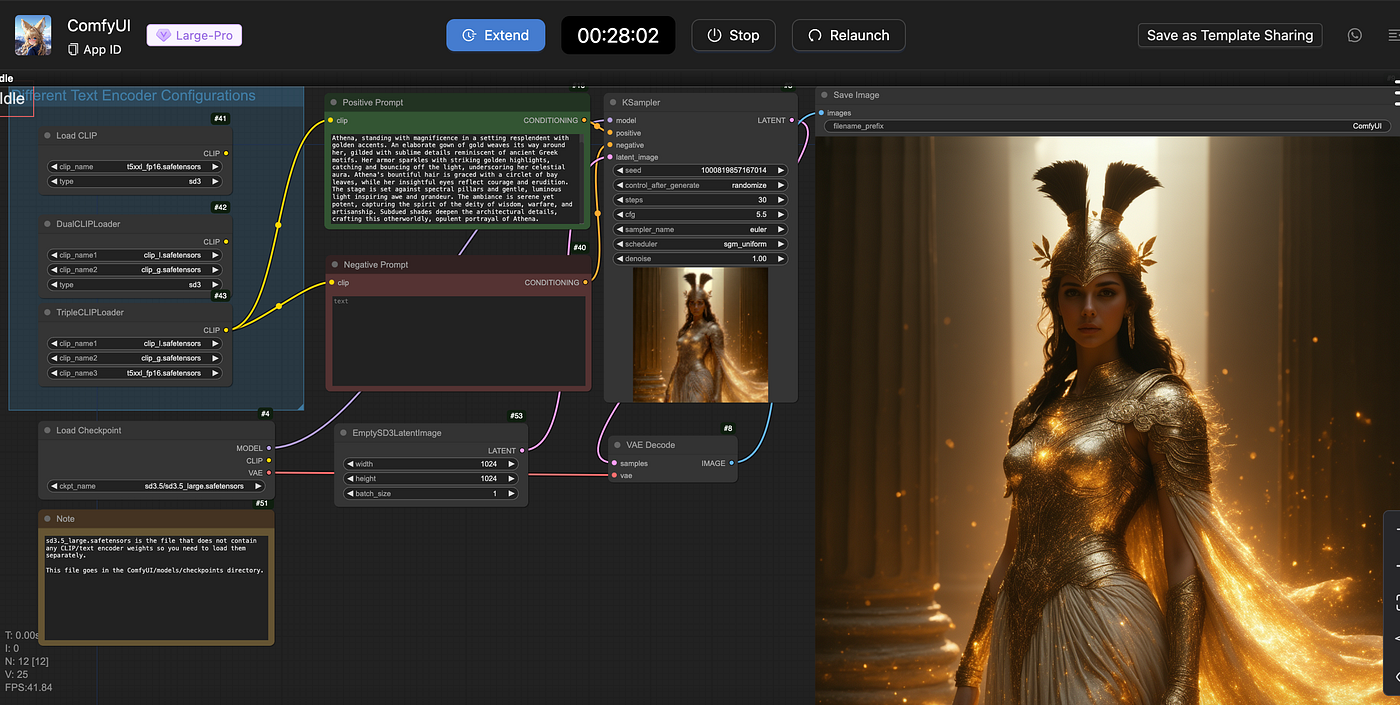

- La interfaz permite ajustar sampler, pasos, guidance y VAEs para afinar estilo, detalle y coherencia.

- Instala modelos (.ckpt/.safetensors) desde fuentes fiables y aprovecha hypernetworks y upscale para resultados pro.

Para crear imágenes espectaculares con IA desde tu ordenador, Stable Diffusion 3 es una de las opciones más interesantes. Por su flexibilidad, calidad y ecosistema de modelos. En esta guía te explico cómo ponerlo a funcionar en tu equipo, qué necesitas para que vaya fino y cómo exprimir su interfaz paso a paso para que te sientas como en casa desde el primer minuto.

Qué es Stable Diffusion 3 y por qué merece la pena

Stable Diffusion es un modelo de generación de imágenes a partir de texto que se ha convertido en un estándar de facto por su naturaleza abierta, su calidad y la cantidad de herramientas que lo rodean. Con la evolución a Stable Diffusion 3 (SD3), se mantiene la filosofía de que cualquiera pueda descargar modelos, combinarlos y ejecutarlos localmente, lo cual brinda independencia y control frente a alternativas cerradas.

La gran ventaja de Stable Diffusion 3 sigue siendo que puedes operar en local, sin depender de servidores externos: ejecutas los modelos en tu PC, eliges qué instalar, qué actualizar y cómo guardar tus resultados. Además, el ecosistema permite trabajar con modelos personalizados (entrenados para estilos, géneros o sujetos concretos) y con utilidades complementarias para refinar caras, ojos o aumentar resolución.

Para facilitarte la vida, en esta guía nos apoyaremos en una interfaz sencilla y visual como Easy Diffusion, que simplifica la instalación y el uso. Aunque Stable Diffusion 3 puede requerir compatibilidad específica según la interfaz elegida, el flujo y los conceptos de trabajo que verás aquí te servirán tanto para SD3 como para versiones cercanas del modelo, con la ventaja de que no necesitas conocimientos avanzados para empezar a generar imágenes desde el primer día.

Requisitos mínimos y recomendados

La instalación con Easy Diffusion es muy directa, similar a la de cualquier programa de escritorio. Dicho esto, conviene revisar primero los requisitos para evitar sorpresas y dimensionar bien tus expectativas de rendimiento y calidad.

Como mínimo, necesitarás un procesador (CPU), 8 GB de RAM y al menos 25 GB de almacenamiento libre. La herramienta puede funcionar incluso sin GPU dedicada, ya que es posible forzar el renderizado por CPU, aunque la velocidad será muy baja; para pruebas y salidas a baja resolución puede bastar.

Si usas gráficos integrados, procura que cuenten con al menos 2 GB de memoria de vídeo. En caso contrario, quizá te interese forzar el modo CPU para evitar fallos por falta de memoria, teniendo claro que los tiempos de generación serán más largos.

Para un uso fluido y resoluciones más altas, lo ideal es contar con una GPU dedicada (NVIDIA o AMD). De forma realista, se recomienda disponer de 8 GB de VRAM o más. Cuanta más VRAM, más rápido podrás trabajar, mayor resolución soportarás en cada pasada y más opciones avanzadas podrás activar sin cuellos de botella. Además, ayuda contar con un bus de memoria rápido en la gráfica.

Instalación paso a paso con Easy Diffusion (Windows)

Aunque también puedes usar Linux o macOS, aquí nos centraremos en Windows por ser el entorno más habitual. El procedimiento es muy sencillo y apenas requiere seguir unas cuantas pantallas del instalador.

- Descarga del instalador. Visita el repositorio de Easy Diffusion (por ejemplo, en GitHub) y elige el paquete correspondiente a tu sistema operativo. En nuestro caso, selecciona la versión para Windows. Guarda el archivo en una carpeta fácil de localizar.

- Ejecución e instalación. Abre el instalador y ve avanzando con el botón “Next” para aceptar los pasos. No hay trucos aquí: simplemente sigue el asistente y mantén la configuración por defecto a menos que tengas requisitos concretos.

- Elige la ubicación correcta. Es importante instalarlo en una carpeta en la raíz de una unidad (por ejemplo, C:/Easy-Diffusion). El instalador descargará dependencias adicionales durante el proceso, así que deja que termine aunque tarde un poco. Al finalizar, marca la opción de crear acceso directo en el escritorio para que te sea más cómodo iniciar la herramienta.

Con la instalación completada, puedes lanzar la interfaz desde el icono del escritorio o abriendo la carpeta de instalación y ejecutando el script llamado “Start Stable Diffusion UI”. A partir de aquí, el sistema preparará todo lo necesario para abrir la aplicación en el navegador.

Primera ejecución e interfaz: lo que verás

Al iniciar, se abrirá una ventana negra del CMD que permanecerá activa mientras uses el programa. No la cierres, porque es el proceso principal que se encarga de cargar modelos y gestionar la cola de render.

En cuanto el backend esté listo, se abrirá de forma automática tu navegador por defecto con la interfaz. A veces puede tardar un poco si tiene que verificar o reinstalar componentes.

La interfaz se organiza en varias pestañas. Las dos principales son “Generate” (donde crearás imágenes) y “Settings” (ajustes generales). Además, verás “Help and Community” (enlaces a documentación y recursos), “Merge Models” (para combinar modelos de IA) y “What’s new?” (registro de cambios de Easy Diffusion). Con el tiempo suelen añadirse más pestañas para nuevas funciones.

En la esquina superior derecha suele aparecer un indicador de estado que te dirá si el sistema está generando, si está listo o si se ha producido algún error. Es un buen punto de referencia para saber qué está ocurriendo en segundo plano en cada momento.

Configuración esencial en “Settings”

Antes de lanzarte a generar, conviene dar un repaso rápido a los ajustes. Cambiar estas opciones puede marcar la diferencia entre una experiencia fluida y otra llena de esperas. Aquí tienes los más relevantes:

- Auto-Save Images: habilita el guardado automático de todo lo que produzcas. Puedes elegir la carpeta de destino y el formato de los metadatos para conservar la información de generación.

- Block NSFW Images: activa un difuminado para contenido adulto que pueda aparecer; útil si compartes equipo o quieres evitar sorpresas.

- GPU Memory Usage: ajusta la huella de VRAM: Low (2-4 GB), Balanced (4-8 GB) o Fast (>8 GB). Si vas justo de memoria, empieza en “Low”.

- Use CPU: fuerza el renderizado con el procesador. Solo recomendable en equipos sin GPU dedicada y para pruebas, ya que es muy lento. Si tienes GPU, no lo actives.

- Confirm dangerous actions: solicita confirmación al borrar archivos u operaciones que impliquen pérdida de datos dentro de la interfaz.

- Make Stable Diffusion available on your network: abre el servicio en tu red local para acceder desde otros dispositivos. Consulta las “Server Addresses” al final de la página para ver la dirección exacta y el puerto.

Cuando termines de tocar la configuración, no te olvides de pulsar “Save” para aplicar cambios. Justo debajo verás también un resumen del hardware detectado por la aplicación.

Generar imágenes con Stable Diffusion 3

Ya en la pestaña “Generate”, verás un campo de texto grande bajo “Enter Prompt”. Ahí escribirás la descripción de lo que quieres conseguir. Es recomendable redactar el prompt en inglés para obtener mejores resultados; si lo prefieres, usa un traductor, copia la frase en inglés y pégala tal cual.

Cuando tengas tu prompt listo, pulsa el botón morado “Make Image” para poner en cola la generación. Justo debajo encontrarás “Negative Prompt”, que sirve para indicar lo que NO deseas que aparezca (por ejemplo: “blurry, low quality, deformed hands”).

Si solo hicieras esto, ya podrías producir piezas interesantes. Pero la magia de Stable Diffusion 3 y su ecosistema está en los parámetros avanzados de generación. Bajo el botón de crear imagen verás varios desplegables con gran cantidad de ajustes que modifican el comportamiento del modelo, el estilo, la nitidez, etc.

Recuerda que la IA es sensible al texto de entrada y a la configuración del sampler y los pasos. No hay una receta universal: experimenta y toma notas de qué funciona con cada temática o estilo, y no dudes en iterar cambiando una sola variable para entender su impacto real.

Ajustes de imagen paso a paso

Estos controles definen cómo se construyen tus imágenes. Úsalos con cabeza y, si te atascas, prueba primero con valores por defecto y ve subiendo. Los más importantes son:

- Seed: la semilla que alimenta el proceso estocástico. Puedes dejar “Random” para obtener variaciones en cada render. Si quieres repetir un resultado, guarda la semilla.

- Number of Images: determina cuántas imágenes se generan y cuántas se procesan en paralelo. Ojo: el número en paralelo debe ser múltiplo del total. Si no lo es, el render puede no terminar y tendrás que reiniciar la app.

- Model: elige el modelo de Stable Diffusion que quieres usar. Si tienes varias versiones (SD3, SDXL, checkpoints especializados, etc.), selecciónalo aquí.

- Custom VAE: añade un VAE específico para mejorar ciertos rasgos (por ejemplo, ojos o caras). Es un complemento muy útil para estilos concretos.

- Sampler: es el algoritmo que retira el ruido y “converge” la imagen final. Cambiar de sampler puede alterar el carácter del resultado; algunos son más rápidos y otros más deterministas.

- Image Size: define el ancho y el alto en píxeles. Para empezar, mantener una relación 1:1 suele dar resultados fiables y evita problemas de VRAM.

- Inference Steps: número de pasos de muestreo. Más pasos tienden a mejorar la calidad, aunque llega un punto de rendimientos decrecientes. Ajusta en función del sampler elegido.

- Guidance Scale: controla cuánto se ciñe la imagen al prompt. Valores altos siguen el texto al pie de la letra; valores bajos dan más libertad creativa.

- Hypernetwork: modificadores que adaptan la generación a un estilo concreto. Útiles para dirigir la estética sin rehacer el prompt.

- Output Format: el formato (PNG, JPG, etc.) de la salida final.

- Image Quality: calidad del formato (por ejemplo, compresión JPG). No cambia la calidad intrínseca de la imagen generada, solo su presentación/archivo.

- Render Settings: opciones como previsualización en vivo (consume VRAM), arreglo de caras/ojos, escalado a mayor resolución (elige factor y método) y si conservar o sustituir la imagen original tras el upscale.

Una buena táctica es fijar tamaño y sampler, probar varios steps y guidance, y solo entonces tocar VAEs o hypernetworks. Así sabrás qué parámetro aporta de verdad y evitarás perderte en combinaciones infinitas.

Modificadores de estilo

En la sección de modificadores podrás activar estilos visuales predeterminados que cambian el acabado de la obra (más realista, más ilustración, más fotográfico, etc.). Aunque la descripción aparezca en inglés, el icono asociado ayuda a identificar qué hace cada uno. No son las únicas posibilidades: puedes escribir a mano estilos, técnicas o artistas en el prompt para ampliar el abanico.

La clave está en combinarlos con cabeza. Si mezclas demasiados estilos, el modelo puede “tirar” de uno u otro aleatoriamente. Mejor empieza con un único modificador y añade otro si buscas un toque más específico.

Opciones sobre imágenes ya generadas

Cuando pases el cursor por encima de una miniatura, aparecerán varias utilidades. Con “Use as Input” reutilizas la configuración empleada para crear esa imagen y generas variantes coherentes. Con “Make Similar Images” el sistema produce versiones parecidas a la seleccionada.

También podrás descargar la imagen en el formato establecido o el JSON con toda la configuración usada (semilla incluida). Es muy práctico para compartir ajustes con otras personas o para documentar tus mejores hallazgos.

Si ves una pieza prometedora y quieres apurarla un poco más, la opción “Draw another 25 Steps” añade 25 pasos extra para refinar detalles. Y cuando la tengas, conviene aplicar “Upscale” para aumentar resolución con el método de escalado que prefieras.

Generación a partir de imágenes y bocetos

Además del texto, con Stable Diffusion 3 también puedes usar imágenes como guía de la IA. Tienes dos vías: partir de una imagen ya generada o subir una foto/ilustración desde tu ordenador para que la IA la interprete y transforme según el prompt.

Si eliges la opción “Draw”, podrás pintar un boceto rápido y emplearlo como base. El modelo intentará respetar la composición general del dibujo y lo completará con los detalles necesarios según el texto de entrada. Al principio cuesta pillarle el punto, pero con práctica lograrás resultados muy sólidos.

Notas específicas sobre Stable Diffusion 3

Aunque el flujo explicado te servirá para ponerte manos a la obra, recuerda que Stable Diffusion 3 puede requerir recursos mayores y compatibilidad concreta según la interfaz que uses. Si trabajas con checkpoints y pipelines pensados específicamente para SD3, revisa la documentación de tu UI para confirmar soporte y requisitos de VRAM.

La buena noticia es que la lógica de trabajo no cambia: prompts claros, control de sampler, pasos, guidance y tratamiento de salida (VAEs, upscale, etc.). Si una interfaz no soporta aún un checkpoint de SD3, puedes usar modelos compatibles intermedios o mantenerte en versiones previas mientras añades funciones clave de esta guía a tu rutina.

Cómo desinstalar (y limpiar) cuando ya no lo necesites

Si en algún momento decides dejar de usar la herramienta, basta con eliminar la carpeta donde la instalaste. No hay que pasar por un desinstalador complejo: borra el directorio y listo. Si guardaste modelos o salidas en rutas personalizadas, recuerda hacer copia antes por si quieres recuperarlos más adelante.

Con todo esto, ya tienes el itinerario completo para trabajar con Stable Diffusion 3 en tu PC: desde los requisitos hasta la instalación, pasando por los ajustes vitales de la interfaz, el control fino de parámetros y la ampliación con modelos y VAEs. Si te organizas bien, podrás iterar rápido, documentar tus mejores combinaciones y obtener resultados sólidos sin depender de servicios externos, con la tranquilidad de que todo corre en tu equipo.

Redactor especializado en temas de tecnología e internet con más de diez años de experiencia en diferentes medios digitales. He trabajado como editor y creador de contenidos para empresas de comercio electrónico, comunicación, marketing online y publicidad. También he escrito en webs de economía, finanzas y otros sectores. Mi trabajo es también mi pasión. Ahora, a través de mis artículos en Tecnobits, intento explorar todas las novedades y nuevas oportunidades que el mundo de la tecnología nos ofrece día a día para mejorar nuestras vidas.