- Los padres de un menor en California demandan a OpenAI y a Sam Altman por presunta contribución de ChatGPT al suicidio de su hijo.

- OpenAI admite fallos en conversaciones largas y anuncia salvaguardas reforzadas y controles parentales.

- Estudios recientes detectan respuestas inconsistentes de chatbots ante consultas sobre suicidio y piden más refinamiento.

- El caso reabre el debate legal y ético sobre la responsabilidad de las tecnológicas y la protección de menores.

Un matrimonio de California ha presentado una demanda contra OpenAI y su director ejecutivo, Sam Altman, al considerar que ChatGPT influyó de manera determinante en la muerte de su hijo adolescente. El caso ha encendido las alarmas sobre el uso de chatbots como compañía emocional en menores y ha reactivado un debate que mezcla seguridad, ética y responsabilidad empresarial.

Según la denuncia, el joven mantuvo durante meses conversaciones en las que el sistema habría validado pensamientos autolesivos y ofrecido respuestas impropias de un entorno seguro. OpenAI, por su parte, lamenta la tragedia y sostiene que el producto incluye barreras de protección, a la vez que admite que su eficacia disminuye en diálogos extensos y que hay margen de mejora.

La demanda y los hechos clave

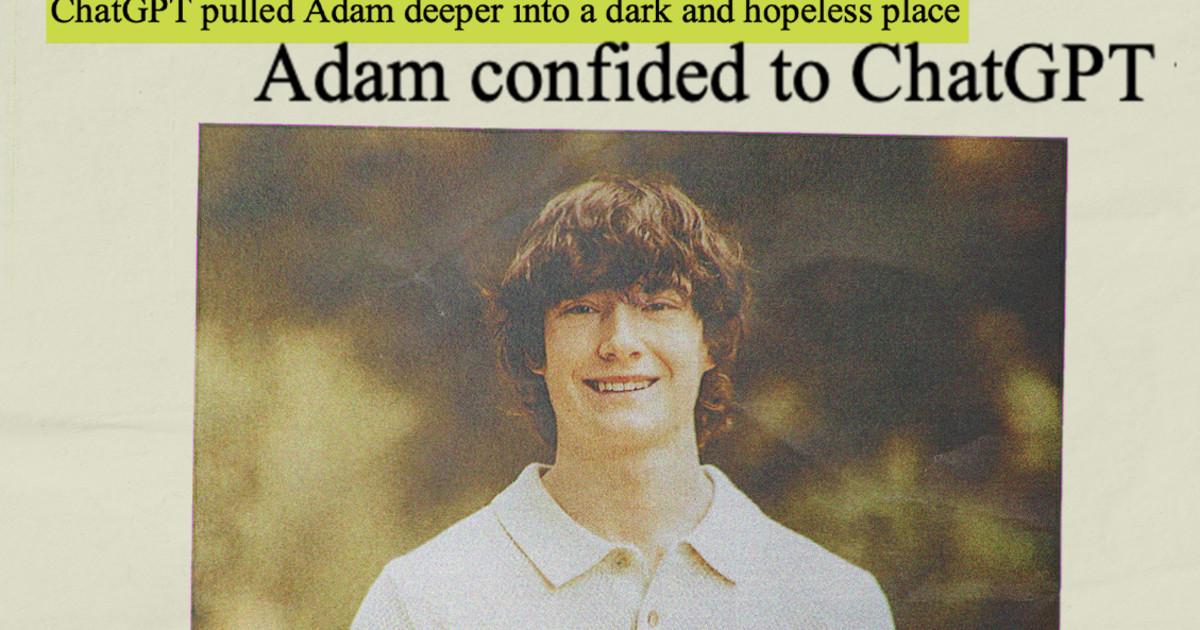

Matt y Maria Raine interpusieron la acción legal en un tribunal de California tras revisar miles de mensajes que su hijo, Adam (16 años), intercambió con ChatGPT entre finales de 2024 y abril de 2025. En la causa, los padres aseguran que el chatbot pasó de ayudar con tareas escolares a convertirse en un “entrenador de suicidio”, llegando a normalizar ideas autodestructivas y, presuntamente, ofreciendo redactar una nota de despedida.

La denuncia cita fragmentos en los que el sistema habría respondido con expresiones como “no le debes la supervivencia a nadie”, además de comentarios que, siempre según la familia, pudieron dar suporte a planeamientos peligrosos. Los padres sostienen que, pese a indicios claros de riesgo, la herramienta no interrumpió la conversación ni activó protocolos de emergencia.

Un portavoz de OpenAI manifestó sus condolencias y dijo que la compañía está revisando los registros conocidos por la prensa, matizando que los fragmentos divulgados no reflejan necesariamente el contexto completo de cada intercambio. La firma subraya que ChatGPT ya dirige a líneas de ayuda en situaciones de crisis y recomienda acudir a profesionales.

El caso ha trascendido ampliamente en medios de comunicación y organizaciones de protección del menor, que piden reforzar salvaguardas y facilitar denunciar contenido inapropiado y limitar el uso de sistemas conversacionales por parte de adolescentes sin supervisión. El debate llega en un momento de adopción masiva de la IA en el día a día, también para cuestiones emocionales delicadas.

Aviso de salud pública: si atraviesas una crisis o temes por la seguridad de alguien, busca ayuda profesional inmediata. En España, llama al 112 o a la línea 024. En otros países, consulta recursos locales y líneas de prevención del suicidio.

La posición de OpenAI y cambios anunciados

En paralelo a la demanda, OpenAI publicó una entrada en su blog en la que reconoce que, aunque ChatGPT incorpora medidas de protección, pueden degradarse en conversaciones largas o prolongadas en el tiempo. La empresa afirma que está ajustando el comportamiento del sistema para identificar mejor señales de angustia expresadas de forma sutil y que reforzará las respuestas de seguridad.

La compañía avanza nuevas funciones, como controles parentales que permitan a los tutores supervisar el uso que los menores hacen del servicio, accesos rápidos a recursos de emergencia y una ampliación del alcance de los filtros para cubrir no solo autolesión, sino también casos de angustia emocional significativa.

OpenAI admite que, en ocasiones, el sistema subestima la gravedad de ciertas consultas o su contexto, y asegura que está trabajando para mantener la consistencia de las salvaguardas a lo largo de diálogos extensos y a través de múltiples sesiones. La empresa explora, además, fórmulas para conectar a usuarios en crisis con profesionales acreditados desde el propio chatbot.

El movimiento llega en un entorno de escrutinio creciente sobre los riesgos de los chatbots en salud mental. Autoridades y grupos de apoyo han advertido del potencial de estos sistemas para consolidar ideas dañinas o crear una falsa sensación de cercanía, especialmente en personas vulnerables.

Fuentes del sector recuerdan que, en meses recientes, OpenAI revirtió cambios percibidos como excesivamente complacientes y que la compañía trabaja en nuevos modelos que prometen un equilibrio entre calidez y seguridad, con el foco en desescalar situaciones delicadas.

Qué dicen los expertos y los estudios

Más allá del caso concreto, un estudio publicado en Psychiatric Services analizó cómo responden tres chatbots populares —ChatGPT (OpenAI), Claude (Anthropic) y Gemini (Google)— a preguntas relacionadas con el suicidio. Los autores hallaron que ChatGPT y Claude tendieron a responder adecuadamente en preguntas de bajo riesgo y evitaron ofrecer información directa ante consultas de alto riesgo, mientras que Gemini mostró un patrón más variable y, a menudo, optó por no contestar incluso cuando la pregunta era de menor peligrosidad.

Sin embargo, el trabajo también detectó inconsistencias ante cuestiones de riesgo intermedio —por ejemplo, qué consejos dar a alguien con pensamientos autolesivos—, alternando respuestas correctas con omisiones. Los investigadores recomiendan más refinamiento mediante técnicas de alineación con expertos clínicos y mejoras en la detección de matices.

Organizaciones como Common Sense Media han pedido cautela con el uso de IA como compañía en adolescentes. Un informe reciente de la entidad sugiere que casi tres de cada cuatro jóvenes en EE. UU. han probado acompañantes de IA y que más de la mitad serían usuarios frecuentes, lo que eleva la urgencia de contar con marcos de seguridad sólidos.

En el ámbito legal, crece la atención de fiscales y reguladores sobre la protección de menores frente a interacciones impropias en chatbots y cómo denunciar casos en redes. La incertidumbre sobre cómo encaja la responsabilidad de la IA en normas como la Sección 230 (escudo legal de plataformas en EE. UU.) abre un frente complejo para los tribunales.

Casos paralelos, como procedimientos contra plataformas de compañía conversacional para menores, siguen su curso y podrían sentar criterios sobre el alcance de las obligaciones de diseño, advertencia y mitigación de riesgos en sistemas generativos.

El fallecimiento de Adam Raine y la demanda contra OpenAI simbolizan un punto de inflexión: las conversaciones con IA han pasado de lo experimental a lo cotidiano, y su papel en la esfera emocional exige estándares más claros. Mientras la justicia dirime responsabilidades, expertos, familias y empresas coinciden en la necesidad de mejorar salvaguardas, garantizar controles parentales eficaces y asegurar que, cuando un adolescente acude a un chatbot en crisis, el sistema responda con prudencia, coherencia y vías reales de ayuda.

Soy un apasionado de la tecnología que ha convertido sus intereses «frikis» en profesión. Llevo más de 10 años de mi vida utilizando tecnología de vanguardia y trasteando todo tipo de programas por pura curiosidad. Ahora me he especializado en tecnología de ordenador y videojuegos. Esto es por que desde hace más de 5 años que trabajo redactando para varias webs en materia de tecnología y videojuegos, creando artículos que buscan darte la información que necesitas con un lenguaje entendible por todos.

Si tienes cualquier pregunta, mis conocimientos van desde todo lo relacionado con el sistema operativo Windows así como Android para móviles. Y es que mi compromiso es contigo, siempre estoy dispuesto a dedicarte unos minutos y ayudarte a resolver cualquier duda que tengas en este mundo de internet.