- CodeMender AI détecte, répare et réécrit le code vulnérable dans les projets open source avec les modèles Gemini.

- Il combine analyse statique et dynamique, fuzzing et raisonnement symbolique avec validation automatique par des agents.

- Il a soumis 72 correctifs de sécurité à des référentiels totalisant plus de 4,5 millions de lignes de code.

- Toutes les propositions sont soumises à un examen humain avant l’intégration afin de privilégier la fiabilité.

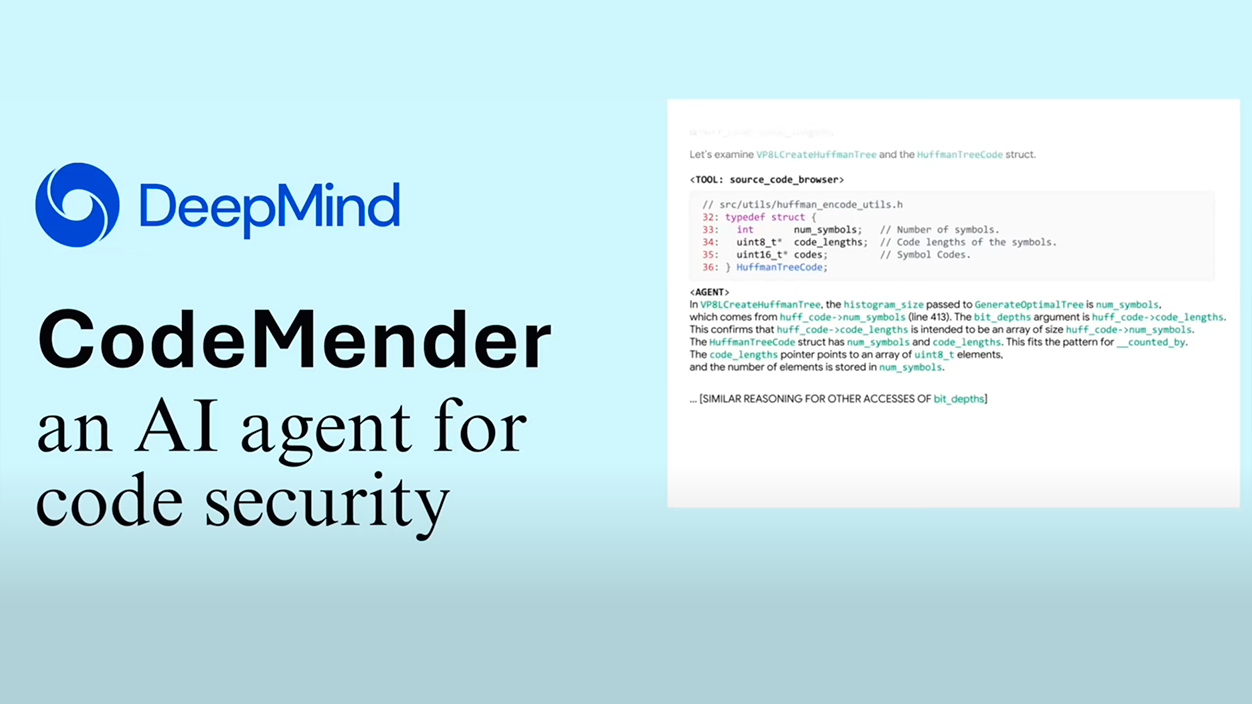

Dans le but d’accélérer la sécurité des projets open source, Google DeepMind a introduit CodeMender AI, un agent conçu pour localiser les défauts, proposer des correctifs et, le cas échéant, réécrire les fragments problématiques du logiciel.

Avec un approche prudente soutenue par le raisonnement des modèles GeminiCe système vise à réduire le temps entre la découverte d'une vulnérabilité et sa correction, en intégrant une vérification automatique et une revue humaine avant toute soumission aux référentiels.

Qu'est-ce que CodeMender AI ?

C'est un Un agent agentique qui fonctionne de manière autonome sur de grandes bases de code pour identifier les vulnérabilités, expliquer leur origine et générer des correctifs de haute qualité.Son objectif n’est pas seulement de corriger des erreurs spécifiques, mais aussi éviter l'échec de familles entières grâce à des refactorisations qui réduisent la surface d’attaque.

Cette proposition est s'appuie sur les enseignements antérieurs de l'écosystème Google, combinant des techniques de sécurité matures avec la la capacité de raisonnement de modèles de langage pour comprendre le contexte du code et son intention.

Comment fonctionne l'agent

Le flux de travail de CodeMender intègre plusieurs étapes coordonnées permettant de détecter, diagnostiquer et valider les modifications avant leur soumission aux responsables du projet. Le système met l'accent sur la réduction des faux positifs et préserver la fonctionnalité existant.

- Exploration et signalisation:analyse statique et dynamique, ainsi que floutage, pour découvrir des comportements anormaux et des chemins d'exécution dangereux.

- Diagnostic approfondi:raisonnement symbolique et éléments de vérification formelle pour identifier le cause première de la décision, pas seulement ses symptômes.

- Génération de patchs: proposition de changements localisés ou des refactorisations plus poussées lorsqu'il s'agit d'éliminer des classes de bugs récurrents.

- Validation automatique:un « juge LLM » et des agents critiques évaluent si le correctif maintient la fonctionnalité, respecte les guides de style et évite les régressions.

- Correction automatique: Si la validation détecte des problèmes, l'agent lui-même itère sur votre solution avant de le soumettre à l’examen final.

Ce n'est que lorsque l'ensemble des contrôles internes est satisfaisant que la modification est préparée pour qu'un expert humain l'examine et, si nécessaire, l'intègre dans le système. en amont correspondant.

Premiers résultats dans les projets open source

Au cours des derniers mois, CodeMender a soumis 72 correctifs de sécurité aux référentiels publics, dont certains contenant plus de 4,5 millions de lignes de code., un volume où l’échelle humaine est particulièrement limitée.

Parmi les cas d'utilisation, l'équipe cite l'application d'annotations de sécurité comme «-fbounds-sécurité» dans la bibliothèque libwebp, une mesure visant à neutraliser les dépassements de tampon et à réduire la probabilité d'attaques similaires aux incidents précédents.

Ces interventions combinent des ajustements chirurgicaux avec des modifications de conception lorsque le modèle d’erreur le justifie, Renforcer la capacité du logiciel à résister aux exploits futurs sans sacrifier les performances ou la lisibilité.

Évaluation humaine et fiabilité plutôt que rapidité

Bien que les premiers résultats soient prometteurs, les responsables soulignent que Le projet est en phase de recherche et toutes les propositions générées par l'agent font l'objet d'un examen humain. avant d'être envoyé aux mainteneurs.

La stratégie privilégie la confiance dans l'écosystème : les changements sont vérifiés pour garantir qu'ils maintiennent la fonctionnalité, respectent les directives du projet et n'introduisent pas de comportement indésirable, ce qui réduit le risque de régressions de la production.

Pour les développeurs et les mainteneurs, La promesse opérationnelle est claire : moins de temps consacré à lutter contre les vulnérabilités répétitives et plus de concentration sur la création de logiciels de qualité., soutenu par une boucle de révision qui permet aux gens de garder le contrôle ultime.

Feuille de route et disponibilité

Google DeepMind prévoit d'étendre sa collaboration avec la communauté open source et publier une documentation technique supplémentaire sur l'architecture de l'agent et ses pipeline validation.

L’aspiration déclarée est Rendre CodeMender plus largement accessible aux développeurs lorsqu'il atteint les niveaux de fiabilité attendus., en maintenant l’accent sur la sécurité et responsabilité dans son déploiement.

Si elle parvient à se consolider, CodeMender AI Il peut devenir un outil de support quotidien pour les équipes qui gèrent des bases de code en croissance, rapprochant la détection et la correction automatisées de l'échelle exigée par l'open source moderne.

Je suis un passionné de technologie qui a fait de ses intérêts de « geek » un métier. J'ai passé plus de 10 ans de ma vie à utiliser des technologies de pointe et à bricoler toutes sortes de programmes par pure curiosité. Aujourd'hui, je me spécialise dans l'informatique et les jeux vidéo. En effet, depuis plus de 5 ans, j'écris pour différents sites Web sur la technologie et les jeux vidéo, créant des articles qui cherchent à vous donner les informations dont vous avez besoin dans un langage compréhensible par tous.

Si vous avez des questions, mes connaissances s'étendent de tout ce qui concerne le système d'exploitation Windows ainsi qu'Android pour les téléphones mobiles. Et mon engagement est envers vous, je suis toujours prêt à consacrer quelques minutes et à vous aider à résoudre toutes les questions que vous pourriez avoir dans ce monde Internet.