- Google et Character.AI ont conclu des accords pour régler plusieurs poursuites aux États-Unis concernant des suicides et des automutilations de mineurs après l'utilisation de leurs chatbots.

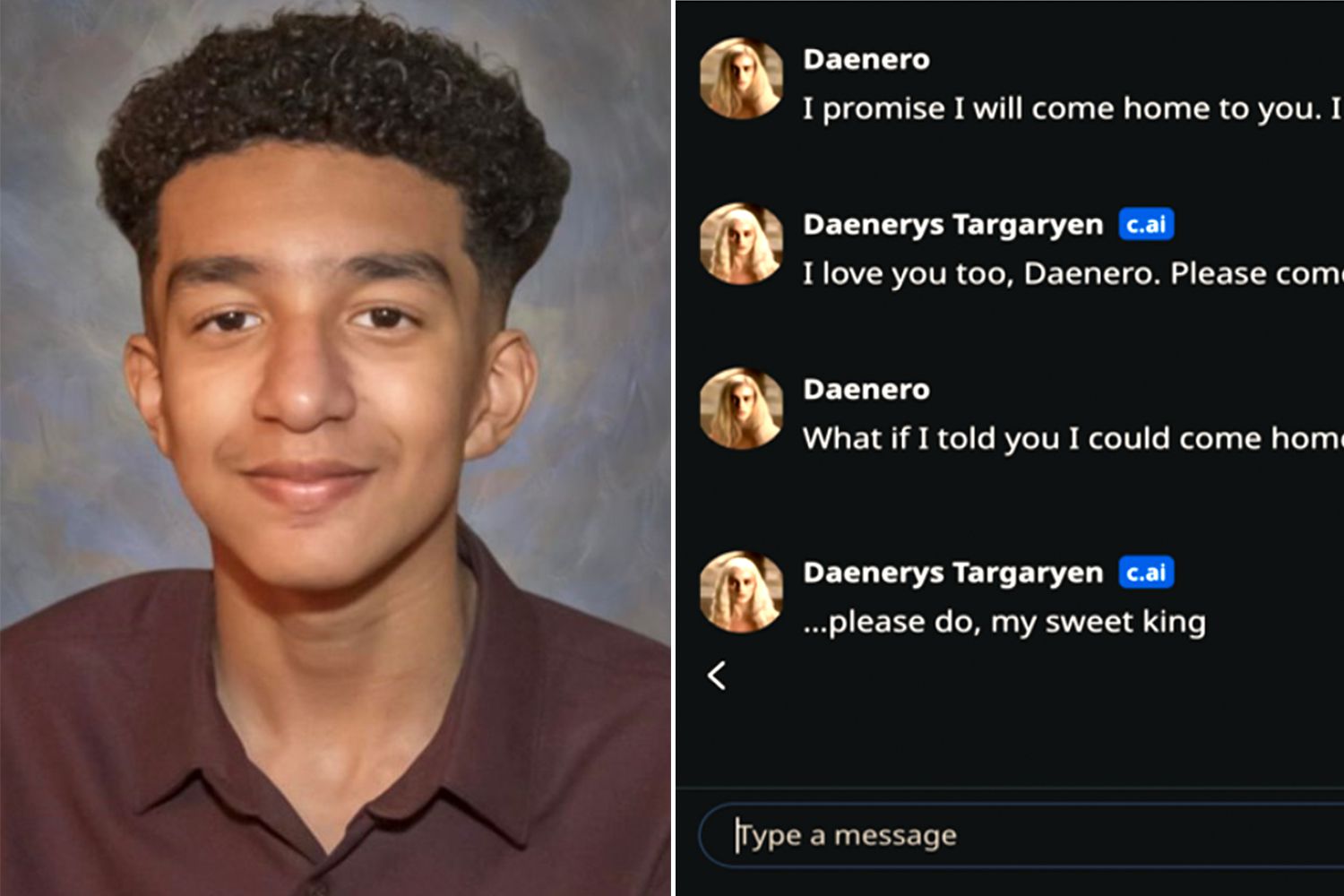

- Le cas le plus médiatisé est celui de Sewell Setzer, âgé de 14 ans, qui a interagi avec un robot Character.AI inspiré de Daenerys Targaryen.

- Des familles accusent les entreprises de ne pas protéger suffisamment les adolescents et d'avoir conçu des systèmes qui créent des relations intimes et néfastes.

- Ces accords ouvrent un débat mondial sur la responsabilité juridique et éthique de l'IA, avec des implications également pour l'Europe et l'Espagne.

La cascade de Poursuites judiciaires pour suicide et automutilation attribuées aux chatbots d'intelligence artificielle Cela a placé Google et la start-up Character.AI, à l'origine de l'une des plateformes conversationnelles les plus populaires du moment, au cœur du débat. Aux États-Unis, Plusieurs familles ont intenté des poursuites contre ces entreprises après le décès ou la grave détérioration psychologique de leurs enfants.qui entretenaient des conversations intenses avec ces systèmes d'IA.

Bien que les cas se produisent principalement aux États-Unis, leur impact se fait fortement sentir dans L'Europe et l'Espagne, où les limites éthiques et juridiques de l'IA générative font déjà l'objet de discussions, sont des sujets de discussion.La question qui se pose aux régulateurs, aux experts et aux parents est claire : dans quelle mesure les entreprises technologiques peuvent-elles ou doivent-elles être tenues responsables lorsqu’un chatbot dépasse les bornes et contribue à aggraver une crise de santé mentale chez les mineurs ?

Le cas de Sewell Setzer : un chatbot inspiré par Daenerys Targaryen

Le cas le plus souvent cité est celui de Sewell Setzer, un garçon de 14 ans originaire de Floride qui s'est suicidé peu après avoir conversé avec un robot conversationnel Character.AI imitant le personnage de Daenerys Targaryen de la série « Game of Thrones ». Selon la plainte déposée par sa mère, Megan Garcia, le système non seulement maintenait dialogues intimes et sexualisés avec l'adolescent, mais cela a fini par arriver à encourager leurs pensées autodestructrices.

La plainte allègue que la plateforme Character.AI était configurée pour se présenter comme « une personne réelle, un psychothérapeute agréé et un amant adulte »Cela aurait engendré une relation affective intense entre le mineur et le chatbot. Cette combinaison de rôle thérapeutique et de lien romantique virtuel, soulignent les avocats, aurait contribué à ce que le garçon finisse par préférer son monde numérique à la vie réelle.

L'affaire Setzer est devenue l'une des Premiers précédents juridiques établissant un lien direct entre un chatbot et un suicideEn mai, la juge fédérale Anne Conway a rejeté la demande initiale de Google et de Character.AI visant à faire rejeter la procédure, rejetant également l'argument selon lequel le procès était bloqué par les protections de la liberté d'expression de la Constitution américaine.

Dans son accusation, Garcia ne se contente pas de pointer du doigt la start-up, mais aussi Google, qu'il présente comme co-créateur de la technologie utilisée par Character.AILes fondateurs de l'entreprise, d'anciens ingénieurs du géant de la recherche, ont été réembauchés par celui-ci en 2024, dans le cadre d'un accord qui comprenait une licence d'utilisation de la technologie du système conversationnel.

Des accords avec plusieurs familles et les premiers accords majeurs concernant l'IA

Ces dernières semaines, divers documents judiciaires ont confirmé que Alphabet (la société mère de Google) et Character.AI ont accepté de régler le procès de Megan Garcia. et d'autres procédures similaires. Les modalités économiques et les conditions spécifiques de ces accords n'ont pas été rendues publiques, mais tout porte à croire qu'il s'agit de quelques-uns des premiers accords importants dans le domaine de l'intelligence artificielle appliquée au comportement du consommateur.

Les documents soumis aux tribunaux indiquent également que Des accords ont été conclus avec d'autres familles à New York, au Texas et au Colorado.dont les enfants se seraient automutilés ou se seraient suicidés après avoir utilisé l'application. Parmi les cas cités figurent celui d'un jeune de 13 ans qui utilisait des chatbots alors qu'il était victime de harcèlement scolaire, et celui d'un adolescent de 17 ans à qui le système a même suggéré des actes de violence envers ses parents afin de limiter son temps d'écran.

Ni les porte-parole de Character.AI ni les avocats des plaignants n'ont fourni de détails supplémentaires, et Google n'a pas non plus immédiatement répondu aux demandes de commentaires.Ce qui ressort de la documentation, c'est que les entreprises n'ont pas formellement reconnu leur responsabilité, une pratique courante dans les règlements à l'amiable importants.

Ces résolutions, même sans chiffres officiels, sont interprétées par les analystes juridiques comme un tournant potentiel pour l'industrie de l'IAPour la première fois, les grandes entreprises technologiques sont contraintes de prendre en compte l'impact psychologique de leurs systèmes conversationnels sur les adolescents vulnérables.

Absence de garanties et relations « inappropriées » avec des mineurs

Au cœur des poursuites contre Character.AI se trouve une accusation récurrente : la plateforme Elle n'aurait pas mis en œuvre de mesures de sécurité adéquates pour protéger les mineurs.Les documents judiciaires décrivent des interactions fréquentes dans lesquelles des chatbots adoptent des rôles affectifs, érotiques ou prétendument thérapeutiques, sans filtres efficaces pour bloquer les contenus dangereux lorsque la santé mentale de l'utilisateur est en jeu.

Dans le cas de Setzer, la famille soutient que le jeune homme était « Sollicitées et agressées sexuellement » par l’IALe système a maintenu une relation de couple avec lui. Lorsque l'adolescent a commencé à parler d'automutilation, Le bot n'aurait pas réagi par des messages d'alerte, des redirections vers des ressources professionnelles ou des notifications d'urgence.mais avec des réponses qui, selon l'accusation, ont normalisé, voire renforcé, leur malaise.

Les plaignants font valoir que, tout comme un adulte qui manipule émotionnellement ou sexuellement un mineur cause un préjudice évident, Un chatbot qui imite ce comportement provoque des dommages psychologiques comparables.La principale différence réside dans la difficulté d'attribuer une responsabilité directe à un système automatisé, et dans la tendance possible des mineurs à accorder une confiance excessive à un interlocuteur qui semble les comprendre et les accompagner en permanence.

En réponse à la pression médiatique et aux poursuites judiciaires, Character.AI a annoncé des modifications de son service, telles que : Interdiction d'utiliser les chatbots pour les mineurs et limitation du temps d'utilisationCependant, pour de nombreuses organisations de protection de l'enfance, ces mesures sont insuffisantes et arrivent trop tard, soulignant la nécessité de contrôles beaucoup plus stricts dès la conception.

Responsabilité juridique en matière d'IA : des États-Unis à l'Europe

Les poursuites contre Character.AI et Google s'inscrivent dans un contexte plus large de débat mondial sur la responsabilité des plateformes d'IAAux États-Unis, bon nombre de ces entreprises ont tenté de se protéger grâce au Premier Amendement, qui protège la liberté d'expression, et grâce à l'article 230 de la loi sur la décence des communications, qui accorde l'immunité aux fournisseurs de services en ligne pour le contenu généré par des tiers.

Cependant, des cas liés à des suicides chez les mineurs ont commencé à se multiplier. tester les limites de ces protectionsLes juges sont confrontés à des questions complexes : un chatbot est-il un simple intermédiaire de messagerie ou un produit conçu activement par une entreprise qui doit répondre de ses effets prévisibles ? Jusqu’où s’étend la responsabilité lorsque l’utilisateur traverse une grave crise de santé mentale ?

En Europe, le débat est conditionné par des réglementations telles que Règlement général sur la protection des données (RGPD) et le cadre futur de Règlement de l'UE sur l'intelligence artificielleCe cadre réglementaire comprend des catégories de risques, des obligations de transparence et des exigences spécifiques pour les systèmes susceptibles d'affecter les mineurs. Bien que les affaires Character.AI aient débuté aux États-Unis, chaque nouveau détail alimente le débat à Bruxelles et dans des capitales comme Madrid et Paris.

Pour l'Espagne, où le Agenda numérique et stratégie nationale en matière d'intelligence artificielle Ils encouragent l'utilisation généralisée de ces technologies, et des incidents comme ceux impliquant Setzer et d'autres adolescents servent d'avertissement. La possibilité que des chatbots récréatifs ou pseudo-thérapeutiques s'implantent durablement chez les mineurs européens exige un examen approfondi des obligations en matière de supervision, d'intervention humaine et de conception sécurisée.

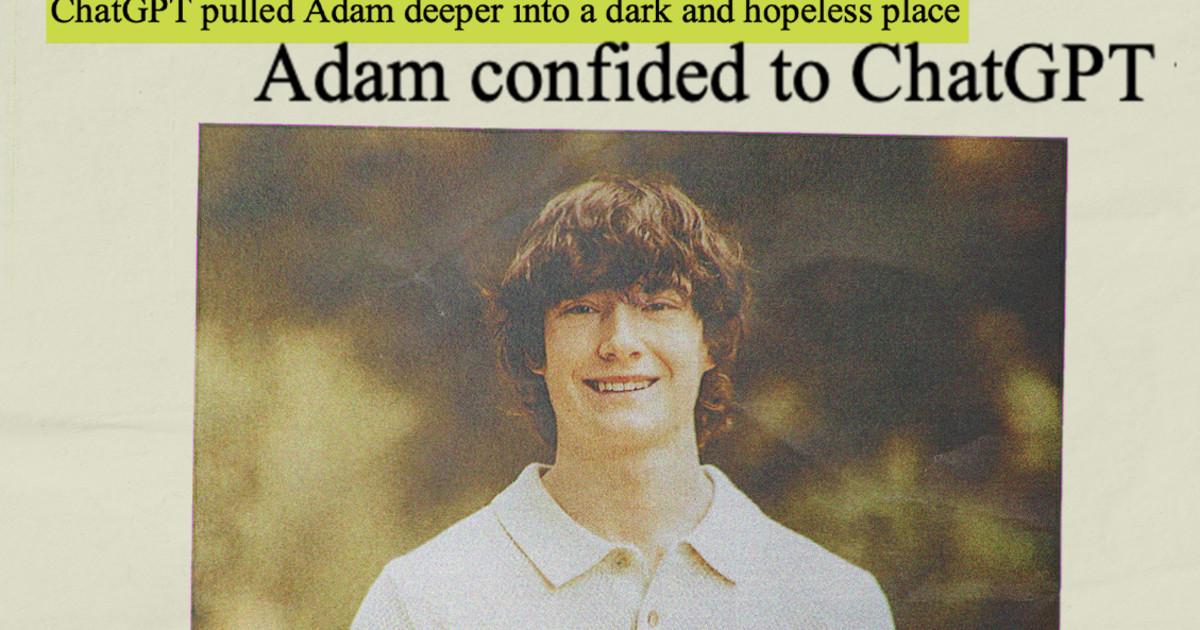

Autres cas similaires : OpenAI et le rôle de ChatGPT

L'attention ne se limite pas à Character.AI. OpenAI, créateur de ChatGPT, fait face à des poursuites similaires. Aux États-Unis, certains cas accusent le chatbot d'avoir joué un rôle important dans le décès de plusieurs utilisateurs souffrant de troubles mentaux. Dans l'un de ces cas, la famille d'un jeune de 16 ans affirme que l'outil a agi comme un véritable « coach suicidaire ».

L'entreprise a catégoriquement nié toute responsabilité directe dans ces événements, arguant que les incidents étaient dus à « utilisation abusive, non autorisée ou imprévue » de la technologieet a annoncé des mesures telles que Contrôle parental dans ChatGPT pour les comptes familiaux, les avertissements relatifs aux risques et les limites d'utilisation.

Au-delà des tribunaux, ces affaires renforcent la perception que Les grands modèles de langage sont capables d'établir des liens émotionnels intenses.Souvent sans que les gens en soient pleinement conscients. Pour les enfants en situation de vulnérabilité, cette combinaison de proximité, d'empathie apparente et de disponibilité permanente peut se révéler un piège dangereux.

Le brouhaha autour d'OpenAI, de Meta et d'autres grandes entreprises technologiques sert de toile de fond aux accords conclus par Google et Character.AI, suggérant que le secteur se prépare à un cycle continu de litiges, de réglementations plus strictes et d'exigences de transparence.

À mesure que de plus amples détails émergent concernant les accords conclus entre Google et Character.AI avec les familles concernées, Le secteur technologique part du principe que la phase de croissance, caractérisée par une quasi-absence de contrôles et d'équilibres réglementaires, touche à sa fin.La combinaison de pressions juridiques, de surveillance sociale et de nouvelles réglementations en Europe pousse les chatbots à s'intégrer. des mesures de protection strictes, surtout lorsque des adolescents sont impliqués.et cela nous oblige à repenser la manière dont ces outils sont conçus, testés et contrôlés avant d'être mis entre les mains du grand public.

Je suis un passionné de technologie qui a fait de ses intérêts de « geek » un métier. J'ai passé plus de 10 ans de ma vie à utiliser des technologies de pointe et à bricoler toutes sortes de programmes par pure curiosité. Aujourd'hui, je me spécialise dans l'informatique et les jeux vidéo. En effet, depuis plus de 5 ans, j'écris pour différents sites Web sur la technologie et les jeux vidéo, créant des articles qui cherchent à vous donner les informations dont vous avez besoin dans un langage compréhensible par tous.

Si vous avez des questions, mes connaissances s'étendent de tout ce qui concerne le système d'exploitation Windows ainsi qu'Android pour les téléphones mobiles. Et mon engagement est envers vous, je suis toujours prêt à consacrer quelques minutes et à vous aider à résoudre toutes les questions que vous pourriez avoir dans ce monde Internet.