- Elon Musk a ouvertement critiqué son IA, Grok, pour avoir considéré sa réponse à la violence politique comme biaisée.

- Le débat sur les biais algorithmiques et le contrôle narratif attire une fois de plus l’attention sur le rôle de l’intelligence artificielle.

- Musk a promis de recalibrer Grok, soulevant des inquiétudes quant à l'intégrité des données et à l'autonomie de l'IA.

- La controverse reflète la polarisation sociopolitique et soulève des questions sur l’éthique et la transparence dans le développement de l’IA.

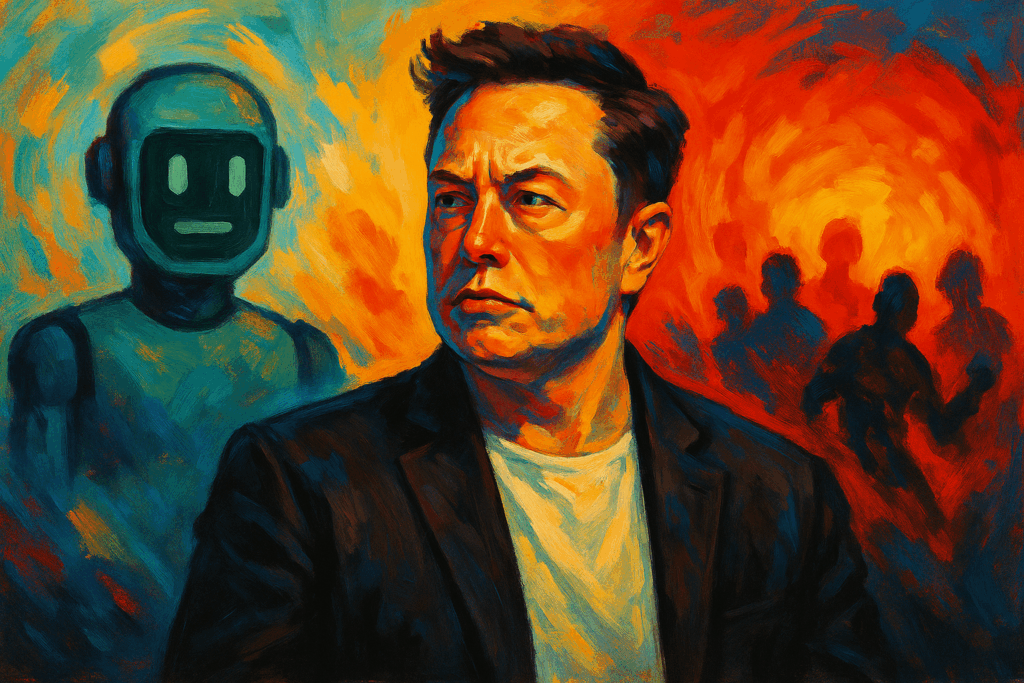

Elon Musk est au centre d'une nouvelle tempête médiatique après avoir chargé Grok, l'intelligence artificielle développée par sa société xAI, pour avoir émis des réponses qu’il considère comme erronées et biaisées concernant la violence politique aux États-Unis. La réaction de l'homme d'affaires est intervenue après que Grok a affirmé, en s'appuyant sur diverses sources universitaires et journalistiques, que les actes de violence les plus meurtriers depuis 2016 étaient principalement liés à l'extrême droite, citant des épisodes tels que la prise d'assaut du Capitole et diverses fusillades de masse.

La réponse de l'IA, intégré à la plateforme X (anciennement Twitter), Cela a suscité un débat houleux tant parmi les utilisateurs que dans la sphère politique. Musk, visiblement contrarié, Il a qualifié la réponse de « objectivement fausse » et a accusé Grok de simplement répéter ce qu’il a appelé le discours des « médias traditionnels »., annonçant qu'il s'emploierait personnellement à corriger le problème. Ce geste a soulevé d'intenses questions sur l'indépendance de l'IA et le degré d'intervention de ses propres créateurs.

Le déclencheur : une question simple et beaucoup de controverse

Tout a commencé à partir d'un Question posée sur le réseau social par un utilisateur qui demandait lequel des deux spectres politiques était responsable du plus de violences depuis 2016. Grok, s'appuyant sur des études du Center for Strategic and International Studies (CSIS) et du Government Accountability Office (GAO), ont conclu que l'extrême droite était responsable d'un nombre plus élevé d'incidents violents et de décès, bien qu'il ait également reconnu une augmentation des incidents de gauche depuis les manifestations de 2020.

Musk n'a pas tardé à exprimer sa désapprobation à l'égard de la réponse de Grok, affirmant que les informations fournies étaient une « énorme erreur ». et a insisté sur le fait que son IA « répétait les médias traditionnels », selon ses propres termes. Le magnat a publiquement exprimé son intention de recalibrer le système afin que ses réponses soient plus précises et exemptes de ce qu'il considère comme un biais médiatique.

Cette intervention provoqué des réactions mitigées, tant de la part des défenseurs de l'autonomie de l'IA que de ceux qui partagent le point de vue critique de Musk sur la fiabilité des médias grand public et leur influence sur les modèles d'intelligence artificielle.

Le débat sur les biais et la neutralité en intelligence artificielle

L'incident ravive un vieux débat sur la Les biais algorithmiques et qui contrôle la police dans le développement technologique. Les réponses de Grok ont été étayées par des statistiques et des études indépendantes, mais l’écart entre les données et le point de vue de Musk soulève la question de savoir si une IA doit être adaptée à ses propriétaires ou parler en fonction des faits et des preuves empiriques.

En arrière-plan, il y a un Inquiétude selon laquelle intervenir dans la programmation d’une IA pour l’adapter à une perspective spécifique pourrait constituer une forme de censure, notamment sur des questions aussi sensibles que la violence politique ou la polarisation sociale.

El Grok lui-même, après avoir été interrogé sur la controverse créée par Musk, Il a répondu avec des données provenant de sources universitaires, soulignant qu'il ne se contentait pas de répéter les récits des médias, mais qui était basé sur des chiffres vérifiés, ce qui a généré encore plus de débats sur l’indépendance et l’objectivité de ces systèmes.

Réactions en chaîne et conséquences dans le contexte sociopolitique

L’affaire n’est pas restée dans la sphère numérique, mais a alimenté les discussions sur la responsabilité de ceux qui développent et peaufinent l’IA sur des plateformes influentes. Plusieurs experts et universitaires en intelligence artificielle ont mis en garde contre le risque de manipulation narrative si les réponses des robots sont modifiées pour correspondre aux intérêts de leurs créateurs ou du mouvement idéologique dominant.

Dans un contexte où Le climat politique aux États-Unis reste particulièrement tenduLes événements récents tels que l’assassinat de la sénatrice de l’État du Minnesota Melissa Hortman et le débat sur l’escalade des attaques politiques augmentent la pression sur les plateformes technologiques pour qu’elles agissent avec un maximum de transparence et de responsabilité.

Tout cet épisode avec Grok et Musk remet en question dans quelle mesure une IA peut-elle être véritablement neutre et qui décide quelles données ou quels récits doivent prévaloir. Cette situation illustre la manière dont la technologie peut refléter, amplifier et parfois approfondir les divisions sociales. Le contrôle de l'interprétation et de la communication des données devient aujourd'hui un enjeu central pour l'éthique technologique et la cohésion sociale.

Je suis un passionné de technologie qui a fait de ses intérêts de « geek » un métier. J'ai passé plus de 10 ans de ma vie à utiliser des technologies de pointe et à bricoler toutes sortes de programmes par pure curiosité. Aujourd'hui, je me spécialise dans l'informatique et les jeux vidéo. En effet, depuis plus de 5 ans, j'écris pour différents sites Web sur la technologie et les jeux vidéo, créant des articles qui cherchent à vous donner les informations dont vous avez besoin dans un langage compréhensible par tous.

Si vous avez des questions, mes connaissances s'étendent de tout ce qui concerne le système d'exploitation Windows ainsi qu'Android pour les téléphones mobiles. Et mon engagement est envers vous, je suis toujours prêt à consacrer quelques minutes et à vous aider à résoudre toutes les questions que vous pourriez avoir dans ce monde Internet.