- Modèle rapide et économique pour le codage agentique avec des traces visibles et un contexte de 256 k.

- Accès via xAI gRPC SDK ou REST avec OpenRouter/CometAPI, avec ACL et mise en cache.

- Appels de fonctions et sorties JSON pour les flux de test-correction, CI et IDE.

- Bonnes pratiques : invites claires, itérations courtes, sécurité et mesures.

Les développeurs qui cherchent à accélérer leur flux de travail trouvent dans Grok Code Rapide 1 un allié de premier ordre, puisque combine vitesse, coût compétitif et traces de raisonnement visible qui vous permettent de guider le modèle avec précision tout en itérant sur du code complexe.

Au-delà du marketing, l’atout majeur de ce modèle xAI est qu’il est conçu pour Codage agentique réel : planifie, invoque des outils et structure les sorties pour s'intégrer aux IDE, aux pipelines et aux services compatibles REST ; tout en conservant une grande fenêtre de contexte qui empêche la troncature des grandes bases de code.

Qu'est-ce que Grok Code Fast 1 et pourquoi est-ce important ?

Grok Code Fast 1 (modèle grok-code-rapide-1) est une variante axée sur la famille Grok Tâches de développement orientées xAI : génère des fonctions, optimise les algorithmes, intègre des systèmes et, surtout, agit comme un « programmeur en binôme » avec des outils (recherche, test, édition de fichiers) et raisonnement transmissible pour inspection en cours d'exécution.

Cette spécialisation privilégie deux axes : latence interactive pour les utilisations au sein de l'éditeur/CI et rentabilité par jeton Pour les travaux volumineux. Contrairement aux LLM classiques, son objectif n'est pas une multimodalité complète, mais plutôt de maîtriser le cycle de développement : lire, proposer, tester et itérer avec un minimum de frictions.

La plateforme se distingue par l'exposition Des traces de raisonnement en continu et prend en charge les appels de fonctions et les sorties structurées (JSON). En pratique, cela facilite l'automatisation des boucles en plusieurs étapes (recherche → édition → test → validation) avec un contrôle et une traçabilité au niveau des jetons.

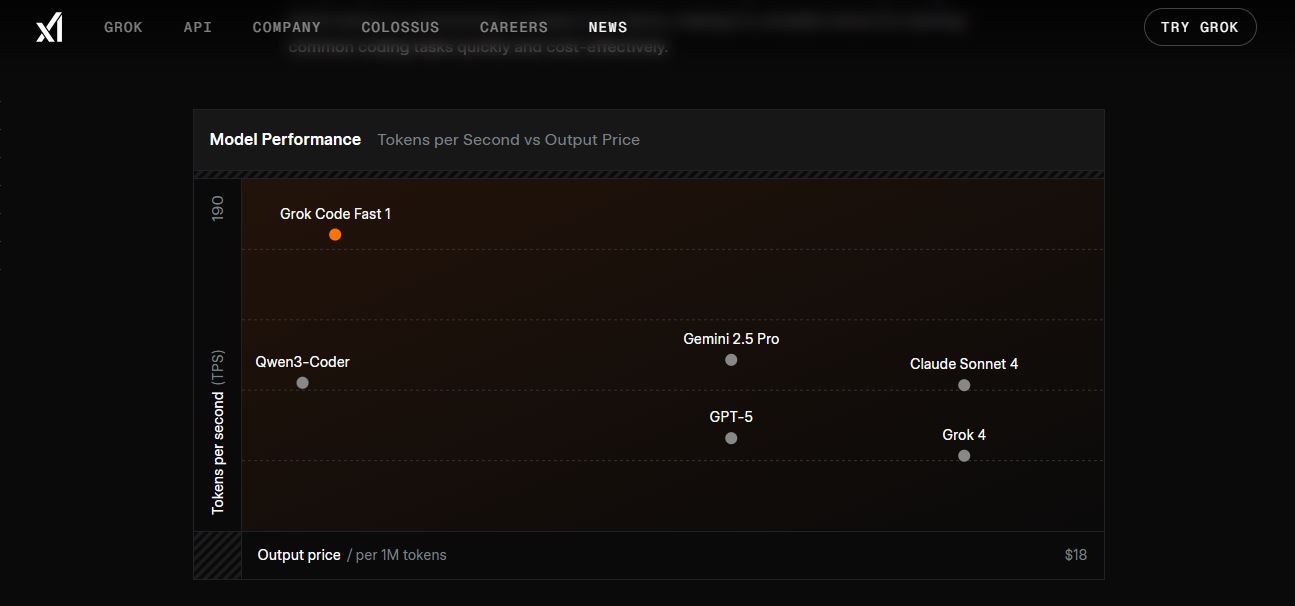

En termes de performance, des chiffres tels que ≈190 jetons/seconde, temps de complétion de ligne instantanés : moins d'une seconde pour les fonctions de 5 à 10 lignes, environ 2 à 5 secondes pour les composants de plus de 50 lignes, et 5 à 10 secondes pour les refactorisations importantes. D'après les benchmarks partagés, surpasse les modèles de type LLaMA dans HumanEval et atteint 70,8 % dans des benchmarks tels que SWE-Bench-Verified.

Une conception technique qui permet la rapidité

Le modèle prend en charge un fenêtre de contexte pouvant contenir jusqu'à 256 000 jetons, utile pour ingérer des référentiels, de la documentation et de longues conversations sans troncature, réduisant ainsi le transfert de contexte redondant.

La plateforme met en œuvre cache de préfixes:Lorsque vous effectuez une itération sur la même invite de base, les jetons mis en cache réduisent les coûts et la latence (prix du jeton mis en cache inférieur), ce qui est essentiel dans les flux agentiques en plusieurs étapes.

De plus, l'API Grok prend en charge définitions d'outils/fonctions structurées à appeler pendant l'analyse ; cela évite les piratages fragiles, simplifie l'analyse et permet à plusieurs outils de se coordonner de manière plus fiable.

Sur le plan opérationnel, le service est hébergé dans le région us-east-1, quelque chose à garder à l'esprit si vous optimisez les latences en Amérique du Nord ou si vous équilibrez entre les fournisseurs et les régions.

Tarifs, limites et disponibilité

Le modèle est facturé à l'utilisation avec des tarifs publiés tels que Jetons d'entrée à 0,20 $/M, Jetons de sortie à 1,50 $/M y 0,02 $/M de jetons mis en cacheCe schéma privilégie les sessions longues avec des préfixes constants et des itérations multiples.

Les limites par défaut signalées sont 480 requêtes par minute y 2 000 000 jetons par minuteIls empêchent les abus tout en permettant une utilisation intensive au niveau de l'équipe ou du CI.

Contrairement à d'autres modèles, Grok Code Fast 1 n'intègre pas la recherche en direct:Vous devez fournir les connaissances et données pertinentes dans l'invite ou via des outils définis dans votre orchestration.

Les comparaisons de coûts avec des modèles plus grands sont citées dans des listes et des forums tiers (par exemple, Sortie GPT-5 ≈ 18 $/M jetons contre 1,50 $/M de Grok CF1), ce qui renforce son positionnement en tâches de développement à volume élevé.

Conditions préalables à l'admission

Avant de lancer la première pétition, vous aurez besoin d'un compte lié à X (xAI s'authentifie avec les informations d'identification X) et un environnement avec Python 3.8+, prise en charge de pip et des variables d'environnement pour gérer votre clé en toute sécurité.

Pour un accès direct, xAI donne la priorité au SDK et aux communications gRPC, ce qui améliore les performances ; si vous préférez REST, vous pouvez utiliser Routeur ouvert ou des passerelles comme CometAPI qui exposent des points de terminaison compatibles OpenAI.

Lors de la génération de clés, il est pratique de définir ACL strictes (par exemple, sampler:write permission) pour limiter les actions ; cela réduit la surface de risque si des informations d'identification sont divulguées ou si un environnement est compromis.

Une fois la configuration terminée, exécutez une vérification rapide du SDK pour confirmer la connectivité et les autorisationsEn cas d’échec, vérifiez le réseau, les ACL et la version du package.

Créer la clé API dans PromptIDE (xAI)

Accéder ide.x.ai Avec votre compte X, ouvrez le menu de votre profil et accédez à « Clés API ». Cliquez ensuite sur « Créer une clé API » et personnaliser les ACL en fonction de ce que vous allez faire avec le modèle (des complétions de base aux appels d'outils avancés).

La clé est affichée une seule foisCopiez-le et conservez-le précieusement. Il est recommandé de le stocker dans une variable d'environnement. CLÉ_API_XAI pour éviter de coder en dur les secrets dans les référentiels.

Plus tard, vous pourrez révoquer, faire pivoter ou ajuster les autorisations à partir du même panneau si vous en avez besoin, par exemple si vous détectez une utilisation anormale ou un changement de flux de travail.

Pour une vérification express, certains SDK exposent des méthodes telles que does_it_work(); utilisez ceci pour vous assurer que authentification et portée sont correctes avant d’investir du temps dans l’intégration.

Installation et configuration du SDK xAI

Installez le SDK avec pip installe xai-sdk, exportez la variable d’environnement avec votre clé (export XAI_API_KEY=…) et créez une instance de Client() dans votre application pour commencer.

Le SDK est responsable de la gestion gRPC de manière transparente, prend en charge les opérations asynchrones hautes performances et vous permet de sélectionner le modèle par nom, par exemple, « grok-code-fast-1 ».

Si quelque chose ne répond pas comme prévu, mettez à jour les packages (pip), vérifiez la connectivité de l'entreprise et vérifier les portées de la clé ; de nombreux incidents proviennent d'autorisations insuffisantes.

Une fois opérationnel, vous pourrez ajuster des paramètres tels que température ou top_p pour équilibrer créativité versus déterminisme dans vos flows.

Accès REST avec OpenRouter et passerelles tierces

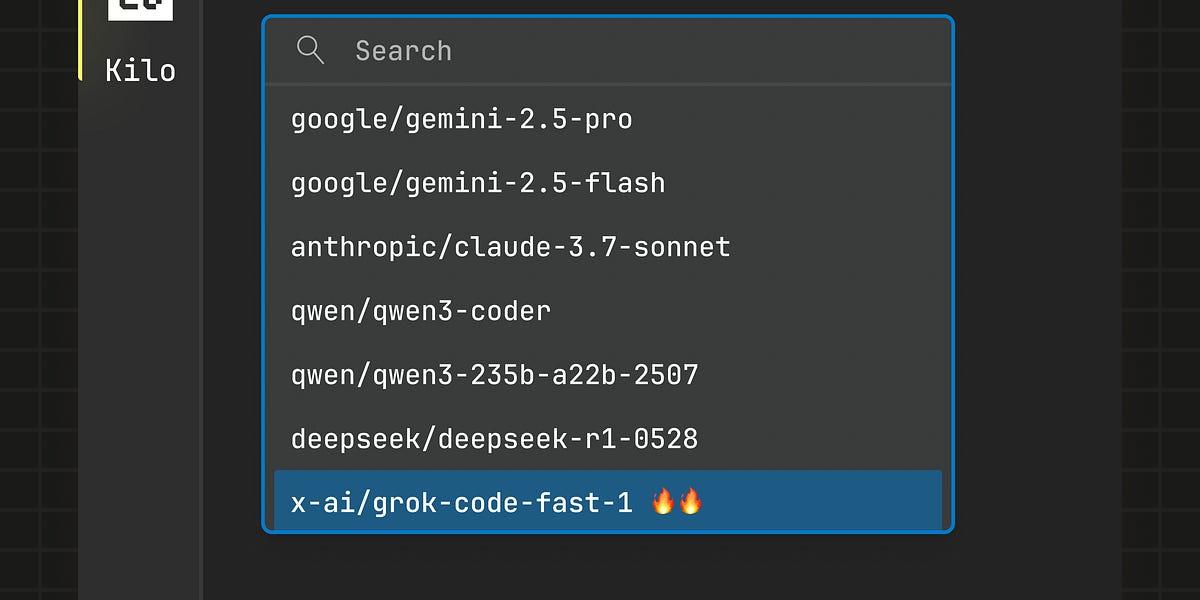

Si HTTP est mieux adapté à votre infrastructure, Routeur ouvert Expose une interface de type OpenAI basée sur « https://openrouter.ai/api/v1 » et des modèles comme « x-ai/grok-code-fast-1 ». Il suffit d'injecter votre clé et de définir vos messages.

Exemple avec prise en charge du SDK OpenAI, utile pour normaliser les paramètres entre les fournisseurs et réutiliser les outils existants (ajouter des en-têtes comme HTTP-Referer si vous souhaitez une traçabilité de l'origine).

from openai import OpenAI

client = OpenAI(

base_url="https://openrouter.ai/api/v1",

api_key="<TU_CLAVE_OPENROUTER>"

)

resp = client.chat.completions.create(

model="x-ai/grok-code-fast-1",

messages=[

{"role": "user", "content": "Genera un algoritmo de ordenación con explicación rápida"}

]

)

print(resp.choices[0].message.content)

Il existe également des fournisseurs tels que CometAPI qui agissent comme un pont REST compatible avec OpenAI et répertorient les mêmes contexte 256kUn exemple simple avec des requêtes pourrait ressembler à ceci :

import os, requests

COMET_KEY = os.getenv("COMETAPI_API_KEY")

BASE = "https://api.cometapi.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {COMET_KEY}",

"Content-Type": "application/json",

}

payload = {

"model": "grok-code-fast-1",

"messages": [

{"role": "system", "content": "Eres Grok Code Fast 1, un asistente de código muy rápido."},

{"role": "user", "content": "Escribe una función en Python que fusione dos listas ordenadas."}

],

"max_tokens": 300,

"stream": False

}

resp = requests.post(BASE, json=payload, headers=headers)

resp.raise_for_status()

print(resp.json())

Dans ces scénarios, les prix annoncés par les agrégateurs sont généralement s'aligner avec xAI et sans frais supplémentaires ; confirmez toujours la disponibilité, les limites et les éventuelles files d'attente par fournisseur.

Utilisation avancée : outils et résultats structurés

Le modèle brille dans les flux agentiques où il peut outils d'invocation (tests, linters, grep, git) et fusionnez leurs résultats dans le plan d'action. Définissez vos outils avec un nom, une description et des paramètres afin que le moteur puisse décider quand les appeler.

Si vous avez besoin de réponses concrètes, activez l'option Mode JSON (type json_object de type response_format) et concevez des schémas typés pour les différences, les résumés ou les plans de refactorisation ; cela simplifie la validation automatique.

Validez toujours ce que vos outils renvoient (par exemple, la sortie de test), détectez les erreurs et appliquez recul exponentiel Si vous rencontrez des limites de débit, l'objectif est de maintenir la boucle plan → exécution → vérification stable.

Grâce au cache de fenêtre et de préfixe de 256 Ko, vous pouvez conserver longues conversations par fichier ou dépôt sans perdre le contexte ni déclencher des coûts de jetons répétés.

Intégration avec les IDE et les services : Copilot, Cursor, Cline, Kilo Code

Grok Code Fast 1 est désormais disponible en Intégrations IDE et des outils tiers. Des aperçus sur GitHub Copilot et une présence dans des solutions comme Cursor et Cline sont cités, même lors de périodes promotionnelles gratuites.

Selon le journal des modifications de GitHub (26/08/2025), Copilot a annoncé un accès gratuit à l'aperçu. jusqu'au 10 septembre 2025 (PDT)Certains guides mentionnent des dates proches (même le 2/09) et, parfois, le modèle est resté indiqué comme libre dans l'interface. La prudence est de mise. vérifier dans le sélecteur de modèle depuis l'IDE pour confirmer l'état actuel.

D’autres partenaires, tels que Code Kilo (extension pour VS Code), ont annoncé un accès gratuit pour une durée limitée (minimum une semaine après la sortie), avec utiliser sans limites apparentes en échange du choix de partager les données d'utilisation pour améliorer le modèle.

Dans tous les cas, si votre équipe utilise déjà Copilot/Cursor/Cline, cela vaut la peine d'essayer le abonnement volontaire ou BYOK (apportez votre propre clé) et mesurez les latences et la qualité dans vos dépôts réels.

Modèles d'intégration recommandés

- IDE d'abord- Utilisez des invites courtes qui demandent de petits changements testables (générer un correctif, exécuter des tests, itérer). Gardez la boucle fermée pour raccourcir le temps de rétroaction.

- Automatisation CI: classe les bugs, suggère des correctifs ou génère de nouveaux tests unitaires ; par prix/latenceLe Grok CF1 est idéal pour les courses fréquentes.

- Orchestration des agents: active les outils avec des garde-fous ; exécute les correctifs dans les environnements de test ; nécessite révision humaine en cas de changements sensibles ; utiliser un raisonnement visible pour auditer le plan.

- Conseils rapides: : passez des fichiers exacts ou des fenêtres limitées, vous préférez formats typés (JSON/diff), enregistre les appels et les résultats pour la reproductibilité.

Déploiement progressif en équipes

Suivre un plan d’adoption : semaines 1-2, tests individuels3-4, pilotes à faible risque ; 5-6, définir les processus et les modèles ; 7-8, déploiement à grande échelle avec des métriques.

Comprend une liste de contrôle de qualité :compile sans erreursY a-t-il des risques de sécurité évidents ? Le système est-il conforme aux normes de style et de maintenabilité ?

Évitez les biais courants : ne déléguez pas la pensée critique, ne sauter les tests, n'ignorez pas la sécurité et ne laissez pas d'invites vagues sans contexte.

Mesurer l'impact avec des mesures de vitesse (temps par tâche, bugs corrigés/session), de qualité (taux de bugs, maintenabilité) et apprentissage (meilleures pratiques assimilées).

Notes sur l'accès libre et la disponibilité

Diverses sources indiquent des périodes de accès gratuit temporaire Pour les intégrations (Copilot, Cursor, Cline, Kilo Code). Les périodes mentionnées incluent la période du 26 août au 10 septembre 2025 (PDT) pour Copilot, ou des promotions d'au moins une semaine pour les partenaires de lancement.

Étant donné que ces fenêtres changent, vérifiez la sélecteur de modèle dans votre IDE ou la documentation du fournisseur. Si le modèle est répertorié comme gratuit, profitez-en pour évaluer la latence. qualité et coût avant une utilisation intensive.

Si vous n'avez qu'une idée : Grok Code Fast 1 est conçu pour fonctionner comme un assistant de code agile, avec des traces de raisonnement, des outils et une sortie structurée ; si vous prévoyez des invites claires, exploitez le cache et sécurisez l'intégration avec les ACL et les tests, Vous pouvez accélérer les livraisons sans augmenter les coûts. et avec un contrôle granulaire sur chaque étape.

Rédacteur spécialisé dans les problématiques technologiques et Internet avec plus de dix ans d'expérience dans différents médias numériques. J'ai travaillé comme éditeur et créateur de contenu pour des sociétés de commerce électronique, de communication, de marketing en ligne et de publicité. J'ai également écrit sur des sites Web d'économie, de finance et d'autres secteurs. Mon travail est aussi ma passion. Maintenant, à travers mes articles dans Tecnobits, j'essaie d'explorer toutes les actualités et les nouvelles opportunités que le monde de la technologie nous offre chaque jour pour améliorer nos vies.