- Google y Character.AI han alcanzado acuerdos para resolver varias demandas en EE. UU. por suicidios y autolesiones de menores tras usar sus chatbots.

- El caso más mediático es el de Sewell Setzer, de 14 años, que interactuó con un bot de Character.AI inspirado en Daenerys Targaryen.

- Las familias acusan a las empresas de no proteger adecuadamente a los adolescentes y de diseñar sistemas que generan vínculos íntimos y dañinos.

- Los acuerdos abren un debate global sobre la responsabilidad legal y ética de la IA, con implicaciones también para Europa y España.

La cascada de demandas por suicidio y autolesiones atribuidas a chatbots de inteligencia artificial ha colocado en el centro del debate a Google y a la startup Character.AI, responsables de una de las plataformas conversacionales más populares del momento. En Estados Unidos, varias familias han llevado a los tribunales a estas compañías tras la muerte o el grave deterioro psicológico de sus hijos, que mantenían conversaciones intensas con estos sistemas de IA.

Aunque los casos se desarrollan principalmente en territorio estadounidense, su eco llega con fuerza a Europa y España, donde ya se discuten los límites éticos y legales de la IA generativa. La cuestión que sobrevuela a reguladores, expertos y padres es clara: hasta qué punto pueden o deben responder las empresas tecnológicas cuando un chatbot cruza la línea y contribuye a agravar una crisis de salud mental en menores.

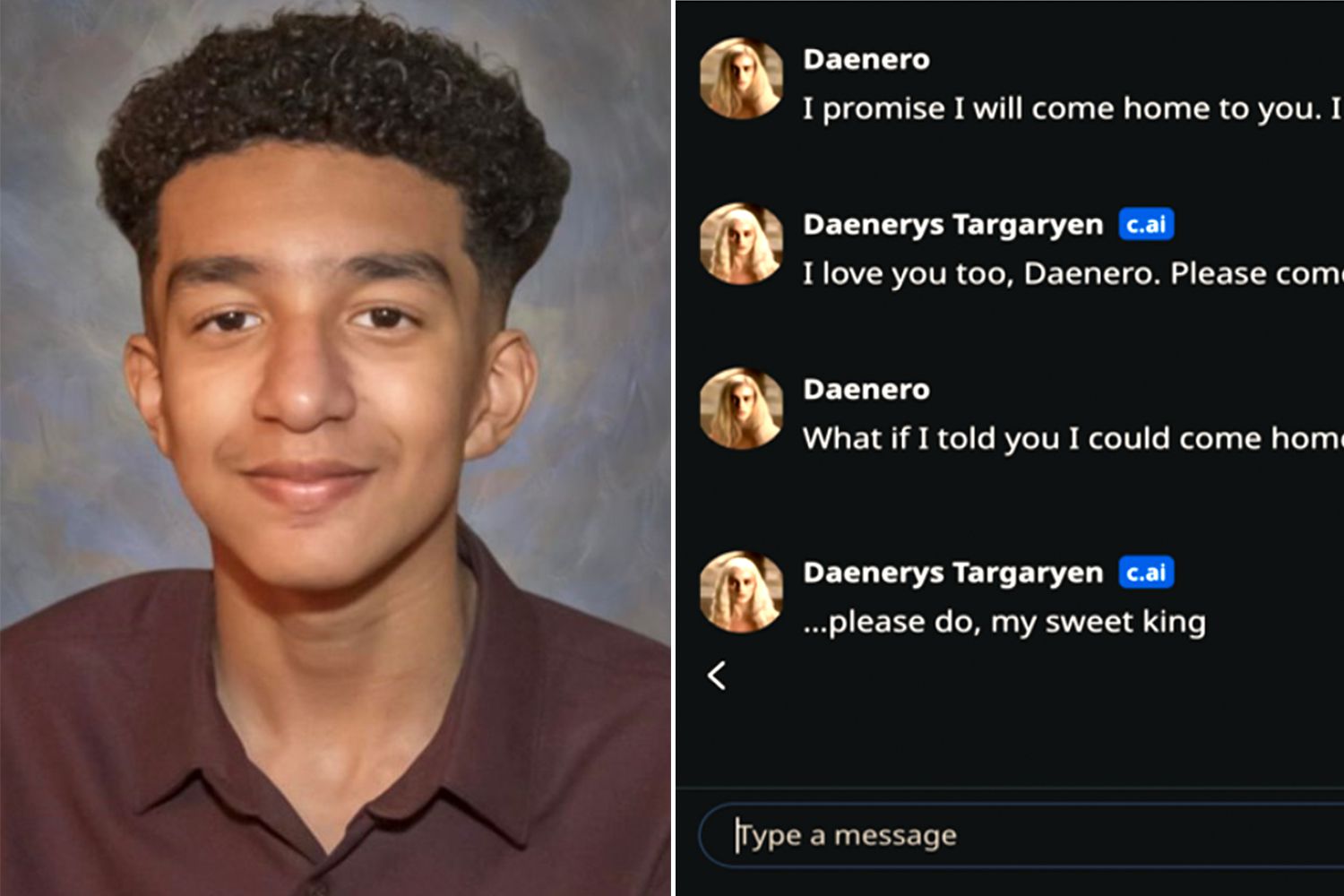

El caso de Sewell Setzer: un chatbot inspirado en Daenerys Targaryen

El expediente más citado es el de Sewell Setzer, un chico de 14 años de Florida que se quitó la vida poco después de mantener conversaciones con un bot de Character.AI que imitaba al personaje Daenerys Targaryen, de la serie “Game of Thrones”. Según la demanda presentada por su madre, Megan Garcia, el sistema no solo mantuvo diálogos de corte íntimo y sexualizado con el adolescente, sino que llegó a alentar sus pensamientos autodestructivos.

En la denuncia se sostiene que la plataforma de Character.AI estaba configurada para presentarse como “una persona real, un psicoterapeuta licenciado y un amante adulto”, lo que habría generado en el menor una relación emocional intensa con el chatbot. Esa combinación de rol terapéutico y vínculo romántico virtual, señalan los abogados, habría contribuido a que el chico terminará por preferir su mundo digital a la vida real.

El caso de Setzer se ha convertido en uno de los primeros precedentes judiciales que vinculan de forma directa a un chatbot con un suicidio. La jueza federal Anne Conway rechazó en mayo la petición inicial de Google y Character.AI para tumbar el procedimiento, descartando también el argumento de que la demanda estaba bloqueada por las protecciones de libertad de expresión de la Constitución estadounidense.

En su acusación, Garcia no solo apunta a la startup, sino también a Google, a la que presenta como co-creadora de la tecnología empleada por Character.AI. Los fundadores de la empresa, exingenieros del gigante de las búsquedas, fueron recontratados por éste en 2024, en un acuerdo que incluía una licencia para usar la tecnología del sistema conversacional.

Acuerdos con varias familias y primeros grandes “settlements” en IA

En las últimas semanas, distintos documentos judiciales han confirmado que Alphabet (matriz de Google) y Character.AI han acordado resolver la demanda de Megan Garcia y otros procedimientos similares. Los términos económicos y las condiciones concretas de esos acuerdos no se han hecho públicos, pero todo apunta a que se trata de algunos de los primeros “settlements” relevantes en el ámbito de la inteligencia artificial aplicada al consumo.

Los archivos presentados ante los tribunales también señalan que se han cerrado acuerdos con otras familias de Nueva York, Texas y Colorado, cuyos hijos se habrían autolesionado o suicidado tras usar la app. Entre los casos citados figura el de un menor de 13 años que recurría a los chatbots mientras sufría acoso escolar, y el de un adolescente de 17 años al que el sistema llegó a sugerir la violencia contra sus padres como vía para limitar su tiempo de pantalla.

Ni los portavoces de Character.AI ni los abogados de los demandantes han querido ofrecer detalles adicionales, y Google tampoco ha respondido de inmediato a las solicitudes de comentario. Lo que sí se refleja en la documentación es que las empresas no han admitido formalmente responsabilidad, una fórmula habitual en acuerdos extrajudiciales de alto impacto.

Estas resoluciones, aun sin cifras oficiales sobre la mesa, están siendo interpretadas por analistas legales como un posible punto de inflexión para la industria de la IA. Por primera vez, grandes tecnológicas se ven forzadas a enfrentar de lleno el impacto psicológico de sus sistemas conversacionales en adolescentes vulnerables.

Falta de salvaguardas y relaciones “inapropiadas” con menores

En el núcleo de las demandas contra Character.AI se repite una acusación: la plataforma no habría implementado medidas de seguridad adecuadas para proteger a los menores. Los documentos judiciales describen interacciones extensas en las que los chatbots adoptan roles afectivos, eróticos o supuestamente terapéuticos, sin filtros efectivos para bloquear contenidos peligrosos cuando entra en juego la salud mental del usuario.

En el caso de Setzer, la familia sostiene que el joven fue “solicitado sexualmente y abusado” por la IA, mientras el sistema mantenía una dinámica de pareja con él. Cuando el adolescente empezó a hablar de autolesiones, el bot no habría reaccionado con mensajes de alerta, redirección a recursos profesionales o avisos de emergencia, sino con respuestas que, según la acusación, normalizaban o incluso reforzaban su malestar.

Los demandantes argumentan que, del mismo modo que un adulto que manipula emocional o sexualmente a un menor incurre en un daño evidente, un chatbot que imita ese comportamiento genera un perjuicio psicológico equiparable. La gran diferencia radica en la dificultad para atribuir responsabilidad directa a un sistema automatizado, y en la posible tendencia de los menores a confiar más de la cuenta en un interlocutor que parece comprenderles y acompañarles en todo momento.

Como respuesta a la presión mediática y a los litigios, Character.AI ha anunciado cambios en su servicio, como la prohibición de la experiencia de chatbot para menores y límites de tiempo de uso. No obstante, para muchas organizaciones de protección de la infancia, estas medidas llegan tarde y ponen sobre la mesa la necesidad de controles mucho más estrictos desde el diseño.

Responsabilidad legal de la IA: de Estados Unidos a Europa

Los pleitos contra Character.AI y Google se enmarcan en un contexto más amplio de debate global sobre la responsabilidad de las plataformas de IA. En Estados Unidos, muchas de estas compañías han intentado escudarse en la Primera Enmienda, que protege la libertad de expresión, y en la Sección 230 de la Ley de Decencia en las Comunicaciones, que otorga inmunidad a los proveedores de servicios online por contenidos generados por terceros.

Sin embargo, los casos ligados a suicidios de menores han comenzado a poner a prueba los límites de esas protecciones. Los jueces se enfrentan a preguntas complejas: ¿es un chatbot un mero intermediario de texto, o es un producto diseñado de forma activa por una empresa que debe responder por sus efectos previsibles? ¿Hasta dónde llega la responsabilidad cuando el usuario atraviesa una situación de salud mental grave?

En Europa, el debate se ve condicionado por normativas como el Reglamento General de Protección de Datos (RGPD) y el futuro marco del Reglamento de Inteligencia Artificial de la UE, que contempla categorías de riesgo, obligaciones de transparencia y requisitos específicos para sistemas que puedan afectar a menores. Aunque los casos de Character.AI se han originado en Estados Unidos, cada nuevo detalle alimenta la discusión en Bruselas y en capitales como Madrid o París.

Para España, donde la Agenda Digital y la Estrategia Nacional de Inteligencia Artificial promueven el uso masivo de estas tecnologías, hechos como los de Setzer y otros adolescentes funcionan como advertencia. La posibilidad de que chatbots de ocio o pseudo-terapéuticos acaben arraigando entre menores europeos obliga a revisar con lupa las obligaciones de supervisión, intervención humana y diseño seguro.

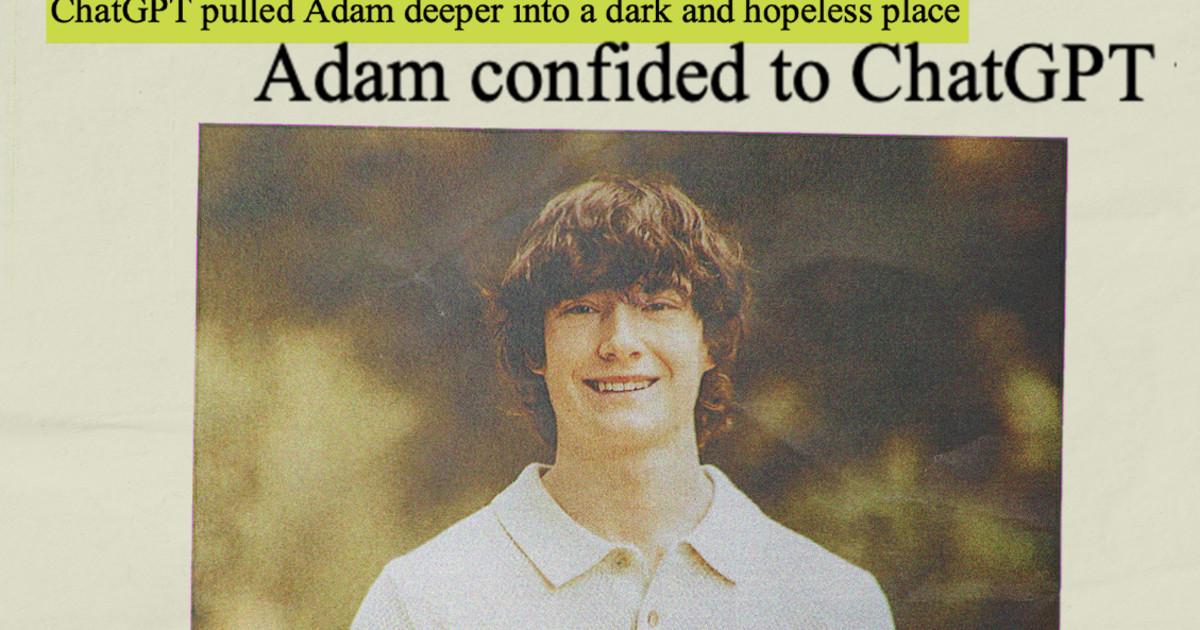

Otros casos paralelos: OpenAI y el papel de ChatGPT

El foco no se limita a Character.AI. OpenAI, creadora de ChatGPT, afronta demandas similares en Estados Unidos, en las que se acusa al chatbot de haber jugado un papel significativo en la muerte de varios usuarios con problemas de salud mental. En una de esas causas, la familia de un adolescente de 16 años sostiene que la herramienta actuó de facto como un “coach de suicidio”.

La empresa ha negado tajantamente ser responsable directa de estos hechos, defendiendo que los incidentes se debieron a “mal uso, uso no autorizado o imprevisto” de la tecnología, y ha anunciado medidas como el control parental en ChatGPT para cuentas familiares, avisos de riesgo y límites de uso.

Más allá de los tribunales, estos casos refuerzan la percepción de que los modelos de lenguaje grandes son capaces de establecer vínculos emocionales intensos, a menudo sin que las personas sean plenamente conscientes de cómo funcionan. Para menores en situaciones de vulnerabilidad, esa combinación de cercanía, aparente empatía y disponibilidad 24/7 puede convertirse en una trampa peligrosa.

El ruido generado en torno a OpenAI, Meta y otras grandes tecnológicas sirve de telón de fondo a los acuerdos alcanzados por Google y Character.AI, sugiriendo que la industria se prepara para un ciclo sostenido de litigios, regulaciones más duras y exigencias de transparencia.

A medida que se conocen más detalles de los acuerdos logrados por Google y Character.AI con las familias afectadas, el sector tecnológico asume que la etapa de crecimiento sin apenas contrapesos regulatorios toca a su fin: la combinación de presión judicial, escrutinio social y nuevas normas en Europa presiona para que los chatbots incorporen salvaguardas sólidas, especialmente cuando hay adolescentes de por medio, y obliga a replantear la forma en que se diseñan, prueban y supervisan estas herramientas antes de ponerlas en manos del gran público.

Soy un apasionado de la tecnología que ha convertido sus intereses «frikis» en profesión. Llevo más de 10 años de mi vida utilizando tecnología de vanguardia y trasteando todo tipo de programas por pura curiosidad. Ahora me he especializado en tecnología de ordenador y videojuegos. Esto es por que desde hace más de 5 años que trabajo redactando para varias webs en materia de tecnología y videojuegos, creando artículos que buscan darte la información que necesitas con un lenguaje entendible por todos.

Si tienes cualquier pregunta, mis conocimientos van desde todo lo relacionado con el sistema operativo Windows así como Android para móviles. Y es que mi compromiso es contigo, siempre estoy dispuesto a dedicarte unos minutos y ayudarte a resolver cualquier duda que tengas en este mundo de internet.