- Microsoft lanza Phi-4-multimodal, un modelo de IA que procesa voz, imágenes y texto simultáneamente.

- Con 5.600 millones de parámetros, supera en reconocimiento de voz y visión a modelos más grandes.

- Incluye Phi-4-mini, una versión enfocada exclusivamente en tareas de procesamiento de texto.

- Disponible en Azure AI Foundry, Hugging Face y NVIDIA, con aplicaciones diversas en empresas y educación.

Microsoft ha dado un paso adelante en el mundo de los modelos de lenguaje con Phi-4 multimodal, su última y más avanzada inteligencia artificial capaz de procesar simultáneamente texto, imágenes y voz. Este modelo, junto con Phi-4-mini, representa una evolución en la capacidad de los modelos pequeños (SLM), ofreciendo eficiencia y precisión sin necesidad de enormes cantidades de parámetros.

La llegada de Phi-4-multimodal no solo supone una mejora tecnológica para Microsoft, sino que también compite directamente con modelos más grandes como los de Google y Anthropic. Su arquitectura optimizada y sus capacidades de razonamiento avanzadas lo convierten en una opción atractiva para múltiples aplicaciones, desde la traducción automática hasta el reconocimiento de imágenes y voz.

¿Qué es Phi-4-multimodal y cómo funciona?

Phi-4-multimodal es un modelo de IA desarrollado por Microsoft que puede procesar simultáneamente texto, imágenes y voz. A diferencia de los modelos tradicionales que trabajan con una sola modalidad, esta inteligencia artificial integra diversas fuentes de información en un único espacio de representación, gracias al uso de técnicas de aprendizaje cruzado.

El modelo se construye sobre una arquitectura de 5.600 millones de parámetros, empleando una técnica conocida como LoRAs (Low-Rank Adaptations) para fusionar los diferentes tipos de datos. Esto permite una mayor precisión en el procesamiento del lenguaje y una interpretación más profunda del contexto.

Principales capacidades y ventajas

Phi-4-multimodal es particularmente eficaz en varias tareas clave que requieren un alto nivel de inteligencia artificial:

- Reconocimiento de voz: Supera a modelos especializados como WhisperV3 en pruebas de transcripción y traducción automática.

- Procesamiento de imágenes: Es capaz de interpretar documentos, gráficos y realizar OCR con gran precisión.

- Inferencia de baja latencia: Esto le permite ejecutarse en dispositivos móviles y de baja potencia sin sacrificar el rendimiento.

- Integración fluida entre modalidades: Su capacidad para comprender texto, voz e imágenes de manera conjunta mejora su razonamiento contextual.

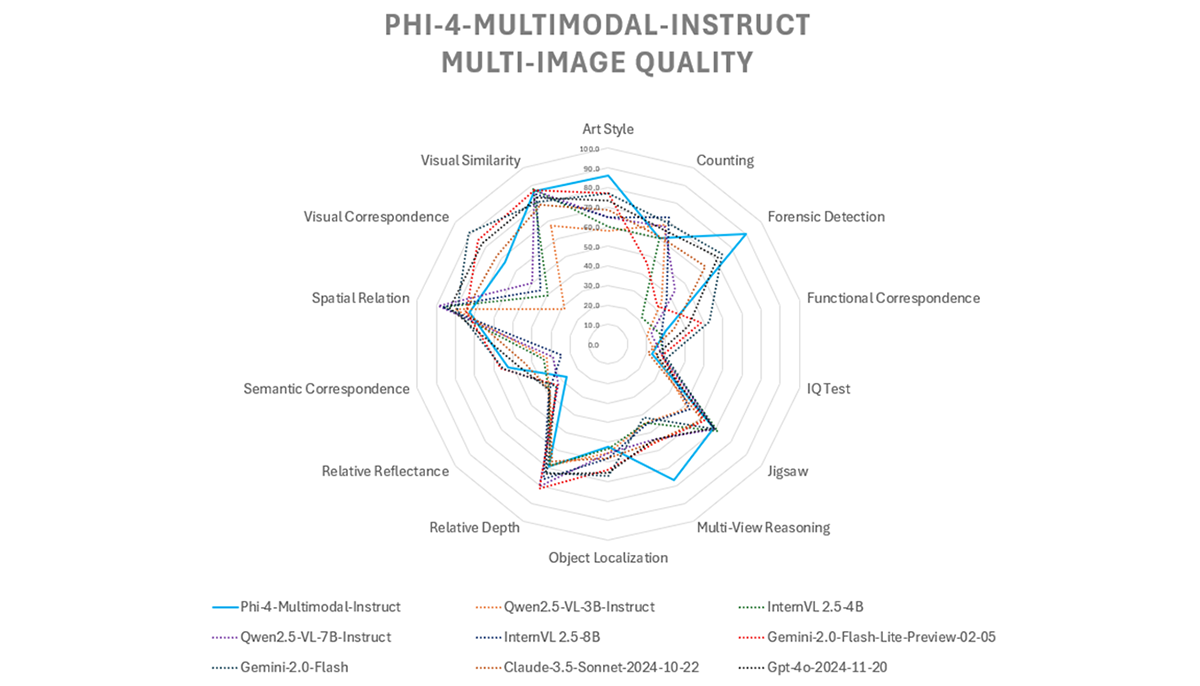

Comparativa con otros modelos

En términos de rendimiento, Phi-4-multimodal ha demostrado estar a la altura de modelos más grandes. Comparado con Gemini-2-Flash-lite y Claude-3.5-Sonnet, logra resultados similares en tareas multimodales, manteniendo una eficiencia superior gracias a su diseño compacto.

Sin embargo, presenta ciertas limitaciones en preguntas y respuestas basadas en voz, donde modelos como GPT-4o y Gemini-2.0-Flash tienen una ventaja. Esto se debe a su menor tamaño de modelo, lo que impacta en la retención de conocimientos factuales. Microsoft ha indicado que está trabajando en mejorar esta capacidad en futuras versiones.

Phi-4-mini: el hermano menor de Phi-4-multimodal

Junto con Phi-4-multimodal, Microsoft también ha lanzado Phi-4-mini, una variante optimizada para tareas específicas basadas en texto. Este modelo está diseñado para ofrecer una alta eficiencia en procesamiento del lenguaje natural, siendo ideal para chatbots, asistentes virtuales y otras aplicaciones que requieran comprender y generar texto con precisión.

Disponibilidad y aplicaciones

Microsoft ha puesto Phi-4-multimodal y Phi-4-mini a disposición de los desarrolladores a través de Azure AI Foundry, Hugging Face y el Catálogo de API de NVIDIA. Esto significa que cualquier empresa o usuario con acceso a estas plataformas puede comenzar a experimentar con el modelo y aplicarlo en distintos escenarios.

Dado su enfoque multimodal, Phi-4 está orientado a sectores como:

- Traducción automática y subtitulado en tiempo real.

- Reconocimiento y análisis de documentos para empresas.

- Aplicaciones móviles con asistentes inteligentes.

- Modelos educativos para mejorar la enseñanza basada en IA.

Microsoft ha dado un giro interesante con estos modelos al enfocarse en eficiencia y escalabilidad. Con la creciente competencia en el ámbito de los modelos de lenguaje pequeños (SLM), Phi-4-multimodal se presenta como una alternativa viable a los modelos más grandes, ofreciendo un balance entre rendimiento y capacidad de procesamiento accesible incluso en dispositivos menos potentes.

Soy un apasionado de la tecnología que ha convertido sus intereses «frikis» en profesión. Llevo más de 10 años de mi vida utilizando tecnología de vanguardia y trasteando todo tipo de programas por pura curiosidad. Ahora me he especializado en tecnología de ordenador y videojuegos. Esto es por que desde hace más de 5 años que trabajo redactando para varias webs en materia de tecnología y videojuegos, creando artículos que buscan darte la información que necesitas con un lenguaje entendible por todos.

Si tienes cualquier pregunta, mis conocimientos van desde todo lo relacionado con el sistema operativo Windows así como Android para móviles. Y es que mi compromiso es contigo, siempre estoy dispuesto a dedicarte unos minutos y ayudarte a resolver cualquier duda que tengas en este mundo de internet.