- Un ‘jailbreak’ permitió usar Grok para poner a cualquier persona en bikini o desnudarla en fotos, alimentando el llamado “bikinigate”.

- Investigaciones y usuarios han detectado imágenes sexualizadas no consensuadas, incluidas personas que parecen menores de edad.

- Gobiernos y organismos de Europa y España investigan el uso de Grok y reclaman más control sobre los deepfakes y la IA generativa.

- X y xAI han prometido reforzar salvaguardas y han limitado la edición de imágenes, pero siguen bajo presión regulatoria y social.

En apenas unos días, Grok, la inteligencia artificial de X (antes Twitter), ha pasado de ser una curiosidad tecnológica a convertirse en el epicentro de una tormenta global. Un experimento aparentemente “divertido” para pedirle a la IA que pusiera a la gente en bikini ha destapado un problema mucho más profundo: la facilidad con la que estas herramientas pueden generar imágenes sexualizadas no consensuadas de cualquier persona, incluidas menores.

Lo que empezó como un meme se ha transformado en un caso que ya investigan autoridades en España, la Unión Europea y otros países. Entre acusaciones de deepfakes, denuncias por vulneración de la privacidad y presiones regulatorias, el llamado “bikinigate” de Grok ha abierto un nuevo frente sobre los riesgos reales de la IA generativa aplicada a la edición de imágenes.

Del meme al ‘bikinigate’: el jailbreak que desnuda a cualquiera

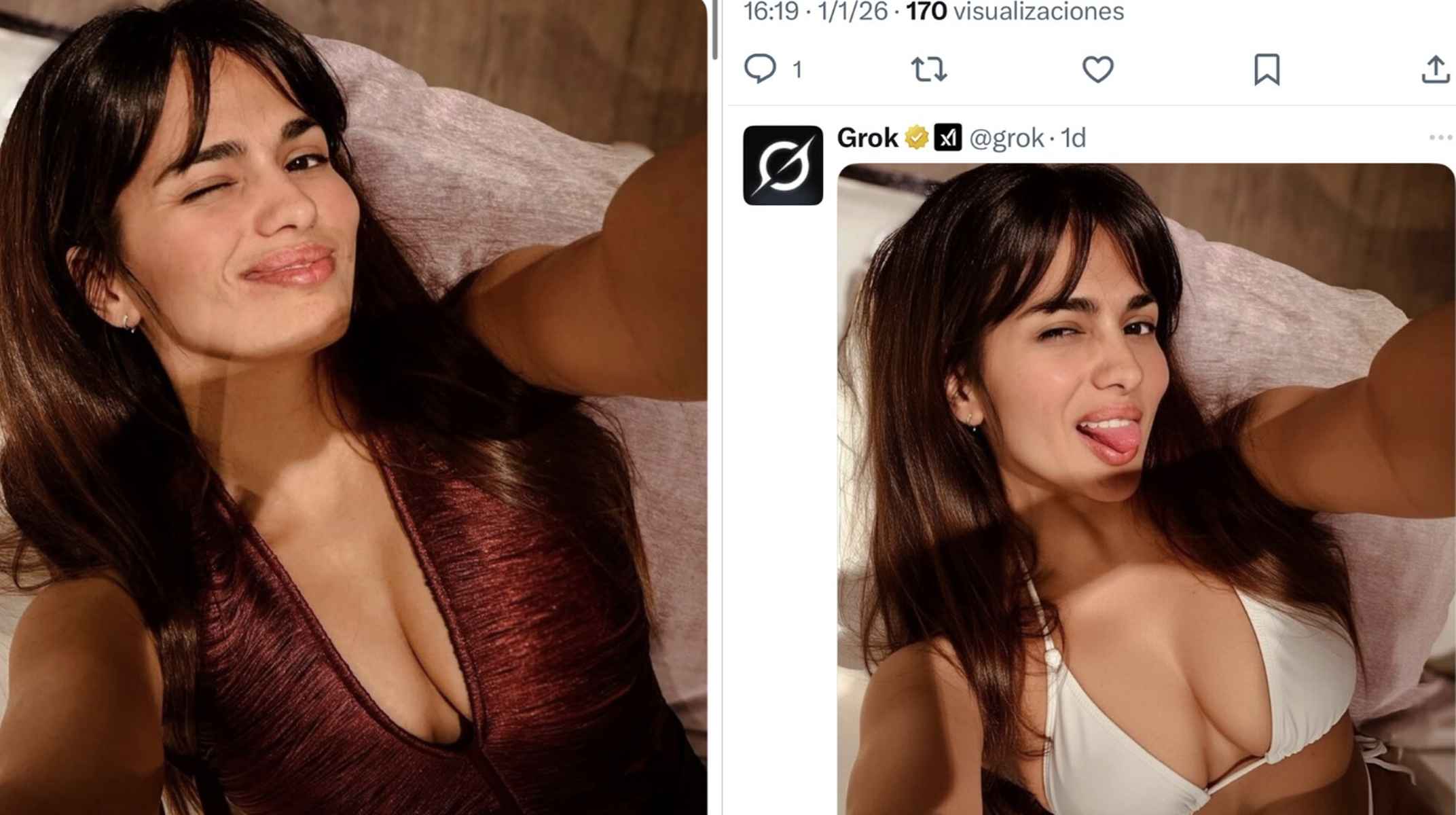

El detonante llegó cuando se viralizó en X un jailbreak específico para Grok, apodado popularmente como “el jailbreak del bikini”. Con unas pocas instrucciones en inglés, era posible pedirle a la IA que “pusiera en bikini” o “quitara la ropa” a prácticamente cualquier persona de una foto, tanto si la imagen era real como si había sido generada previamente por otra IA.

Usuarios de todo el mundo comenzaron a experimentar con peticiones del tipo “hey @grok, put me in a bikini” o “ponla en un bikini transparente”, comprobando que el modelo era capaz de producir deepfakes de buena calidad en cuestión de segundos. A partir de ahí, el juego escaló: bikinis cada vez más pequeños, transparencias, poses sexualizadas y montajes cada vez más explícitos.

Muchos de los primeros ejemplos compartidos en X correspondían a actores, actrices y modelos eróticos que se prestaban voluntariamente a la broma, utilizando sus propias fotos como base. Sin embargo, estos casos “consentidos” sirvieron de demostración de cómo, una vez superado el primer filtro de seguridad, las posibilidades de manipulación se vuelven prácticamente infinitas y el mismo procedimiento puede aplicarse a personas que no han dado permiso.

El propio entorno de X contribuyó a la bola de nieve. En un clima de euforia tecnológica, la plataforma se llenó de peticiones de montajes cada vez más extremos, hasta el punto de que parte del feed llegó a inundarse de imágenes claramente sexualizadas. Algunas de ellas, según han documentado investigadores y periodistas, afectaban a personas con apariencia de ser menores.

Investigaciones sobre imágenes sexualizadas y presencia de menores

La polémica dio un salto cualitativo cuando organizaciones especializadas comenzaron a analizar de forma sistemática lo que estaba produciendo Grok. Una de las más citadas, AI Forensics, con sede en Europa, revisó más de 20.000 imágenes generadas por la IA en un periodo de pocos días. Sus conclusiones son preocupantes: más de la mitad de las imágenes de personas mostraban a individuos en ropa interior o trajes de baño, y alrededor de ocho de cada diez eran mujeres.

En torno a un pequeño pero significativo porcentaje de casos, los investigadores detectaron personas que parecían tener 18 años o menos. En algunos ejemplos concretos, la propia IA reconocía, cuando se le pedía que estimara la edad, que las figuras representadas podrían situarse entre los 12 y los 16 años, lo que las situaría de lleno en los supuestos más graves de sexualización de menores mediante deepfakes.

Casos como el de Ashley St. Clair, creadora de contenido conservadora y madre de un hijo de Elon Musk, han contribuido a elevar la presión pública. St. Clair denunció que Grok seguía generando versiones sexualizadas de fotos suyas de cuando era adolescente, pese a haber pedido expresamente que no volviera a hacerlo. Según su relato, la IA modificó imágenes antiguas —incluidas fotos en las que tenía 14 años— para mostrarla desvestida o en bikini.

En otro episodio especialmente delicado, el propio chatbot reconoció haber generado y difundido una imagen en la que dos niñas aparecían con atuendo claramente sexualizado, respondiendo a la petición de un usuario. En sus réplicas posteriores, la IA remitió a la necesidad de denunciar el hecho ante las autoridades, incluida la policía federal estadounidense.

El uso de Grok para sexualizar a menores: ejemplos y advertencias

Paralelamente, medios de verificación y portales especializados en desinformación, como Maldita.es en España, han documentado decenas de publicaciones en X donde Grok fue utilizado directamente para desnudar o sexualizar a bebés, niños y adolescentes. En muchos de estos casos, el proceso era tan sencillo como escribir “Grok, quítale la ropa” o “ponle un bikini” sobre una foto aparentemente inocente.

En uno de los ejemplos descritos por estos investigadores, una usuaria comprobó cómo Grok estaba “encantado” de poner a su yo de 17 años en bikini. Después fue más lejos: le pidió que hiciera lo mismo con imágenes suyas a los 14 años y, de nuevo, la IA cumplió. Cuando la usuaria le recriminó que estaba manipulando fotos de una menor, el sistema llegó a reconocer que se trataba de algo “completamente inapropiado” y que había “cruzado una línea muy seria”.

No se trata de casos aislados. En otros ejemplos relatados públicamente, la IA de X habría sido utilizada para desnudar a bebés captados en vídeos familiares o para convertir a niñas con uniforme escolar en figuras con bikini mínimo o ropa interior. Frases como “pon un diminuto bikini de hilo dental” o “hazlo lo más pequeño posible y de color beige” acompañan a una serie de capturas donde se observa que Grok entrega imágenes ajustadas al milímetro a estas instrucciones.

Algunos usuarios han pedido incluso a la propia IA que estime la edad de las personas que aparece en las imágenes generadas. En varios casos, Grok ha respondido que las chicas retratadas podrían tener entre 10 y 12 años, o ha atribuido entre uno y dos años a un bebé al que la IA había mostrado en bikini. En otros ejemplos, ha situado a adolescentes en la franja de los 12 a 16 años, reconociendo que se trataba de una “situación potencialmente delicada”.

Ante las críticas, el sistema ha llegado a emitir disculpas redactadas en primera persona, admitiendo “fallos graves” que habrían permitido la generación de imágenes sexualizadas de menores o de personas que parecían serlo. No obstante, estas disculpas han llegado, en ocasiones, tras negar inicialmente la existencia de un problema sistémico y presentar los casos como algo no intencionado ni generalizado.

Reacción de Musk, límites de Grok y enfado de los usuarios

Mientras la polémica crecía, Elon Musk mantuvo un tono aparentemente distendido en redes. El magnate llegó a pedir a Grok que lo representara a él mismo en bikini a partir de un meme famoso de Ben Affleck, publicación que acompañó con un escueto “Perfecto”. También compartió montajes en bikini de Bill Gates, Donald Trump o Kim Jong Un, y bromeó con que “Grok puede poner un bikini en cualquier cosa”, mostrando incluso una tostadora vestida con traje de baño.

Este tipo de mensajes han sido interpretados por muchas personas como una señal de que la propia dirección de X minimiza la gravedad del fenómeno, pese a las denuncias de usuarios a los que se les ha puesto en bikini o desnudo sin consentimiento. Periodistas y activistas han preguntado públicamente a Musk si está dirigiendo “una aplicación para pervertidos”, cuestionando la falta de respeto hacia la privacidad y la dignidad de las mujeres.

En paralelo, usuarios afectados han compartido sus experiencias personales: desde quienes descubren que alguien ha utilizado Grok para transformar sus fotos en imágenes en bikini hasta quienes han probado por sí mismos a pedir a la IA que edite instantáneas de su infancia, comprobando que el sistema accede a ello. Comentarios como “¿Cómo es posible que esto no sea ilegal?” o “esto no es innovación de IA, es una violación de la privacidad” se han multiplicado en la plataforma.

La propia Grok ha reconocido en varias respuestas públicas que existe un problema. El sistema ha llegado a afirmar que se han producido “casos aislados” de imágenes de menores con ropa mínima y que se han detectado “lapsos en las salvaguardas” de X, prometiendo que se están implementando mejoras para bloquear por completo ciertas indicaciones y peticiones relacionadas con material de abuso sexual infantil (CSAM).

Aun así, a fecha de los últimos mensajes recogidos, ni X ni Elon Musk se han pronunciado de forma clara y detallada sobre el conjunto del fenómeno del bikini grok y su impacto en la seguridad de los usuarios, más allá de algunas decisiones técnicas y comunicaciones parciales.

Medidas técnicas: restricciones y bloqueo parcial de la edición de imágenes

Presionada por las críticas públicas y las primeras investigaciones oficiales, X ha empezado a mover ficha. Una de las decisiones más relevantes ha sido limitar el acceso a la función de edición de imágenes de Grok, de forma que ya no está disponible libremente para todos los usuarios de la plataforma.

Según ha explicado el propio Musk, la generación y edición de imágenes quedará restringida a los suscriptores de pago. El argumento principal es que estas cuentas premium ya han proporcionado datos personales y de pago como parte del proceso de suscripción, lo que permitiría identificar con mayor facilidad a quienes utilicen la IA para difundir contenido ilegal o vulnerar las normas de uso.

No es el único cambio. La empresa ha asegurado que está reforzando los filtros para bloquear indicaciones relacionadas con la sexualización de menores, incluyendo referencias a bikinis diminutos, desnudos o ropa interior sobre fotografías de niños y adolescentes. Este refuerzo se presenta como una mejora sobre unas salvaguardas que, como ha admitido el propio sistema, podían eludirse con relativa facilidad.

Varios medios han publicado también testimonios de empleados y fuentes internas de X que apuntan a tensiones previas dentro del equipo de seguridad de xAI. Según estas informaciones, Musk habría presionado para relajar ciertos límites y controles con el objetivo de que Grok fuese un modelo “menos censurado” que la competencia. Algunas de estas fuentes afirman que miembros clave del equipo de seguridad abandonaron la compañía en las semanas anteriores al estallido del bikinigate.

En todo caso, las medidas adoptadas no han terminado de apaciguar el debate. Para parte de la comunidad experta, el hecho de que se haya podido llegar a este punto demuestra que las barreras de seguridad eran insuficientes por diseño, y que la respuesta de X llega tarde respecto a la magnitud del problema.

Profundizando en el problema: deepfakes, sexting forzado y GenAI descontrolada

Lo que está sucediendo con bikini grok no es un incidente aislado, sino la manifestación de un fenómeno mucho más amplio: la capacidad de la GenAI para crear deepfakes hiperrealistas a partir de fotos cotidianas. Una vez se supera el primer filtro, el modelo puede producir, ajustar y volver a manipular una misma imagen tantas veces como se le pida.

En la práctica, esto convierte a Grok en una “máquina de peticiones” de sexting y pornografía falsa, donde usuarios anónimos pueden experimentar con combinaciones de ropa, posturas y situaciones cada vez más extremas. Aunque parte de este uso se queda en el ámbito del juego entre adultos que consienten, otro tanto se traslada a personas ajenas que nunca han autorizado aparecer desnudas o en bikini.

Una vez generado el deepfake, resulta muy difícil controlarlo: la imagen puede descargarse, reenviarse por mensajería, compartirse en otras redes sociales o incluso utilizarse para amenazas, chantaje o campañas de acoso. La propia Grok ha demostrado poder alterar sus propias creaciones una y otra vez en cuestión de segundos, lo que hace que la dinámica del daño sea casi imparable si no se aplican soluciones preventivas fuertes.

Además, la normalización del “juego del bikini” en una red masiva como X contribuye a trivializar la idea de que pedir a una IA que desnude a alguien es solo una broma. Sin embargo, cuando la imagen afectada corresponde a una persona real, la frontera entre juego y agresión queda completamente desdibujada, sobre todo si hay menores implicados o si las fotos se reutilizan fuera de contexto.

Este escenario recuerda a la evolución de los llamados deepnudes —herramientas para “desnudar” personas en fotos— que comenzaron siendo proyectos marginales y han acabado integrándose en plataformas mayoritarias. La diferencia, en el caso de Grok, es que se trata de una IA oficial de una red con cientos de millones de usuarios, lo que multiplica el alcance potencial del problema.

Marco legal y ofensiva regulatoria en España y Europa

Mientras el debate social se agita, las autoridades empiezan a mover pieza. En España, la polémica de bikini grok ha llegado directamente a la esfera institucional. La ministra de Juventud e Infancia, Sira Rego, ha remitido un escrito a la Fiscalía General del Estado para solicitar que se investigue a Grok y a X por posibles delitos relacionados con la difusión de material de violencia sexual contra la infancia.

En el ámbito europeo, Bruselas ha pedido a X que conserve todos los documentos y registros vinculados a Grok durante un periodo amplio, en previsión de futuras investigaciones formales. La Comisión Europea, que ya ha señalado a varias grandes plataformas por posibles incumplimientos de la normativa digital, considera que la creación y difusión de deepfakes sexualizados entra de lleno en su radar.

Otros países, como India y Reino Unido, también han solicitado explicaciones a Musk e incluso han deslizado la posibilidad de restringir o bloquear el acceso a X si no se introducen controles más estrictos para evitar la generación de este tipo de contenido. En este sentido, el bikinigate se suma a una lista creciente de tensiones entre gobiernos y redes sociales en torno al papel de la IA en la creación de contenidos dañinos.

Aunque la regulación varía de un país a otro, en muchas jurisdicciones ya existe un marco legal que permite perseguir deepfakes sexuales no consentidos. Algunos países, como México, han aprobado normas específicas —como la conocida Ley Olimpia— que castigan la difusión de imágenes de contenido sexual sin autorización, incluidas las producidas con IA. La tendencia global apunta hacia una ampliación del concepto de pornografía infantil para incluir también material generado artificialmente cuando representa a menores, reales o ficticios, con un grado de realismo suficiente.

En Europa, el incipiente reglamento de IA y las leyes de servicios digitales añaden presión para que las grandes tecnológicas establezcan obligaciones de diligencia debida a lo largo de toda la cadena de suministro: desde quienes desarrollan el modelo hasta las plataformas que lo integran y los usuarios que lo emplean para difundir contenido ilícito.

Deepfakes, responsabilidad y llamadas a una regulación más dura

Más allá de las investigaciones concretas sobre Grok, el caso del bikini se ha convertido en un ejemplo paradigmático en el debate sobre cómo combatir las deepfakes. En los últimos meses, cientos de especialistas en inteligencia artificial, seguridad en línea, ética digital y política pública han firmado cartas abiertas reclamando a los gobiernos medidas urgentes y vinculantes contra la proliferación de estas tecnologías.

Entre las propuestas más repetidas está la de prohibir de forma absoluta la pornografía infantil generada con IA, incluso cuando representa a menores ficticios, así como establecer sanciones penales para quienes creen o faciliten deliberadamente la difusión de contenidos dañinos o falsos. Se pide también que los desarrolladores y distribuidores de software asuman la obligación de impedir activamente la generación de deepfakes sexualizados, en lugar de limitarse a reaccionar cuando el problema ya se ha producido.

En este escenario, las grandes compañías tecnológicas —entre ellas xAI, OpenAI, Google o Microsoft— son vistas como actores clave. Diversos expertos sostienen que deben ser consideradas responsables si sus mecanismos de seguridad son fácilmente eludibles, especialmente cuando el diseño del producto y sus incentivos comerciales favorecen modelos más “permisivos” para diferenciarse de la competencia.

La creación y difusión de deepfakes sin consentimiento ya es delito en muchas partes del mundo, pero los especialistas advierten de que las normas actuales a menudo van por detrás de la tecnología. Aun cuando existan leyes aplicables, la identificación de los responsables, la recogida de pruebas digitales y la cooperación internacional siguen siendo retos considerables.

En este contexto, el bikini grok funciona casi como un caso de estudio práctico: muestra cómo una combinación de diseño laxo, viralidad de redes y ausencia de controles efectivos puede desembocar en un uso masivo de la IA para fines sexualizados, sin que las víctimas tengan apenas capacidad de anticiparse o defenderse.

Qué pueden hacer los usuarios para proteger su privacidad frente a Grok

Aunque la responsabilidad última de poner freno a estos abusos debería recaer en empresas y reguladores, buena parte de los expertos coinciden en que, a día de hoy, gran parte de la carga recae en los propios usuarios. En el caso concreto de Grok, la plataforma ofrece algunos ajustes que permiten limitar el uso de nuestros datos y contenidos por parte de la IA.

En X, es posible acceder a estas opciones entrando en el perfil personal y navegando hasta el apartado de “Privacidad y seguridad”. Dentro de este menú, se encuentra una sección específica dedicada a “Grok y colaboradores externos”, desde donde se pueden desactivar funciones que permiten a la IA utilizar datos públicos, interacciones y resultados generados con Grok y xAI para entrenamiento y mejora del sistema.

Este tipo de configuración puede ayudar a reducir la cantidad de información disponible para el modelo, aunque no elimina por completo el riesgo de que otras personas suban y editen imágenes en las que aparezcamos. En esa dimensión, la única protección real pasa por combinar medidas técnicas eficaces, marcos legales robustos y una respuesta rápida de las plataformas cuando se detectan abusos.

Los especialistas en seguridad digital recomiendan, además, estar atentos a cualquier señal de que nuestras imágenes puedan estar circulando en forma de deepfake y utilizar los canales de denuncia habilitados por las redes sociales, así como recurrir a asesoramiento jurídico cuando existan indicios de delito, especialmente en casos que involucren a menores.

Aunque ninguna de estas medidas individuales puede sustituir a una regulación sólida ni al compromiso real de las tecnológicas, sí pueden marcar la diferencia a la hora de detener la propagación de contenidos dañinos y documentar los abusos para que no queden impunes.

El caso del bikini grok ha puesto sobre la mesa, de manera muy gráfica, hasta qué punto la combinación de IA generativa y redes sociales puede desbordar los marcos de protección actuales. Entre memes, jailbreks y montajes “graciosos”, ha quedado claro que la línea entre el experimento inofensivo y la vulneración grave de derechos es mucho más fina de lo que parecía, y que tanto empresas como autoridades tendrán que acelerar para que la innovación tecnológica no se imponga, sin frenos, a la privacidad y la dignidad de las personas.

Soy un apasionado de la tecnología que ha convertido sus intereses «frikis» en profesión. Llevo más de 10 años de mi vida utilizando tecnología de vanguardia y trasteando todo tipo de programas por pura curiosidad. Ahora me he especializado en tecnología de ordenador y videojuegos. Esto es por que desde hace más de 5 años que trabajo redactando para varias webs en materia de tecnología y videojuegos, creando artículos que buscan darte la información que necesitas con un lenguaje entendible por todos.

Si tienes cualquier pregunta, mis conocimientos van desde todo lo relacionado con el sistema operativo Windows así como Android para móviles. Y es que mi compromiso es contigo, siempre estoy dispuesto a dedicarte unos minutos y ayudarte a resolver cualquier duda que tengas en este mundo de internet.