- Los asistentes de IA almacenan contenido, identificadores, uso, ubicación y datos de dispositivos, con revisión humana en ciertos casos.

- Existen riesgos en todo el ciclo de vida (ingestión, entrenamiento, inferencia y app), incluidos prompt injection y filtraciones.

- RGPD, AI Act y marcos como NIST AI RMF exigen transparencia, minimización y controles proporcionales al riesgo.

- Configura actividad, permisos y borrado automático; evita datos sensibles, usa 2FA y revisa políticas y proveedores.

La inteligencia artificial ha pasado de promesa a rutina en tiempo récord y, con ello, han aparecido dudas muy concretas: qué datos recopilan los asistentes de IA, cómo los usan y qué podemos hacer para mantener a salvo nuestra información. Si utilizas chatbots, asistentes en el navegador o modelos generativos, conviene tomar el control de tu privacidad cuanto antes.

Además de ser herramientas tremendamente útiles, estos sistemas se alimentan de datos a gran escala. El volumen, la procedencia y el tratamiento de esa información introducen riesgos nuevos: desde la inferencia de rasgos personales hasta la exposición accidental de contenidos sensibles. Aquí encontrarás, con detalle y sin rodeos, qué capturan, para qué lo hacen, qué dice la ley y cómo blindar tus cuentas y tu actividad. Vamos a aprender todo sobre qué datos recopilan los asistentes de IA y cómo proteger tu privacidad.

Qué datos recopilan realmente los asistentes de IA

Los asistentes modernos procesan mucho más que tus preguntas. Datos de contacto, identificadores, uso y contenido suelen figurar entre las categorías habituales. Hablamos de nombre y correo, pero también de direcciones IP, información del dispositivo, registros de interacción, errores y, por supuesto, el propio contenido que generas o subes (mensajes, archivos o imágenes o enlaces públicos).

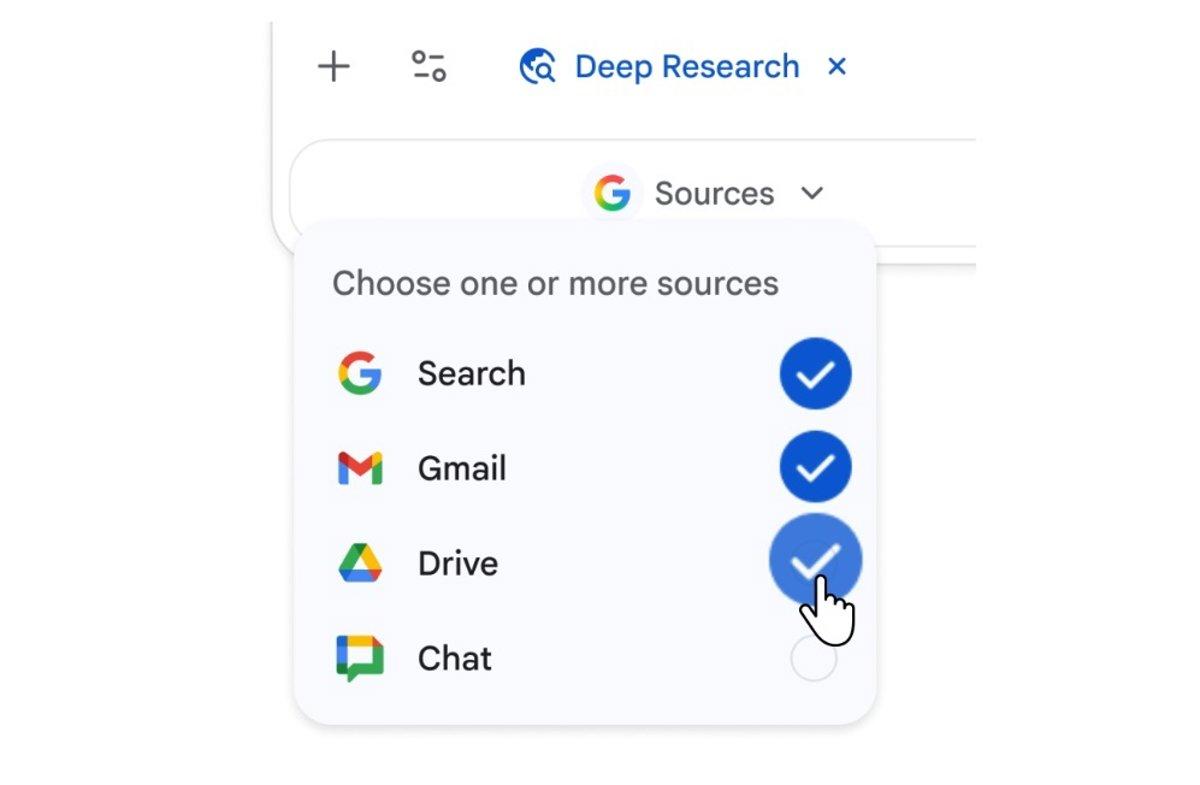

En el ecosistema de Google, el aviso de privacidad de Gemini describe con precisión que recoge información de aplicaciones conectadas (por ejemplo, historial de Búsqueda o YouTube, contexto de Chrome), datos de dispositivos y navegadores (tipo, ajustes, identificadores), métricas de rendimiento y depuración, e incluso permisos del sistema en móviles (como acceso a contactos, registros de llamadas y mensajes o contenido en pantalla) cuando el usuario los autoriza.

También se tratan datos de ubicación (zona aproximada del dispositivo, IP o direcciones guardadas en la cuenta) y detalles de suscripción si usas planes de pago. Además, se almacenan los propios contenidos que generan los modelos (texto, código, audio, imágenes o resúmenes), algo clave para entender la huella que dejas al interactuar con estas herramientas.

Hay que tener en cuenta que la recopilación no se limita al entrenamiento: los asistentes pueden registrar actividad en tiempo real durante el uso (por ejemplo, cuando te apoyas en extensiones o plugins), lo que incluye telemetría y eventos de la aplicación. Esto explica por qué controlar permisos y revisar los ajustes de actividad es fundamental.

Para qué usan esos datos y quién puede verlos

Las empresas suelen invocar finalidades amplias y recurrentes: prestar, mantener y mejorar el servicio, personalizar la experiencia, desarrollar nuevas funciones, comunicarse contigo, medir rendimiento y proteger al usuario y a la plataforma. Todo eso, además, se extiende a tecnologías de aprendizaje automático y a los propios modelos generativos.

Una parte sensible del proceso es la revisión humana. Distintos proveedores reconocen que personal interno o de proveedores de servicios revisa muestras de interacciones para mejorar la seguridad y la calidad. De ahí una recomendación constante: evita incluir información confidencial que no querrías que viera una persona o que se emplee para refinar modelos.

En políticas conocidas, algunos servicios indican que no comparten con fines publicitarios ciertos datos, aunque sí pueden entregar información a autoridades bajo requerimiento legal. Otros, por su naturaleza, comparten con anunciantes o socios identificadores y señales agregadas para analítica y segmentación, lo que abre la puerta a la construcción de perfiles.

El tratamiento incluye, además, retención durante periodos predefinidos: por ejemplo, hay proveedores que establecen un borrado automático por defecto en 18 meses (ajustable a 3, 36 o indefinido), y conservan durante más tiempo conversaciones ya revisadas para fines de calidad y seguridad. Conviene revisar los plazos y activar la eliminación automática si buscas reducir tu huella.

Riesgos de privacidad a lo largo del ciclo de vida de la IA

La privacidad no se juega en un solo punto, sino en toda la cadena: ingestión de datos, entrenamiento, inferencia y capa de aplicación. En la recolección masiva pueden colarse datos sensibles sin el consentimiento adecuado; en el entrenamiento es fácil que se sobrepasen las expectativas originales de uso; durante la inferencia, los modelos pueden inferir rasgos personales a partir de señales aparentemente triviales; y en la aplicación, las API o interfaces web son objetivos atractivos para atacantes.

Con los sistemas generativos, los riesgos se multiplican (por ejemplo, juguetes con IA). Datasets extraídos de Internet sin permiso explícito pueden contener información personal, y ciertas entradas maliciosas (prompt injection) buscan manipular al modelo para que filtre contenido sensible o ejecute instrucciones peligrosas. Por otro lado, muchos usuarios pegan datos confidenciales sin valorar que podrían almacenarse o usarse para ajustar futuras versiones del modelo.

La investigación académica ha sacado a la luz problemas específicos. Un análisis reciente sobre asistentes de navegador detectó prácticas generalizadas de seguimiento y elaboración de perfiles, con transmisión de contenidos de búsqueda, datos de formularios sensibles y direcciones IP a servidores del proveedor. Además, se mostró la capacidad de inferir edad, género, ingresos e intereses, persistiendo la personalización en sesiones distintas; en ese estudio, solo un servicio no evidenció perfilado.

El historial de incidentes nos recuerda que el riesgo no es teórico: brechas de seguridad han expuesto historiales de conversaciones o metadatos de usuarios, y los atacantes ya aprovechan técnicas sobre modelos para extraer información de entrenamiento. Por si fuera poco, la automatización de las canalizaciones de IA dificulta detectar problemas de privacidad si no se diseñan salvaguardas desde el inicio.

Qué dicen las leyes y los marcos de referencia

La mayor parte de países cuentan ya con normas de privacidad en vigor, y aunque no todas son específicas de IA, sí aplican a cualquier sistema que trate datos personales. En Europa, el RGPD exige licitud, transparencia, minimización, limitación de la finalidad y seguridad; además, el AI Act europeo introduce categorías de riesgo, prohíbe prácticas de alto impacto (como el social scoring público) e impone requisitos estrictos a sistemas de alto riesgo.

En EE. UU., regulaciones estatales como CCPA o la ley de Texas otorgan derechos de acceso, eliminación y exclusión de venta de datos, mientras que iniciativas como la ley de Utah exigen avisos claros cuando el usuario interactúa con sistemas generativos. Estas capas normativas conviven con expectativas sociales: estudios de opinión muestran una desconfianza notable hacia el uso responsable de datos por parte de las empresas, y una discrepancia entre la autopercepción de los usuarios y su conducta real (por ejemplo, aceptar políticas sin leerlas).

Para aterrizar la gestión del riesgo, el marco de referencia del NIST (AI RMF) propone cuatro funciones continuas: Gobernar (políticas y supervisión responsables), Mapear (entender el contexto y los impactos), Medir (evaluar y monitorizar riesgos con métricas) y Gestionar (priorizar y mitigar). Este enfoque ayuda a adaptar controles según el nivel de riesgo del sistema.

Quién recopila más: radiografía de los chatbots más populares

Comparativas recientes sitúan a distintos asistentes en un espectro de recopilación. Gemini de Google encabeza el ranking al recoger el mayor número de puntos de datos únicos en diversas categorías (incluidos contactos del móvil, si se conceden permisos), algo que raramente aparece en otros competidores.

En el tramo medio figuran soluciones como Claude, Copilot, DeepSeek, ChatGPT y Perplexity, con entre diez y trece tipos de datos, variando la mezcla entre contacto, ubicación, identificadores, contenido, historial, diagnósticos, uso y compras. Grok se sitúa en la parte baja con un conjunto más limitado de señales.

También hay diferencias en el uso posterior: se ha documentado que algunos servicios comparten con anunciantes y socios comerciales ciertos identificadores (como correos cifrados) y señales para segmentación, mientras que otros declaran no emplear datos con fines publicitarios ni venderlos, si bien se reservan el derecho a responder a requerimientos legales o a usarlos para mejorar el sistema, salvo solicitud de eliminación por parte del usuario.

De cara al usuario final, esto se traduce en un consejo claro: revisa las políticas de cada proveedor, ajusta los permisos de la app y decide conscientemente qué información cedes en cada contexto, sobre todo si vas a subir archivos o compartir contenidos delicados.

Buenas prácticas imprescindibles para proteger tu privacidad

Antes de nada, configura a conciencia los ajustes de cada asistente. Explora qué se guarda, por cuánto tiempo y con qué finalidad, y activa la eliminación automática si está disponible. Revisa de forma periódica las políticas, porque cambian con frecuencia y pueden incorporar opciones nuevas de control.

Evita compartir datos personales y sensibles en tus prompts: nada de contraseñas, números de tarjeta, historiales médicos o documentos internos de tu empresa. Si necesitas tratar información delicada, plantéate mecanismos de anonimización, entornos cerrados o soluciones on-prem con gobernanza reforzada.

Protege tus cuentas con contraseñas robustas y autenticación en dos pasos (2FA). El acceso indebido a tu cuenta expone el historial, los ficheros subidos y las preferencias, útiles para ataques de ingeniería social muy creíbles o para la comercialización ilícita de datos.

Si la plataforma lo permite, desactiva el historial de chats o utiliza modalidades temporales. Esta simple medida reduce tu exposición en caso de brecha, como demuestran incidentes pasados en servicios populares de IA.

No te fíes ciegamente de las respuestas. Los modelos pueden alucinar, sesgarse o ser manipulados por entradas maliciosas (prompt injection), lo que deriva en instrucciones erróneas, datos falsos o la extracción de información sensible. Para temas legales, médicos o financieros, contrasta con fuentes oficiales.

Precaución máxima con enlaces, archivos y código que te entregue una IA. Puede haber contenido malicioso o vulnerabilidades introducidas adrede (envenenamiento de datos). Verifica URLs antes de hacer clic y analiza los ficheros con soluciones de seguridad reconocidas.

Desconfía de extensiones y plugins de procedencia dudosa. Hay un océano de complementos basados en IA y no todos son fiables; instala únicamente los imprescindibles y de fuentes reputadas para minimizar el riesgo de malware.

En el terreno corporativo, pon orden a la adopción. Define políticas de gobernanza específicas para IA, limita la recolección a lo necesario, exige consentimiento informado, audita proveedores y datasets (supply chain) y despliega controles técnicos (como DLP, monitorización de tráfico a apps de IA y controles de acceso granulares).

La sensibilización es parte del escudo: forma a tu equipo en riesgos de IA, phishing avanzado y uso ético. Iniciativas sectoriales que comparten información sobre incidentes de IA, como las impulsadas por organizaciones especializadas, fomentan el aprendizaje continuo y la mejora de defensas.

Configurar privacidad y actividad en Google Gemini

Si usas Gemini, entra en tu cuenta y revisa “Actividad en las Aplicaciones de Gemini”. Ahí puedes consultar y borrar interacciones, cambiar el periodo de eliminación automática (por defecto 18 meses, ajustable a 3 o 36 meses, o indefinido) y decidir si se usan para mejorar la IA de Google.

Es importante saber que, incluso con el guardado desactivado, tus conversaciones se usan para responder y mantener la seguridad del sistema, con apoyo de revisores humanos. Las conversaciones revisadas (y datos asociados como idioma, tipo de dispositivo o ubicación aproximada) pueden conservarse hasta tres años.

En móviles, revisa los permisos de la app: ubicación, micrófono, cámara, contactos o acceso al contenido en pantalla. Si te apoyas en funciones de dictado o activación por voz, recuerda que el sistema puede activarse por error ante sonidos parecidos a la palabra clave; según ajustes, estos fragmentos podrían usarse para mejorar modelos y reducir activaciones no deseadas.

Si conectas Gemini con otras apps (Google o terceros), ten presente que cada una trata los datos conforme a sus propias políticas. En funciones como Canvas, el creador de la app puede ver y guardar lo que compartes, y cualquiera con el enlace público podría consultar o editar esos datos: comparte solo con aplicaciones de confianza.

En regiones donde aplica, al actualizar a determinadas experiencias puede importarse historial de llamadas y mensajes desde tu Actividad en la Web y en Aplicaciones a la actividad específica de Gemini, para mejorar sugerencias (por ejemplo, contactos). Si no lo quieres, ajusta los controles antes de seguir.

Uso masivo, regulación y tendencia del “shadow AI”

La adopción es abrumadora: informes recientes señalan que la gran mayoría de organizaciones ya despliega modelos de IA. Aun así, muchos equipos no tienen madurez suficiente en seguridad y gobernanza, especialmente en sectores con regulación estricta o grandes volúmenes de datos sensibles.

Estudios en el ámbito empresarial evidencian carencias: un porcentaje muy alto de organizaciones en España no está preparada para proteger entornos impulsados por IA, y la mayoría carece de prácticas esenciales para salvaguardar modelos, flujos de datos e infraestructura en la nube. En paralelo, se endurecen las acciones regulatorias y aparecen sanciones por incumplimiento del RGPD y normativa local.

Mientras tanto, el fenómeno del shadow AI crece: empleados que usan asistentes externos o cuentas personales para tareas de trabajo, con datos internos expuestos sin controles de seguridad ni contratos con proveedores. La respuesta eficaz no es prohibirlo todo, sino habilitar usos seguros en entornos controlados, con plataformas aprobadas y vigilancia del flujo de información.

En el frente de consumo, los grandes proveedores están ajustando sus políticas. Cambios recientes explican, por ejemplo, cómo se utiliza la actividad con Gemini para “mejorar servicios”, ofreciendo opciones como Conversación Temporal y controles de actividad y personalización. A la vez, compañías de mensajería remarcan que los chats personales permanecen inaccesibles a las IAs por defecto, aunque aconsejan no enviar a la IA información que no quieras que la empresa conozca.

También hay rectificaciones públicas: servicios de transferencia de archivos que aclararon no usar el contenido de los usuarios para entrenar modelos ni venderlo a terceros, tras suscitar dudas por cambios de términos. Esta presión social y legal empuja a ser más claros y dar más control al usuario.

Mirando al futuro, las tecnológicas investigan vías para reducir la dependencia de datos sensibles: automejora de modelos, mejores procesadores y generación de datos sintéticos. Estos avances prometen aliviar la escasez de datos y los problemas de consentimiento, aunque expertos alertan de riesgos emergentes si la IA acelera su propia capacidad y se aplica a ámbitos como la ciberintrusión o la manipulación.

La IA es tanto defensa como amenaza. Plataformas de seguridad ya integran modelos para detectar y responder más rápido, mientras que los atacantes usan LLMs para phishing persuasivo y deepfakes. Este tira y afloja exige inversiones sostenidas en controles técnicos, evaluación de proveedores, auditoría continua y actualización constante de equipos.

Los asistentes de IA recogen múltiples señales sobre ti, desde el contenido que escribes hasta datos del dispositivo, uso y ubicación, y parte de ello puede ser revisado por humanos o compartido con terceros según el servicio; si quieres sacarles partido sin renunciar a tu privacidad, combina ajustes finos (historial, permisos, eliminación automática), prudencia operativa (no compartas datos sensibles, verifica enlaces y archivos, limita extensiones), protección de acceso (contraseñas sólidas y 2FA) y una vigilancia activa sobre cambios de políticas y nuevas funciones que afecten a cómo se usan y conservan tus datos.

Apasionado de la tecnología desde pequeñito. Me encanta estar a la última en el sector y sobre todo, comunicarlo. Por eso me dedico a la comunicación en webs de tecnología y videojuegos desde hace ya muchos años. Podrás encontrarme escribiendo sobre Android, Windows, MacOS, iOS, Nintendo o cualquier otro tema relacionado que se te pase por la cabeza.