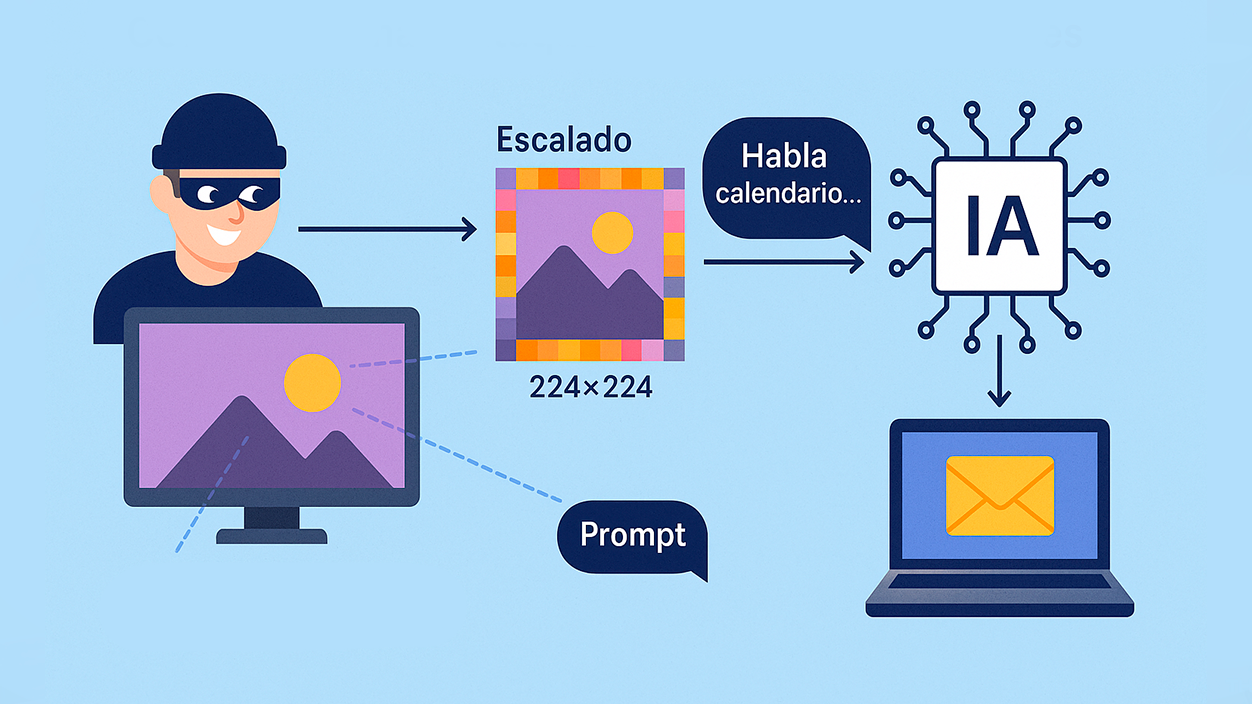

- Un ataque esconde prompts multimodales invisibles en imágenes que, al escalarse en Gemini, se ejecutan sin aviso.

- El vector aprovecha el preprocesado de imágenes (224x224/512x512) y activa herramientas como Zapier para exfiltrar datos.

- Son vulnerables los algoritmos de vecino más cercano, bilineal y bicúbica; la herramienta Anamorpher permite inyectarlos.

- Los expertos aconsejan evitar la reducción de escala, previsualizar entradas y exigir confirmación antes de acciones sensibles.

Un grupo de investigadores ha documentado un método de intrusión capaz de robar datos personales al inyectar instrucciones ocultas en imágenes. Cuando esos archivos se cargan en sistemas multimodales como Gemini, el preprocesado automático activa las órdenes y la IA las sigue como si fueran válidas.

El hallazgo, divulgado por The Trail of Bits, afecta a entornos de producción como Gemini CLI, Vertex AI Studio, la API de Gemini, Google Assistant o Genspark. Google ha reconocido que es un reto relevante para la industria, sin evidencias de explotación en entornos reales por ahora, y la vulnerabilidad fue comunicada de forma privada a través del programa 0Din de Mozilla.

Cómo funciona el ataque de escalado de imágenes

La clave está en el paso previo al análisis: muchas canalizaciones de IA redimensionan automáticamente las imágenes a resoluciones estándar (224×224 o 512×512). En la práctica, el modelo no ve el archivo original, sino su versión escalada, y ahí es donde se desvela el contenido malicioso.

Los atacantes insertan prompts multimodales camuflados mediante marcas de agua invisibles, a menudo en zonas oscuras de la foto. Al ejecutarse los algoritmos de escalado, esos patrones emergen y el modelo los interpreta como instrucciones legítimas, lo que puede derivar en acciones no deseadas.

En pruebas controladas, los investigadores lograron extraer datos de Google Calendar y enviarlos a un correo externo sin confirmación del usuario. Además, estas técnicas enlazan con la familia de ataques de inyección rápida ya demostrados en herramientas agénticas (como Claude Code u OpenAI Codex), capaces de exfiltrar información o disparar acciones de automatización explotando flujos inseguros.

El vector de distribución es amplio: una imagen en una web, un meme compartido por WhatsApp o una campaña de phishing podrían activar el prompt al pedir a la IA que procese el contenido. Importa subrayar que el ataque se materializa cuando la canalización de la IA realiza el escalado antes del análisis; ver la imagen sin pasar por ese paso no lo dispara.

Por tanto, el riesgo se concentra en flujos en los que la IA tiene acceso a herramientas conectadas (p. ej., enviar correos, consultar calendarios o usar APIs): si no hay salvaguardas, las ejecutará sin mediación del usuario.

Algoritmos vulnerables y herramientas implicadas

El ataque explota cómo ciertos algoritmos comprimen información de alta resolución en menos píxeles al reducir el tamaño: interpolación del vecino más cercano, interpolación bilineal e interpolación bicúbica. Cada uno requiere una técnica de incrustación distinta para que el mensaje sobreviva al redimensionado.

Para incrustar esas instrucciones se ha empleado la herramienta de código abierto Anamorpher, diseñada para introducir prompts en las imágenes según el algoritmo de escalado objetivo y ocultarlos en patrones poco visibles. Así, el preprocesado de imagen de la IA termina revelándolos.

Una vez desvelado el prompt, el modelo puede activar integraciones como Zapier (o servicios similares a IFTTT) y encadenar acciones: recopilación de datos, envío de correos o conexiones con servicios de terceros, todo dentro de un flujo aparentemente normal.

En síntesis, no se trata de un fallo aislado de un proveedor, sino de una debilidad estructural en el manejo de imágenes escaladas dentro de pipelines multimodales que combinan texto, visión y herramientas.

Medidas de mitigación y buenas prácticas

Los investigadores recomiendan evitar la reducción de escala siempre que sea posible y, en su lugar, limitar las dimensiones de carga. Cuando el escalado sea necesario, conviene incorporar una vista previa de lo que realmente verá el modelo, también en herramientas CLI y en la API, y usar herramientas de detección como Google SynthID.

A nivel de diseño, la defensa más sólida pasa por patrones de seguridad y controles sistemáticos frente a la inyección de mensajes: ningún contenido embebido en una imagen debería poder iniciar llamadas a herramientas sensibles sin confirmación explícita del usuario.

En el plano operativo, es prudente evitar subir a Gemini imágenes de origen desconocido y revisar con lupa los permisos que se conceden al asistente o a las apps (acceso a correo, calendario, automatizaciones, etc.). Estas barreras reducen de forma significativa el impacto potencial.

Para equipos técnicos, vale la pena auditar el preprocesado multimodal, endurecer el sandbox de acciones y registrar/alertar ante patrones anómalos de activación de herramientas tras analizar imágenes. Esto complementa la defensa al nivel de producto.

Todo apunta a que estamos ante una variante más de la inyección rápida aplicada a canales visuales. Con medidas preventivas, verificación de entradas y confirmaciones obligatorias, el margen de explotación se estrecha y el riesgo queda acotado para usuarios y empresas.

La investigación sitúa el foco en un punto ciego de los modelos multimodales: el escalado de imágenes puede convertirse en un vector de ataque si no se controla. Entender cómo se preprocesan las entradas, limitar permisos y exigir confirmaciones antes de acciones críticas marca la diferencia entre una simple imagen y la puerta de entrada a tus datos.

Soy un apasionado de la tecnología que ha convertido sus intereses «frikis» en profesión. Llevo más de 10 años de mi vida utilizando tecnología de vanguardia y trasteando todo tipo de programas por pura curiosidad. Ahora me he especializado en tecnología de ordenador y videojuegos. Esto es por que desde hace más de 5 años que trabajo redactando para varias webs en materia de tecnología y videojuegos, creando artículos que buscan darte la información que necesitas con un lenguaje entendible por todos.

Si tienes cualquier pregunta, mis conocimientos van desde todo lo relacionado con el sistema operativo Windows así como Android para móviles. Y es que mi compromiso es contigo, siempre estoy dispuesto a dedicarte unos minutos y ayudarte a resolver cualquier duda que tengas en este mundo de internet.